24,99 €

Mehr erfahren.

- Herausgeber: Schattauer

- Kategorie: Geisteswissenschaft

- Serie: Wissen & Leben

- Sprache: Deutsch

Früher war alles später. Und heute gilt: Schneller, höher, weiter – obwohl wir uns alle nach Entschleunigung, Tiefe und Nähe sehnen. Der Arzt, Neurowissenschaftler und Bestsellerautor Manfred Spitzer blickt in diesem Buch auf unterschiedliche (Fehl-)Entwicklungen, die unser alltägliches Leben betreffen. Er stellt die Fragen von morgen, mit denen wir uns heute beschäftigen sollten: Müssen wir lernen, Maschinen zu vertrauen, selbst wenn sie uns umbringen? Ändern sich unsere Beziehungen durch digitale Medien? Werden bald Roboter für uns arbeiten und bald danach wir für sie? Wie stets beleuchtet Spitzer psychologische, neurobiologische und gesellschaftliche Sachverhalte mithilfe neuester wissenschaftlicher Erkenntnisse. Er widmet sich dem Zusammenhang zwischen fehlender Weitsicht und Kurzsichtigkeit, Smartphone und Willensbildung, Armut und Intelligenzquotient, Armut und Schmerzerleben sowie zwischen Armut und Lebenserwartung. Er untersucht, was Einsamkeit mit uns macht, und erklärt, wie Stärke schmeckt. Nehmen Sie sich die Zeit, dieses Buch zu lesen – denn auch das zeigt Spitzer eindrucksvoll auf: Wer Bücher liest, lebt länger!

Das E-Book können Sie in Legimi-Apps oder einer beliebigen App lesen, die das folgende Format unterstützen:

Seitenzahl: 331

Veröffentlichungsjahr: 2018

Ähnliche

Manfred Spitzer

Früher war alles später

… und heute zerreißen wir (uns) so schnell es geht

Prof. Dr. Dr. Manfred Spitzer

Universität Ulm, Psychiatrische Klinik

Leimgrubenweg 12–14

89075 Ulm

Bibliografische Information der Deutschen Nationalbibliothek

Die Deutsche Nationalbibliothek verzeichnet diese Publikation in der Deutschen Nationalbibliografie; detaillierte bibliografische Daten sind im Internet über http://dnb.d-nb.de abrufbar.

Besonderer Hinweis:

In diesem Buch sind eingetragene Warenzeichen (geschützte Warennamen) nicht besonders kenntlich gemacht. Es kann also aus dem Fehlen eines entsprechenden Hinweises nicht geschlossen werden, dass es sich um einen freien Warennamen handelt.

Das Werk einschließlich aller seiner Teile ist urheberrechtlich geschützt. Jede Verwertung ist ohne Zustimmung des Verlags unzulässig. Das gilt insbesondere für Vervielfältigung, Übersetzungen, Mikroverfilmungen und die Speicherung in elektronischen Systemen.

Schattauer

www.schattauer.de

© 2017 by J. G. Cotta’sche Buchhandlung Nachfolger GmbH, gegr. 1659, Stuttgart

Alle Rechte vorbehalten

Umschlagabbildung: Foto oben: Staatsbibliothek zu Berlin, Nachlass Gerhart Hauptmann; unten: Plakat von Emil Orlik zu Gerhart Hauptmanns Drama „Die Weber“, 1897

Gesetzt von am-productions GmbH, Wiesloch

Datenkonvertierung: le-tex publishing services GmbH, Leipzig

Printausgabe: ISBN 978-3-608-43243-5

E-Book: ISBN 978-3-608-19075-5

PDF-E-Book: ISBN 978-3-608-29074-5

Dieses E-Book basiert auf der aktuellen Auflage der Printausgabe.

Meinen sechs Kindern und zwei Enkeln

Vorwort

„Vielleicht werde ich später sterben, als ich heute annehme, aber ganz bestimmt früher, als ich mir wünsche“ – schrieb der Arzt Paul Kalanithi kurz vor seinem Tod im Jahr 2015. Hier liegen sowohl „später“ als auch „früher“ in der Zukunft. Im Titel dieses Buches meinen beide Ausdrücke hingegen Zeitpunkte in der Vergangenheit. Das mag dem unvoreingenommenen Betrachter logisch widersprüchlich erscheinen, ist es aber nicht. Und so darf man den meisten Menschen durchaus den Eindruck zugestehen, dass früher alles später war, d.h. dass die Zeit früher etwas langsamer verging als heute. Aber ist das wirklich so? – Unter anderem dieser Frage wird in diesem Buch (Kapitel 1) nachgegangen.

Weihnachten war auf jeden Fall weltweit früher später, und in Mecklenburg-Vorpommern ist sogar noch heute vieles etwas später, wovon sich jeder überzeugen kann, der dort einmal einen „entschleunigten“ Urlaub machen möchte. Diesen haben viele nötig, weil im Arbeitsleben dauernd gilt, dass Stillstand gleich Rückschritt ist, oder wie es der ehemalige Stuttgarter Oberbürgermeister Manfred Rommel gesagt hat: „Es ist auf dem Fahrrad wie in der Wirtschaft: Wer sich nicht fortbewegt, fällt um“ (zit. nach Merkel 2013). Daher – so wird uns heute gesagt – müssen wir zerreißen, um nicht selbst von der raschen Entwicklung zerrissen zu werden (Kapitel 2).

Diese selbstzerstörerische Disruptions-Rhetorik hat mittlerweile sogar die beschauliche Schweiz erreicht. Dort befindet sich in Zürich die einzige europäische Universität unter den zehn besten Universitäten der Welt: die Eidgenössische Technische Hochschule (ETH). Der Direktor ihrer Bibliothek betitelt einen im Fachblatt Forschung & Lehre publizierten Aufsatz zur Neupositionierung der universitären Bibliotheken mit „Digitale Disruption“, kritisiert das veraltete „analogische“ Denken und verwendet auch ansonsten eine Terminologie, die Verbindungen zur digitalen Mafia gesetzloser Großkonzerne (die reichsten der Welt!) erahnen lässt (Ball 2016, S. 776): „Next Level Library“ klingt ähnlich wie das Erreichen des nächsten Schwierigkeitsniveaus beim Abschießen von Monstern; die „produktiven Change-Ergebnisse“ kennt man ansonsten nur aus dem Business-Geplapper von Managern. Es geht aber in der Wissenschaft weder um die „Konsumption wissenschaftlicher Inhalte“, noch lässt sich aus dem, was bislang passiert ist, ableiten, dass man nicht mehr auf „kleinschrittige Veränderungen“ und „jahrzehntelange evolutionäre Weiterentwicklung von Dienstleistungen und Prozessen“ setzen sollte – sondern auf Disruption. Bibliothekare, welche die ihnen anvertraute Bibliothek der „Vergangenheitsverschickung des Geistes“ bezichtigen (Ball 2016, S. 777), sofern und solange sie sich nicht selbst zerreißt, sollten uns suspekt sein!

Die Frage, ob mich mein Auto umbringen darf, kann, soll oder muss (Kapitel 4), gehört nicht zu den innerakademischen Kuriositäten, sondern mitten in unser Leben. Daher ist auch die Gründung einer Ethik-Kommission zur Lösung genau dieser Frage Ende September 2016 sinnvoll. Selten lag ein Nervenheilkunde-Editorial so klar am Puls der Zeit (bzw. drei Monate davor). Soll das Auto den Kinderwagen überfahren oder lieber gegen den nächsten Baum fahren und den (mit-)fahrenden Rentner opfern? – Ich hätte mich nicht getraut, die Frage so zugespitzt zu formulieren, wie das die Tagesschau vom 30.9.2016 getan hat!1„Sachschaden geht vor Personenschaden“ und „keine Klassifizierung von Personen nach welchen Kriterien auch immer“, hörte man den Verkehrsminister reden. Aber was soll dann geschehen, wenn es spitz auf knapp kommt? Ich bin gespannt, was die Ethik-Kommission sagen wird. Und vor allem: Wenn wir schon wissen, dass keiner ein Auto kauft, das seinen Besitzer notfalls umbringt (wie der ausführlich diskutierte Science-Artikel nahelegt), und wenn die Autoindustrie Recht hat, dass autonomes Fahren sicherer ist als das Steuern durch Menschen, wie entgehen wir dann der Zwickmühle, dass die besten Intentionen mehr Tote bewirken?

Interessant ist in diesem Zusammenhang, dass die meisten Deutschen ganz offensichtlich einer utilitaristischen Ethik folgen, wie ein TV-Experiment der ARD am 17.10.2016 zeigte: Die Zuschauer einer Gerichtsverhandlung, in der es darum ging, ob man 165 Menschen töten darf, um 75000 Menschen zu retten, stimmten ab, ob der Angeklagte schuldig oder nicht schuldig sei, und befanden ihn mehrheitlich (86,9%) für nicht schuldig (waren also der Ansicht, man dürfe wenige Menschen töten, um viele zu retten). Das ganze Experiment war methodisch nicht sehr sauber durchgeführt worden: Eine „Versuchsanordnung“ (so der Autor der Geschichte) sieht anders aus, die Aufzeichnung der Daten war offenbar mangelhaft2 und nicht einmal die Anzahl der Teilnehmer wurde berichtet. Dennoch mag man es als Beleg dafür nehmen, dass die Deutschen im Hinblick auf ihre Moral mehrheitlich nicht aufgeklärt (Menschen sind niemals Mittel zum Zweck), sondern praktisch denken.

Ebenfalls um die Moral – nämlich die der Süd-Koreaner – geht es in Kapitel 3: Was sollten wir denken, wenn Computer irgendwann nicht nur schneller rechnen können als Menschen (das ist schon seit Jahrzehnten der Fall), sondern auch kreativer denken? Hören wir dann frustriert auf, kreativ zu sein? – Ich denke nicht, denn vieles von dem, was heute in dieser Hinsicht behauptet wird, ist nichts als Hype. Wie die Realität wirklich ist, zeigt wieder der Blick nach Süd-Korea: Dort wurden im Jahr 2015 Gesetze erlassen, durch die die junge Generation (alle unter 19 Jahren) vor den Auswirkungen von Smartphones geschützt werden (Kapitel 5). Zu diesen gehört auch Kurzsichtigkeit, die bei Kindern und Jugendlichen entsteht, wenn sie zu wenig im Freien sind und zu wenig in die Ferne sehen (Kapitel 6).

Ganz oft wird behauptet, dass wir Menschen uns schlicht und ergreifend an neue Technik gewöhnen müssten: Wir ändern uns ganz einfach, passen uns an, und werden vielleicht in einigen tausend Jahren mit USB-Anschluss hinter den Ohren geboren. Wie wenig dies mit der Realität zu tun hat, kann man daran ablesen, wie sehr unser Menschsein umgekehrt unsere Nutzung der modernen Technik bestimmt: Wir kommunizieren letztlich nicht anders als vor hunderttausend Jahren, wie sich mit Big Data, d.h. der Analyse großer Datenmengen zur menschlichen Kommunikation, zeigen lässt (Kapitel 7 und 8).

Die nächsten vier Kapitel beziehen sich auf ein Problem, das mich seit ihrer Abfassung nicht mehr loslässt: Armut. Das Problem ist weitaus komplexer, als man zunächst vermuten könnte, geht es doch um viel mehr als nur die Abwesenheit von Geld (Kapitel 9 bis 12).

Die letzten sechs Kapitel dieses achtzehnten Buches seiner Art – es handelt sich wie immer um meine Beiträge aus einem Jahrgang der Zeitschrift für Nervenheilkunde – greifen jeweils aktuelle Erkenntnisse auf und stellen sie in einen Zusammenhang: Das Lesen von Büchern erweist sich als lebensverlängernd (Kapitel 13); Toxoplasmose beeinflusst das Verhalten von Primaten – einschließlich des Menschen (Kapitel 14); Ärzte stehen zwar anders zum Tod als medizinische Laien, sterben aber dennoch kaum anders (Kapitel 15); Ziegen besitzen eine Form des Einfühlungsvermögens (Kapitel 16); Einsamkeit beeinträchtigt die Gesundheit (Kapitel 17); und die Anzahl der grundlegenden Geschmacksqualitäten ist weitaus größer als bislang gedacht (Kapitel 18). Wie immer bin über diese Themen „gestolpert“, sei es beim Suchen nach anderen Informationen, im Gespräch mit Kollegen oder beim Durchblättern wissenschaftlicher Zeitschriften. Getrieben von Neugierde recherchierte ich dann jeweils weiter, bis der Kontext klar wurde und der neue Befund damit in einen größeren Zusammenhang einzuordnen war. Diese Arbeit macht mir auch nach 18 Jahren noch immer sehr viel Freude und wird nie langweilig. Auch kam es noch nie vor, dass sich keine Thematik ergeben hätte, es ist eher umgekehrt: Zuweilen geschieht so viel, dass man nicht mehr nachkommt und genau deswegen einen Beitrag nicht rechtzeitig fertig bekommt.

Auch im Jahr 2016 haben mir meine Mitarbeiter geholfen, die Psychiatrische Uni-Klinik in Ulm durch nicht immer ganz ruhiges Fahrwasser gut zu steuern. Ihnen allen gilt dafür mein ganz besonderer Dank! Wir begegnen uns gegenseitig und unseren Patienten mit Aufmerksamkeit und Respekt, und so komme ich jeden Morgen gerne zur Arbeit, freue mich auf gemeinsame Visiten und auf die vielen Begegnungen und Gespräche am Rande. Es sind die Kleinigkeiten, die im Leben den Unterschied machen!

Ebenfalls danken möchte ich den Verlegern Dieter Bergemann und Dr. Wulf Bertram sowie den Mitarbeiterinnen und Mitarbeitern beim Schattauer Verlag, die sich ittlerweile schon um gut 20 Bücher aus meiner Feder gekümmert haben, insbesondere Frau Dr. Anja Borchers, Frau Ruth Becker, Frau Birgit Heyny und Frau Dr. Petra Mülker.

Meiner Morgenrunde (Julia, Georg & Thomas) danke ich für die alltägliche Einsamkeitsprophylaxe und Ermunterung! Der Band (Wulf & Joram) für die gelegentlichen, viel zu seltenen diesbezüglichen Hochdosis-Interventionen. Wäre das nicht und hätte ich dazu noch keine Kinder (und damit auch keine Enkel), dann wäre ich nach den in diesem Buch diskutierten Erkenntnissen schon längst tot.

Hiddensee, Mecklenburg-Vorpommern,

am Reformationstag 2016

Manfred Spitzer

Literatur

Anonymus. Damit der Autopilot die richtige Entscheidung trifft. In Berlin trifft die „Ethik-Kommission zum automatisierten Fahren“ erstmals zusammen. FAZ 1.10.2016, S. 29.

Ball R. Digitale Disruption. Warum sich Bibliotheken neu positionieren müssen. Forschung & Lehre 23(9): 776–777.

Haeming A. „Hart aber fair“ zum ARD-Film „Terror“. „Sonst sind wir schnell bei Volksjustiz“. Spiegel online 18.10.2016 (http://www.spiegel.de/kultur/tv/ard-film-terror-und-hart-aber-fair-so-lief-das-tv-experiment-a-1117059.html; abgerufen am 25.10.2016).

Merkel A. Rede von Bundeskanzlerin Merkel bei der Eröffnung der EUROBIKE 2013, 28.8.2013 (https://www.bundesregierung.de/ContentArchiv/DE/Archiv17/Reden/2013/08/2013-08-28-merkel-eurobike.html; abgerufen am 24.10.2016).

Inhalt

1 Früher war alles später – und besser

2 Zerreißen oder zerrissen werden?

3 Go und die Moral in Südkorea

4 Sollte mein Auto mich umbringen wollen müssen

5 Smart Sheriff gegen Smombies

6 Kurzsichtig wegen mangelnder Weitsicht

7 Telefonieren studieren

8 Was geschieht beim Online-Dating?

9 Stunting: Gehirnentwicklung, Status und Statur

10 Armut tut weh

11 Armut macht dumm

12 Die Theorie der Lebensgeschichten

13 Wer Bücher liest, lebt länger

14 Protozoen und Persönlichkeitsstörungen, die Psychiatrie und der Ursprung der Menschheit

15 Ärzte sterben gewöhnlich

16 Ziegen sind auch nur Menschen

17 Einsamkeit – erblich, ansteckend, tödlich

18 Stärke – der sechste Geschmack?

Sachverzeichnis

1 Früher war alles später – und besser

Früher war Weihnachten später – so lautet der Titel eines Buchs (4), das man in diesen Tagen vielleicht gerne einmal hervorholt, um darin zu schmökern (▶Abb. 1-1). Wenn man bedenkt, wie früh heute die Nikoläuse und Sterne in die Schaufenster und in die Gassen zwischen ihnen gelangen, so kann man dem Titel aus rein empirischer Sicht nur zustimmen: „Die Blätter an den Bäumen sind noch nicht einmal gelb, geschweige denn welk, und schon hängt die Weihnachtsbeleuchtung in den Ästen. Immer früher stapeln sich die Schokoladen-Nikoläuse an den Kassen, beschallen elendig vertraute Weihnachtsmelodien die Fußgängerzonen und Supermarktgänge“, bringt der Klappentext des genannten Buchs die Problematik auf den Punkt. Die Vorverlagerung bewirkt leider, dass man an Weihnachten gar keine Weihnachtslieder mehr singen mag, vom Essen der zum Fest schon alt gewordenen Weihnachtsplätzchen einmal gar nicht zu reden.

Abb.1-1 Cover der beiden hier erwähnten, sehr lesenswerten Bücher.

Früher hat man die Feste tatsächlich gefeiert wie sie fielen, während man sie heute vorverlegt. So grüßt nicht nur das leicht gelbliche Herbstlaub den Weihnachtsmann, sondern der Schneemann auch den Osterhasen, der seinerseits wahrscheinlich demnächst dem Pfingstochsen zuwinken dürfte. Marketing-Spezialisten wissen warum: Wenn aus dem neuen Auto oder Buch innerhalb weniger Wochen ein Vorjahresmodell zu werden droht – weil sich ein Jahreswechsel dummerweise von einem Tag auf den nächsten vollzieht – dann muss man Produkte des kommenden Jahres früher verkaufen, damit sie später altern: Das Auto-Modell vom Frühjahr 2017 kann man daher schon im Herbst 2016 kaufen, ebenso ein 2017 erscheinendes Buch (wer das vorliegende Buch schon 2016 kauft und dies nicht glaubt, der schaue selbst vorne im Impressum nach!). Unsere Abneigung gegen das Altern ist also letztlich die Triebfeder dieser Beschleunigung. Und weil wir alle das Altern noch mehr fürchten als der Teufel das Weihwasser, wird sich an diesem Trend nichts ändern. Irgendwann, vielleicht erst im Jahre 2098, werden wir zum Fest der Feste Bücher verschenken oder geschenkt bekommen, deren Erscheinen auf das Jahr 2100 datiert ist.

Gemäß diesem Trend war also früher tatsächlich alles später. Dies galt übrigens nicht nur für das genannte hohe christliche Fest, sondern auch – zumindest im rechts-oberen Zipfel der Republik – nahezu für dessen Gegenteil: den Weltuntergang.

„Wenn ich wüßte, dass die Welt morgen unterginge, dann würde ich nach Mecklenburg ziehen, weil dort alles 50 Jahre später geschieht.“ Dieses Otto von Bismarck zugeschriebene3 Zitat drückt ganz wunderbar aus, wie unterschiedlich die Zeit subjektiv erlebt wird. Im Nordosten Deutschlands scheint sie noch heute langsamer zu gehen als im hektischen Südwesten zwischen High-Tech und Spätzle.

Die Angst vor dem Altern, d.h. vor dem Vergehen der Zeit, bewirkt also, dass die Zeit rascher vergeht – so paradox dies auch klingen mag. Dass damit ein Teufelskreis in Gang gesetzt wird, macht die Sache ebenso wenig besser wie die Tatsache, dass daraus Angst und Stress resultieren. Und weil wir dies wiederum nahezu definitionsgemäß nur aversiv erleben können, war früher nicht nur alles später, sondern eben auch besser.

Wie ich im Folgenden zeigen möchte, ist das sich gegenwärtig vielen aufdrängende Gefühl, früher sei es langsamer und besser zugegangen, vielschichtig: Sowohl objektive als auch subjektive Faktoren spielen eine Rolle. Ihnen nachzugehen lohnt sich – gerade in einer Jahreszeit, die durch lange dunkle Winterabende und damit viel Zeit für Besinnung sprichwörtlich gekennzeichnet ist.

Bevor man einen Effekt diskutiert, sollte man sich vergewissern, dass er auch existiert. Die neuesten Daten zur Frage, ob früher alles besser war (Stand: Herbst 2016) sind eindeutig: Ja, der Effekt existiert. „Die Verunsicherung der 30- bis 59-Jährigen ist gewachsen, ihr Zukunftsoptimismus steil zurückgegangen“, kommentiert das Allensbach-Institut für Demoskopie eine Umfrage im Auftrag des Gesamtverbandes der Deutschen Versicherungswirtschaft, GDV, vom 1. bis 22. Juni 2016 von insgesamt 1100 Männern und Frauen im Alter zwischen 30 und 59 Jahren (1, 2). Dabei steigt der Anteil der Leute (im Vergleich zu 2013), denen es nach eigenen Angaben besser geht als früher (heute: 39%, 2013: 35%) und es sinkt der Anteil derjenigen, die angeben, es ginge ihnen schlechter als früher (heute: 20%, 2013: 23%). Dennoch hat sich die Bewertung der Aussichten für das nächste Jahr deutlich zum Negativen gewendet (▶Abb. 1-2):

Abb.1-2 „Ich sehe den kommenden Monaten entgegen mit Hoffnung (weiße Kreise), Skepsis (schwarze Kreise) bzw. unentschieden“ (graue Kreise; nach Daten aus 1).

„Der Blick auf die jeweils bevorstehenden 12 Monate ist nun aber im Vergleich mit 2015 viel pessimistischer gefärbt: Diesmal gaben nur noch 43% an, hoffnungsvoll in die Zukunft zu blicken; vor einem Jahr waren es noch 57%. Umgekehrt hat sich der Anteil der sorgenvoll gestimmten Menschen aus der ‚Generation Mitte‘ von 30 auf 42% erhöht“ (2).

Als Gründe werden genannt – jeweils etwa von zwei Dritteln der Befragten – die Zunahme

der Kluft zwischen Arm und Reich,

der Terrorgefahr,

der Fremden (Flüchtlinge) und

der Fremdenfeindlichkeit.

Zudem hat die Angst der Deutschen vor dem Anstieg von Gewalt und Kriminalität in ihrem Umfeld (Gewaltverbrechen, Diebstahl, Einbruch, Anschlag im Inland) seit dem Vorjahr um 22% zugenommen. In globaler Hinsicht fürchtet knapp die Hälfte der Bevölkerung einen Krieg. Sorgen bereiten zudem die Alterung der Gesellschaft und die Furcht vor einem geringeren eigenen Lebensstandard im Alter (60%) sowie vor persönlicher Arbeitslosigkeit (29%) und dem persönlichen Verlust der Ersparnisse durch Inflation (40%). Der Anteil derer, die über mehr Stress (43%) und Überforderung im Beruf (21%) klagen, hat ebenfalls gegenüber dem Vorjahr um 15% zugenommen.

So hoffnungslos erschien uns Deutschen die Lage seit den Terroranschlägen vom 11. September 2001 und der Finanzkrise von 2008 nicht mehr; und gerade im letzten Jahr ging es mit dem Pessimismus bergauf und mit dem Optimismus bergab.

Betrachtet man die Sorgen der deutschen Bevölkerung einmal ganz nüchtern, dann fällt auf, dass sie berechtigt sind. So nahm die Kluft zwischen Reich und Arm weltweit zwar im vorletzten und vor allem letzten Jahrhundert deutlich ab, seit etwa 1970 steigt sie jedoch weltweit wieder an und wird, glaubt man den Experten, dies auch bis ans Ende dieses Jahrhunderts weiterhin tun. Da Armut hierzulande vor allem Ungleichheit meint (sie ist relativ zum Median des Verdienstes aller definiert), wird also die Armut zunehmen. Selbst wenn durch ein Wunder alle Deutschen ab dem 1.1.2017 doppelt so viel verdienen würden als zuvor, wäre der Anteil der Armen unverändert (denn das sind diejenigen, die nur 60% oder weniger vom Median des Einkommens aller Deutschen zur Verfügung haben). Das mag paradox klingen, ist jedoch aufgrund der Mathematik dahinter unausweichlich.

Dass die Terrorgefahr heute größer ist als sie es früher war – selbst in den Zeiten von Bomben in Nordirland (IRA) sowie Andreas Baader und Ulrike Meinhof (RAF) – wird kaum jemand bezweifeln. Nicht anders ist es mit den Flüchtlingen. Zwar hatten wir davon in der Vergangenheit (nach Ende des Zweiten Weltkriegs) schon deutlich mehr als im Jahr 2015, aber deren Zahl wird sich in den kommenden Jahrzehnten noch in einer Weise steigern, die uns heute unvorstellbar erscheint: Wenn es stimmt, dass bis zum Ende dieses Jahrhunderts die Erderwärmung so zugelegt haben wird, wie man es heute mit den vorhandenen Daten berechnen kann, dann steht in etwa 80 Jahren 2 Milliarden Menschen (den Bewohnern aller großen Küstenstädte sowie den Bewohnern von Ländern wie Holland, Louisiana oder den Malediven) das Wasser buchstäblich bis zum Hals, und sie werden sich aus genau diesem Grunde schon auf den Weg gemacht haben. Wenn nun aber eine Million Flüchtlinge die Europäische Union an den Rand der Zerreißprobe gebracht haben (mit bislang noch ungewissem Ausgang!), mag man sich gar nicht ausmalen, was 2000 Millionen (das sind 2 Milliarden!) Flüchtlinge mit der Welt, wie wir sie kennen, machen. Der im Jahr 2016 allenthalben zu beobachtende kleinherzige Nationalismus (Stichworte: Brexit, AfD) jedenfalls stimmt einen hier für die in einigen Jahrzehnten in den Blick zu nehmende Zukunft wirklich nicht optimistisch!

So ergibt sich, das auch bei der Angst vor alledem (die ja selbst als eines der Probleme fungiert) die Hoffnung auf Entwarnung kaum gegeben werden kann – zumal die Akzeptanz einer psychiatrischen Lösung – Lithium, Benzodiazepine oder Haloperidol ins Trinkwasser – gegen Null gehen dürfte. Sie wird mittelfristig eher zunehmen, nicht zuletzt weil Einbrüche und die Ausgaben für Verteidigung tatsächlich zunehmen und der Wert des Geldes sowie die Wahrscheinlichkeit eines globalen Friedens tatsächlich abnehmen.

Aber ist es nicht eine Täuschung, dass früher alles besser war? Sagen das nicht alle älteren Menschen, ganz einfach deswegen, weil wir die Vergangenheit einfach prinzipiell eher mit der rosa Brille betrachten, wie das der Volksmund sagt? In der Tat spricht für diese Ansicht nicht nur die uns allen bekannte anekdotische Evidenz, dass das abhanden gekommene Urlaubsgepäck von heute die Partystory in zwei Jahren werden wird. Vielmehr wurde die Existenz einer solchen rosa Brille für Ereignisse in unserem Gedächtnis bereits vor 20 Jahren von US-amerikanischen Psychologen wissenschaftlich belegt. Sie führten Studien durch, bei denen 21 Probanden eine 12-tägige Europareise, 77 Studenten einen Kurztrip am Erntedankfest (Thanksgiving) oder 38 Studenten eine dreiwöchige Fahrradtour in Kalifornien unternahmen. „Die Kosten solcher Ereignisse werden für gewöhnlich in Dollar gemessen. Was man dafür bekommt hingegen sind Erfüllung, persönliche Belohnung und Erinnerungen“, schreiben die Autoren in typisch amerikanischer ökonomisierender Kosten-Nutzen-Analyse (5, S. 422, Übersetzung durch den Autor). Bei allen drei Studien ergab sich, dass das Erlebnis vorher und nachher positiver beurteilt wurde als während der Reise selbst. Betrachten wir nur beispielsweise die Fahrradtour: Ganze 5% der Teilnehmer hatten vorher die Vermutung, dass die Erfahrung für sie enttäuschend sein könnte, wohingegen während der Tour volle 61% enttäuscht waren. Hinterher konnten sich dann wiederum nur gerade einmal 11% daran erinnern, auf der Tour enttäuscht gewesen zu sein. – Die rosa Brille scheint ganze Arbeit zu leisten!

Man hat sich viele Gründe überlegt, warum die rosa Brille wohl existiert, von der Freude vor und nach dem Ereignis, die sich auf dessen eher allgemeine Bedeutung bezieht, im Gegensatz zum ablenkenden nervenden Kleinkram während des Ereignisses, über den konstruktiven Charakter des Erinnerns bei grundsätzlich immer vorhandenem Bedürfnis nach Stärkung unseres Selbstwertgefühls bis hin zur Ausbalancierung unserer alltäglichen jeweils in der Gegenwart vorhandenen Existenzangst.

Aufgrund dieser sehr bunten Vielfalt an möglichen Ursachen der rosa Brille wundert es nicht, dass sie auch unterschiedlich beurteilt wird. Man kann sie als allgemeine Lebenserleichterung auffassen, die uns zudem sogar bekannt ist, weswegen wir dann eben auch Reisen unternehmen und Veranstaltungen besuchen: Wir wissen, schon vorher, dass wir hinterher schöne Erinnerungen haben werden, deren Gesamtheit ja dann nichts weniger ausmacht als das, was wir „unser Leben“ nennen. Man kann der rosa Brille aber auch anlasten, dass sie zu falschen Entscheidungen führt: Das neue Auto, die neue Wohnung, der neue Arbeitgeber oder gar die neue Beziehung werden vergleichsweise zu optimistisch beurteilt, was Fehlentscheidungen begünstigt. Das Gleiche gilt, wenn ich die Vergangenheit zu positiv beurteile und daher meinen eigenen Fehlern geringere Bedeutung beimesse, als ich dies tun sollte (z.B. „bei Aktien lag ich bislang immer goldrichtig“). Die rosa Brille mag also dazu führen, dass ich aus Fehlern weniger lerne als ich könnte oder sollte: „Das andauernde Umschreiben der Vergangenheit in einem günstigen Licht kann bedeuten, dass wir den Herausforderungen der Zukunft in geringerem Maße gewachsen sind“, bemerken Mitchell und Mitarbeiter hierzu in ihrer abschließenden Diskussion (5, Übersetzung durch den Autor).

War also früher wirklich alles besser? – Ich persönlich neige zur Antwort „Vielleicht ein bisschen!“. Denn alles mit der Bemerkung „es bleibt ja eh alles, wie es ist“ auf die rosa Brille zu schieben und als Konsequenz untätig dem Lauf der Welt zuzuschauen, entspricht einfach nicht meinem Naturell. Ich mag nicht zusehen, wie die Welt den Bach hinuntergeht, dazu gefällt sie mir zu gut. Und vor allem meinen Kindern und deren Kindern auch.

Literatur

1. Anonymus. Große Allensbach-Umfrage: Wovor die Deutschen Angst haben. Bild.de, 8.9.2016 (http://www.bild.de/politik/inland/umfrage/allensbach-wovor-die-deutschen-angst-haben-47719672.bild.html; abgerufen am 10.9.2016)

2. Anonymus. In der mittleren Generation wächst die Zukunftsangst. FAZ, 9.9.2016, S. 19.

3. Kasten B. Alles 50 Jahre später? Die Wahrheit über Bismarck und Mecklenburg. Zwickau: Hinsdorff 2013.

4. Kampa D. Früher war Weihnachten später. Zürich: Diogenes 2011.

5. Mitchell TR, Thompson L, Peterson E, Cronk R. Temporal adjustments in the evaluation of events: the „Rosy View“. Journal of Experimental and Social Psychology 1997; 33: 421–448.

6. Nawijn J, Marchand MA, Veenhoven R, Vingerhoets AJ. Vacationers happier, but most not happier after a holiday. Appl Res Qual Life 2010; 5: 35–47.

2 Zerreißen oder zerrissen werden?

Digital disruptiv: Dysfunktional und destruktiv!

„Die Welle der Disruption rollt“4 (▶Abb. 2-1). Seit einiger Zeit hört man auf Fachtagungen, liest in Zeitungen und erfährt in Diskussionen, dass die digitale Technologie heute vor allem eines sei: disruptiv – also wörtlich übersetzt zerreißend. Damit ist gemeint, dass eine Neuerung bzw. eine Erfindung den Effekt hat, die Welt nicht nur zu verändern, sondern Teile der – bekannten – Welt überflüssig zu machen, sodass es diese Teile zerreißt und sie erstaunlich schnell verschwinden: Das Auto ließ die Pferdekutsche verschwinden, die CD die Schallplatte und MP3 samt iPod dann die CD. Als Computer erfunden wurden, nahm man bei IBM an, der Markt für diese Geräte sei sehr klein, weil man weltweit nur ein paar Geräte (Großcomputer, genannt Mainframes) brauche. Jahrzehnte später besitzt jeder einen Personal Computer (PC), und die Großcomputer sind verschwunden.

Ein weiteres oft angeführtes Beispiel ist die im Jahr 1892 gegründete Firma Kodak. Sie stellte Foto- und Filmkameras sowie Filme, Fotopapier und weiteres Zubehör her, war weltweit bekannt, riesengroß und sehr erfolgreich. Bereits 1975 wurde dort die erste Digitalkamera gebaut, man hielt sie aber für so schlecht, dass man sich lieber weiter auf die konventionelle Fotografie konzentrierte – mit dem Effekt, dass es heute Kodak nicht mehr gibt.5

Abb.2-1 Interesse am Wort „disruptiv“ in den deutschen Medien von August 2009 bis Juli 2016 (nach Google Trends, abgerufen am 2.8.2016).

In jedem dieser Beispiele wurde nicht ein vorhandenes Produkt bzw. eine vorhandene Technik weiterentwickelt, sondern etwas völlig Neues geschaffen. „Wenn ich die Menschen gefragt hätte, was sie wollen, hätten sie gesagt: schnellere Pferde.“ Dieses Zitat von Henry Ford6 zeigt klar, worum es hier inhaltlich geht: Manche Neuerungen vollziehen sich nicht langsam und im Sinne einer Evolution (von schon Vorhandenem zu etwas Neuem), sondern wie eine Revolution. Das Alte verschwindet vollkommen und wird durch etwas ganz Neues ersetzt.

Diese Überlegungen sind hinlänglich bekannt. Neu hingegen ist der Gedanke, dass dies in ganz besonderem Maße für die digitale Technik (die „digitale Revolution“) zutrifft, dass durch sie vieles Alte so gründlich und schnell verschwindet, dass man für diesen Prozess das Wort „zerreißend“ („disruptiv“) verwendet und dass man dies ganz prinzipiell für gut und wünschenswert erklärt. Wie so mancher neue Name bewirkte auch diese Bezeichnung eines Prozesses („disruptive innovation“), eines allgemeinen Sachgebiets („disruptive technology“) bzw. einer Sache („disruptive product“) deren Verdinglichung, was dazu führt, dass man das Wort im Substantiv verwendet („this course is on disruption“, beschreibt jemand den Inhalt einer Lehrveranstaltung) und vor allem gedankenlos auf alles Mögliche überträgt. Man spricht mittlerweile sogar nicht mehr von der Digitalisierung von Schulen, Universitäten oder der Medizin, sondern von „disruptive education“, „disruptive university“ und „disruptive health care“. Das alles sei ebenso unvermeidbar wie es zugleich auch gut sei.

So zumindest behauptet es der Harvard-Ökonom Clayton M. Christensen in seinem Buch The Innovator’s Dilemma aus dem Jahr 1997 (▶Abb. 2-2) und in mehr als einem halben Dutzend weiterer Bücher (6). Er argumentiert, dass Manager gerade deswegen, weil sie dazu neigen, sich an den Wünschen der Kunden zu orientieren, zwar einerseits den Erfolg der Firma über Jahrzehnte sichern, andererseits jedoch neue Entwicklungen systematisch nicht mehr im Blick haben. Dadurch würden ihre früher „richtigen“ Entscheidungen nun falsch (was den Titel des Buchs erklärt).

Der Artikel Disruptive Technologies: Catching the Wave, den Christensen zusammen mit seinem Kollegen Joseph L. Bower im Jahr 1995 im Harvard Business Review publizierte (3), verfolgte die gleiche Argumentationslinie und machte die Idee weltweit bekannt. Im Gegensatz zum normalen (inkrementellen, evolutionären) Fortschritt, verändere eine disruptive Technologie nicht einfach eine schon existierende Technik, sondern revolutioniere einen ganzen Markt, schaffe einen neuen, und ließe einen alten untergehen. Dabei sind die neuen disruptiven Produkte anfangs oft nicht so gut wie die alten, beginnen zuweilen als billige Nischenprodukte, setzen sich jedoch dann plötzlich sehr rasch durch.

Abb.2-2 Cover des Nachdrucks der Monografie The Innovator’s Dilemma von Clayton M. Christensen aus dem Jahr 2011. Das Buch erschien im Jahr 1997 und wurde 1999 zum Bestseller – auf dem Höhepunkt der ersten dot-com-Börsenblase, die kurze Zeit später bekanntermaßen zerplatzte.

Man hat Christensen daher auch zuweilen mit Thomas Kuhn und dessen These von der (inkrementellen, evolutionären) „Normalwissenschaft“ im Gegensatz zu Paradigmenwechseln bei wissenschaftlichen Revolutionen verglichen (9). Gern und oft werden die Firma Apple und deren Produkte (grafische Benutzeroberfläche, iPad, iPhone) als positive Beispiele für disruptive Innovationen angeführt. Man sehe an ihnen deutlich, wie gut und erstrebenswert es sei, wenn das Neue das Alte in der Luft zerreißt. Daher müsse man auf Disruption setzen, nicht zuletzt, um nicht selbst zerrissen zu werden: „Disrupt or be disrupted“ lautet daher auch das neue Mantra der Betriebswirtschaftler.

Ein Problem an der gesamten Argumentation von Christensen ist, dass man immer erst hinterher weiß, ob etwas Neues zu einer disruptiven Innovation geworden ist oder nicht. Eine sichere Vorhersage hierzu ist nicht möglich. So war beispielsweise das Apple Newton Messagepad (▶Abb. 2-3) ein vollkommen neues, geniales Gerät mit einer ganzen Reihe nützlicher Eigenschaften (z.B. Erkennung der Handschrift) und Anwendungen und wurde – ein Flop! Fünf Jahre nach seiner Einführung wurde die Produktion des Produkts bzw. der Produktpalette von dem neuen (alten) Chef von Apple, Steve Jobs, eingestellt.

Christensens „Fälle“ sind zudem willkürlich ausgewählt und zeigen insbesondere, wie Unternehmen scheitern können. Sie zeigen nicht, wie sich Erfolg mit Notwendigkeit einstellt. Und wenn der Autor behauptet, dass es mit einem Unternehmen auch dann schiefgehen kann, wenn die Manager alles – vermeintlich – richtig machen (beispielsweise sich an den Kundenwünschen orientieren und die Produkte weiterentwickeln), dann drückt er aus, was wir alle längst wissen: Unglück passiert. So wundert es nicht, dass ein vom Autor bei der Gründung beratener 3,8 Millionen US-Dollar schwerer Disruptive Growth Investment Fund nach einem knappen Jahr pleite war. Ebenso wenig verwundert, dass er im Jahr 2007 mit seiner Einschätzung des iPhones („Das wird ein Misserfolg für Apple“) gründlich danebenlag. Dennoch schreibt der Autor im Vorwort der Auflage von 2011, dass „die Theorie der Disruption nach wie vor Voraussagen liefert, die ziemlich genau sind“ (8, Übersetzung durch den Autor). An Selbstbewusstsein mangelt es dem Harvard-Business-Mann ganz offensichtlich nicht, an Selbstkritik dagegen schon. Auf eine Kritik seitens der Geschichtsprofessorin Jill Lepore seiner Universität7 reagierte er sehr emotional abwertend und zugleich mit wenig Inhalt (2).

Abb.2-3 Der von seiner Herstellerfirma Apple als „personaler digitaler Assistent“ bezeichnete Newton war ein Vorläufer von iPhone und iPad. Er war konzipiert als „Kommunikationsmedium für alle“, das man immer dabeihaben kann. Die Firma kündigte das Gerät im August 1993 wie folgt an: „Die ausgeklügelte Informationstechnologie und die vielfältigen Kommunikationsfunktionen des Newton MessagePads ermöglichen es Ihnen, Kontakt zu Freunden und Kollegen zu halten, Ihren Alltag zu organisieren und Ihre Ideen sofort festzuhalten. Sie können sich Notizen machen, Skizzen entwerfen, Briefe formatieren und ausdrucken, Daten mit Ihrem PC austauschen, Faxe versenden, Nachrichten und Dokumente empfangen sowie E-Mails und Online-Dienste abrufen. Die eingebaute Infrarottechnik erlaubt Ihnen sogar den Austausch von Visitenkarten mit Geschäftspartnern. Und wo auch immer Sie hingehen – Ihr leistungsstarker, weniger als ein Pfund leichter persönlicher Assistent ist stets in Ihrer Hosentasche mit dabei“(16, Übersetzung durch den Autor).

Interessanterweise wurde das Buch trotz seiner vollkommen unzureichenden empirischen Basis, seiner argumentativen Schwächen und sogar Plattheit wie auch seiner offensichtlichen praktischen Unbrauchbarkeit (was hielten Sie von dem Hinweis eines Arztes: „Über die Prognose wird der weitere Verlauf entscheiden“?) über allen grünen Klee dieser Welt gelobt.8 – Warum?

Bei Licht betrachtet, geht es beim Thema Disruptivität um digitale Informationstechnik und deren Folgen auf Gesellschaft, Wirtschaft und den Einzelnen. Diese Folgen wurden in der Vergangenheit in sehr rosigen Farben gezeichnet: Innovation, Wachstum, Arbeitsplätze, Reichtum, Glück – all das versprach uns die „digitale Revolution“ noch vor wenigen Jahren. Die Fakten sehen jedoch anders aus: Auf die erste digitale Börsenblase folgte zwar eine Konsolidierung der Branche, die Goldgräberstimmung jedoch war vorbei. Schaut man sich die wirtschaftlichen Daten der letzten 15 Jahre genauer an, so zeigt sich in den westlichen (digitalisierten) Industrienationen gegenüber den 1980er- und 1990er-Jahren ein vergleichsweise geringeres Wachstum des Bruttoinlandsprodukts, der Produktivität und vor allem der Löhne sowie eine Zunahme der Arbeitslosigkeit. Die Zahl der Geschäftsgründungen ist rückläufig, das Durchschnittsalter der Firmen hingegen steigt an (18).

Diese Fakten werden von Wirtschaft und Politik vollkommen ignoriert. Wenn beispielsweise das Wirtschaftsministerium in einer Broschüre (▶Abb. 2-4) Anfang 2016 mit neuen Arbeitsplätzen durch zunehmende Digitalisierung warb, so muss es sich auch fragen lassen, auf welchen Daten sein Optimismus ruht und vor allem, wie es denn um die durch dieselbe Digitalisierung wegfallenden Arbeitsplätze bestellt ist.9

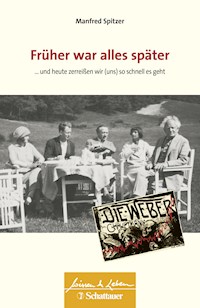

Wer sich darüber informieren will, was technologischer Fortschritt für die betroffenen Menschen bedeuten kann, der lese Die Weber von Gerhart Hauptmann (▶Abb. 2-5). In diesem sozialen Drama aus dem Jahr 1892 geht es um den schlesischen Weberaufstand von 1844, der weder der erste noch der heftigste dieser frühindustriellen Unruhen war, die sich seit dem späten Mittelalter bis ins 19. Jahrhundert hinein in Deutschland ereigneten. Wahrscheinlich hatte er jedoch den größten PR-Effekt, wie man heute sagen würde, insbesondere im Hinblick auf die Märzrevolution von 1848 (19). Wie Hauptmann eindrucksvoll darstellt, litten die Aufständischen Hunger und waren im Hinblick auf ihre wirtschaftliche Verhandlungsmacht den Abnehmern ihrer am Handwebstuhl erzeugten Produkte im Vergleich zur maschinell erzeugten Ware hoffnungslos unterlegen. Die Besitzer der Maschinen nutzten ihre Monopolstellung gnadenlos aus, was zu einem Verfall der Preise für gewebte Textilien führte. Dieser war so stark ausgeprägt, dass er auch durch Nacht- und Kinderarbeit nicht ausgeglichen werden konnte, was bei den Betroffenen zu Mangel, Verelendung und Hunger führte.

Abb.2-4 Die Broschüre Digitalisierung und du (Titelblatt links) wurde im März 2016 vom Bundesministerium für Wirtschaft und Energie (BMWi) publiziert und malt unsere digitale Zukunft in rosigen Farben. So wird für das Jahr 2015 beispielsweise von 50000 neuen Arbeitsplätzen durch die Digitalisierung gesprochen (rechts).

Diese von Gerhart Hauptmann so eindrücklich geschilderte Entwicklung ist ein Beispiel für das, was heute als Disruption bezeichnet wird. Doch während uns Hauptmanns Arbeit „zeitlos“ an die sozialen Folgen eines gnadenlosen Verdrängungswettbewerbs erinnert und zum Nachdenken ermahnt, ist das perfide an der Semantik von „Disruption“, dass mit diesem Begriff eine ökonomische Entwicklung intellektuell attraktiv und zugleich moralisch neutral formulierbar erscheinen soll, die in Wahrheit an den Grundfesten unserer Gemeinschaft nicht nur rüttelt, sondern sie im Laufschritt zerstört. Im Grunde – so bleibt der Eindruck aus dem Hype um diesen Begriff – soll er salonfähig machen, was nicht salonfähig ist; er soll zeigen, wie es um diejenigen bestellt ist, die „moderne“ Entwicklungen nicht wahrnehmen: Sie werden zerrissen. Zudem wird behauptet, dass man mit einer (wert-)konservativen und auf objektive Abschätzung von Technikfolgen bedachten Haltung das eigene Schicksal schon besiegelt habe: Die „Ewiggestrigen“ werden vom Fortschritt zerrissen und sind an diesem eigenen Schicksal auch noch selbst schuld(!), denn sie haben „Disruption“ nicht verstanden. Verlieren und daran auch noch selber schuld sein – dies ist die Botschaft von Disruption, bei der es sich damit um eine gedankenloses Reduktion komplexer ökonomischer Zusammenhänge und Konsequenzen handelt, die an Perfidität kaum zu überbieten ist.

Abb.2-5 Plakat von Emil Orlik (1870–1932) aus dem Jahr 1897 zu Hauptmanns Stück. Dessen Hintergrund – der Aufstand der Weber in Schlesien von 1844 – fasst Wolfgang Büttner (1994) in einem ZEIT-Artikel 150 Jahre danach wie folgt zusammen: „Im preußischen Schlesien ist die Not besonders groß. Das Textilgewerbe im Königreich produzierte mehr Web- und Spinnwaren als alle anderen deutschen Länder. Hier stehen fast fünfzig Prozent aller Webstühle, auf denen Leinen, Baum- oder Halbbaumwolle verarbeitet werden. Aus England kommen mehr und mehr billigere, auf modernen Maschinen hergestellte Waren. In Deutschland ist die historisch überholte Heimindustrie noch weit verbreitet. Außerdem hemmen preußische Gesetze im Interesse der Großgrundbesitzer den industriellen Fortschritt. So sinkt der Preis für die Weber beständig, und Verdienstrückgang lässt sich, selbst wenn der Arbeitstag bis nach Mitternacht ausgedehnt wird, nicht mehr wettmachen.“ Die Aufführung des Stücks war zunächst (am 3.3.1892) vom Polizeipräsidium in Berlin verboten worden, sodass die erste öffentliche Aufführung erst nach der 1893 erfolgten Aufhebung am 25.9.1894 erfolgte.

Aus meiner Sicht lässt sich an der Diskussion um die digitale Disruptivität daher vor allem eines ablesen: der intellektuelle und moralische Verfall eines Teils unserer wirtschaftlichen Elite. Die vermeintliche „Theorie“ ist gar keine, denn sie erlaubt keinerlei Voraussagen oder praktische Anwendungen. Und motiviert ist sie offensichtlich durch die verzweifelte ökonomische Lage mancher im Bereich digitaler Informationstechnik tätiger Firmen, die weder vor Lügen noch vor Handlungen zurückschrecken, die vorsätzlich das Vertrauen anderer Personen ausnutzen, um geschäftliche Vorteile zu erlangen: Man tut so, als könne man mithilfe des Gedankens (der „Theorie“) der Disruption Firmen in zwei Sorten einteilen: Die einen zerreißen, die anderen werden zerrissen. Die emotionale Begleiterscheinung des Gedankens ist gewünscht und wird bewusst provoziert: die Angst vorm eigenen raschen und vollkommen unvermittelten Untergang, der wegen fehlender technischer „Weitsicht“ auch noch selbst verschuldet ist.

Diese Angst ist mittlerweile das alles Digitale beherrschende Grundgefühl. „Im Silicon Valley hat der Glaube an Disruption mittlerweile einen nahezu religiösen Beigeschmack. Alles, was zerreißt, ist gut; und alles, was dem Zerreißen im Wege steht (wie etwa die Taxiunternehmen in San Francisco oder die lokalen Tageszeitungen), verdient es zu verschwinden.“ So charakterisiert es Justin Fox (9, Übersetzung durch den Autor), Chefherausgeber genau derjenigen Zeitschrift – Harvard Business Review –, in der auch die erste Arbeit von Christensen etwa 20 Jahre zuvor erschienen war.10

„Du machst mit, oder Du bist in ein bis zwei Jahren weg“, reden uns die Technik-Gurus ein, die stolz auf das Zerreißen sind und die Angst auch gleich ganz offen thematisieren: Wer Angst habe vor disruptiven Entwicklungen und aus diesem Grund zögere, der sei eben selber schuld, wenn es ihn dann bald erwische. Die Apologeten der neuen Entwicklung überbieten sich geradezu sich mit Negativa, sprechen von Explosion, „Urknall“ und „zerstörender“ [devastating] Innovation – als wäre „zerreißend“ noch zu milde formuliert! (13).

Abb.2-6 Bücher, die man nicht zu lesen braucht – es sei denn, man sucht Beispiele für intellektuell unredliche und moralisch höchst fragwürdige Argumentation.

Der mitverantwortliche Wortschöpfer schreckt nicht einmal davor zurück, in zwei neueren Büchern (▶Abb. 2-6) den Gedanken der Disruptivität auf die schulische sowie die universitäre Bildung zu übertragen (7, 8). Beide sind das Papier nicht wert, auf dem sie gedruckt sind, werden doch in ihnen die mittlerweile vollkommen überzogenen Behauptungen zum Stellenwert digitaler Medien an Schulen und Universitäten auf sehr vage und wenig praktische Weise wiederholt: Man hat bei der durch viel Wirtschaftsjargon nicht gerade erleichterten Lektüre den Eindruck, dass der Autor und seine Koautoren nicht wissen, wovon sie sprechen. Und noch etwas: Wenn sogar Universitäten neue Studiengänge stolz als „disruptiv“ anpreisen11, dann sagt das nichts über den akademischen Wert oder gar die Moralität dieser Gedanken, sondern leider nur etwas über die betreffenden Verantwortlichen an den Universitäten.12

Das schon im vorletzten Jahrhundert weithin bekannt gewordene, trivialisierte Verständnis der Evolution des Menschen als „Abstammung vom Affen“ und als „Fressen oder gefressen werden“ ist mittlerweile als das entlarvt, was es ist: völlig unzureichend, weil zu stark vereinfachend und daher schlichtweg nicht nur falsch, sondern vor allem auch gefährlich! Denn wenn es zur Natur des Menschen gehörte, dass er fressen muss, um nicht gefressen zu werden, dann fände jegliche Form der Aggressivität ihre Rechtfertigung. Nicht umsonst wurde daher im letzten Jahrhundert vielfach und erfolgreich gegen Sozialdarwinismus – dessen schlimmste Auswüchse wir Deutschen nur zu gut kennen – argumentiert. Selbst unter Ökonomen hat sich in den letzten Jahrzehnten die Erkenntnis festgesetzt, dass Fairness und Vertrauen wesentliche und unverzichtbare Ingredienzien eines funktionierenden wirtschaftlichen Miteinanders darstellen (11).

Bei allen denkenden Menschen sollten daher die Alarmglocken dröhnen, wenn jemand von Disruption redet. Wer mit Angst argumentiert, der reitet derzeit zwar auf einer allgegenwärtigen und damit bequemen Welle. Aber er bemerkt dabei zugleich nicht, wie sehr er einer Täuschung unterliegt. Sagt ihm doch sein Bauchgefühl: Je mehr Angst die Leute haben, desto deutlicher wird, dass ich mit der Disruption recht habe. Die Angst der Leute scheint ihm also auch noch recht zu geben!