»Ain't Nothing Like the Real Thing?« E-Book

0,00 €

Mehr erfahren.

- Herausgeber: transcript Verlag

- Kategorie: Geisteswissenschaft

- Serie: Edition Medienwissenschaft

- Sprache: Deutsch

Is this the real thing? Ob Schallplatten, Abbildungen schwarzer Löcher, Deepfakes oder touristische Attraktionen – die Zuschreibung von Authentizität erfüllt in ganz unterschiedlichen Kontexten Funktionen, indem auf den Aspekt der Materialität verwiesen wird. Umgekehrt geraten (mediale) Artefakte auch als Gegenstände von Authentifizierungsprozessen in den Blick. Die Phänomene, denen Authentizität zugeschrieben oder abgesprochen wird, sind dabei so verschieden wie die Disziplinen, die diese Zuschreibungen vornehmen, untersuchen und hinterfragen. Die Beiträger*innen liefern dieser Interdisziplinarität folgend Analysen zur Authentifizierung von und mittels Medien und Artefakten.

Das E-Book können Sie in Legimi-Apps oder einer beliebigen App lesen, die das folgende Format unterstützen:

Seitenzahl: 427

Veröffentlichungsjahr: 2024

Ähnliche

Die E-Book-Ausgabe erscheint im Rahmen der »Open Library Medienwissenschaft 2024« im Open Access.

Die Open Library Community Medienwissenschaft 2024 ist ein Netzwerk wissenschaftlicher Bibliotheken zur Förderung von Open Access in den Sozial- und Geisteswissenschaften:

Vollsponsoren: Technische Universität Berlin / Universitätsbibliothek | Universitätsbibliothek der Humboldt-Universität zu Berlin | Staatsbibliothek zu Berlin - Preußischer Kulturbesitz | Universitätsbibliothek Bielefeld | Universitätsbibliothek Bochum | Universitäts- und Landesbibliothek Bonn | Technische Universität Braunschweig / Universitätsbibliothek | Universitätsbibliothek Chemnitz | Universitäts- und Landesbibliothek Darmstadt | Sächsische Landesbibliothek, Staatsund Universitätsbibliothek Dresden (SLUB Dresden) | Universitätsbibliothek Duisburg-Essen | Universitäts- und Landesbibliothek Düsseldorf | Goethe-Universität Frankfurt am Main / Universitätsbibliothek | Universitätsbibliothek Freiberg | Albert-Ludwigs-Universität Freiburg / Universitätsbibliothek | Niedersächsische Staats- und Universitätsbibliothek Göttingen | Universitätsbibliothek der FernUniversität in Hagen | Staats- und Universitätsbibliothek Hamburg | Gottfried Wilhelm Leibniz Bibliothek - Niedersächsische Landesbibliothek | Technische Informationsbibliothek (TIB) Hannover | Universitätsbibliothek Kassel | Universität zu Köln, Universitäts- und Stadtbibliothek | Universitätsbibliothek Leipzig | Universitätsbibliothek Mainz | Universitätsbibliothek Mannheim | Universitätsbibliothek Marburg | Ludwig-Maximilians-Universität München / Universitätsbibliothek | FH Münster | Universitäts- und Landesbibiliothek Münster | Bibliotheks- und Informationssystem (BIS) der Carl von Ossietzky Universität Oldenburg | Universitätsbibliothek Passau | Universitätsbibliothek Siegen | Universitätsbibliothek Vechta | Universitätsbibliothek der Bauhaus-Universität Weimar | Zentralbibliothek Zürich | Zürcher Hochschule der KünsteSponsoring Light: Universität der Künste Berlin, Universitätsbibliothek | Freie Universität Berlin |Bibliothek der Hochschule Bielefeld |Hochschule für Bildende Künste Braunschweig |Hochschule für Technik und Wirtschaft Dresden - Bibliothek | Hochschule Hannover - Bibliothek | Hochschule für Technik, Wirtschaft und Kultur Leipzig | Hochschule Mittweida, Hochschulbibliothek | Landesbibliothek Oldenburg | Akademie der bildenden Künste Wien, Universitätsbibliothek | Jade Hochschule Wilhelmshaven/Oldenburg/Elsfleth | ZHAW Züricher Hochschule für Angewandte Wissenschaften, Hochschulbibliothek | Westsächsische Hochschule Zwickau | Hochschule Zittau/Görlitz, HochschulbibliothekMikrosponsoring: Ostbayerische Technische Hochschule Amberg-Weiden | Deutsches Zentrum für Integrations- und Migrationsforschung (DeZIM) e.V. | Technische Universität Dortmund | Evangelische Hochschule Dresden | Hochschule für Bildende Künste Dresden | Hochschule für Musik Carl Maria Weber Dresden, Bibliothek | Palucca Hochschule für Tanz Dresden – Bibliothek | Filmmuseum Düsseldorf | Universitätsbibliothek Eichstätt-Ingolstadt | Bibliothek der Pädagogischen Hochschule Freiburg | Berufsakademie Sachsen | Bibliothek der Hochschule für Musik und Theater Hamburg | Hochschule Hamm-Lippstadt | Hochschule Fresenius | ZKM Zentrum für Kunst und Medien Karlsruhe | Hochschule für Grafik und Buchkunst Leipzig | Hochschule für Musik und Theater „Felix Mendelssohn Bartholdy“ Leipzig, Bibliothek | Filmuniversität Babelsberg Konrad Wolf - Universitätsbibliothek | Universitätsbibliothek Regensburg | Bibliothek der Hochschule Rhein-Waal | FHWS Hochschule Würzburg-Schweinfurt

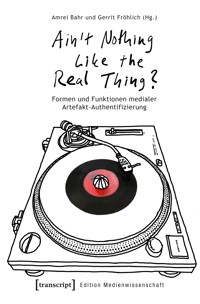

Amrei Bahr, Gerrit Fröhlich (Hg.)

»Ain't Nothing Like the Real Thing?«

Formen und Funktionen medialer Artefakt-Authentifizierung

Gefördert durch die Anton-Betz-Stiftung der Rheinischen Post e.V.

Bibliografische Information der Deutschen Nationalbibliothek

Die Deutsche Nationalbibliothek verzeichnet diese Publikation in der Deutschen Nationalbibliografie; detaillierte bibliografische Daten sind im Internet über https://dnb.dnb.de/ abrufbar.

Dieses Werk ist lizenziert unter der Creative Commons Attribution 4.0 Lizenz (BY). Diese Lizenz erlaubt unter Voraussetzung der Namensnennung des Urhebers die Bearbeitung, Vervielfältigung und Verbreitung des Materials in jedem Format oder Medium für beliebige Zwecke, auch kommerziell.https://creativecommons.org/licenses/by/4.0/

Die Bedingungen der Creative-Commons-Lizenz gelten nur für Originalmaterial. Die Wiederverwendung von Material aus anderen Quellen (gekennzeichnet mit Quellenangabe) wie z.B. Schaubilder, Abbildungen, Fotos und Textauszüge erfordert ggf. weitere Nutzungsgenehmigungen durch den jeweiligen Rechteinhaber.

Erschienen 2024 im transcript Verlag, Bielefeld

© Amrei Bahr, Gerrit Fröhlich (Hg.)

Umschlaggestaltung: Amrei Bahr

Umschlagabbildung: Amrei Bahr

Lektorat: Matthias Warkus

Korrektorat: Matthias Warkus

Druck: Majuskel Medienproduktion GmbH, Wetzlar

https://doi.org/10.14361/9783839461204

Print-ISBN: 978-3-8376-6120-0

PDF-ISBN: 978-3-8394-6120-4

EPUB-ISBN: 978-3-7328-6120-0

Buchreihen-ISSN: 2569-2240

Buchreihen-eISSN: 2702-8984

Inhalt

Einleitung

Amrei Bahr und Gerrit Fröhlich

»What We Thought Was Unseeable«: Die mediale Konstruktion der ersten authentischen empirischen Bilder eines Schwarzen Lochs

Paula Muhr

Authentizität und mindere Technik

Angelika Schwarz

Rillen und Falten oder: Die doppelte Authentifizierung in Chanels Beauté Boutique

Vinylschallplatten, Warenwelt und das Selbst in der Metamoderne

Gerrit Fröhlich, Holger Lund, Katharina Zindel und Oliver Zöllner

Spurenlesen – Digitale Indexikalität und Datenforensik

Sascha Simons

Vom Fake zu funk: Authentizität als Fetisch der Sozialen Medien

Robert Dörre

Politische Öffentlichkeit, Desinformation und das Problem von Deepfakes

Isabel Kusche

Autographische Authentizität – oder die problematische Echtheit autographischer Werke

Joana van de Löcht und Doris Reisinger

Auf der dunklen Seite der Authentizität: »Dark Tourism« und die soziale Produktion des Authentischen

Georg Fischer und Johannes Coughlan

Real oder fake?! Spielarten gegenderter Kleidung im Spannungsfeld der Authentizität

Verena Potthoff und Ulla Stackmann

Erfahrung von Authentizität als symbolische Handlung: Von Zeichen und Bedeutungen in virtuellen Ausstellungsräumen

Felix Liedel

Strategien der Authentizitätsproduktion von der Empfindsamkeit bis zum Straßenrap

Johannes Waßmer

Einleitung

Amrei Bahr und Gerrit Fröhlich

Begeben wir uns auf die Suche nach Authentizitätszuschreibungen – sei es im Alltag oder in der Wissenschaft –, so fällt zweierlei schnell auf: Sie sind so omnipräsent wie vielfältig – und bisweilen sogar gegensätzlich. Im Hinblick auf die wissenschaftliche Auseinandersetzung mit Authentizität lässt sich zudem rasch feststellen, dass sich diese Vielfalt und Uneinheitlichkeit über diverse Disziplinen und Gegenstandsbereiche hinweg erstreckt. Alles Mögliche wird als authentisch bezeichnet, zugleich wird allem Möglichen die Authentizität abgesprochen – und das scheint jeweils ganz Unterschiedliches zu heißen. Dieser Umstand mag den Verdacht nahelegen, dass hier eine gewisse Willkür am Werk ist: Kann »Authentizität« etwa alles Mögliche bedeuten? Sind die Zuschreibungen gar inhaltsleer, fehlt es ihnen an Aussagekraft über dasjenige, auf das sie Bezug nehmen? Gibt es Authentizität am Ende gar nicht? In seinem Büchlein Authentizität. Karriere einer Sehnsucht hält Erik Schilling in diesem Sinne Folgendes fest:

Wichtig ist […] ein Bewusstsein dafür, dass die Bezeichnung eines Menschen, Ortes oder Objekts als ›authentisch‹ die entsprechende Eigenschaft nur zuschreibt. Authentizität jenseits dieser Zuschreibung gibt es nicht. Weil die Bezeichnung als »authentisch« lediglich die Übereinstimmung einer Erwartung mit einer Beobachtung konstatiert, lässt sie nur Rückschlüsse zu über denjenigen, der »authentisch« sagt, über seine Erwartung und Perspektive, was potentiell hochinteressant ist. Wenig bis nichts hingegen sagt die Rede vom »Authentischen« über den Menschen oder das Objekt aus, das als »authentisch« bezeichnet wird. (Schilling 2020: 14).

Dieser Schluss Schillings, dass Authentizitätszuschreibungen sich in einer Auskunft über die Zuschreibenden erschöpfen, erscheint dann doch ebenso überspitzt wie vorschnell. Schließlich ist die Vielfalt begrifflicher Verständnisse wiederum kein exklusives Merkmal der Authentizität – auch andere Begriffe werden je nach Disziplin und Kontext sehr unterschiedlich, teils sogar in einander widerstreitender Weise bestimmt, ohne dass daraus völlige Inhaltsleere folgen würde. Das zeigt sich etwa am Werkbegriff, für dessen Definition sich selbst innerhalb einzelner geisteswissenschaftlicher Disziplinen beachtliche Diskrepanzen feststellen lassen (Bahr 2020). Im Angesicht dieser Diskrepanzen das Vorhaben einer Bestimmung des Werkbegriffs zu verwerfen, erschiene allerdings übereilt, halten doch die Definitionen, die sich in den verschiedenen Disziplinen finden lassen, ganz unterschiedliche, je auf ihre Weise wertvolle Einsichten bereit.

Wie aber sollten wir mit der Vielfalt der Authentizitätsverständnisse umgehen, um diese Einsichten gewinnbringend auszuwerten? Sie sollte uns weder Anlass dazu geben, zwanghaft einen einheitlichen Authentizitätsbegriff festzulegen – noch sollten wir Willkür walten lassen, indem wir alle Authentizitätsverständnisse von vornherein als gleichwertig auffassen. Denn wer zu sehr auf Vereinheitlichung aus ist, gibt zugleich die Einsichten preis, die mit anderen Begriffsverständnissen einhergehen. Ein solcher Verlust ist vermeidbar, wenn es Transparenz und Verständigung über verschiedene Begriffsverständnisse gibt, ohne dass damit zugleich der Anspruch einhergehen müsste, dass sich unter den Vorschlägen der eine, einzig wahre Authentizitätsbegriff ausmachen ließe. Solange nun aber einzelne begriffliche Verständnisse innerhalb der Vielfalt der Authentizitätsauffassungen jeweils konsistent gehandhabt werden, kann auch der Vorwurf der Willkür kaum überzeugen. Am Ende muss sich die Tragfähigkeit einzelner Authentizitätsauffassungen erweisen: In der wissenschaftlichen Auseinandersetzung mit ihnen, indem man sie an etablierten Praktiken und lebensweltlichen Beispielen misst, und indem man offenlegt, was wir aus ihnen lernen können.

Mit dem vorliegenden Sammelband unternehmen wir als Herausgeber_innen gemeinsam mit den Beitragenden den Versuch, in diesem Sinne eine kontext- und disziplinübergreifende Verständigung über den Wert und die Funktion bestimmter Authentizitätszuschreibungen und Begriffsverständnisse anzustoßen. Gerade im Kontrast der unterschiedlichen Herangehensweisen zeigt sich, wie die verschiedenen Authentizitätsauffassungen und ihre wissenschaftlichen Analysen einander gegenseitig erhellen und befruchten können – und sei es nicht durch das Feststellen von Gemeinsamkeiten oder Schnittmengen, sondern durch Abgrenzungen, Unstimmigkeiten und Irritationspotentiale. Um die Vielfalt der diversen Authentizitätszuschreibungen dennoch handhabbar zu halten, haben wir den Gegenstandsbereich dieses Bandes auf (mediale) Artefakte beschränkt. Als Gegenstände von (In)Authentizitätszuschreibungen geraten mediale Artefakte immer wieder in den Blick der unterschiedlichen wissenschaftlichen Disziplinen. Die Arten von Artefakten, denen Authentizität zu- oder abgeschrieben wird, sind dabei so verschieden wie die Disziplinen, die die entsprechenden Zuschreibungen vornehmen, untersuchen und hinterfragen. Als (in)authentisch werden u.a. Werke der Bildenden Kunst, Fotografien, Dokumentarfilme, Texte, historische Quellen, Computerspiele, Nahrungsmittel und (vermeintliche) materielle Zeugnisse vergangener Zeiten apostrophiert.

Abgesehen von der individuellen Authentizität einzelner Artefakte sind oftmals auch Artefakt-Typen Gegenstände (mitunter fragwürdiger) Authentizitätszuschreibungen – das gilt etwa, wenn Fotografien (fälschlicherweise?) als glaubwürdige Dokumentationen von Tatsachen aufgefasst werden: Dabei wird in jeder Epoche bestimmten medialen Artefakten zugestanden oder abgesprochen, Aspekte von Natur oder Personen mittels eines scheinbar nicht-entfremdeten Zugriffs auf die »Wirklichkeit« erfassen und speichern zu können. Über ihre Objektauthentizität hinaus werden mediale Objekte und andere Artefakte zudem als Werkzeuge der Inszenierung eigener Subjektauthentizität genutzt – beispielsweise bei der Benutzung einer analogen Kamera, beim Sammeln von Schallplatten oder beim erfolgreichen Spielen besonders schwieriger digitaler Spiele (während das Spielen von »casual games« auf vermeintlich »inauthentische« Spieler_innen hinweist, vgl. Fröhlich 2020). In Gestalt von medialen Artefakten wie Tagebüchern oder Selftracking-Apps dienen sie überdies als Werkzeuge einer scheinbar authentischen Selbstdarstellung (Fröhlich 2023), während andere Medien – beispielsweise Instagram – per se unter dem Verdacht stehen, inauthentische Inszenierungen zu forcieren (die in diesem Rahmen wiederum nur durch inszenierte Authentizität mit Markern wie #nofilter thematisiert werden können). All dies eröffnet Spannungsfelder von Authentizitätszuschreibungen innerhalb wie auch zwischen den Disziplinen – als gemeinsame Bezugspunkte stellen sie thematisch ein stabilisierendes Moment des Austauschs dar, der in den Beiträgen des Bandes dokumentiert wird.

Den Auftakt des Bandes bildet der Beitrag von Paula Muhr, der sich um Schwarze Löcher und ihre mediale Repräsentation dreht. Bei Schwarzen Löchern handelt es sich um mysteriöse kosmische Objekte, deren enorme Masse sich auf einen einzigen Punkt konzentriert: die sogenannte Singularität. Am 10. April 2019 wurde das erste empirische Bild eines Schwarzen Lochs auf sechs weltweit verteilten und zeitgleich laufenden Pressekonferenzen der Öffentlichkeit präsentiert – die vor 2019 entstandenen wissenschaftlichen Bilder Schwarzer Löcher waren Ergebnisse von Computersimulationen, die die theoretischen Annahmen über diese rätselhaften Objekte visualisierten. Der Beitrag von Paula Muhr widmet sich der Frage nach der Authentizität entsprechender empirischer Bilder. Er zeigt auf, inwiefern sich deren Erstellungsprozess grundsätzlich von der Erstellung fotografischer Aufnahmen unterscheidet und statt als ›taking a picture‹ zutreffender als ›making a picture‹ bezeichnet werden sollte. Beglaubigt wird die Authentizität dieser Bilder dadurch, dass menschliche und nicht-menschliche Akteur_innen durch den Einsatz statistischer Modellierungsmethoden ausreichend visuell konsistente Bildrekonstruktionen aus empirischen Messungen über eine nachvollziehbare Kaskade unterschiedlicher Aufzeichnungen und zahlreicher Zwischenbilder erstellen. Nur so können Bilder erzeugt werden, die nicht nur dasjenige, »what we thought was unseeable«, empirisch visualisierbar machen, sondern auch als neue epistemische Instrumente in der wissenschaftlichen Erforschung von Schwarzen Löchern einsetzbar sind.

Angelika Schwarz widmet sich in ihrem Beitrag der Authentizität im Kontext von minderer Technik: Frühe fotografische VerfahrengeltenMitte des 19. Jahrhunderts als präzise Aufzeichnungsinstrumente der Realität, die einen unverstellten Blick auf die Wirklichkeit erlauben. Mit der alltäglichen Allgegenwart fotografischer wie filmischer Reproduktion und deren stetiger qualitativer Verbesserung ging allerdings bekanntermaßen kein verlässlicher Kontakt mit der Realität einher. Zunehmende Perfektion und Detailtreue in Abbildungen der Wirklichkeit säen eher Zweifel daran, ob hier ein unmittelbarer Zugriff auf die Wirklichkeit gegeben ist oder ob es nicht doch Inszenierungsinteressen sind, die im Hintergrund die Darstellung prägen. Soll der Tatsache Rechnung getragen werden, dass kulturelle Artefakte grundsätzlich eine Produktionsgeschichte aufweisen, kommt gegenüber der Bildindustrie der Gegenwart rasch der Verdacht auf, dass Authentizität durch die technische Zurichtung verloren geht. Es ist dieses Spannungsverhältnis, das der Beitrag in den Blick nimmt: Authentizität und Inszenierung werden gerade nicht im Rahmen einer abstrakten Gegenüberstellung miteinander kontrastiert, sondern es wird stattdessen das Re-Entry der Unterscheidung zwischen dem Authentischen und dem Inauthentischen im Medium des Technischen selbst in den Fokus gerückt. Statt vorauszusetzen, dass der Eindruck des Authentischen sich »in Wirklichkeit« Inszenierungsleistungen verdankt, wird das Augenmerk darauf gerichtet, dass bestimmte inszenatorische Formen den Effekt des Unvermittelten trotz ihrer notwendigen Vermittlung glaubhaft verkörpern, während andere nur den Stempel des Aufgesetzten, des Verstellten, des Arrangierten davontragen. Im Zentrum der Überlegungen steht damit die paradoxale Leitfigur einer »Darstellung von Nichtdarstellung«, die Jan Berg für verschiedene Techniken der medialen Authentifizierung vorgeschlagen hat.

Gerrit Fröhlich, Holger Lund, Katharina Zindel und Oliver Zöllner untersuchen in ihrem Beitrag Authentizität im Kontext von Vinylschallplatten, Warenwelt, Körperarbeit und Identität am Beispiel des temporären Display- und Store-Designs der Chanel Beauté Boutique in Berlin-Mitte im Sommer 2020. Vinyl wird heute auch außerhalb der Musikbranche als Symbol für Coolness und Hipness eingesetzt – nicht zuletzt, da die Schallplatte als analoge Technologie im Kontrast zum Digitalen oft als Authentizitätsgenerator eingesetzt wird. Anhand der bemerkenswerten Verknüpfung von Vinylschallplatten und Luxuskosmetik ziehen die Autor_innen Rückschlüsse auf Medien- und Gesellschaftsstrukturen sowie Konsum- und Marketingstrategien. Der Blick auf die Kampagne offenbart Paradoxien des Authentischen in der Konsumkultur und Spannungen zwischen analoger Nostalgie und digitaler Realität. Weixler spricht von einem »Authentizitäts-Pakt« und bezeichnet damit die Bereitschaft der Rezipient_innen, medialen Produkten aufgrund bestimmter narrativer Verfahren und Inhalte, aber eben auch aufgrund des Formats den Status ›authentisch‹ zuzuschreiben. Dabei geht es weniger um Wahrheit oder Originalität als um die Wahrhaftigkeit der Darstellung, nach der in der postmodernen Gesellschaft eine zunehmende Sehnsucht herrscht, und die in der Konsumkultur durch wechselseitige Zuschreibungen zwischen Marke, Ware und Konsument_innen konstruiert wird. Vor diesem Hintergrund zeigt der Beitrag, wie der Gebrauch von Vinyl als Requisite – in diesem Fall durch Chanel – Authentizität inszeniert wie im gleichen Zuge auch unterläuft.

Im Zentrum des Beitrags von Sascha Simons steht das Spurenlesen, das er mit Fragen der digitalen Indexikalität und der Datenforensik konfrontiert. Digitale Technologien lassen mediale Darstellungen zunehmend verdächtig erscheinen. Einerseits sind dieser Tage öffentliche Äußerungen einer großen Zahl von Personen möglich; andererseits erschweren es die ebenso umfangreichen wie tiefgreifenden digitalen Bearbeitungs- und Reproduktionsmöglichkeiten, mediale Darstellungen durch bloße Anschauung hinsichtlich ihrer Authentizität zu prüfen. Damit geht einher, dass traditionelle Beglaubigungsverfahren nicht ohne Weiteres auf digitale Artefakte übertragbar sind, weil sie sich erstens nicht auf das ohnehin brüchige Indexikalitätsversprechen fotochemischer Aufzeichnung berufen können, weil zweitens die Identifikation von Original und Urheber_innenschaft immer schwieriger wird und weil sich drittens mit der Zusammensetzung der involvierten Produktions- und Distributionsinstanzen auch deren Machtverhältnisse verändern. Dieser Vertrauenskrise zum Trotz verdanken Bilder und Videos von Protestbewegungen wie Black Lives Matter ihre rationale Geltung und affektive Dringlichkeit nach wie vor der Überzeugung, dass das abgebildete Geschehen sich so ereignet habe, wie die Darstellung es nahelegt. Allerdings liegt gerade in der Schwierigkeit, mediale Authentizitätsansprüche zu belegen, eine immense politische Brisanz. Eine besondere Rolle spielt hier die Analyse der im Zuge der Bild- und Videoproduktion und reproduktion entstehenden Metadaten – gemeint sind paratextuelle Daten, die u.a. Auskünfte über Entstehungsort und zeit geben oder Rückschlüsse über die im Verbreitungsprozess involvierten menschlichen und nicht-menschlichen Akteur_innen zulassen. Der Beitrag zeigt, dass sich mit Hilfe dieser Indizien in Form des Reversed Engineering nicht nur einzelne Darstellungen verifizieren bzw. widerlegen, sondern auch ganze Ereignisse retrospektiv modellieren lassen, wie es sich Syrian Archive oder Forensic Architecture zur Aufgabe machen, um Menschenrechtsverletzungen und Umweltverbrechen zu dokumentieren.

Robert Dörre setzt sich in seinem Beitrag mit Authentizität als Fetisch der Sozialen Medienauseinander. Soziale Medien bilden den Rahmen für öffentliche mediale Selbstentwürfe, die vorgeblich der Sphäre des Privaten entstammen. Um die in diesem Zusammenhang produzierten medialen Artefakte – vor allem Texte, Bilder und Videos des Selbst – und wesentlich ihre Authentizität dreht sich ein gesellschaftlicher und akademischer Diskurs. Dabei gilt es zu berücksichtigen, dass in Sozialen Medien beständig mediale Umwelten emergieren, in denen ganz eigene Kriterien von Authentizität verfolgt, kritisiert und verhandelt werden. Diese Formierung und Wandlung von Authentizitätsvorstellungen am Beispiel der Selbstdokumentation auf Plattformen wie YouTube, Snapchat und Instagram zu beschreiben ist ein zentrales Anliegen des Beitrags. In Anlehnung an das von Thomas Weber eingeführte Konzept des medialen Milieus wird vorgeschlagen, von einer milieuspezifischen Authentizität Sozialer Medien zu sprechen. Der Beitrag macht deutlich, inwiefern es allem Wissen um Tendenzen zu Inszenierung und Ökonomisierung in Sozialen Medien zum Trotz Vergnügen und Lust bereitet, Beiträge als authentisch zu behandeln. Authentizität in Sozialen Medien erscheint insoweit nicht nur als leere Sehnsucht, sondern kann erfülltes Spiel sein.

Politische Öffentlichkeit, Desinformation und das Problem von Deepfakes stehen im Zentrum von Isabel Kusches Beitrag.Manipulationen von Audio- und Videoaufzeichnungen gibt es schon länger – als Deepfakes haben sie in jüngerer Zeit zunehmend Konjunktur. Deepfakes werden mittels Deep Learning erzeugt, einem Verfahren maschinellen Lernens, und lassen sich in diesem Sinne den synthetischen Medien zuordnen. Unter diese Sammelbezeichnung fällt Video, Audio, Bild- und Textmaterial, das mithilfe von künstlicher Intelligenz hergestellt wurde. Der Beitrag nimmt zunächst technische Gegenmaßnahmen in den Blick, die auf die Herausforderung reagieren, dass Deepfakes – im Unterschied zu älteren Verfahren der Manipulation von Bildern und Videos – durch das bloße Auge nicht mehr erkennbar sind. Anschließend wird der Fokus auf den Kontext politischer Öffentlichkeit gelenkt, in dem derartige technisch avancierte Manipulationen nur das jüngste Beispiel einer tief verankerten Sorge darüber sind, dass diese politische Öffentlichkeit auf unterschiedliche Weise bewusst getäuscht wird. Vor diesem Hintergrund wird genauer bestimmt, ob und inwiefern es sich bei Deepfakes tatsächlich um eine besondere Herausforderung für die politische Öffentlichkeit handelt – und das heißt, nicht im Hinblick auf die Einordnung technischer Artefakte als authentisch oder nichtauthentisch, sondern im Hinblick auf ihre Effekte im Kontext laufender politischer Kommunikation, in der sich politische Akteur_innen ihren Publika unvermeidlich medial vermittelt präsentieren.

Joanavan de Löcht und Doris Reisinger befassen sich in ihrem Beitrag mit autographischer Authentizität: Ihr Interesse gilt der problematischen Echtheit autobiographischer Werke.Auf den ersten Blick mag die Authentizität von Artefakten nicht nur als etwas Alltägliches, sondern auch als etwas Simples, wenn nicht gar Banales erscheinen: Eine triviale, da augenscheinlich rein materielle und technisch nachweisbare Echtheit, die wenig mit der schwer greifbaren Subjektauthentizität ihrer Urheber_innen zu tun hat. Dabei ist die enge Verknüpfung zwischen Urheber_innen und der Authentizität ihrer Hervorbringungen bereits etymologisch angelegt, denn der Begriff ›authentisch‹ leitet sich vom altgriechischen αὐθέντης mit dem Bedeutungsspektrum ›Mörder oder Suizidant‹, ›Täter‹, ›Herrscher‹ bis hin zu ›Autor‹ her. Am Anfang steht also ein handelndes Subjekt in einer Machtposition. Dies gilt auch für das lateinische ›authenticus‹ – ›zuverlässig, verbürgt‹ sowie in Bezug auf Schriften ›urschriftlich, eigenhändig‹. Diese Verknüpfung bildet bis heute den Kern der Echtheitsbedingung autographischer Artefakte. Hitlers Tagebücher hingegen sind eben deshalb nicht echt, weil Hitler sie nicht selbst geschrieben hat. Bei näherer Betrachtung erweist sich die Authentizität von Artefakten allerdings als weit weniger trivial, als es zunächst den Eindruck macht. Der Beitrag entfaltet die Schwierigkeiten von Authentizitätszuschreibungen zu autographischen und nicht-autographischen Artefakten, indem er die Vielfalt solcher Zuschreibungen über verschiedene Artefaktarten hinweg in den Blick nimmt.

»Dark Tourism« und die soziale Produktion des Authentischen sind Thema des Beitrags von Georg Fischer und Johannes Coughlan, die in diesem Sinne der dunklen Seite der Authentizität (oder besser: der Authentizität der dunklen Seite) nachspüren.Der Beitrag geht von der Diagnose aus, dasseine solche Spielart derAuthentizität in der jüngeren Vergangenheit zu einer zentralen touristischen Ressource avanciert ist. Ausschlaggebend ist dabei nicht nur die Ausdifferenzierung touristischer Angebote und Nachfragen, sondern auch die mediale Kommunikation von als authentisch erfahrbaren Reisen. Dazu gehören insbesondere digitale Medien wie SocialMedia-Plattformen, Reiseberichte in (para)journalistischen Outlets (Blogs, Rundfunk, Zeitschriften, Bücher etc.) sowie einschlägige Buchungsportale. Innerhalb des touristischen Angebots gibt es nicht nur sonnige Badeorte, sondern auch solche, die auf der dunklen Seite des Spektrums liegen: »Dunkel« sind diese Spielarten touristischer Reisen, weil sie nicht zu unbeschwertem Erholungsurlaub (etwa an Sandstränden) einladen, sondern an Orte führen, die mit grausamen historischen Ereignissen in Verbindung stehen, etwa Kriegen, Katastrophen, Genoziden oder anderen Leiden. Um das Phänomen des dunklen Tourismus aufzuschlüsseln, gliedert sich der Beitrag in drei Teile: Zunächst wird in einem historisch-soziologischen Überblick die Verbindung von Medialität und Tourismus untersucht und ein Verständnis vom touristischen Erlebnis skizziert, das auf medialer Vorprägung und entsprechenden Erwartungen beruht. Anschließend werden unter dem doppelten Stichwort »Anklage und Einklage« kursorisch verschiedene tourismussoziologische Perspektiven auf ihr Verhältnis zur Kulturkritik befragt. Schließlich wird das Feld des »Dark Tourism« in den Blick genommen, indem zwei Beispiele herangezogen werden: Tschernobyl und das Berliner Holocaust-Denkmal. Dabei geht es weniger darum, wie sich Authentizität als Substanz theoretisieren lässt – vielmehr wird erforscht, welche Rolle authentisches Erleben in touristischen Praktiken spielt. So wird ein Beitrag zur Diskussion um die soziale Konstruktion von Authentizität als gesellschaftlicher Ressource im Allgemeinen und als touristischer Ressource im Speziellen geleistet.

Mit Spielarten gegenderter Kleidung im Spannungsfeld der Authentizität befasst sich der Beitrag von Verena Potthoff und Ulla Stackmann. Der Beitrag nutzt eine Analyse narrativer Strategien, um aufzuzeigen, wie gegenderte Kleidung als Inszenierungsmittel Geschlechternormen aufruft und innerhalb von filmischen Erzählungen Figuren in ein Verhältnis dazu setzt. Er macht deutlich, inwiefern es sich bei diesen Narrativen letztlich um Spielarten von Kleidungspraktiken handelt, die ein Spannungsfeld der Authentizität eröffnen. Die eigene Performance muss dabei nicht zwangsläufig auf sie zurückgreifen, sondern kann sie ebenso konterkarieren und unterminieren. Maßgeblich ist hier, inwiefern die durch Kleidung aufgerufenen Gendervorstellungen hinterfragt, reflektiert und kritisiert werden. Potthoff und Stackmann zeigen, dass die vestimentäre Inszenierung von Geschlecht oder Gender nicht nur mit Identität und den entsprechenden Rollenzuschreibungen, sondern auch eng mit gesellschaftlichen Machtstrukturen verknüpft ist – dabei können authentische und inauthentische Darstellungen sowohl affirmativ als auch subversiv eingesetzt werden. Das wirft die Frage auf, wie sich eine hier beobachtbare Tendenz zur Veruneindeutigung auf das Verständnis von Authentizität auswirkt. Dem Beitrag liegt die These zugrunde, dass Authentizität in diesem Zusammenhang von einer grundlegenden Offenheit und Unbestimmtheit gekennzeichnet ist. Die ›Zitatförmigkeit‹ schwächt sich ab oder entfällt, sodass Symbole allein nicht mehr hinreichen, um Merkmale für Authentizität zu sein, während Kontext und Auftreten zunehmend an Bedeutung gewinnen. Die Autorinnen lenken den Blick darauf, wie das Vermischen unterschiedlicher Kleidernormen das Ausbilden neuer zitierfähiger Kleidungspraxen ermöglicht.

Felix Liedels Beitrag widmet sich der Erfahrung von Authentizität als symbolischer Handlung am Beispiel virtueller Ausstellungsräume.Deren offensichtlichem Nutzen, der in ihrer Inklusivität, Ortsunabhängigkeit und prinzipiellen konzeptionellen Offenheit liegt, zum Trotz erschweren derzeit noch einige theoretische, technische und methodische Probleme den umfassenden Einsatz virtueller Realitäten in der kulturellen Bildung. Zwar existieren bereits zahlreiche – teils frei zugängliche – virtuelle Ausstellungsräume und Kunstmuseen, die sich mit der VR besuchen lassen. Deren Nutzung bleibt allerdings bislang hinter den Erwartungen zurück. Ein Grund dafür ist die Wahrnehmung der virtuellen Artefakte als »unauthentisch«: Kulturinteressierte suchen in den Artefakten nach dem »Echten« und »Wahrhaftigen«. Die medialen Repräsentationen fungieren als Stellvertreter und werden kulturtheoretisch traditionell oft mit »Verlusterscheinungen« in Verbindung gebracht. Im Beitrag wird dieser Aspekt aus einer medientheoretischen Perspektive im Dialog mit einem symbolisch-interaktionistischen Handlungsmodell genauer untersucht. Erstens geht es dabei um die Frage nach der Zeichenhaftigkeit virtueller Exponate und virtueller Räume und die sich daraus ergebenden medientheoretischen Implikationen. Zweitens um eine tiefere Betrachtung kultureller Objekte als »bedeutungsvolle gesellschaftliche Dinge«, die in virtuellen Räumen ausgestellt werden, und gleichzeitige Interaktion mit dem Medium. Die Zusammenführung beider Argumente führt zu einer medientheoretischen Interpretation des symbolischen Interaktionismus: Virtuelle Ausstellungsräume können als symbolische Orte begriffen werden, in denen bedeutsame subjektive Erfahrungen durch soziale Interaktion und mediale Interaktivität entstehen können.

Johannes Waßmer beschließt den Band mit seinem Beitrag zu Strategien der Authentizitätsproduktion von der Empfindsamkeit bis zum Straßenrap. Autor_innen von empfindsamen Romanen im 18. Jahrhundert ist mit Autor_innen im Straßenrap der Gegenwart gemein, dass sie antreten, um Echtheit zu transportieren und Erzähltes an Erlebtes zu binden. Die ›Originalpapiere‹, die der Schriftsteller Wieland herausgibt, entsprechen diesbezüglich dem »Ich kenne das, ich hab das schon erlebt, Mann« des Rappers Denyo. In beiden Fällen wird strategisch eine bestimmte Relation zwischen Text, Autor_in und Realität her- und offensiv ausgestellt. Der Beitrag zeigt, dass diese Relationsbildung unabhängig von Gattung, Sprachregister, Epoche und Topoi ist und sich über den Begriff der Authentizität erfassen lässt. Authentizität wird dabei als ein Begriff verstanden, über den Relationen hergestellt sowie ›Echtheit‹, ›Wahrhaftigkeit‹, ›Unverfälschtheit‹ zugeschrieben werden. Der Beitrag entwickelt dementsprechend ein Verständnis von Authentizitätsinszenierung, bei dem die Frage nach Eigenschaften von Texten in den Hintergrund tritt. An ihre Stelle rücken die inszenatorische Produktion von Authentizität und deren Strategien. Diese Strategien erfolgen, so die vier den Beitrag strukturierenden Thesen, erstens paratextuell; sie entstehen, weil zweitens Authentizität besondere Relevanz in individualisierten Gesellschaften erfährt; besonderen Reiz üben sie aus, weil drittens mit ihnen Netze wechselseitiger Authentifizierungen gesponnen werden und weil viertens aufgrund der Diffusion verschiedener Begriffe von Authentizität diese zwar ›beliebig‹ wird, mit ihr daher aber umso besser symbolisches Kapital erwirtschaftet werden kann.

Als Herausgeber_innen gilt unser großer Dank der Anton-Betz-Stiftung für die großzügige finanzielle Unterstützung, dem transcript Verlag für die konstruktive und wertschätzende Zusammenarbeit sowie die Förderung des Bandes als Open-Acess-Publikation, Jacqueline Geib für ihre wertvolle Arbeit bei der Anpassung der Beiträge für die Publikation sowie Matthias Warkus für das exzellente Schlussredigat. Besonders danken wollen wir den Autor_innen der Beiträge für ihre Geduld mit uns, denn der Band hätte schon viel früher erscheinen sollen. Da die Wissenschaft nicht nur Authentizität gewinnbringend verhandeln, sondern auch selbst mehr von ihr profitieren sollte, sei dazu gesagt, dass auch im Leben von Wissenschaftler_innen private Herausforderungen keine Seltenheit sind – und dass es nicht immer möglich ist, der wissenschaftlichen Arbeit Priorität einzuräumen, wenn diesen Herausforderungen begegnet werden muss. Wir hoffen sehr, dass die Beiträge nun nicht nur uns, sondern auch vielen interessierten Leser_innen wertvolle Einsichten vermitteln und Impulse geben werden, um zur Bereicherung der Vielfalt von Authentizitätsverständnissen im Kontext medialer Artefakte beizutragen.

Literatur

Bahr, Amrei (2020): »Sich ans Werk machen. Annäherungen an einen geisteswissenschaftlichen Grundbegriff«, in: Zeitschrift für Ästhetik und Allgemeine Kunstwissenschaft 65 (2020), 41–58.

Fröhlich, Gerrit (2023): »The History of Media-Based Technologies of the Self from Rousseau to Runtastic«, in: Peter Gentzel et al. (Hg.): The Forgotten Subject. Subject Constitutions in Mediatized Everyday Worlds. Wiesbaden, S. 191–208.

Fröhlich, Gerrit (2020): »Inauthentizität als digitaler Sündenfall. Öffentliche Konflikte um richtige Spiele, falsche Gamer und wahre Geschichte in der digitalen Spielekultur«, in: Berliner Debatte Initial 02/2020, S. 10–21.

Schilling, Erik (2020): Authentizität: Karriere einer Sehnsucht, München: C.H. Beck.

»What We Thought Was Unseeable«: Die mediale Konstruktion der ersten authentischen empirischen Bilder eines Schwarzen Lochs

Paula Muhr

Einführung

Am 10. April 2019 wurde das erste empirische Bild eines Schwarzen Lochs auf sechs weltweit verteilten und zeitgleich laufenden Pressekonferenzen der Öffentlichkeit präsentiert (Goddi et al. 2019: 32). Dieses bahnbrechende Bild zeigt das supermassereiche rotierende Schwarze Loch M87*, das sich im Zentrum der Riesengalaxie Messier 87 befindet und 55 Millionen Lichtjahre von der Erde entfernt ist.1 Schwarze Löcher sind mysteriöse kosmische Objekte, deren enorme Masse auf einen kleinen Raum konzentriert ist. Infolgedessen entsteht in ihrer unmittelbaren Umgebung ein extrem starkes Gravitationsfeld, dem sogar das Licht nicht entkommen kann. Die Grenze dieses Bereichs wird als Ereignishorizont (engl. event horizon) bezeichnet und gilt als das »definierende Merkmal« eines Schwarzen Lochs (EHTC 2019a: 1). Alles, was den Ereignishorizont nach innen überschreitet, verschwindet im Schwarzen Loch.

Die Existenz von Schwarzen Löchern wurde zuerst von Einsteins Allgemeiner Relativitätstheorie vorhergesagt. Seit den 1970ern gab es eine stetig wachsende Zahl astronomischer Messungen, die indirekte Beweise für die Existenz von Schwarzen Löchern lieferten. Dies geschah zunächst über die Messung ihrer Gravitationswirkungen auf benachbarte astronomische Objekte und im Jahr 2015 durch die Aufzeichnung von Gravitationswellen, Verzerrungen der Raumzeit, die durch die Verschmelzung von zwei Schwarzen Löchern verursacht wurden (vgl. Goddi et al. 2019: 25f.). Diese Messungen ergaben jedoch keine Aufschlüsse über die Eigenschaften der unmittelbaren Umgebungen der Schwarzen Löcher, entsprechend dem von Einsteins Theorie vorhergesagten Ereignishorizont. Insofern waren die vor 2019 entstandenen wissenschaftlichen Bilder Schwarzer Löcher Ergebnisse von Computersimulationen, die die theoretischen Annahmen über diese rätselhaften Objekte visualisierten (vgl. etwa Mościbrodzka/Falcke/Shiokawa 2016).

Im Gegensatz dazu basierten die Bilder, die 2019 von der Event Horizon Telescope (EHT) Collaboration, einem Team von mehr als 200 internationalen Wissenschaftler*innen, erzeugt wurden, das erste Mal auf den empirischen Datensätzen.2 In diesem Sinne gelten die EHT-Bilder als die ersten empirischen Visualisierungen eines Schwarzen Lochs und dadurch auch als der erste »direkte visuelle Beweis« für die Existenz dieser mysteriösen astronomischen Objekte und ihrer Ereignishorizonte (EHTC 2019g).3 Dabei wurde mit diesen Bildern nicht nur ein grundsätzlich unsichtbares kosmisches Phänomen wissenschaftlich sichtbar gemacht. Vielmehr wurden Schwarze Löcher bzw. ihre unmittelbare Umgebung durch die Erstellung der EHT-Bilder empirisch erfassbar und erforschbar gemacht (vgl. dazu Muhr 2023). Wissenschaftler*innen nutzen also diese Bilder, um neue empirische Erkenntnisse über die physikalischen Eigenschaften des M87* zu gewinnen und die bisher rein theoretischen Annahmen über den Ereignishorizont zu testen (EHTC 2019e, 2019f; Muhr 2023).4 Hinsichtlich dieser epistemischen Funktionen, die die EHT-Bilder im Kontext der physikalischen Grundlagenforschung erfüllen, ist ihre empirische Authentizität von höchster Priorität. Damit meine ich Folgendes: Um valide und zuverlässige empirische Informationen über das visualisierte Schwarze Loch liefern zu können, muss nachweisbar sein, dass die EHT-Bilder weder Zufallsprodukte des aufwendigen und – wie wir sehen werden – oft sehr verwickelten bildgebenden Prozesses noch ein Ergebnis rein mathematischer Modellierung sind. Vielmehr muss nachweisbar sein, dass jedes EHT-Bild als Ergebnis seines komplexen Produktionsprozesses einen tragfähigen, in empirischer Messung begründeten referentiellen Bezug zu dem besagten kosmischen Objekt besitzt.5

Zur Betonung dieser empirischen Authentizität wurde das exemplarische EHT-Bild in den Ankündigungen an die breite Öffentlichkeit entweder implizit oder explizit mit einer fotografischen Aufnahme gleichgestellt. »We have taken the first picture of a black hole,« deklarierte Sheperd Doeleman, der Direktor der EHT, in der Pressemitteilung (EHTC 2019g). Andere Mitglieder des EHT-Teams (Wielgus 2020) sowie Autor*innen der zahlreichen Medienberichte haben das EHT-Bild danach explizit als ›Fotografie‹ bezeichnet (Pimbblet 2019; Seidler 2019). Diese diskursive Einbettung der neuartigen Bilder mag vorwiegend dadurch motiviert sein, dass Fotografie oft als das ultimative dokumentarische Medium rezipiert wird, das uns einen angeblich unvermittelten Blick auf »things as they are« ermöglicht (Walker 2020: 371). Zahlreiche medientheoretische Analysen haben jedoch überzeugend gezeigt, dass die vermeintliche mediale Transparenz und die damit verbundene »piktorale Selbstevidenz« der Fotografie nicht intrinsische Eigenschaften des Mediums sind, sondern kulturelle Artefakte, die durch bestimmte Gebrauchsweisen entstehen (Jäger 2006: 47; vgl. auch Walker 2020). Hinzu kommt, dass aus medientheoretischer Sicht die Gleichstellung zwischen den EHT-Bildern und der Fotografie eher irreführend als einleuchtend ist, weil dadurch die Medienspezifik der EHT-Bilder übersehen wird.

Wie in diesem Beitrag gezeigt wird, unterscheidet sich der Erstellungsprozess der EHT-Bilder grundsätzlich von der Erstellung fotografischer Aufnahmen und kann viel zutreffender als ›making a picture‹ statt ›taking a picture‹ bezeichnet werden. Ein Hinweis darauf ist allein die Tatsache, dass die algorithmenbasierteErzeugung der EHT-Bilder aus nichtvisuellen Messdaten fast zwei Jahre in Anspruch genommen hat.6 Was zusätzlich gegen die pauschale Gleichstellung mit Fotografie spricht, ist, dass die EHT-Bilder des Schwarzen Lochs keineswegs mimetische Bilder sind, denn sie ähneln dem Schwarzen Loch visuell nicht.7

Was in jedem 2019 veröffentlichten EHT-Bild zu sehen ist, ist ein rot-orange leuchtender asymmetrischer Ring, dessen unterer Teil heller erscheint (vgl. EHTC 2019a: 5, Fig. 3). Wie das EHT-Team erklärte, visualisiert dieser Ring die innere Region der sogenannten Akkretionsscheibe (ebd.: 6).Diese besteht aus einfallendem glühendem Gas (d.h. Plasma), das sich mit nahezu Lichtgeschwindigkeit um das rotierende Schwarze Loch auf Spiralbahnen bewegt und dabei Strahlung in unterschiedlichen Wellenlängen abgibt.8 In der Mitte befindet sich eine kreisförmige dunkle Region, die durch den innersten Photonenorbit begrenzt ist und als »Schatten« des Schwarzen Lochs bezeichnet wird (EHTC 2019a: 1f.; 2019e: 2; Falcke/Melia/Agol 2000). Es geht aus den Gleichungen der Relativitätstheorie hervor, dass der Photonenorbit eine instabile Kreisbahn in der unmittelbaren Nähe des Ereignishorizonts ist, auf der Lichtteilchen (d.h. Photonen) durch den Einfluss der Gravitationskraft des Schwarzen Lochs gebeugt werden und unendlich oft um das Schwarze Loch kreisen können. Die Photonen, die dieser Bahn entkommen oder sie von außen streifen, können einen entfernten Beobachter erreichen, während diejenigen, die sich innerhalb des Photonenorbits befinden, mit signifikant größerer Wahrscheinlichkeit den Ereignishorizont erreichen. Demnach ist der Schatten durch die Kombination der Lichtbeugung einerseits und des Einfangens von Licht andererseits durch den Ereignishorizont verursacht (Falcke/Melia/Agol 2000: L13f.). Laut den Annahmen der Relativitätstheorie ist daher für einen entfernten Beobachter der Schatten eines rotierendes Schwarzen Lochs mehrfach größer als der Ereignishorizont. Anders gesagt: Der Ereignishorizont selbst ist nicht in den EHT-Bildern sichtbar, da er sich innerhalb des Schattens befindet.9

Im Grunde genommen macht die Messung der elektromagnetischen Strahlung, die die Akkretionsscheibe emittiert und in der Zwischenzeit die Erde erreicht hat, die Erzeugung der EHT-Bilder überhaupt möglich. Jedoch handelt es sich bei der vom EHT-Projekt aufgezeichneten elektromagnetischen Strahlung um Radiowellen, die sich außerhalb des Spektrums des für das menschliche Auge sichtbaren Lichts befinden (EHTC 2019b: 3). Das bedeutet, dass nicht nur das Schwarze Loch und sein Ereignishorizont, sondern auch die umgebende Akkretionsscheibe grundsätzlich unsichtbar sind. Daher sind die EHT-Bilder farbcodierte Darstellungen in sogenannten ›Falschfarben‹. Diese Farben entsprechen nicht den intrinsischen Eigenschaften des visualisierten Objekts, sondern wurden vom EHT-Team arbiträr gewählt (Wielgus 2020).10 Zudem ist sogar der Helligkeitsverlauf der EHT-Bilder nichtmimetisch. Er ist in den Einheiten der sogenannten Helligkeitstemperatur dargestellt. Sie stimmen nicht mit den physikalischen Temperaturen des radioemittierenden Plasmas überein, aus dem die Akkretionsscheibe besteht (EHTC 2019d: 8f.).

Da sich aus epistemischer Sicht der Vergleich mit Fotografie als wenig produktiv erwiesen hat, drängt sich an dieser Stelle folgende Frage auf: Wie wurde die Referentialität der nichtmimetischen EHT-Bilder im Sinne ihrer Fähigkeit, zuverlässige und authentische Informationen über das sonst unzugängliche Schwarzes Loch zu liefern, hergestellt? Auf dem ersten Blick mag die Antwort trivial erscheinen. Man könnte behaupten, die Referentialität dieser Bilder verdanke sich jener komplexen Messung, die einen synchronisierten Einsatz mehrerer Teleskope auf der ganzen Welt beinhaltete, um ein virtuelles, erdumspannendes Teleskop zu bilden. Die so gewonnenen Messdaten – so wird es in Medienberichten meist erklärt – wurden dann dank neuartiger Algorithmen direkt in ein Bild umgewandelt. Diese Erklärung übersieht jedoch die bereits erwähnte Tatsache, dass die digitale Erstellung der EHT-Bilder aus den Messdaten fast zwei Jahre gedauert hat. Warum hat die Transformation der Messdaten in die endgültigen, als authentisch deklarierten Bilder so viel Zeit in Anspruch genommen? Und was genau geschah in diesem Transformationsprozess? Das EHT-Team hat diesen Prozess explizit als Bildrekonstruktion und nicht als Bildkonstruktion bezeichnet (EHTC 2019a: 4). Der Begriff der Bildrekonstruktion, den ich im Folgenden auch verwenden werde, impliziert, dass die EHT-Bilder nicht willkürlich erstellt, sondern aus den empirisch erhobenen Messsignalen zuverlässig zusammengebaut wurden. Mein Hauptargument in diesem Beitrag ist, dass wir gerade diesen aufwendigen Bildrekonstruktionsprozess verstehen müssen, um zu beurteilen, wie der Authentizitätsanspruch der entstandenen EHT-Bilder, im Sinne von ihrer Fähigkeit, »auf die ›wirkliche‹ Welt Bezug zu nehmen und diese von einer ›imaginären‹ Welt zu unterscheiden« (Jäger 2018: 316), erzeugt wurde. Meine Absicht ist dabei keineswegs zu behaupten, dass diese Bilder einen direkten, unmittelbaren Zugang zum dem visualisierten Schwarzen Loch bieten. Vielmehr möchte ich untersuchen, wie ihre Fähigkeit auf eine medientranszendente Realität zu verweisen medial konstruiert wurde. Um dies zu untersuchen, wird meine Analyse auf dem Begriff der Referenzkette des französischen Soziologen Bruno Latour und dem Begriff des medialen Evidenzverfahrens des deutschen Medienwissenschaftlers Ludwig Jäger basieren.

Der medientheoretische Hintergrund

Latour hat überzeugend argumentiert, dass wissenschaftliche Bilder nicht als mimetische Repräsentationen oder bloße visuelle Kopien der medientranszendenten Realität zu verstehen sind. Der Grund dafür sei (Latour 1999: 69f.; 2014: 348), dass die Distanz zwischen einem Phänomen und seinem wissenschaftlichen Bild zu groß ist, um in einem einzigen Schritt überbrückt werden zu können. Stattdessen sind Wissenschaftler*innen gezwungen, eine Reihe von Zwischenschritten einzubauen. Diese ermöglichen es ihnen, die Distanz zwischen dem Phänomen und seinem Bild in kleinere Abstände zu unterteilen, die sie dann durch eine Serie von aufeinanderfolgenden Inskriptionen überbrücken können.11 So entsteht eine Kette von Transformationen, da die Wissenschaftler*innen in jedem Zwischenschritt die Inskriptionen, die aus dem vorhergehenden Schritt übertragen worden sind, überarbeiten und modifizieren, bevor sie sie zum nächsten Schritt transportieren (Latour 1999: 70; 2014: 347).

Wie eine solche Transformationskette in der wissenschaftlichen Praxis eingesetzt wird, zeigt Latour am Beispiel einer Expedition von Bodenwissenschaftler*innen, die er nach Amazonien begleitet. Sie gehen dabei der Frage nach, ob in einer bestimmten Region der Urwald in die Savanne vordringt oder der Urwald sich zurückzieht. Um die Antwort zu finden, entnehmen die Wissenschaftler*innen eine Reihe von Bodenproben, die sie dann durch eine von Latour genau beschriebene Kette von Transformationsschritten letztendlich in ein Diagramm des Bodenprofils umwandeln, das im Zentrum ihres Abschlussberichts steht. Latour (1999.: 70–72) erklärt dazu, dass der Zweck der Transformationen bei jedem Information erzeugenden Schritt zweifach ist. Einerseits bewirken die Transformationen den Wirklichkeitsverlust durch Reduktion von Partikularität der vorangegangenen Inskription. Andererseits führen sie zu Wirklichkeitsgewinn durch Amplifikation der Vermittelbarkeit der nachfolgenden Inskription.

Dementsprechend entsteht das wissenschaftliche Bild als Ergebnis eines Prozesses, in dem eine kontinuierliche Kaskade von unterschiedlichen Aufzeichnungen und Zwischenbildern erzeugt wird. Laut Latour (ebd.: 71f.) ist eine reversible Bewegung entlang einer solchen ununterbrochenen und zurückverfolgbaren Kette der Transformationen das, was die Referenzialität und das wissensproduzierende Potential wissenschaftlicher Bilder garantiert. Anders gesagt: Nicht seine visuellen Eigenschaften, sondern die Details seines Erzeugungsprozesses bürgen für die potentielle empirische Authentizität und Wahrheitsevidenz eines wissenschaftlichen Bildes. Um die Authentizität im Sinne der nachweisbaren Referenzialität eines wissenschaftlichen Bildes überhaupt beurteilen zu können, müssen wir daher die zugrundeliegende Referenzkette analysieren.12

Tatsächlich lässt sich im Falle der EHT-Bilder eine zugrundeliegende Referenzkette erkennen. Sie besteht erstens aus der Erhebung der nichtvisuellen Messdaten (EHTC 2019b); zweitens aus der zweistufigen Datenvorbereitung (EHTC 2019c); und drittens aus der dreistufigen Bildrekonstruktion (EHTC 2019d). Bei näherer Betrachtung weicht jedoch ein wesentlicher Aspekt dieser Kette von Latours Beschreibung ab. In seiner Interpretation ist eine Transformationskette linear aufgebaut aus strikt aufeinanderfolgenden prozeduralen Schritten (Latour 1999: 69–79; vgl. besonders ebd.: 70, Fig. 2.21). Meine Analyse wird zeigen, dass im Gegensatz dazu einige Schritte der Transformationskette der EHT-Bilder – besonders in der Phase der Bilderrekonstruktion – verzweigt sind und aus mehreren, parallel laufenden und aufeinander verweisenden Operationen bestehen. Die Komplexität dieser verzweigten Kette mag auf den ersten Blick redundant erscheinen. Da aber die im April 2019 veröffentlichen EHT-Bilder die ersten ihrer Art waren, existierte zuvor kein etabliertes oder validiertes Verfahren für ihre Herstellung. Stattdessen musste die darunterliegende Referenzkette zuerst nicht nur herausgebildet, sondern auch durch ein entsprechendes mediales Evidenzverfahren – um den durch Jäger eingeführten Begriff zu benutzen – legitimiert werden.

Laut Jäger (2018: 319, Hervorh. im Orig.) muss in Situationen, in denen die Geltung des Wahrheitsgehalts eines Zeichens – im Sinne seiner Bezugnahme »auf die Dadraußenheit einer zeichentranszendente Welt« (d.h., empirische Authentizität) – aus irgendeinem Grund als problematisch erscheint oder noch nicht etabliert wurde, die Legitimität seiner Geltung durch mediale Prozeduren ausgehandelt und also diskursiv hervorgebracht werden. Diese Prozeduren, die in ihrer Gesamtheit von Jäger (2006: 41) als Evidenzverfahren bezeichnet werden, beinhalten die Herstellung eines komplexen Netzes »wechselseitiger Bezugnahmen differenter Medien aufeinander sowie die rekursive Rückwendung eines Mediums auf sich selbst«. Die Herstellung solcher inter- und intramedialen Bezugnahmen zwischen unterschiedlichen Zeichen ist rhetorisch organisiert und bedient sich »in der Regel in prozeduralen Grammatiken organisierter Mittel wie Beweis, Argumentation und Erklärung« (ebd.: 45). Das Resultat dieses Verfahrens der Verschaltung verschiedener Medien miteinander, bei dem »mediale Differenzen prozessiert werden«, nennt Jäger (ebd.: 41) diskursive Evidenz.13 Bei diesem Typus von Evidenz sind die Authentizitätsansprüche nur insoweit gewährleistet, als das darunterliegende Evidenzverfahren »hinsichtlich seiner prozeduralen Schritte nachvollzogen und hinsichtlich seiner Schlüssigkeit eingesehen werden kann« (ebd.: 46).14

Anders als bei Latour ist in Jägers Interpretation die Ununterbrochenheit der Kaskade der medialen Transformationen weder unerlässlich noch ausreichend, um einen zuverlässigen referentiellen Bezug zwischen dem Zeichen und dem medientranszendenten Phänomen herzustellen. Unerlässlich ist jedoch wie bei Latour die Zurückverfolgbarkeit der – hier aber nicht unbedingt linear ablaufenden – prozeduralen Schritte eines diskursiven Evidenzverfahrens. Zudem müssen die operative Notwendigkeit und die evidenzgenerierende Funktion jedes prozeduralen Schrittes dieses Verfahrens argumentativ durch inferentielle Bezüge von Zeichen auf Zeichen begründet werden.

Wie ich im Folgenden zeige, wurde die empirische Authentizität der ersten EHT-Bilder des Schwarzen Lochs durch ein speziell zugeschnittenes diskursives Evidenzverfahren konstruiert und beglaubigt, in dem verschiedene visuelle, mathematisch-algorithmische und rhetorische Operationen miteinander verschränkt wurden. Hier fokussiert sich meine Analyse vorwiegend auf die Phase des dreistufigen Bildrekonstruktionsprozesses, da die medialen Operationen dieser Phase die Transformation von nichtvisuellen Daten in ein Bild bewirken. Vor der Analyse dieser Phase müssen wir aber die vorhergehenden Schritte der Datenerhebung und vorbereitung betrachten, da diese maßgeblich die Art der in der Bildrekonstruktionsphase vorgenommenen Operationen beeinflussen.

Die Erhebung und Vorbereitung der Messdaten

Das Messverfahren, durch das die Daten für die Rekonstruktion der EHT-Bilder erhoben wurden, heißt Langbasisinterferometrie (engl. very long baseline interferometry, VLBI). Sie beruht auf dem synchronisierten Einsatz von mehreren weltweit verteilten Radioteleskopen, die teilweise tausende Kilometer voneinander entfernt sind.15 Die GPS-basierte Synchronisation ermöglicht es, dass die zu einem virtuellen Netzwerk zusammengeschalteten Teleskope die Radiosignale im gleichen Frequenzband desselben Objekts am Himmel mit einer zeitlichen Übereinstimmung aufnehmen, die sich im Bereich von Nanosekunden befindet (EHTC 2019a: 3). Durch die spätere paarweise Überlagerung (Interferenz) der von einzelnen Teleskopen empfangenen Signale erhält man einen Datensatz, aus dem man die Position und/oder die räumlichen Eigenschaften des beobachteten astronomischen Objekts errechnen kann (vgl. dazu Bouman et al. 2016: 913–915). Die VLBI ist grundsätzlich nicht neu – sie wird seit den späten 1960ern benutzt (Thompson/Moran/Swenson 2017: 391). Aber erst durch die gezielte Arbeit des EHT-Teams konnte diese Methode konzeptionell und technologisch signifikant erweitert werden und jene hohe räumliche Auflösung erreichen, die für die Erzeugung der ersten Bilder eines Schwarzen Lochs notwendig war.16 Dabei wurde die notwendige Auflösung auf Basis jener theoretischen, auch als Grundlage für die aufwendigen Computersimulationen dienenden Annahmen über Schwarze Löcher und der bisherigen indirekten Messdaten definiert (EHTC 2019b: 5; Falcke/Melia/Agol 2000).

Generell ist die räumliche Auflösung der VLBI von zwei Faktoren abhängig: erstens dem maximalen Abstand zwischen den einzelnen Teleskopen; zweitens der Wellenlänge des gemessenen Radiosignals.17 Dementsprechend hat die instrumentelle Konstellation, die 2017 speziell für die EHT-Messung von M87* zusammengestellt wurde, den synchronen Einsatz von sieben Teleskopen an fünf geografischen Standorten benötigt, deren Basislängen zwischen 160 m und 10 700 km betrugen (EHTC 2019a: 3).18 Diese Anordnung erwies sich als notwendiges Minimum, um einen zwar extrem lückenhaften, aber für die rechnerische Rekonstruktion der ersten Bilder eines Schwarzen Lochs ausreichenden Datensatz zu liefern.19Trotz relativ geringer Anzahl der Teleskope konnte das EHT-Team durch die Nutzung der sogenannten Aperturesynthese die notwendige Auflösung erreichen: »The rotation of Earth during the night causes the baselines connecting pairs of the telescopes to sweep through a range of angles and effective lengths, filling in the space of possible measurements« (Bouman 2020: 27).

Zudem waren bezüglich der Erhöhung der Auflösung weitere technische Weiterentwicklungen notwendig, um die Messung von Radiosignalen mit der Wellenlänge von 1,3 mm zu ermöglichen (EHTC 2019a: 3). Da die VLBI zuvor im Wellenlängenbereich von mehreren Millimetern bis mehreren Zentimetern erprobt wurde, war die Erweiterung auf die deutlich kürzere Wellenlänge mit neuen Herausforderung verbunden. So führte der Umstieg auf die kurze Wellenlänge zu einer Reihe neuartiger unvermeidbarer Messfehler, die die Bildrekonstruktion erschwerten.20

Zwei Aspekte sind dabei von Interesse für unsere Diskussion: Erstens zeigt die bisherige Beschreibung, dass es sich bei der VLBI-Messung um keine passive Registrierung von Daten handelt, sondern um einen dynamischen Prozess. Denn bereits die Entscheidung darüber, welche Wellenlänge aufgenommen wird, hat direkte Auswirkungen auf die Qualität der erhobenen Daten und ihre anschließende Übersetzbarkeit in Bilder. Zweitens bedeutet das Auftreten der spezifischen, durch die erhöhte räumliche Auflösung bedingten Messfehler, dass die traditionellen Methoden der Datenverarbeitung und Bildrekonstruktion in der VLBI nicht mehr ohne Weiteres für die vom EHT-Team erhobenen Daten geeignet waren. Es gab also kein standardisiertes Verfahren, das die Wissenschaftler*innen benutzen konnten, um die von den sieben Radioteleskopen aufgenommenen Signale in Bilder umzuwandeln. Aus diesem Grund musste das EHT-Team – um mit Latour zu sprechen – eine neue Transformationskette entwickeln und validieren, die auf die spezifischen Eigenschaften ihrer Daten zugeschnitten wurde.

Der erste Schritt in dieser Kette war der aufwendige Prozess der Datenerhebung durch das Interferometer (d.h. das Netzwerk von sieben Radioteleskopen). Diese Datenerhebung wurde am 5., 6., 10. und 11. April 2017 ausgeführt. An jedem dieser Tage fanden zwischen sieben und 25 einzelne Messungen statt, die jeweils zwischen drei und sieben Minuten dauerten (EHTC 2019a: 3). Daraus resultierten ca. 5 Petabyte Rohsignaldaten, die auf Hochleistungsfestplatten gespeichert wurden (Bouman 2020: 27).21 Im nächsten Abschnitt der Transformationskette wurden die Rohsignale der einzelnen Teleskope gemeinsam einer zweistufigen Datenverarbeitung unterzogen, die aus Korrelation und darauffolgender Kalibrierung bestand. Ziel der Datenverarbeitung war es, die Rohdaten in »science-ready data sets« umzuwandeln (EHTC 2019c: 2) und sie damit entsprechend für den nachfolgenden Schritt der Bildrekonstruktion aufzubereiten.

Während dieser Korrelation wurden zwei als Korrelatoren bezeichnete spezielle Supercomputer benutzt, um die paarweisen Rohsignale aller Teleskope zu korrelieren (d.h. zu kombinieren). Für diesen Transformationsschritt verwendeten die Korrelatoren das vorgegebene Modell der Erdgeometrie und die aufgezeichneten Zeitinformationen bei der Ankunft an jeder Station, um die Signale auf eine gemeinsame Zeitreferenz abzustimmen (EHTC 2019c: 3–5). Jeder Korrelator – einer im MIT Haystack Observatory und der andere im Max-Planck-Institut für Radioastronomie in Bonn – prozessierte jeweils die Hälfte des gesamten Datensatzes. Diese Aufteilung und die daraus resultierende Parallelisierung der Korrelation hatten zwei Gründe. Einerseits dienten sie der Beschleunigung des Prozesses. Andererseits ermöglichten sie die anschließende Validierung der von beiden verschiedenen Supercomputern erhaltenen Ergebnisse durch gegenseitigen Vergleich (EHTC 2019b: 14). Da dieser Vergleich wechselseitige Bezugnahmen zwischen den unabhängig prozessierten Datensätzen herstellte, um sie so zu beglaubigen, soll er hier als wichtige Instanz des EHT-spezifischen Evidenzverfahrens (Jäger 2006: 41) gedeutet werden.

Die parallelisierte Korrelation wurde für jeden Messtag gesondert durchgeführt und damit vier unabhängige Datensätze erzeugt. Diese enthielten aber einen hohen Anteil von durch unterschiedliche Messfehler entstandenem Rauschen, das zu einer verfälschten Bildrekonstruktion geführt hätte (EHTC 2019c: 3–5). Um dies zu vermeiden, musste anschließend ein Prozess der Kalibrierung durchgeführt werden. Dieser wurde speziell für die EHT-Daten entwickelt, um »bad data« – d.h. die messbedingten Inkohärenzen und Fehler (z.B. die Phasenverzerrungen, die durch unterschiedliche atmosphärische Bedingungen über den einzelnen Teleskopen entstehen) – zu beseitigen und dadurch einen ausreichend einheitlichen und zuverlässigen Datensatz für jeden Messtag zu erhalten (ebd.: 1 u. 5). In Anlehnung an Latour (1999: 70f.) kann man sagen, dass das EHT-Team bei diesem Transformationsschritt durch die Reduktion von Partikularität der vorangegangenen Datensätze die Amplifikation der Vermittelbarkeit der nachfolgenden Datensätze bewirkte. Dementsprechend fand in diesem Prozess eine enorme Datenkomprimierung statt – die resultierenden Datensätze wurden auf nur 250 Megabytes reduziert (Wielgus 2020).

Die technischen Details der Kalibrierung sind zu umfangreich, um hier genauer betrachtet zu werden. Für unsere Diskussion ist wesentlich, dass die Kalibrierung aus drei voneinander unabhängigen, parallel laufenden und speziell für diese Zwecke maßgeschneiderten automatisierten algorithmischen Pipelines bestand (EHTC 2019c: 4–14). Letztendlich wurde jedoch nur das Ergebnis einer dieser Pipelines als ›the science-ready data set‹ deklariert und für die darauffolgende Bildrekonstruktion benutzt (ebd.: 2). Die Ergebnisse der anderen zwei Pipelines erfüllten dennoch eine entscheidende evidenzgenerierende Funktion. Der Vergleich der kalibrierten Datensätze der verschiedenen Pipelines hatte nämlich gezeigt, dass trotz der unterschiedlichen methodologischen Ansätze bei ihrer Erstellung die jeweiligen Ergebnisse ausreichend konsistent waren (ebd.: 14; 21–23). Diese durch intramediale Bezüge (Jäger 2006: 41) hergestellte Konsistenz diente zur Authentifizierung des Kalibrierungsprozesses, denn sie unterstrich, dass dessen Ergebnisse weder Zufallsprodukte noch reine Artefakte eines bestimmten algorithmenbasierten methodologischen Zugangs waren. Im Folgenden werde ich zeigen, dass sich eine vergleichbare Multiplikation der einzelnen Transformationsschritte in parallel laufenden Operationen durch alle Phasen der Bildrekonstruktion als definierendes Merkmal des EHT-spezifischen Evidenzverfahrens fortsetzt.

Herausforderungen der Bildrekonstruktion

Die als Ergebnis der Datenverarbeitung entstandenen Datensätze bestanden aus einer Reihe von durch paarweise Korrelation von Signalen errechneten Interferenzmustern, die in der Fachsprache als »calibrated complex visibilities« (kalibrierte komplexe Sichtbarkeiten) bezeichnet werden (EHTC 2019d: 4). Diese komplexen Sichtbarkeiten entsprechen Raumfrequenzen – oder im Fachterminus – Fourier-Komponenten der Helligkeitsverteilung des Zielobjekts am Himmel.22 Das bedeutet, dass die mit einem idealen Interferometer gemessenen Sichtbarkeiten durch Anwendung einer erprobten mathematischen Methode, die als Fourier-Transformation bekannt ist, direkt in das Bild des Schwarzen Lochs umgewandelt werden können.

In der Praxis ist der Weg von den gemessenen Sichtbarkeiten bis zum Bild deutlich komplizierter. Erstens beinhalten die kalibrierten Sichtbarkeiten trotz der aufwendigen Datenvorbereitung weiterhin einen hohen Anteil an Rauschen. Das macht ihre direkte Umwandlung in ein empirisch authentisches Bild eines Schwarzen Lochs unmöglich.23 Zweitens sind die EHT-Datensätze stark fragmentarisch und lückenhaft, da nur wenige Fourier-Komponenten des Bildes trotz der oben erwähnten Aperturesynthese gemessen werden können (ebd.). Auch wenn diese Einschränkung für die VLBI charakteristisch ist, war sie im Falle von EHT durch die geringe Anzahl der für die Messung geeigneten Teleskope besonders ausgeprägt (ebd.: 9). Infolgedessen gilt, dass »the inverse problem of determining an image from a measured set of visibilities is ill-posed. Consequently, reconstructed images are not unique – they always require information, assumptions, or constraints beyond the interferometer measurements« (ebd.: 4).

In anderen Worten: Aus dem gleichen kalibrierten EHT-Datensatz können mathematisch unendlich viele unterschiedliche Bilder rekonstruieren werden, deren visuelle Eigenschaften durch eine Reihe von interpretativen Entscheidungen bestimmt sind, die die Wissenschaftler*innen bei der Bildrekonstruktion treffen müssen. Wie konnte man dennoch aus den EHT-Daten empirisch authentische Bilder mit einem referentiellen Bezug zum Schwarzen Loch erzeugen? Und wie konnte die Referentialität der rekonstruierten Bilder beglaubigt werden, wenn es keine unabhängige Verifizierungsmöglichkeit gibt, d.h., »there are no previous VLBI images of any source at 1.3 mm wavelength, and there are no comparable black hole images on event-horizon scales at any wavelength« (EHTC 2019d: 9)? Wie wir im Folgenden sehen werden, lag die Lösung in der Entwicklung einer neuartigen mehrstufigen Bildrekonstruktionskette, in der sich unterschiedliche visuelle, algorithmische und diskursive Operationen im Sinne des Jägerschen Evidenzverfahrens gegenseitig beglaubigten.

»Blind imaging«

Bei der konventionellen VLBI, die Wellenlängen im cm-Bereich misst, ist der Prozess der Bildrekonstruktion gut etabliert. Er besteht typischerweise aus der Anwendung des CLEAN Algorithmus, der 1974 von Jan Högbom entwickelt wurde und auf dem statistischen Verfahren der inversen Modellierung basiert (Thompson/Moran/Swenson 2017: 551–557). Zuerst wird hier aus den kalibrierten Sichtbarkeiten durch inverse Fourier-Transformation ein sogenanntes ›dirty image‹ errechnet, das wegen der lückenhaften verrauschten Messung viele Störungen enthält. Danach arbeitet der Algorithmus durch iterative Schritte daran, diese Störungen mathematisch approximativ zu erfassen und dann aus dem ›schmutzigen Bild‹ zu dekonvolvieren (d.h. herauszurechnen) und so ein optimales ›sauberes‹ Bild zu generieren. Dabei arbeitet der CLEAN-Algorithmus unter der Annahme, dass ein Bild eine Ansammlung von punktförmigen Quellen ist, und sucht dementsprechend nach den hellsten Punkten im Bild (Thompson/Moran/Swenson 2017: 552). Aus der Sicht der EHT ist diese Annahme aber problematisch, da die Akkretionsscheibe nicht eine punktförmige, sondern eine räumlich ausgedehnte Quelle ist, deren innere Struktur von Interesse ist. Zudem ist CLEAN in seiner Standardversion nicht in der Lage, mit jenen spezifischen Arten von Rauschen umzugehen, die in den EHT-Daten enthalten sind (EHTC 2019d: 4; Bouman et al. 2016: 915). Um diese Probleme zu umgehen, passte das EHT-Team im ersten Schritt den CLEAN-Algorithmus an den Bedarf ihrer Daten an. Diese Anpassung erforderte eine Reihe von Expertenentscheidungen und Benutzereingaben, deren potentieller Einfluss auf die Authentizität des endgültigen ›sauberen‹ Bildes a priori nicht klar war.

Mit dem Ziel, optimale Rekonstruktionsergebnisse aus den Daten zu erzeugen, entschied sich das EHT-Team daher, zusätzlich zur Anpassung von CLEAN einen weiteren Bildrekonstruktionsansatz anzuwenden. Es handelt sich um den sogenannten Regularised-Maximum-Likelihood-Ansatz (RML), der zum statistischen Verfahren der Vorwärtsmodellierung gehört und in der optischen Interferometrie und Computer Vision verbreitet ist, jedoch seltener in der Radiointerferometrie verwendet wurde (EHTC 2019d: 4f.; Bouman et al. 2016: 915–917). Bei diesem Ansatz wird das finale Bild als Raster von Pixeln dargestellt. Die speziell dafür entwickelten Algorithmen werden verwendet, um die optimalen numerischen Werte für diese Pixel direkt aus dem EHT-Daten durch statistische Modellierung zu errechnen (EHTC 2019a: 5). Wie Bouman (2020: 29) es erklärt, der RML-Ansatz »starts with an image – say, a fuzzy blob – and uses the observational data to modify this starting guess until it finds an image that looks like an astronomical picture and has a high probability of producing the measurements we observed.« Um eine potentielle Überanpassung des Modells an die Daten und dadurch eine Verfälschung des rekonstruierten Bildes zu vermeiden, müssen bei RML gewisse Bildeigenschaften (z.B. Glattheit und Kompaktheit) von Benutzer*innen als bevorzugt vordefiniert werden.24 Diese Eigenschaften, sogenannte Priors, werden auf Grundlage der vorherigen Annahmen darüber, wie die »physikalisch plausiblen« Bilder aussehen sollen, ausgewählt (EHTC 2019a: 4; vgl. auch Bouman 2017: 41; Bouman et al. 2016: 916). Insofern war auch dieser Ansatz, genauso wie CLEAN, mit einer Reihe von Expertenentscheidungen verbunden, die, falls falsch getroffen, zu unauthentischen Bildern führen können. Darüber hinaus musste die Angemessenheit des RML-Ansatzes, genauer gesagt, die neuen Algorithmen, die vom EHT-Team auf Basis dieses Ansatzes entwickelt wurden, für die Rekonstruktion der EHT-Daten zuerst bewiesen werden.

Um die Zuverlässigkeit sowohl des angepassten CLEAN- als auch des neueren RML-Ansatzes bei der Anwendung auf die EHT-Daten zu bewerten und deren Effekte miteinander zu vergleichen, führte das EHT-Team eine zusätzliche Stufe der Bildrekonstruktion namens ›blind imaging‹ ein, die bei der standardmäßigen VLBI nicht vorhanden ist. Das ›blind imaging‹ bestand daraus, dass mehrere Teams »were blind to each others’ work«, während sie an demselben Datensatz arbeiteten (EHTC 2019d: 9).25 Auf den ersten Blick mag diese zusätzliche Stufe der Bildrekonstruktion Nichtexpert*innen redundant erscheinen. Im Folgenden werde ich aber zeigen, dass ›blind imaging‹ mit einer Verschränkung von menschlichen Expertenurteilen und algorithmischen Prozeduren eine wichtige Rolle in der Erstellung der empirischen Authentizität der EHT-Bilder spielte.

Während der ›blind imaging‹-Stufe der Bildrekonstruktion