Erhalten Sie Zugang zu diesem und mehr als 300000 Büchern ab EUR 5,99 monatlich.

- Herausgeber: BoD - Books on Demand

- Kategorie: Wissenschaft und neue Technologien

- Sprache: Deutsch

Ein kritischer und realistischer Einblick hinter die Kulissen von KI und des digitalen Wandels. Ein Buch für alle, die die Hintergründe der Technologie wirklich verstehen wollen: Wer KI für Magie hält, wird hier enttäuscht - wer sie verstehen will, kommt voll auf seine Kosten. Folgende grundlegenden Fragen werden behandelt: Wie funktioniert KI? Was sind die Schwachstellen der Technologie? Ist der Hype darüber übertrieben? Wie groß ist die Abhängigkiet von den US-Konzernen? Welchen Einfluss hat die KI auf die "Cloudifizierung" und die zunehmend datengetriebenen Geschäftsmodelle?

Sie lesen das E-Book in den Legimi-Apps auf:

Seitenzahl: 213

Veröffentlichungsjahr: 2025

Das E-Book (TTS) können Sie hören im Abo „Legimi Premium” in Legimi-Apps auf:

Ähnliche

INHALTSVERZEICHNIS

Einleitung

Was ist Künstliche Intelligenz?

Geschichte der Informationstechnologie

Meilensteine

Der Erfolgsfaktor Rechenleistung

Geschichte der KI

KI - Wie funktioniert das?

Expertensysteme

Maschinelles Lernen

Regelbasiert vs. Deep Learning

Das Orakel von Delphi

Die Black-Box

Daten-Monokultur

Cloudifizierung

Medien aus der Maschine

Generative KI

Deepfakes - Die Zerstörung der Wahrheit

Computerkriminalität

Daten-Sammler

KI Agenten

Das Google-Prinzip

Überwachung

Regulierungen

DSGVO

AI Act

Kartellmaßnahmen

Grenzen der KI

Blick in die Zukunft

Literaturverzeichnis

Bildnachweis

Einleitung

Die Künstliche Intelligenz (KI) stellt ohne Frage einen der wichtigsten Meilensteine in der Geschichte der Informationstechnologie dar. KI umfasst heute schon alle Bereiche unseres digitalen Lebens, von intelligenten Assistenten wie Alexa bis hin zu Staubsaugerrobotern, Unterstützung in der medizinischen Diagnostik oder militärischen Systemen wie Israels „Iron Dome”. In einigen Bereichen wird der Einsatz mit großer medialer Aufmerksamkeit verfolgt, in anderen Bereichen dagegen hat sich die Technik fast unbemerkt verbreitet und etabliert.

Wohl kaum jemand würde die Rechen-Ergebnisse einer digitalen Kasse im Supermarkt per Hand nachrechnen oder die Addition auf einer Online-Rechnung mit Papier und Bleistift kontrollieren. Computer arbeiten schließlich exakt. Mit der KI begegnet uns aber jetzt eine digitale Technologie, die nicht immer exakt arbeitet und in Teilen auf Wahrscheinlichkeiten und Abschätzungen beruht. Der gegenwärtige KI-Hype verdeckt leider fundamentale Probleme, die mit der rasanten Entwicklung und dem Einsatz dieser Technologien einhergehen. Die aktuellen KI-Techniken besitzen Schwächen und Mängel, über die man zumindest seitens der Entwickler und Betreiber ungern spricht. Jetzt ist es an der Zeit, darüber nachzudenken, wie wir mit dieser Problematik umgehen wollen.

Oberflächlich betrachtet ist Google eine Suchmaschine, der Inhaber einer gut besuchten Webseite kann darauf Werbung schalten, die meisten Dienste im Internet sind umsonst und KI macht unser Leben einfacher. Wenngleich diese Ausführungen ihre Richtigkeit haben, erschließen sich bei näherer Betrachtung wesentliche Zusammenhänge zwischen den genannten Elementen. Hinter den Kulissen wird die digitale Wirtschaft von einigen wenigen führenden Unternehmen durch ausgefeilte Techniken gestaltet, oftmals ohne dass man als Nutzer diese komplexen Prozesse wahrnimmt. So verdient Google bei fast jeglicher Werbung im Internet mit und wir bezahlen alle für den Betrieb der scheinbar kostenlosen Dienste mit unseren Daten. Der Nutzen der KI liegt vor allem in der schnellen Verarbeitung riesiger Datenmengen, die der Betrieb des Internets mit sich bringt und die für die digitalen Geschäftsmodelle notwendig sind. KI ist somit in erster Linie ein Segen für die großen Konzerne, deren Dominanz stetig und ungehindert zugenommen hat.

Die KI erfährt heute in der Öffentlichkeit oft eine hohe Akzeptanz, Unternehmen werben mit ihrem Einsatz und es werden die KI-Funktionalitäten bei Produkten als Qualitätskriterium angepriesen. Eine verantwortungsvolle Entwicklung und Nutzung von KI erfordert allerdings eine differenziertere Auseinandersetzung als den gegenwärtigen Medienrummel. Es fehlen darüber hinaus wirksame Regulierungen, die die künftige Nutzung von KI-Technologien effektiv unter Kontrolle bringen und ihre Entwicklung in gemeinwohlorientierte Bahnen lenken. Die Speicherung sensibler Daten in riesigen Rechen- und Datenzentren unter Kontrolle großer Konzerne nimmt unter anderem durch den Einsatz von KI immer mehr zu. Anders als frühere technologische Revolutionen schafft die Digitalisierung eine Infrastruktur, auf der immer neue Anwendungen und Transformationen aufbauen können. Die „Cloudifizierung” unseres Alltags schreitet stetig und scheinbar unausweichlich voran. Die KI ist der entscheidende Faktor für die weitere Entwicklung dieser neuen Infrastruktur.

Dieses Buch beleuchtet die Thematik differenziert und scheut sich nicht davor, sie kritisch zu hinterfragen. Es präsentiert die Technologie weder als Allheilmittel noch als apokalyptische Bedrohung. Stattdessen lädt es Sie ein, die komplexe Realität der KI zu erkunden: Wie funktioniert sie wirklich? Welche Probleme bringt sie mit sich? Wem nutzt die KI letztendlich mehr, den großen Konzernen oder den Nutzern? Wie kann man einen verantwortungsvollen Einsatz gestalten?

In den ersten Kapiteln verfolgen wir den Weg der Digitalisierung, von den Anfängen bis zu aktuellen Techniken der Künstlichen Intelligenz. Dem Leser werden die technologischen Grundlagen der KI auf verständliche Weise vermittelt, wobei die inhaltliche Genauigkeit nicht verloren geht. Der Ausdruck „Künstliche Intelligenz” wird entzaubert, und ihre technischen Grundlagen werden transparent vermittelt. Es wird ein Blick hinter die Fassaden geworfen und erklärt, warum die Technik schon in ihren Grundlagen mit Ungenauigkeit, Unschärfe und Uneindeutigkeit einhergeht.

Die folgenden Kapitel beleuchten kritisch die verschiedenen Aspekte der KI vor dem Hintergrund der wirtschaftlichen Interessen der großen US-Konzerne. Den unbequemen Fragen wird dabei nicht aus dem Weg gegangen. Wie sicher sind unsere Daten? Wie abhängig ist inzwischen unsere Infrastruktur von den amerikanischen Tech-Konzernen? Wie unsicher sind Cloud-Datenzentren?

Zum Abschluss wird ein Blick in die Zukunft gewagt und mögliche technische Weiterentwicklungen werden vorgestellt.

Dieses Buch setzt sich kritisch mit der Thematik auseinander und bietet neue Blickwinkel, die gängige mediale Darstellungen hinterfragen. Es soll das notwendige Wissen und die wesentlichen Einblicke vermittelt werden, um einen freien und unverfälschten Blick hinter die Fassade zu ermöglichen. KI betrifft letztlich nicht nur Technik und Wirtschaft, sondern verändert unseren Alltag und unsere Lebensweise immer mehr. Diese Veränderung wird weiter stattfinden, ob wir wollen oder nicht. Aber auf die Art und Weise, wie sie weiter fortschreitet, können wir durchaus noch in mehrfacher Hinsicht Einfluss nehmen.

Was ist Künstliche Intelligenz?

Abb. 2.1 Die Erforschung künstlicher Intelligenz reicht weit in die Vergangenheit zurück.

Intelligenz wird oft als die Fähigkeit definiert, zu lernen, zu verstehen und auf neue Situationen zu reagieren. Menschliche Intelligenz bedeutet vor allem, kluge Entscheidungen zu treffen, basierend auf Wissen und Verständnis. Oft sprechen wir von menschlicher Intelligenz, als eine einzelne Eigenschaft. Aber sie umfasst alle geistigen Fähigkeiten und besteht bei näherer Betrachtung aus einem Bündel von verschiedenen kognitiven Fähigkeiten.

Kognitive Fähigkeiten sind die spezifischen geistigen Prozesse, die Intelligenz ermöglichen [1]. Die Kognition selber kann in verschiedene Bereiche untergliedert werden:

Wahrnehmung der Umwelt: Über unsere Sinne

Aufmerksamkeit auf spezielle Geschehen: Objekte des Interesses

Nachdenken: Verarbeitung der Information im Gehirn

Speicherung der Information: Gedächtnisspeicherung für spätere Erinnerung

Zuweisung von Bedeutungen: Meist über Sprache

Die besondere Stärke menschlicher Intelligenz liegt also im Zusammenspiel dieser verschiedenen Gesichtspunkte. Dieses Zusammenwirken macht menschliche Intelligenz damit zu mehr als der Summe ihrer Teile.

Die uralte Frage, ob Maschinen intelligent sein können war lange Zeit eine philosophische. Seit dem Beginn der Informationswissenschaften, ist sie aber auch eine technische. Der Begriff Künstliche Intelligenz ist ein Sammelbegriff für unterschiedlichste Techniken, die dazu dienen sollen, Maschinen in die Lage zu versetzen Aufgaben auszuführen, die normalerweise menschliche Intelligenz erfordern. KI soll es Computern ermöglichen, komplizierte Aufgaben mit Leistung auf menschlichem Niveau zu lösen. „Künstliche Intelligenz” ist ein umfassender Allgemeinbegriff und keine einheitliche Technologie. Dazu kommt noch, dass „KI” auch oft als Marketingbegriff genutzt wird, um Produkte oder Dienstleistungen attraktiver erscheinen zu lassen. Die Bandbreite der Bedeutung reicht von einfachen Rechenanleitungen bis hin zu der hypothetischen, menschenähnlichen Künstlichen Intelligenz.

KI imitiert beziehungsweise simuliert menschliche kognitive Fähigkeiten und versucht obendrein das menschliche Niveau zu erreichen, oder zu übertreffen. Wir reden also über nicht mehr und weniger, als über die digitale Vision der Neuerfindung der naturgegebenen Intelligenz.

Der Informatiker spricht schon mal über KI auf menschlichem Niveau und meint dabei sehr oft das Niveau der fähigsten Menschen in einem Bereich. Man muss hier beachten, dass der Abstand zwischen Mittelmaß und dem fähigsten Menschen in einigen Gebieten sehr groß und in anderen Bereichen eher weniger groß ausfällt. Beispiele wären hier einmal das kleine Einmaleins und das Schachspielen auf der anderen Seite der Skala.

Der Mathematiker Alan Turing stellte 1950 in einem Aufsatz ein Gedankenexperiment vor, das seither als Turing Test bekannt ist. Die zentrale Idee besteht darin, dass eine Maschine als intelligent betrachtet werden kann, wenn sie in der Lage ist, menschliche Kommunikation so zu simulieren, dass ein Mensch wiederum nicht unterscheiden kann, ob er mit einer Maschine oder einem Menschen interagiert [2].

Der Test funktioniert im Detail wie folgt. Es gibt drei Teilnehmer: einen menschlichen Fragesteller, einen menschlichen Probanden und eine Maschine, die getestet wird. Der Fragesteller weiß nicht, wer der Mensch und wer die Maschine ist. Der Fragesteller stellt beiden Teilnehmern Fragen. Die Maschine versucht, den Fragesteller davon zu überzeugen, dass sie der menschliche Teilnehmer ist, während der menschliche Proband ebenfalls versucht, dies zu tun. Wenn der Fragesteller nach einer bestimmten Zeit nicht mehr zuverlässig unterscheiden kann, wer der Mensch und wer die Maschine ist, hat die Maschine den Test bestanden.

Bisher hat den Test keine Software wirklich erfolgreich absolviert. Die Schätzungen, bis wann der Turing-Test von einer Software mit positivem Ergebnis abgeschlossen wird, weichen sehr stark voneinander ab. Ray Kurzweil, leitender Forscher und KI-Visionär bei Google, prognostiziert das Jahr 2029 [15]. Heutige KI-Systeme wie ChatGPT sind in der Lage, extrem menschenähnliche Gespräche zu führen, und in abgegrenzten Themengebieten könnten sie den Turing-Test möglicherweise bestehen. Der Turing-Test war ein Meilenstein, doch es bleibt die grundlegende Frage, ob eine Maschine wirklich als intelligent angesehen werden kann, wenn sie uns zwar täuschen kann, aber kein Bewusstsein hat. Es gibt inzwischen auch alternative Tests, die über das reine Konversationsvermögen hinausgehen und verschiedene Aspekte der Intelligenz zu erfassen versuchen.

Ein Beispiel hierfür ist der Marcus-Test, entwickelt vom Neurowissenschaftler Gary Marcus. Es handelt sich nicht um einen klar definierten Test mit einem festen Fragenkatalog, sondern eher um ein Konzept oder einen Handlungsrahmen. Die KI wird dabei unter anderem dazu befragt, wie sie die ihr vorgeführte Fernsehsendung interpretiert. Im Gegensatz zu komplexen mathematischen Problemen oder Aufgaben, die mit Texten arbeiten, bei denen KI oft sehr gut abschneidet, prüft der Test das grundlegende Weltverständnis durch scheinbar einfache Fragen. Fragen wie „Braucht ein Fisch eine Leiter, um aus dem Wasser zu kommen?”, „Ein Mann kauft ein Ticket für einen Zug, aber bevor er einsteigt, wird der Zug durch einen anderen ersetzt. Ist es noch derselbe Zug?” oder „Bleibt man trocken, wenn man im Regen steht, aber die Augen schließt?” erscheinen für den Menschen einfach, können KI-Systeme aber in Schwierigkeiten bringen [4]. Die Fragen sind darauf ausgelegt, die Grenzen und Schwächen von KI-Systemen aufzudecken. Die Fragen bringen KI in Schwierigkeiten, weil sie oft auf menschliches Verständnis oder gesunden Menschenverstand abzielen. KI kann Fakten aus Datenbanken abrufen, aber es fehlt ihr das intuitive Verständnis von Alltagswissen.

Abb. 2.2 Das chinesische Zimmer

Es gibt ein schönes Gedankenexperiment mit dem Namen „Das chinesische Zimmer”, das 1980 von dem Philosophen John Searle entwickelt wurde, um die Grenzen der KI und die Natur des Verstehens zu verdeutlichen [3]. Das Experiment funktioniert wie folgt:

Ein Mann sitzt in einem geschlossenen Raum. Er versteht kein Chinesisch, hat aber ein umfassendes Regelwerk, ähnlich einem Computerprogramm zur Verfügung. Von außen werden ihm Fragen in Form von chinesischen Schriftzeichen hereingereicht. Mit Hilfe seines Regelwerks kann der Mann die passenden chinesischen Zeichen als Antwort zurückgeben, ohne die Bedeutung der Zeichen zu verstehen. Für einen Beobachter außerhalb des Raums erscheint es, als ob der Mann im Raum Chinesisch beherrscht, da er scheinbar sinnvolle Antworten gibt. In Wirklichkeit gibt es jedoch kein echtes Verstehen, sondern nur eine vorschriftsmäßige Handhabung von Zeichen nach vorgegebenen Regeln.

Heutige KI-Systeme arbeiten ähnlich, in dem sie Zeichen nach Regeln verarbeiten, ohne deren Bedeutung zu verstehen. Selbst wenn ein Computer einen Turing-Test besteht, bedeutet das nicht, dass er wirklich etwas versteht. Dieses Gedankenexperiment zeigt, dass selbst die besten KI-Systeme kein echtes Bewusstsein oder Verständnis besitzen, sondern nur Simulationen dieser Fähigkeiten sind. Man kann jedoch auch die Auffassung vertreten, dass KI lediglich Probleme lösen soll, ohne die zugrundeliegenden Zusammenhänge bewusst zu erkennen. Wenn ein Übersetzungsprogramm, das moderne KI-Techniken nutzt, einen russischen Aufsatz fehlerfrei ins Deutsche überträgt, kann man dennoch sicher sein, dass es den Inhalt nicht wirklich verstanden hat. Jenseits dieser technischen Sicht, bleibt es wohl Ansichtssache, ob man die perfekte Lösung als intelligent bezeichnet.

Oft fällt auch heutzutage der Begriff der Generativen Künstlichen Intelligenz . Damit werden Systeme bezeichnet, die völlig neue Inhalte wie Texte, Bilder oder Videos mittels KI erstellen. Generative KI unterscheidet sich vor allem dadurch, dass sie kreativ tätig ist und völlig neue Inhalte erstellt. Beispiele für generative KI sind Chatbots (Dialogsysteme) wie ChatGPT oder Bilder-KIs. Nicht-generative KI hingegen, wie Gesichtserkennung, autonomes Fahren oder Vorhersagemodelle, beschäftigt sich oft mit Analyse, Optimierung oder Entscheidungsfindung. Beispiele hierfür sind auch Übersetzungssysteme oder medizinische Diagnosesysteme. Es handelt sich dabei nicht um eine technische Abgrenzung, sondern vielmehr um eine inhaltliche Betrachtung der Aufgabenstellung.

KI-Systeme sind heute noch auf spezifische Aufgaben beschränkt, für die sie entwickelt wurden. Die Forschung allerdings ist bereits auf der Suche nach einer Künstlichen Allgemeinen Intelligenz (engl. Artificial General Intelligence, AGI), auch starke KI genannt. AGI-Systeme sollen im Gegensatz zur heutigen spezialisierten KI übergreifende Probleme lösen und sich flexibel an neue Herausforderungen anpassen können, wie ein Mensch, ohne manuelles Eingreifen. AGI ist also ein hypothetisches Computerprogramm mit menschlichem Verständnis und geistigen Fähigkeiten. Es kann wie der Mensch lernen, ungewohnte Aufgaben zu bewältigen, ohne dass eine zusätzliche Ausbildung erforderlich ist. AGI könnte kontinuierlich lernen und sich weiterentwickeln. Eine starke KI würde ein eigenes Bewusstsein besitzen und möglicherweise ein eigenes Verständnis von Identität und Existenz entwickeln.

Abb. 2.3 Automatisierung in der Antike

Die Vision einer Künstlichen Allgemeinen Intelligenz ist schon sehr alt und lässt sich bis in die Antike zurückverfolgen. So erschuf Hephaistos, der Gott des Feuers, laut griechischer Mythologie künstliche Diener aus Gold. Sie konnten sich eigenständig bewegen und Hephaistos bei seiner Arbeit unterstützen [5]. In der Science Fiction Serie Raumschiff Enterprise, aus den 60er Jahren, hatte es Captain Kirk sehr häufig mit solchen Intelligenzen zu tun, die mit Sprache, Verstand und Bewusstsein ausgestattet waren, ohne dabei die Gestalt menschenähnlicher Roboter zu haben [6]. Im Kontrast zu der oft kalten und gefühllosen KI wurde Kirks Menschlichkeit, Intuition und Emotionalität oftmals als Stärke dargestellt. Das ist aus heutiger Sicht und in einer Zeit der allgemeinen KI-Begeisterung sehr bemerkenswert. In gewisser Weise war die Serie ihrer Zeit voraus, weil sie Fragen über Künstliche Intelligenz stellte, die heute im Fokus der Diskussionen stehen.

Auf die Frage, wann eine solche AGI verfügbar sein wird, gibt es sehr unterschiedliche Antworten. Ray Kurzweil, Leiter der technischen Entwicklung bei Google, sieht sie schon ab 2045 realisierbar [15]. Es ist naheliegend, dass die Vorstellung einer AGI auch den Interessen der großen IT-Konzerne entspricht. Daher könnte die Erzählung dazu die nen, die erheblichen Investitionen in KI zu rechtfertigen und ihre Wirkung zu maximieren. Allein mit der Perspektive auf eine AGI lassen sich beträchtliche Vermögenswerte generieren. Visionäre Versprechungen können aber auch zu überhöhten Unternehmensbewertungen führen, die nicht auf realistischen technologischen Grundlagen basieren. Weniger optimistische Schätzungen gehen von einer Verfügbarkeit um das Jahr 2100 aus.

Geschichte der Informationstechnologie

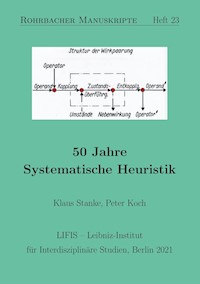

Abb. 3.1 Technologischer Fortschritt ist der Motor der digitalen Revolution.

Um Künstliche Intelligenz richtig einzuordnen, sollte man sie im Zusammenhang der gesamten Digitalisierung betrachten. Dabei ist es wichtig, die historische Entwicklung der IT nachzuvollziehen und die rasante Fortschrittsgeschwindigkeit der IT zu beachten. Waren es zu Beginn Jahrzehnte und danach Jahre, so kann man heute fast schon in Quartalsabständen Fortschritte vernehmen. Entgegen der öffentlichen Wahrnehmung ist KI kein neues Phänomen, die Techniken existieren schon sehr lange. Die Verfügbarkeit immer größerer Rechenleistungen zu immer günstigeren Preisen führte schließlich zum Durchbruch.

Meilensteine

1941 Der erste Digitalrechner Z3

Der deutsche Ingenieur Konrad Zuse stellte 1941 den ersten funktionsfähigen Digitalrechner vor. Die sogenannte Z3 wurde in elektromagnetischer Relaistechnik mit 600 Relais für das Rechenwerk und 1400 Relais für das Speicherwerk ausgeführt. Die kleiderschrankgroße Maschine schaffte zwei FLOPS (englisch für Floating Point Operations Per Second), d.h. Gleitkommaoperationen pro Sekunde. Die Z3 gilt als erster funkti onsfähiger Universalrechner der Welt. Er besaß schon recht viele Eigenschaften moderner Rechner. Das System arbeitete digital, hatte einen Speicher, war programmierbar und damit universell einsetzbar [1]. Der Grundstein für die Entwicklung moderner Computer war gelegt.

1981 Der erste PC

1981 bringt der damalige Weltmarktführer IBM den ersten Personal Computer PC, ein Einzelplatzrechner für den persönlichen Gebrauch auf den Markt. Der PC stellte keine wirkliche technische Neuerung dar. Produkte von Atari, Commodore und Apple hatten sich vorher schon am Markt etabliert. IBM konnte damit aber einen Standard setzen. IBM hatte damals kein eigenes Betriebssystem für den geplanten PC. Also kaufte IBM sein DOS-System bei dem Startup Unternehmen Microsoft. Aus dem kleinen, von Bill Gates und Paul Allen gegründeten Microsoft erwuchs ein Imperium, dessen Einfluss die gesamte Technologiebranche bis gegenwärtig prägt. Heute ist der Personal Computer in den unterschiedlichsten Formen wie Notebooks, Laptops oder Tablet-PCs allgegenwärtig. Der rasante Siegeszug des PCs sorgte dafür, dass in den Büros dieser Welt bald jeder Arbeitsplatz mit einem Computer ausgestattet war. Textverarbeitung und Tabellenkalkulationsprogramme ebneten den Erfolg. Bereits nach kurzer Zeit war der PC ebenfalls in den meisten Haushalten anzutreffen [2].

1994 Das Internet verändert die Welt

Der Vorläufer des weltweiten Verbundes von Rechnernetzen, dem Internet, war das ARPANET, ein Netzwerk das den Datenaustausch zwischen amerikanischen Universitäten erlaubte. 1971 versandte man die erste E-Mail darin und die ersten Rechner außerhalb der USA wurden dann 1974 an das ARPANET angeschlossen. Die erste Webseite wurde 1990 am Europäischen Kernforschungszentrum CERN im „World Wide Web” veröffentlicht. Dann ging es Schlag auf Schlag mit der weltweiten Vernetzung der Systeme. In Deutschland machte 1994 der erste Internet Provider den Datenaustausch für private und geschäftliche Zwecke möglich. 1994 erschienen auch bereits die ersten Suchmaschinen mit Lycos und Yahoo, gefolgt von Google 1997. Soziale Netzwerke wie Facebook sorgten ab 2004 für einen weiteren Schub an digitaler Vernetzung. Das Netz hat unsere Welt und unseren Alltag, in beinahe jeder Lebenslage, kontinuierlich und radikal verändert [20].

Der Erfolg des Internets ist auch ganz eng mit dem sehr steilen Aufstieg der nachstehenden drei Internetunternehmen verbunden.

Google: Aus dem ursprünglichen Suchmaschinengeschäft ist der weltweite Marktführer im Bereich digitaler Werbung hervorgegangen. Neben YouTube, Android Smartphones und vielen anderen Aktivitäten ist man ein führender Akteur im Bereich der KI. Die Holdinggesellschaft firmiert unter dem Namen Alphabet. Die Firma wird als größter weltweit tätiger Datensammler (Kritiker gebrauchen den Begriff Datenkrake) angesehen. In der Branche geht man fest davon aus, dass die Geheimdienste der USA und China neidisch auf den gigantischen Datenbestand von Google sind.

Amazon: Amazon ist ein riesiges E-Commerce-Unternehmen, das in der Öffentlichkeit hauptsächlich für den Online-Handel bekannt ist. Amazon besitzt eine Vielzahl von Tochterunternehmen, die neben vielen anderen Aktivitäten wie Versand- und Logistikservices oder Video Streaming, auch Hörbücher (Audible) oder Smart-Home Lösungen (Ring) anbieten. Es ist eines der größten und bekanntesten Unternehmen weltweit. AWS ist die Cloud-Computing- und KI-Sparte von Amazon. AWS ist der führende Anbieter im Cloud-Markt.

Meta (Facebook): Mit seinen Produkten Facebook (soziales Netzwerk), WhatsApp (Messaging-Dienst) und Instagram (Plattform zum Teilen von Fotos und Videos) erreicht die Firma Milliarden von Menschen. Das Ausgangsunternehmen Facebook gründete Marc Zuckerberg 2004.

Im Rahmen dieser Thematik fällt öfters der Begriff GAFAM, welcher, so wird berichtet, von der EU in die Welt gesetzt wurde. GAFAM ist ein Kürzel, das sich aus den Anfangsbuchstaben von fünf der einflussreichsten Unternehmen der Welt zusammensetzt:

GAFAM (G für Google, A für Apple, F für Facebook und A für Amazon, M für Microsoft)

Das Akronym wird immer in Verbindung mit einem kritischen Blick auf die enorme Vorherrschaft dieser fünf amerikanischen Digitalkonzerne im Internet gebraucht. Der Hype um Künstliche Intelligenz hat von Anfang an, auch mit dem dortigen Engagement der großen Internetkonzerne zu tun. Die „Big Five” sind auch hier aktuell die wichtigsten Akteure.

2000 Big Data

Big Data (deutsch Massendaten) ist keine Technologie, sondern ein Begriff für ein Phänomen, das sich in den frühen 2000er Jahren verbreitete. Mit dem enormen Zuwachs an Datenquellen, wie sozialen Medien, Sensoren und mobilen Geräten, wuchs die weltweite Datenmenge in diesem Zeitraum immer schneller und die Bedeutung und der finanzielle Nutzen von großen Datensammlungen wurden immer mehr erkannt. Big Data hatte eine transformierende Wirkung in der digitalen Welt. IT wurde bis dahin oft als unterstützende Funktion, ähnlich wie beispielsweise eine Telefonanlage, angesehen, die hauptsächlich für den reibungslosen Betrieb der Infrastruktur verantwortlich war. Mit dem Aufkommen von Big Data wurde die IT in vielen Firmen auch von strategischem Nutzen. Rasch waren Daten ein Produktionsfaktor und halfen bei der Generierung neuer Geschäftsmodelle. Das Sammeln und Auswerten großer Datenmengen wurde nun als entscheidender Faktor angesehen. Die großen Tech-Konzerne begannen in den frühen 2010er Jahren mit der strategischen Ausrichtung auf Big Data und KI. Daten wurden zur neuen Währung und die KI war die dazu passende Schlüsseltechnologie. Der deutsche Begriff „Datenzentrum” kommt seither wahrscheinlich der Bedeutung des Wortes „Rechenzentrum” näher [3].

2006 Cloud-Computing

John McCarthy, amerikanischer Informatiker, prognostizierte bereits 1961, dass Rechenzentren irgendwann öffentliche „Versorgungseinrichtungen” sein werden:

„Wenn Computer der Art, wie ich sie befürworte, sich in der Zukunft durchsetzen, wird Rechenkraft eines Tages vielleicht als Versorgungsdienstleistung organisiert sein, so wie es heute das Telefonnetz ist. Die Computerversorger könnten die Grundlage einer neuen, wichtigen Industrie sein.”[4]

Zu Beginn der 2000er Jahre nahm der Siegeszug von Cloud-Computing seinen Lauf und die Vision von Rechnerleistung als Infrastruktur wurde Realität. Cloud-Computing bedeutet die Bereitstellung von Daten oder Programmen über das Internet (die „Cloud”). Cloud-Anbieter unterhalten eigene Rechenzentren mit unzähligen virtuellen Rechnern und virtuellen Speichern. Auf dieser Basis können ganz verschiedene Umgebungen zur Verfügung gestellt werden. Kunden können diese virtuellen Umgebungen mieten und über das Internet darauf zugreifen. Anstatt eigener physischer Server oder Infrastruktur zu kaufen und zu warten, können Unternehmen Rechenleistung, Speicherplatz und komplette Anwendungen als Service über das Internet nutzen. Die Kunden greifen über Webbrowser darauf zu und mieten, managen und betreiben so ihre IT Infrastruktur. Ein eigenes Rechenzentrum (engl. Datacenter) ist nicht mehr notwendig.

Man muss inzwischen eine Cloud-Infrastruktur auf einer Ebene zu den anderen Elementen unserer technischen Infrastruktur wie Straßen, Gleise, Brücken, Gas-, Strom- und Wasserversorgung zählen. In vielen Bereichen ist sie auch als „kritisch” einzustufen, da sie von wesentlicher Bedeutung für die Aufrechterhaltung wichtiger elementarer gesellschaftlicher Funktionen sind. Ein Ausfall oder eine Störung dieser Infrastruktur kann erhebliche gesellschaftliche und wirtschaftliche Folgen haben. Auch weil KI-Infrastrukturen in der Regel cloudbasiert sind, gilt die Technologie heute als der Wachstumsmarkt. Marktführer sind auch hier die großen amerikanischen Tech-Giganten.

2007 Das Smartphone

Steve Jobs Gründer, und Chef von Apple stellte am 29. Juni 2007 sein Smartphone namens iPhone vor. Das iPhone stellte eine kleine Revolution dar, da es drei Geräte in einem vereinte: Man konnte damit nicht nur telefonieren, sondern war auch mobil im Internet unterwegs mit Email und Browser Funktionen. Darüber hinaus war es auch ein tragbarer mp3-Player mit Berührbildschirm. Das iPhone wurde schnell zum Ver kaufsschlager und im Jahre 2008 folgte Googles Smartphone mit dem Betriebssystem Android, was den Hype noch einmal verstärkt hat. Das Internet war damit mobil geworden.

In Deutschland besitzt heute mehr als 90 % der Bevölkerung ein Smartphone. Das Smartphone ist ein fester Bestandteil unseres Alltags geworden. Die durchschnittliche Nutzungszeit beläuft sich in Deutschland inzwischen auf enorme rund 150 Minuten pro Tag und User [5].

Männer wie Bill Gates (Microsoft), Steve Jobs (Apple) und Mark Zuckerberg (Facebook) waren maßgeblich am Mythos „Silicon Valley” beteiligt. Das Silicon Valley ist eine Region in Nordkalifornien, welches weltweit als Zentrum der Computerindustrie bekannt ist. Es erstreckt sich ungefähr über den Süden der San Francisco Bay Area. Die großen US-Tech-Konzerne haben hier ihren Hauptsitz. Es existiert darüber hinaus auch eine florierende Szene von innovativen Start-ups, die von Risikokapitalgebern unterstützt werden. Im Mythos wird die romantisierte Vorstellung von Einzelpersonen, die in Garagen revolutionäre Unternehmen gründen, oft verklärt. Zum Mythos gehört neben der Verherrlichung von Tech-Gründern, auch der Glaube, dass technologische Innovation praktisch jedes gesellschaftliche Problem lösen kann. Es gibt passenderweise auch einige entsprechende klischeehafte Hollywoodverfilmungen dazu (The Social Network, The Circle, Steve Jobs, Die Silicon Valley Story). Über allem steht dabei immer die Erwartung auf „the next big thing ” auf die nächste große Innovation oder den nächsten bedeutenden Trend. Diese idealisierte Darstellung hat auch dazu beigetragen, dass viele Menschen digitalen Fortschritt wie die KI, unkritisch als positiv betrachten und den Tech-Konzernen ein hohes Maß an Vertrauen entgegenbringen.

Abb. 3.2 „Meilensteine der Informationstechnologie”

Der Erfolgsfaktor Rechenleistung

Die Rechnerleistung und die Entwicklung der IT sind eng miteinander verbunden und beeinflussten sich immer gegenseitig. Fortschritte in der Rechnerleistung sorgten stets für qualitative Sprünge in den Möglichkeiten der IT, zuletzt im Bereich der KI.

Der Z3 von 1941 arbeitete noch mit Relais. Darauf folgten Rechner mit Glasvakuumröhren. Die Nachfolgesysteme arbeiteten schon mit Transistoren auf Germaniumbasis. In den 60er Jahren löste der Transistor aus Silizium diesen ab. Das elektronische Halbleiter-Bauelement Transistor kann als einer der größten technologischen Umbrüche in der Menschheitsgeschichte angesehen werden.

Die Geschwindigkeit der Schaltvorgänge ist maßgeblich für die Rechenleistung der darauf basierten Rechner. Der Abstand der einzelnen Transistoren und damit die Leitungsgeschwindigkeiten sind ein weiterer entscheidender Faktor dabei. Kürzere Leiterbahnen sparen Strom und rechnen schneller. Der darauf abgeleitete Drang zur Miniaturisierung begann und mündete in der Entwicklung einer Recheneinheit, die so klein war, dass sie in einem kleinen integrierten Schaltkreis untergebracht werden konnte, dem sogenannten Mikroprozessor. Die zentrale Recheneinheit (CPU) ist das Gehirn des Computers, also quasi das Kernstück eines jeden Rechners.

Im Jahre 1993 bestand der legendäre Intel Pentium schon aus 3.100.000 Transistoren und leistete etwa 60 MFLOPs (Millionen Gleitkommaoperationen pro Sekunde). Apples aktueller M2 Ultra Prozessor bringt dagegen wieder eine enorme Leistungssteigerung. Er erreicht etwa 27,2 TFLOPS (TeraFLOPS) und besteht aus 134.000.000.000 Transistoren (1 Tera=1 Million Millionen) [6].

Diese rasante Entwicklung der IT basierte immer auf der rasanten Steigerung der Rechenleistungen. Immer höhere Rechenleistungen standen im Laufe der Jahre zur Verfügung und parallel dazu wurden diese auch immer billiger. Die Steigerung war und ist dabei exponentiell.

Wenn man dies in die Welt der Autos übertragen würde, dann ergäbe dies bei einem VW Golf folgendes Bild: Das Golf Grundmodell kostete 1981 zirka 8000 DM. Die Höchstgeschwindigkeit des Golf betrug etwa 150 km/h. Wäre die Leistungssteigerung beim Auto analog zur IT verlaufen, so hätte der aktuelle Golf heute eine Höchstgeschwindigkeit von über 5 Milliarden km/h. Dieses hypothetische Auto wäre etwa 4 Millionen Mal schneller als der Schall oder, anders ausgedrückt, bräuchte etwa 0,029 Sekunden für eine Erdumrundung. Das Auto wäre zudem für einen Preis von einem Cent zu haben.