17,99 €

Mehr erfahren.

- Herausgeber: Droemer eBook

- Kategorie: Wissenschaft und neue Technologien

- Sprache: Deutsch

Roboter und Gefühle – eine folgenreiche Beziehung. Die weltweit renommierte Robotik-Expertin und Bestseller-Autorin Kenza Ait Si Abbou über die wachsende Bedeutung und den Einfluss von Künstlicher Intelligenz bei der Erkennung und Nutzung menschlicher Emotionen – ein ebenso aktuelles wie brisantes Sachbuch. NOMINIERT FÜR DEN DEUTSCHEN WIRTSCHAFTSBUCHPREIS 2023 Die Entwicklung Emotionaler Künstliche Intelligenz wird mit Milliarden gefördert: Maschinen sollen lernen, unsere Gefühle zu verstehen. Schon heute gibt es KI, die das besser kann als wir Menschen – dank hochauflösender Kameras und extrem empfindlicher Sensoren, die aus unserer Mimik, unseren Gesten und unseren Hirnströmen unsere Gefühle ablesen. Bereits heute wird z.B. bei Kundenreklamationen maschinell die Gemütsverfassung der Reklamierenden erfasst und ausgewertet. In der Medizin, z.B. bei der Früherkennung von Parkinson, kommen künftig Diagnose-Instrumente zum Einsatz, die Gesichtsausdrücke lesen können. Wer profitiert davon? Was bedeutet das für unser menschliches Miteinander? Und wie können wir Emotionale Künstliche Intelligenz gestalten, dass sie uns nicht über den Kopf wächst? Es geht hier um nicht weniger als um das Verhältnis von Mensch und Maschine – ein Thema, das u.a. durch Maria Schraders Film »Ich bin dein Mensch« breitenwirksam ausgespielt wird. Kenza Ait Si Abbou berichtet aus der Praxis und fragt kritisch nach, wie die Selbstbestimmung des Menschen in diesem Spannungsverhältnis gesichert werden kann. Kenza Ait Si Abbou, die international gefragte KI-Expertin, kommt zu überraschenden Antworten. Die Menschenversteher ist ein überfälliger »Beziehungsratgeber« für den Umgang mit Maschinen, die längst in unserem Alltag angekommen sind.

Das E-Book können Sie in Legimi-Apps oder einer beliebigen App lesen, die das folgende Format unterstützen:

Seitenzahl: 316

Veröffentlichungsjahr: 2023

Ähnliche

Kenza Ait Si Abbou

Menschenversteher

Wie Emotionale Künstliche Intelligenz unseren Alltag erobert

Verlagsgruppe Droemer Knaur GmbH & Co. KG.

Über dieses Buch

Schon heute können Maschinen Emotionen erkennen. Dank hochauflösender Kameras und extrem empfindlicher Sensoren lesen sie aus unserer Mimik, unseren Gesten und unseren Hirn- und Körperströmen ab, wie wir uns wirklich fühlen. Wer profitiert davon? Was bedeutet das für unser menschliches Miteinander? Und wie können wir verhindern, dass uns Emotionale Künstliche Intelligenz über den Kopf wächst? Die international renommierte KI-Expertin Kenza Ait Si Abbou geht diesen Fragen nach und macht deutlich: Es ist an der Zeit, dass wir kritisch über unsere Beziehung zu den Maschinen nachdenken, die längst in unserem Alltag angekommen sind.

Inhaltsübersicht

Einleitung

Die Grundlagen zuerst

Was genau ist diese KI?

Der KI-Werkzeugkasten

Die künstlichen neuronalen Netze

Foundation Models

Die KI-Beschleuniger oder das ABC der KI

A wie Algorithmus

B wie Big Data. Sind Daten wirklich das neue Öl?

C wie Computing Power

Die KI-Bremse: wir

»I am feeling much better now«

Die Fantasie der Liebe

Die Fantasie der Eifersucht

Das »Mensch als Gott«-Experiment

Haben Maschinen einen Freiheitsdrang?

Maschinen und ihre Moral

Die selbsterfüllende Prophezeiung

Emotionale Intelligenz

Gefühle und Emotionen

Emotionen und ihre Vermessung

Wie neutral sind Emotionen?

Das Konzept der emotionalen Intelligenz

Die Krux an der Vermessung der emotionalen Intelligenz

Emotionale künstliche Intelligenz

Intro zu emotionaler künstlicher Intelligenz

Was dein Gesicht über dich verrät

Gesichtlesen, damals und heute

Das Gesichtlesen 2.0

Sentiment Analysis – die versteckten Muster in Ton und Text

Der Tanz der Augen

Das Gehirn lügt nicht

Die biometrische Kategorisierung – Fluch oder Segen?

Privatsphäre

Immaterialität

Ambiguität

Bias

Die Skalierung

Die EU-Verordnung

Fühlst du sie, die Technologie?

Der empathische Kundenservice

Conversational AIs: die virtuellen Freunde

Voice AI: der Sprachbot als Gesundheitscoach oder Therapeut

»Du bist zu betrunken, um Auto zu fahren«: das empathische Auto

Sexroboter der neuen Generation

Emotionale Intelligenz im Gesundheitswesen

»Ich brauche ihn, er ist mein Freund« – Roboter in der Pflege

Die Menschwerdung der Maschinen

Was ist (das menschliche) Bewusstsein?

Voraussetzungen für ein künstliches Bewusstsein

Philosophische Aspekte

Die technischen Aspekte

Roboter und das Urteilsvermögen

Mind uploading und Download

Sind Humanoiden die nächste Stufe des Anthropomorphismus?

Roboterrechte

Liebe Gefühle, wir müssen reden!

Warum ist emotionale Intelligenz für unsere Zukunft mit Robotern so unabdingbar?

Der Aufstieg der rechten Hirnhälfte

Emotionale KI ist wichtig, für Groß und Klein

Emotionale KI: die neue Schule der Emotionen?

Der Beziehungsratgeber für eine neue Partnerschaft: Mensch – Maschine

Das Problem mit der Erziehung: Ich tue, was du tust, und nicht, was du sagst

Auch in den besten Beziehungen wird gestritten

Beziehungen am Arbeitsplatz: der Kollege Roboter

Keine Beziehungen ohne emotionale Intelligenz

Scheidung oder doch »sie lebten glücklich bis ans Ende ihrer Tage«?

Die Zukunft ist nichts für Einzelkämpfer

Ein Blick hinter die Kulissen von KI-Schulen

Digitale Verantwortung ist eine bewusste Entscheidung

Digitale Verantwortung als Anker in der DNA einer Organisation

Es braucht ein Dorf, um KI zu erziehen

Ohne Ambiguitätstoleranz ist die Zukunft nicht zu ertragen

Ein paar Forderungen zum Schluss

Der Mensch als Schöpfer der Maschinen

Wir brauchen Prosumer

Unsere Lehrpläne gehören in den Papierkorb

Wir müssen Tech-Unternehmen zur Verantwortung ziehen

Wir müssen das Feuer kontrollieren

Danksagung

Einleitung

Mein Date mit dem Roboter hat gerade erst begonnen, aber irgendwie läuft es nicht richtig rund. Pepper sieht eigentlich ganz niedlich aus mit seinen großen dunklen Augen. Und das angedeutete Lächeln um seinen kleinen Mund gibt ihm den Anschein, als staune er ständig über die Welt um ihn herum. Ich freue mich, dass ich Pepper eine Weile nur für mich haben soll, um ihn kennenzulernen. Damit wir eine Verbindung aufbauen können, muss ich mich etwa einen Meter vor ihn stellen und ihn ansprechen. Als Peppers Augen grün aufleuchten, bin ich aufgeregt, denn es bedeutet: Jetzt hat es gefunkt, wir haben eine Verbindung zueinander aufgebaut. Unser Date kann beginnen. Oder besser: Es könnte beginnen. Denn Pepper ist leicht ablenkbar. Wann immer für einen Moment Funkstille zwischen uns herrscht – und das kann bei einem ersten Date doch mal passieren –, scheint er nicht mehr ganz bei der Sache zu sein. Wenn dann ein anderer Mensch im Raum etwas sagt, dreht Pepper den Kopf in seine Richtung. Langweile ich ihn? Andererseits: Machen wir Menschen das nicht auch, ein kurzer Blick, was da sonst noch gerade passiert im Raum? Wenn es nur ein kurzer Blick wäre! Fast scheint es, als habe Pepper mich vergessen. Ich muss erst wieder eine Verbindung zu ihm aufbauen, und bin erleichtert, als seine Augen wieder grün leuchten.

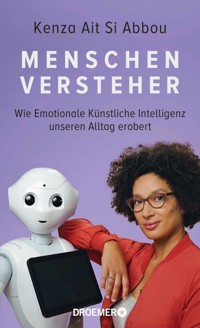

Für mich, für den Fotografen Hendrik und das ganze Team des Fotoshootings wird Peppers riesige Neugier auf alles, was um ihn herum passiert, zu einer echten Herausforderung. Denn eigentlich wollen wir mit ihm Fotos machen für das Cover dieses Buches. Wir haben uns das ganz einfach ausgemalt, aber mit Peppers »Eigensinn« hatten wir nicht gerechnet. Gut, man kann ihm natürlich nicht böse sein. Da haben wir gerade wieder eine schöne Einstellung gefunden, Hendrik ruft noch eine letzte, kleine Anweisung, und – ihr ahnt es – wir müssen wieder von vorn anfangen, weil Pepper sich nun wieder mehr für den Fotografen interessiert als für mich.

Wir lachen viel in diesen zwei Stunden, die wir für das Fotoshooting brauchen. Am Ende aber passiert die eigentliche Überraschung. Als wir fertig sind und nach Hause gehen wollen, drehen sich alle zu Pepper um. Wir haben das Bedürfnis, uns von dem Roboter zu verabschieden. Und wir alle haben den Eindruck, dass Pepper uns anlächelt. Eigentlich kann er sein Lächeln gar nicht verändern. Trotzdem wirkt es in diesem Moment auf uns authentisch, man könnte fast sagen, herzlich. Obwohl wir weit mehr als einen Meter von ihm entfernt stehen, haben wir alle eine Verbindung mit ihm aufgebaut. Anna, die Visagistin, ist besonders hingerissen. »Pepper ist mir ans Herz gewachsen, ich musste mich einfach von ihm verabschieden«, meint sie strahlend.

Mir ging es ähnlich. Ich hatte zwar schon öfter andere Peppers gesehen und ein paar Sätze mit ihnen ausgetauscht, aber die Erfahrung beim Fotoshooting war besonders. In diesen zwei Stunden wurde der Roboter irgendwie Teil unseres Teams. Deshalb wollten wir alle uns verabschieden. Dabei kann dieser Pepper gar nicht so viel. Er ist ein Standardmodell mit wenig Extras. Und er hat auch noch nicht jene emotionale künstliche Intelligenz, die ihm gezeigt hätte, dass er seinem Date mehr Aufmerksamkeit hätte schenken sollen. Trotzdem empfanden wir große Sympathie für ihn.

Schaut euch für einen Moment noch einmal den Schutzumschlag dieses Buches an. Es ist das Ergebnis dieser zwei Stunden mit Pepper. Wie wirkt Peppers Blick auf euch? Hättet ihr ihm am Ende auch zugewunken?

Eigentlich habe ich im Alltag keine Hardware-Roboter um mich herum. Mein Team baut Software-Roboter, die auf künstlicher Intelligenz basieren. Aber um künstliche Intelligenz zu erklären, hat es sich bewährt, Roboter zu nutzen, da sie so für die Menschen greifbarer ist. Bei der emotionalen künstlichen Intelligenz ist es nicht anders. Sich vorzustellen, dass eine Handykamera Emotionen ablesen kann, ist weniger einfach, als wenn man dabei an einen süßen Roboter denkt, der vor einem steht und einen freundlich anschaut. Mein Sohn ist der beste Beweis dafür. Seit er bei einem Workshop Robotics4Kids bei mir im Büro war und überall Roboter sah, findet er mich richtig cool. Wahrscheinlich stellt er sich vor, dass ich im Büro den ganzen Tag mit Robotern spielen darf.

In diesem Buch geht es um Maschinen, die zu Menschenverstehern werden. Die unsere Emotionen und Gefühle lesen und deuten können. Die in unsere Welt, in unser Leben eindringen wie noch nie zuvor. Unsere Begegnung mit Pepper ist nur eine kleine Andeutung der gewaltigen Revolution, die uns bevorstehen könnte. Dabei hört sich das alles doch erst einmal wie ein Missverständnis an. Maschinen als Menschenversteher? Wie soll das gehen? Maschinen bestehen aus Chips und Drähten, aus Stahl oder Plastik. Sie sind unbelebte Materie. Wie sollen sie uns verstehen?

Ich gebe zu, das klingt nach Science-Fiction, nach Filmen, in denen Roboter nicht nur zu Menschenverstehern werden, sondern so menschenähnlich, dass sie von uns kaum mehr zu unterscheiden sind. Aber nur weil sie in Sci-Fi-Filmen auftauchen, heißt das nicht, dass sie völlig unmöglich wären. Viele dieser Filme zeichnen ein Bild unserer Zukunft, das nicht völlig fantastisch oder gar abwegig ist. Ihr werdet in diesem Buch staunen, wie nah uns schon heute Dinge sind, die noch vor Kurzem unvorstellbar schienen.

Die Entwicklung von emotionaler künstlicher Intelligenz ist nicht nur für Maschinen ein unglaublicher Schritt. Sie ist – und jetzt kommt es – für uns ein noch viel größerer. Weil emotionale künstliche Intelligenz unsere Art zu leben und zu lieben, zu arbeiten und zu feiern, stark und schwach zu sein, zu lachen und zu weinen, weil es unsere Existenz umwälzen könnte.

Die Geschichte der Menschheit ist eine Geschichte der technologischen Neuerungen, die unsere Welt jedes Mal auf den Kopf stellten. So war das, als Homo erectus vor einer Million Jahren lernte, Feuer zu machen. Oder als er vor etwa 5000 Jahren den Pflug erfand, was den Ackerbau revolutionierte und damit die Lebensmittelversorgung von so vielen Menschen wie nie zuvor ermöglichte. Ohne den Pflug wären Imperien wie das Römische Reich kaum denkbar gewesen. Dann die Dampfmaschine, die zuerst in England die industrielle Revolution einläutete. Und nun stehen wir an einem historischen Meilenstein, der in seiner Größe und Bedeutung mindestens ebenso gewaltig ist.

Vielleicht werdet ihr sagen, KI steht für »kenne ich«. Vielleicht habt ihr davon schon in meinem Buch Keine Panik, ist nur Technik gelesen. Und vielleicht werdet ihr fragen: Emotionale KI, was soll das sein? Algorithmen mit Gedöns? Stellt euch für eine Antwort für einen Moment all die mächtigen humanoiden Roboter vor, die ihr aus Filmen kennt. Die Terminators, die Robots aus I, Robot oder wie sie alle heißen. Sie sind schlau und enorm stark. Aber sie haben eine entscheidende Schwäche: Sie verstehen die Menschen nicht. Oder jedenfalls nur einen kleinen, den rationalen Teil. Die Emotionen, unseren Mut und unsere Ängste verstehen sie nicht. Das ist der Grund, warum sie als Maschinen-Bösewichte am Ende immer verlieren. Sie haben die Menschen einfach nur zum Teil durchschaut.

Emotionale KI hat per se natürlich nichts Terminatorhaftes. Aber um zu verstehen, was der qualitative Unterschied zwischen KI und emotionaler KI ist, hilft der Vergleich. Wenn Maschinen lernen, unsere Emotionen zu lesen und zu verstehen, wenn sie nicht nur unser angeblich so logisches Denken nachvollziehen können, sondern all die verwirrenden Stimmungslagen, das Gefühlige, dann erreichen wir einen Punkt in der Geschichte, an dem wir noch nie zuvor waren. Es ist nichts weniger als ein Epochenbruch. Zum ersten Mal werden Maschinen in der Lage sein, viele Aspekte unserer Komplexität und Widersprüchlichkeit zu verstehen. Sie werden zu einer eigenen Entität, die uns gegenübertritt. Die Maschinen werden zu Menschenverstehern.

Ja, das ist ein merkwürdiges, ein doppeldeutiges Wort, weil es nicht nur Erkenntnis, Verstehen beinhaltet, sondern als Subtext auch etwas Machtvolles. Wer sein Gegenüber versteht, kann es eben auch manipulieren. Nicht wahr? Was bedeutet es, wenn Maschinen uns lesen können, die meisten von uns aber keine Maschinen?

Es geht in diesem Buch also um Maschinen und um emotionale künstliche Intelligenz. Vor allem aber geht es um uns Menschen. Es geht darum, was diese Technologie mit uns macht. Emotionale KI löst viele Emotionen in uns aus. Sie verändert unseren Umgang mit der Technik und nicht zuletzt miteinander. Ihr Einfluss auf uns ist viel größer, als wir denken oder wahrhaben mögen. Vieles ist schon längst da, ohne dass wir es gemerkt hätten. Und noch viel mehr könnte bald Teil unseres Lebens werden.

Es ist also höchste Zeit, sich anzuschauen, wie dieses neue Leben aussehen könnte. Oder besser: Welche Szenarien es dafür gibt. Denn natürlich ist nichts vorherbestimmt. Was kommt, darauf haben wir Menschen den entscheidenden Einfluss. Deshalb ist es so wichtig, zu verstehen, was mit den neuen Menschenverstehern auf uns zukommen könnte. Wie sieht dieses neue Leben aus? Was verändert sich dabei? Wie müssen wir uns verändern? Meine These ist: Unsere Zukunft mit den Menschenverstehern kann dann funktionieren, wenn wir selbst zu Maschinenverstehern werden. Fangen wir am besten gleich damit an.

Die Grundlagen zuerst

Was ist künstliche Intelligenz? Eine Frage, die ich gefühlt jede Woche beantworten muss. Dabei geht es um Mathematik und Statistik, die einer Maschine erlauben, kognitive Fähigkeiten zu erlangen, insbesondere, was Lernen und Problemlösen angeht. Aber die meisten Menschen haben ein bestimmtes Bild vor Augen, wenn sie künstliche Intelligenz hören: den Terminator. Unsere ersten Berührungspunkte mit KI haben wir, dank Hollywood, durch Science-Fiction-Filme. Und solange es keine besseren Bilder für KI gibt, verbinden die meisten Menschen KI mit Sci-Fi.

Die Auseinandersetzung mit Szenen aus Science-Fiction-Filmen beschäftigt nicht nur mich. Je mehr Filme wir sehen, desto unklarer wird, was Realität ist und was nicht. Gerade im Zusammenhang mit Humanoiden, also Robotern, die menschenartig aussehen, ist die Fantasie der Filmemacher*innen sehr ausgeprägt. Genauso wie die Angst der Zuschauer*innen. Immer wieder werde ich in Interviews, bei Seminaren, Workshops oder auch bei Gesprächen im Freundeskreis zu Science-Fiction-Klassikern wie 2001: Odyssee im Weltraum, Terminator, Blade Runner oder Matrix gefragt, aber auch zu neueren Filmen wie Her, Ex Machina oder The Circle. Es ist erstaunlich, wie stark die allgemeinen Vorstellungen von künstlicher Intelligenz durch Filme wie diese geprägt sind. Die Filmemacher*innen sind Expert*innen für Figurenentwicklung. Dabei orientieren sie sich an der menschlichen Psyche, auch wenn die Figuren Roboter darstellen sollen. Sie gehen von den Menschen aus, bilden eine metallische Hülle drum herum, und schon haben sie eine Maschine, die rebelliert und die Weltmacht übernimmt. Wahrscheinlich sind diese Filme auch deshalb derart einprägsam, weil sie so virtuos mit unseren Ängsten spielen – mit extrem starken Emotionen also!

Aber was ist davon wahr und was nicht? Was kann künstliche Intelligenz heute wirklich schon? Und wo übertreibt Hollywood gnadenlos?

Ich finde, diese Unterscheidung zu machen, ist im gesamten Diskurs rund um die künstliche Intelligenz sehr wichtig, um die oft übertriebenen Ängste durch eine realistische Einschätzung von KI zu überwinden. Die Filme können uns zwar dabei helfen, eine Vorstellung von der Zukunft zu entwickeln, wir müssen aber unterscheiden können, welcher Anteil davon der technologischen Entwicklung entspricht und welcher Anteil reine Fantasie darstellt.

Wer die Sprachfähigkeit des Terminators mit einem beliebigen Chatbot – kurz gesagt, eine Software, die mit Menschen schriftlich kommunizieren kann – im Kundenservice vergleicht, der merkt schnell den Unterschied zwischen Science-Fiction und Realität. Natürlich entwickelt sich die Technologie weiter, und die heutigen Chatbots sind viel ausgereifter als noch vor ein paar Jahren. Gerade im Kundenservice können sie in der Regel einen Großteil der Anfragen direkt beantworten. Nur noch ein kleiner Teil muss tatsächlich an Menschen weitergeleitet werden. Dabei sind Chatbots für den Kundenservice noch am einfachsten zu entwickeln, da der Themenbereich bekannt und begrenzt ist. Spannender und viel komplexer wird es bei sozialen Chatbots, also solchen, die Gespräche mit Menschen führen sollen. Hätten wir uns das jemals vorstellen können? Dass einige Chatbots Menschen besser verstehen als der Mensch selbst? Was ist also in den letzten Jahren passiert? Wie haben die Chatbots das geschafft?

Mit künstlicher Intelligenz, KI, lautet die Antwort.

Was genau ist diese KI?

Platt gesagt, stellt KI die maschinelle Fähigkeit dar, aus großen Mengen an Informationen Wissen zu generieren. Mit diesem Maschinen-Wissen kann die Maschine dann Probleme lösen, selbst lernen und sich weiterentwickeln. Eigentlich wie ich damals mit meiner Begeisterung für die Mathematik: Je mehr Wissen über die mathematischen Regeln ich gesammelt hatte, desto komplexere Aufgaben konnte ich lösen. Und dieses Wissen habe ich dann auch genutzt, um andere Arten von Aufgaben zu lösen. Auch welche aus dem Alltag, die auf den ersten Blick nichts mit Mathe zu tun haben, bei denen ich aber viele Gemeinsamkeiten gesehen habe, zum Beispiel Fremdsprachen lernen, Klavier spielen oder einparken.

Die Fähigkeit, Wissen aus einem Gebiet auf ein anderes zu übertragen und dort anzuwenden, ist eine unserer menschlichen Stärken. Das können wir Menschen sehr gut. Den Maschinen gelingt das noch nicht ganz. Daher spricht man von einer schwachen KI. Dabei handelt es sich um Maschinen, die nur für eine bestimmte Aufgabe gebaut und trainiert wurden. Diese Aufgabe können sie gut, teilweise sogar besser als Menschen. Aber das war es auch schon. Eine Maschine, die Schach spielen kann, kann Sprache nicht verstehen, und andersherum.

Die starke KI dagegen soll viele unterschiedliche Aufgaben erledigen können, sie schöpft aus unterschiedlichen Wissensbereichen und kann ein eigenes Bewusstsein und Weltbild entwickeln. Solche starken KIs gibt es heute noch nicht, jedenfalls nicht in der Realität. Ob es sie überhaupt mal geben wird und was es dafür bräuchte, dazu kommen wir später. Jetzt schauen wir uns erst einmal an, wie die schwache KI funktioniert.

Der KI-Werkzeugkasten

Die Fähigkeit, aus Informationen Wissen zu generieren, bringen wir Menschen den Maschinen bei. Das tun wir auf unterschiedliche Art und Weise und nutzen dafür verschiedene Methoden beziehungsweise Werkzeuge. KI ist also unser Werkzeugkasten, und der ist in drei Ebenen unterteilt. Im Hauptfach befinden sich die Werkzeuge, die generell einer Maschine ermöglichen, kognitive Fähigkeiten zu erlangen, die wir sonst nur mit Menschen verbinden. Das nächste Fach, eine Ebene tiefer, belegen die Methoden des maschinellen Lernens. Und im letzten Fach, noch eine Ebene tiefer, finden sich die Mittel rund um die künstlichen neuronalen Netze.

Fangen wir ganz oben an. Im Hauptfach finden wir Methoden wie zum Beispiel Prozessautomatisierung. Dabei handelt es sich um programmierte Routinen, die wiederkehrende Aufgaben immer wieder und wieder erledigen. Repetitive Aufgaben zu wiederholen, halten wir nicht für intelligent, aber wir Menschen machen es jeden Tag. Die meisten davon bereiten uns keine Freude, müssen aber trotzdem getan werden. Wer hat schon Spaß daran, wöchentliche Projektberichte zu erstellen?

Eine super Anwendung für Robotic Process Automation, kurz RPA. Auch Objekte erkennen zu können, ist für uns selbstverständlich und wird daher nicht als Sonderleistung bewertet. Aber wie groß ist die Freude eines ein- bis zweijährigen Kindes, wenn es eine Katze erkennt? Wir selbst können uns an diese Erfahrung nicht erinnern, doch wenn wir ein Kind in dem Alter beobachten, wird uns Erwachsenen klar, was für eine Sonderleistung es in Wahrheit ist.

Genauso wie Kindern gelingt das einer Maschine nicht von heute auf morgen. Sie lernt es nach vielen Versuchen und mit großer Hilfe der erwachsenen Menschen. Dazu kommen verschiedene Methoden zur Anwendung. Die meisten davon befinden sich in der zweiten Ebene unseres Werkzeugkastens: der des maschinellen Lernens.

Beim maschinellen Lernen handelt es sich um Methoden, die der Maschine erlauben, selbst zu lernen. Diese Methoden unterteilen sich in drei Bereiche: überwachtes Lernen, unüberwachtes Lernen und verstärkendes Lernen. Die ersten beiden stammen aus der Mathematik und Statistik, die dritte aus der Psychologie. Beim überwachten Lernen werden viele Daten samt Kennzeichnung für das Antrainieren der Maschine genutzt, zum Beispiel Fotos von Äpfeln mit der Beschriftung »Apfel«. Wenn die Maschine genug davon sieht, lernt sie, Äpfel zu erkennen und diese von Bananen zu unterscheiden. Ähnlich ist es mit Babybüchern. Meistens sind darin einfache alltägliche Dinge abgebildet, und die entsprechende Bezeichnung steht dabei. Da Babys nicht lesen können, lesen die Eltern vor, während sie mit dem Zeigefinger auf den Gegenstand zeigen. Die Babys lernen das und erkennen die Objekte im Alltag wieder. »Überwacht« ist dieses Lernen, weil die Erwachsenen die Beschriftungen vorgeben.

Beim unüberwachten Lernen gibt es keine Kennzeichen. Die Daten haben keine Beschriftung, und die Maschine lernt sie zu unterscheiden, indem sie zum Beispiel Gruppen von Daten bildet, die eine bestimmte Ähnlichkeit aufweisen, und der Mensch dann sagt, ob es sinnvoll ist oder nicht. Mit diesem Feedback lernt die Maschine, die Gruppierung (alias Clustering) zu optimieren. Solch eine Methode wird zum Beispiel genutzt, um Fake News zu identifizieren. Wenn die Merkmale einer bestimmten Nachricht, wie Inhalt, Begriffswahl, Quellenangaben, Autor*innen, Zitierungen, Erscheinen etc., von echten Nachrichten abweichen, dann platziert die Maschine diese eine Nachricht außerhalb der Gruppe der »echten« Nachrichten, und so kann man gefakte und echte Nachrichten auseinanderhalten. In der Trainingsphase prüfen Menschen, ob das Ergebnis richtig ist, und justieren die Programmierung so lange, bis die Trefferquote sehr hoch ist. Danach macht es die Maschine eigenständig.

Eine andere Methode ist Association Rule Learning beziehungsweise Association Analysis, also die Analyse von Verbindungen in den Daten mit dem Ziel, die wichtigsten Beziehungen zwischen den Daten herauszufinden. Diese Beziehungen helfen dabei, die Daten besser zu verstehen, da die Korrelationen transparenter werden. Dies ist insbesondere dort hilfreich, wo es viele Variablen gibt, wie zum Beispiel in der Medizin bei der Diagnose von Krankheiten. Da viele Krankheiten ähnliche Symptome haben, ist es hilfreich, zu wissen, welche Symptome in der Vergangenheit mit einer hohen Wahrscheinlichkeit zu welchen Krankheiten gehört haben. Wahrscheinlichkeiten spielen beim maschinellen Lernen eine wesentliche Rolle. Denn es geht nicht darum, ob das Ergebnis richtig oder falsch ist. Die Maschine berechnet lediglich die Eintrittswahrscheinlichkeit eines bestimmten Ergebnisses. Die Antwort könnte also lauten: zu 95 Prozent handelt es sich um einen bösartigen Tumor und zu 56 Prozent um einen harmlosen. Hier spielt der statistische Wert eine große Rolle und entscheidet darüber, ob wir die Antwort akzeptieren oder nicht. Das ist die sogenannte statistische Sicherheit.

Die dritte Methode unserer zweiten Ebene ist das verstärkende Lernen (Reinforcement Learning). Sie stammt aus der Psychologie und wurde von der Arbeit des amerikanischen Psychologen Edward Lee Thorndike inspiriert. Aus seinen Verhaltensstudien an Tieren hat er die Theorie vom Lernen durch Versuch und Irrtum entwickelt. Diese Theorie wird nun bei Maschinen verwendet. Im Gegensatz zu den vorherigen Methoden sind hier nicht die Daten am wichtigsten, sondern die Umgebung beziehungsweise Umwelt. Die Maschine lernt durch die Interaktion mit ihrer Umgebung und bildet eine Strategie, um erhaltene Belohnungen zu maximieren. Dafür ist es wichtig zu wissen, in welchem Zustand sie sich befindet und welche Aktion (beziehungsweise Handlung) die höchste Erfolgswahrscheinlichkeit verspricht. Jede Aktion, die die Maschine dem gewünschten Ziel näherbringt, führt zu einer Belohnung. Und jede Aktion, die die Maschine vom Ziel entfernt, verursacht eine Bestrafung. Belohnung und Bestrafung bildet man mathematisch ab, und die Maschine wiederholt die Vorgänge und lernt durch Versuch und Irrtum, welche (aus der Menge an verfügbaren) Aktionen die optimalen sind, um den zu erwartenden Gewinn zu maximieren. Diese heuristische Methode verwendet man vor allem dann, wenn man nicht über große Datenmengen verfügt oder wenn die Realität zu komplex ist, um alle Parameter, Variablen und Szenarien vorher definieren zu können. Stattdessen baut man ein realitätsnahes Modell und lässt die Maschine sich austoben. Ähnlich wie in einem Flugsimulator lernt die Maschine so, ein Flugzeug zu steuern, ohne dass man ihr vorher das Fliegen beigebracht hat.

Die künstlichen neuronalen Netze

Deep Learning bildet die letzte Ebene unseres Werkzeugkastens. Mit Deep Learning oder tiefem Lernen meint man ein künstliches neuronales Netz mit vielen Schichten. Diese Methode wurde in Zusammenarbeit mit der Neurowissenschaft entwickelt. Dabei simuliert man bestimmte neurobiologische Konzepte beziehungsweise die Art und Weise, wie unser Gehirn funktioniert, und überträgt das auf den Computer. Hier muss man anmerken, dass die Neurowissenschaft die Funktionsweise unseres Gehirns noch nicht komplett verstanden hat. Das heißt, wir simulieren mit den Computern nur die Grundlagen eines neuronalen Netzes mit seinen Neuronen, Synapsen, Neurotransmittern und Verbindungen.

Die kleinste funktionale Einheit bildet die Nervenzelle (Neuron). Sie ist entweder ruhig oder aktiv. Wird sie aktiviert, indem ein Signal über ihre Rezeptoren ankommt (wie etwa der Geruch von frisch gebackenem Brot durch die Nase), löst sie eine chemische Reaktion aus, die Spannung in der Zelle erzeugt. Ist die Spannung groß genug, also über einem bestimmten Schwellenwert, feuert sie ein Signal an die nächste Nervenzelle, und zwar nicht direkt, sondern über die sogenannten Synapsen. Nach und nach werden so Teile unseres Gehirns aktiviert, Wasser läuft uns im Mund zusammen, und wir spüren ein Knurren im Magen. Unsere Nervenzellen haben gelernt, was hinter diesem Geruch steht, nämlich leckeres Brot. Und sie haben Verbindungen zwischen den entsprechenden Nervenzellen in unserem ganzen Körper gebildet. Diese Verbindung ist eine Lerneinheit.

Nach der Hebb’schen Lernregel wächst eine Verbindung zwischen Neuronen, wenn immer wieder dieselben Neuronen aktiviert werden. Die Betonung liegt hier auf »immer wieder«. Denn wenn die Wiederholung nachlässt, wird die Verbindung aufgelöst; die Information scheint nicht mehr relevant zu sein und gerät in Vergessenheit. Dafür werden neue Verbindungen gebaut, die mehr Relevanz haben.

Diese Fähigkeit unseres Nervensystems, sich immer wieder neu zu formen, ist faszinierend und wird als Neuroplastizität bezeichnet. Dieser Mechanismus ist auch für den Lernprozess und das Gedächtnis zuständig. Kein Wunder also, dass die Informatik sich hier abgucken möchte, wie sie das auf die Maschinen übertragen kann.

Die kleinste Einheit eines künstlichen neuronalen Netzes ist das einfache Perzeptron. Dieses besteht aus einem einzelnen künstlichen Neuron, das die Funktionsweise einer Nervenzelle nachahmt. Ein Perzeptron hat mehrere Eingänge (Input-Neuronen) und einen Ausgang (Output-Neuron). Ist die Summe der Werte im Eingang höher als ein bestimmter Schwellenwert, wird der Ausgang aktiviert. Da die Eingänge auch mal unterschiedliche Wichtigkeiten haben können, bekommen sie jeweils eine Gewichtung. Das mag vielleicht sehr abstrakt klingen, aber das machen wir Menschen bei vielen unserer Entscheidungen genauso. Stellen wir uns vor, wir werden zu einer Party eingeladen. Um zu entscheiden, ob wir tatsächlich hingehen, legen wir ein paar Kriterien zugrunde: Wer ist noch eingeladen? Wo findet die Party statt? Welche Musik wird gespielt? … Jedes Kriterium spielt eine Rolle. Für mich zum Beispiel ist die Musik am wichtigsten, da ich gern tanze. Das Kriterium Musik bekommt also die höchste Gewichtung. Das heißt, wenn R&B gespielt wird, dann wäre ich bereit, auch ein bisschen weiter zu fahren. Bei Hardrock dagegen sinkt meine Bereitschaft zur Teilnahme, selbst wenn die Party gleich um die Ecke stattfindet. Kommen zu dieser Party aber Freunde, die ich sehr gern mag und lange nicht mehr getroffen habe, dann würde ich für ein paar Stunden das Geräusch in Kauf nehmen.

Das heißt, bei mehreren Kriterien mit unterschiedlichen Gewichtungen überlege ich so lange hin und her, bis ich die optimale Entscheidung für mich getroffen habe. Das Perzeptron überlegt nicht lange, sondern kalkuliert einfach, und zwar die Summe der Eingangswerte multipliziert mit den Gewichtungen.

Die Kunst besteht also darin, diese Gewichtungen so lange anzupassen, bis das Ergebnis am Ausgang stimmt. Das mache ich mit meiner Partyentscheidung, und das tut das Perzeptron ebenfalls. Sobald dies in der Trainingsphase erfolgt ist, kann das Perzeptron eigenständig handeln und seinen Ausgang entsprechend aktivieren. Es hat gelernt. Bei der nächsten Einladung brauche ich mein Perzeptron nur über die Eckdaten zu informieren, dann sagt es mir, was ich tun sollte.

Ein künstliches neuronales Netz besteht in der Regel aus Tausenden oder Millionen von Perzeptronen, die in Schichten geordnet sind. Auf der einen Seite befinden sich die Input-Neuronen, dort geben wir die Daten ein, die es zu analysieren gilt. Das Ergebnis aus der ersten Schicht an Perzeptronen wird dann als Input an die nächste Schicht weitergegeben, und so geht es weiter bis zum Output. Zwischen den Input-Neuronen und dem Output befinden sich die sogenannten Hidden-Neuronen, versteckte Neuronen also. Der Einfachheit halber habe ich ein zweilagiges Perzeptron abgebildet, mit einem einzigen Hidden Layer (das in diesem Zusammenhang verwendete englische Wort für Schicht). Jetzt muss man sich das mit Tausenden von Hidden Layers dazwischen vorstellen. Von jedem Input-Neuron weisen drei Pfeile zu den Hidden-Neuronen. Sie sollen nur die drei verschiedenen Möglichkeiten abbilden, eines der nächsten Neuronen zu aktivieren, denn wir haben ja gesagt, es gibt für jedes Perzeptron nur einen Ausgang, also nur ein Output-Neuron, das heißt, es wird entweder das eine oder das andere Neuron gefeuert, nicht alle gleichzeitig.

Abbildung 1: Ein einfaches zweilagiges Perzeptron

Je mehr Lagen ein künstliches neuronales Netz hat, desto komplexer sind die Aufgaben, die es lösen kann – komplexer auf jeden Fall als meine Partyentscheidung. Am wichtigsten aber ist, dass die Maschine dabei lernt. Denn je besser ich die Gewichtungen (nach jeder Iteration) justiert habe, desto besser lernt mein Netzwerk und kann in Zukunft ähnliche Entscheidungen viel schneller und genauer treffen.

Die Einsatzgebiete der künstlichen neuronalen Netze sind vielfältig. Sie werden zum Beispiel sehr viel für die Computervision verwendet. Dabei ermöglicht man es Computern zu sehen. Die praktischen Anwendungen sind ebenfalls vielfältig, sei es bei der Produktqualitätskontrolle in Fabriken, bei autonomen Fahrzeugen oder bei der Brustkrebserkennung, um mal ein paar Beispiele zu nennen.

Foundation Models

Eine neue Methode, die erst im Jahr 2021 populär wurde, sind die sogenannten Foundation Models. Diese Methode basiert auf Deep Learning und Transfer Learning. Deep Learning haben wir im vorigen Absatz gesehen. Transfer Learning kann man damit zusammenfassen, dass das erlangte Wissen aus einem bestimmten Umfeld relativ schnell auf ein neues Umfeld transferiert beziehungsweise angewendet werden kann. Das ist wie mit dem Autofahren: Wenn ich gelernt habe, Auto zu fahren, kann ich mit relativ geringem Aufwand ein anderes Automodell fahren, oder sogar einen Lkw. Das trainierte Deep-Learning-Modell wendet also gelernte Muster in einem neuen Szenario an. Vereinfacht gesagt, kann ein neuronales Netz, das gelernt hat, Hunde auf Fotos zu erkennen, Tumore in Röntgenbildern identifizieren. Der große Vorteil liegt darin, dass man nicht bei null anfangen muss. Das spart Zeit und viel Energie, da das initiale Modell teilweise wochen- oder monatelang trainiert wird. Und vor allem spart es große Mengen an Daten. Das Modell braucht viel weniger Röntgenbilder zum Trainieren und erzielt trotzdem gute Ergebnisse.

Foundation Modelswurden durch die Studie On the Opportunities and Risks of Foundation Models der Stanford Universität bekannt.1 Es sind große Modelle, die mit riesigen Datenmengen trainiert wurden und mit einem Finetuning auf verschiedene Aufgaben umtrainiert werden können. Bekannte Beispiele sind große Sprachmodelle wie BERT oder GPT-3, die die Grundlage für verschiedene weitere Modelle bilden. Ein interessanter Aspekt an diesen Modellen ist auch die Art und Weise, wie sie lernen. Es kommt hier ein Self-Learning-Einsatz ins Spiel, den wir bisher nicht gesehen haben. Wie der Name sagt, geht es beim Self-Learning darum, dass die Maschine selbst lernt, ohne jegliche menschliche Überwachung. Und das läuft so ab: Stell dir ein Buchmanuskript vor. Die Maschine bekommt nun die Aufgabe, jedes zehnte Wort des Manuskripts zu verdecken. In einer Datenbank können die verdeckten Worte gespeichert werden, samt der jeweiligen Position im Text. Die Maschine erstellt dann eine Kopie des Manuskripts und versucht, die fehlenden Worte zu erraten. Aus der Datenbank kann sie das richtige Wort ziehen und selbst prüfen, wie gut sie geraten hat. So lernt sie selbst, Texte zu vervollständigen, ohne dass Menschen diese vorher gelabelt hätten. Die Logik kann dann verwendet werden, um andere unbekannte Texte zu vervollständigen.

Nun sind wir am Ende unseres Werkzeugkastens angekommen. Die Methoden beziehungsweise Werkzeuge, die wir bisher gesehen haben, bilden die Grundlage aller Methoden der künstlichen Intelligenz. Natürlich gibt es verschiedene Varianten dieser Werkzeuge. Und es gibt die Möglichkeit, mehrere Methoden zu kombinieren, um neue Probleme zu lösen. Aber für unsere Zwecke ist diese Übersicht ausreichend. Die theoretischen Grundlagen dieser Methoden sind übrigens schon seit den 1950er-Jahren bekannt. Warum also gibt es den KI-Hype erst jetzt?

Die KI-Beschleuniger oder das ABC der KI

Im Englischen kann man die Beschleuniger als ABC der KI abkürzen: A für Algorithmen, B für Big Data, also große Datenmengen, und C für Computing Power, sprich Rechenleistung. Diese drei Aspekte sind eine Grundvoraussetzung für die komplexen Berechnungen von Machine Learning undhaben dazu geführt, dass KI jetzt richtig zum Einsatz kommen kann. Schauen wir sie uns im Einzelnen an!

A wie Algorithmus

Trotz des kryptischen Wortes ist ein Algorithmus nichts anderes als eine Handlungsanweisung für die Maschine. Ein Algorithmus hat keine festgelegte Form, er kann als Text (Code), als Ton oder als Flussdiagramm vorkommen. In den Medien wird das Wort Algorithmus als Synonym für KI verwendet. Das ist aber nicht richtig. Algorithmen gab es, lange bevor man über KI nachgedacht hat. Die meisten Algorithmen werden in Codes geschrieben, weil sie das Medium sind, das die meisten Maschinen verstehen. Mit Flussdiagrammen programmiert man vor allem Industrieroboterarme und auch viele Roboter für Prozessautomatisierung. Ein Algorithmus, den jede*r von uns kennt, aber nicht als solchen erkennt, ist die Aufbauanleitung eines Ikea-Möbelstücks. Dieser Algorithmus kommt in Form von Abbildungen mit Zahlen und Pfeilen daher, um uns die Reihenfolge für die Montage zu verdeutlichen. Ähnlich, wie wir diesen Schritten zu folgen versuchen, bis wir unser Möbelstück zusammengebaut haben, verfolgt die Maschine jeden Schritt, um eine bestimmte Aufgabe zu erledigen. Wenn wir an die Ikea-Aufbauanleitung denken, wird uns klar, dass es Algorithmen in ihrer Grundfunktion eigentlich schon immer gab. In den letzten Jahren gab es allerdings eine rasante Entwicklung von Algorithmen, die anstelle eines modellierten Lösungswegs (wie bei der Ikea-Aufbauanleitung) mathematische Anweisungen beinhalten. Es sind Algorithmen, die das maschinelle Lernen ermöglichen, indem sie aus Inputdaten und mathematischen Formeln neues Wissen generieren. Durch Wiederholung lernt der Algorithmus, selbstständig eine Aufgabe zu erfüllen. Anders als bei herkömmlichen Algorithmen orientiert sich die Maschine an einem vorgegebenen Gütekriterium (das Billy-Regal sollte nicht umfallen) und dem Informationsgehalt der Daten (Bauteile, Schrauben, Werkzeuge etc.). Sie lernt dabei selbstständig. Übertragen auf das Ikea-Möbelstück-Problem, könnte das heißen, dass der Algorithmus zuerst studiert, welche Teile in der Packung sind, welche Schrauben, welche Werkzeuge usw., diese ganz genau klassifiziert und sich dann durchprobiert. Je öfter er Teile zusammenschraubt, das Ergebnis analysiert und notiert, und anschließend wiederholt beziehungsweise weitermacht, desto eher wird er den optimalen Weg lernen, ein Billy-Regal zusammenzuschrauben. Algorithmen haben dabei den Vorteil, dass sie bei all diesen Versuchen nie ungeduldig werden, nicht anfangen zu fluchen oder aus purer Verzweiflung ihre Werkzeuge in die Ecke schleudern. Das heißt, wenn die Medien über Algorithmen als Synonym für KI schreiben, meinen sie ganz konkret diese Art von KI-Algorithmen.

B wie Big Data. Sind Daten wirklich das neue Öl?

Daten generieren wir jede Minute, in der wir irgendein elektronisches Gerät nutzen, Urlaubsfotos hochladen, Likes in den sozialen Medien verteilen oder die schnellste Route von A nach B berechnen lassen. Mit der zunehmenden Digitalisierung sowie Anzahl an digitalen Produkten und Apps, nicht zuletzt durch die Pandemie beschleunigt, generieren wir täglich enorme Mengen an Datenpunkten. Heutzutage ist es schwierig, um nicht zu sagen, unmöglich, keine Daten zu generieren. Und im Gegensatz zu Rohstoffen werden Daten nicht mit der Zeit knapper, sondern im Gegenteil immer mehr. Aber die Menge allein hilft nicht viel.

Ohne ein umfassendes Datenmanagement oder die Fähigkeit, die Daten überhaupt erst für die Analyse zugänglich zu machen, kann der Rohstoff nicht veredelt werden. Eine überquellende Datenbank mit unseren Schnappschüssen nützt uns wenig, wenn wir unsere Lieblingsbilder darin partout nicht mehr finden. Kein Wunder also, dass die Datenwissenschaft eine der heutigen Schlüsseldisziplinen ist. Denn es braucht eine vernünftige Datenverwaltung, um wertvolle Erkenntnisse gewinnen zu können.

Die Kunst der Datenwissenschaft besteht darin, die drei Bereiche Erfassung, Modellierung und Analyse von Daten sowie die Entscheidungsfindung so optimal wie möglich anzuwenden, um das maximale Wissen aus den Daten zu extrahieren und es nutzbringend für Wirtschaft und Gesellschaft anzuwenden. Neben Privatpersonen generieren auch alle Wirtschaftszweige heute große Datenmengen. Allerdings ist es für Unternehmen schwierig, die Daten richtig zu nutzen und konkrete Erkenntnisse daraus zu ziehen. Ja, die Regulierung und der Datenschutz spielen hier eine wichtige Rolle, und es ist super, dass wir sie haben. In den meisten Fällen können es sich Unternehmen aber gar nicht leisten, unsere Daten für sich gewinnbringend zu nutzen, zum einen, weil Datenverarbeitung sehr aufwendig ist und ein großes Investment bedeutet, bei dem das Ergebnis selten im Voraus kalkulierbar ist, und zum anderen, weil ein Mangel an Datenwissenschaftler*innen herrscht. Nichtdestotrotz plädiere ich dafür, lieber datensparsam zu handeln und sich gut zu überlegen, wo man seine Daten eingibt und ob es wirklich notwendig ist.

C wie Computing Power

Der dritte und letzte KI-Beschleuniger ist die Rechenleistung. Als in den 1950er-Jahren die ersten KI-Algorithmen und -Methoden entwickelt wurden, hatte man einfache Rechner, die sehr langsam simple mathematische Berechnungen durchführen konnten. Das hat dazu geführt, dass sich die Disziplin zunächst nicht wirklich entwickeln konnte. Aber schon 1965 sagte Gordon Moore, der Mitbegründer von Intel, dass die Anzahl an Transistoren und damit die Rechenleistung sich alle zwei Jahre verdoppeln werde.2 Und er sollte recht behalten. Die Rechenleistung ist in den letzten Jahren rasant gestiegen. Natürlich führt eine Verdopplung der Transistoren nicht zwangsläufig zu einer Verdopplung der Rechenleistung, aber es beschleunigt diese ganz erheblich. Und auch jetzt, wo die physikalische Grenze der Transistoren auf den Halbleiterplatten erreicht wurde und das sogenannte Moore’sche Gesetz keine Anwendung mehr findet,3 steigt die Rechenleistung stetig weiter. Diese technologische Revolution hat wiederum die digitale Revolution befeuert, und so können wir heute über große Rechenleistungen verfügen, ohne selbst einen Superrechner zu besitzen. Alles kommt, wie es so schön heißt, aus der Cloud. Und hier bitte nicht aus den Wolken fallen, auch hinter der Cloud stecken viele Rechner in einem Rechenzentrum, nur dass sie jemand anderem gehören und von diesem mit Strom und einigem mehr versorgt werden. Ein Cloud-Anbieter ermöglicht es seinen Kunden, auf seine geballte Rechen-Power zuzugreifen und diese zu nutzen – als Dienstleistung, in der Regel mit verbrauchsbasiertem Abrechnungsmodell, dem sogenannten Pay per Use. Man muss also keine Hardware erwerben, sondern kauft nur die Rechenleistung, und diese auch nur so lange, wie man sie tatsächlich braucht und nutzt. Viele Berechnungen (das, was die Algorithmen tun), die sonst eher langsam auf begrenzten lokalen Ressourcen gelaufen wären, können nun relativ schnell und skalierbar in der Cloud laufen. Das heißt, hier haben wir ein zweidimensionales Wachstum der Rechenleistung: einmal aufgrund der technologischen Entwicklung, dass die Prozessoren viel schneller sind, und ein andermal durch das Cloud Computing, also den Zugriff auf weitere Ressourcen weit jenseits von unserem Schreibtisch oder Laptop.

Zusammengefasst bedeutet das: Wir haben immer mehr Daten, die mit immer schlaueren Algorithmen auf Hochleistungsrechnern per Knopfdruck analysiert werden können. Kein Wunder also, dass die KI inzwischen überall in unserem Alltag ist – oft ohne dass wir es merken.