Erhalten Sie Zugang zu diesem und mehr als 300000 Büchern ab EUR 5,99 monatlich.

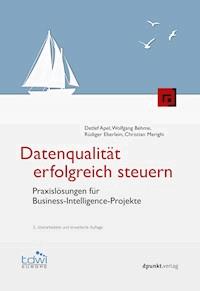

- Herausgeber: dpunkt

- Kategorie: Fachliteratur

- Serie: Edition TDWI

- Sprache: Deutsch

Immer mehr Unternehmen begreifen ein gutes Datenqualitätsmanagement als einen entscheidenden Wettbewerbsvorteil: Die IT-Kosten sinken, Projekte werden beschleunigt, auf Änderungen am Markt oder von gesetzlichen Auflagen kann schneller und flexibler reagiert werden. Datenintegrationen über System-, Abteilungs- und Unternehmensgrenzen hinweg werden erleichtert und falsche Entscheidungen basierend auf mangelhaften Daten verhindert. Anhand praktischer Beispiele zeigt Ihnen dieses Buch, wie Sie die Qualität Ihrer Daten zielorientiert und nachhaltig verbessern können. Analysieren Sie die Ursachen und Auswirkungen schlechter Datenqualität und erfahren Sie, welche Investitionen sich wirklich lohnen. Lernen Sie die Grundlagen des Datenqualitätsmanagements kennen, die technische Umsetzung mit passgenauen Werkzeugen sowie die praktische Umsetzung in einem kompletten Zyklus eines BI-Projekts. Mit diesem umfassenden Wissen bieten Ihnen die Autoren einen wertvollen Leitfaden für ein erfolgreiches Datenqualitätsmanagement. Die 3. Auflage wurde komplett überarbeitet. Als neues Thema wurde Big Data aufgenommen, da es für die Welt der Business Intelligence eine neue Evolutionsstufe darstellt und somit Auswirkungen auf das Datenqualitätsmanagement hat.

Sie lesen das E-Book in den Legimi-Apps auf:

Seitenzahl: 477

Veröffentlichungsjahr: 2015

Das E-Book (TTS) können Sie hören im Abo „Legimi Premium” in Legimi-Apps auf:

Ähnliche

Detlef Apel ist der Subject Matter Expert für Stammdaten- und Datenqualitätsmanagement bei Capgemini. Durch seine mehr als 17-jährige Erfahrung mit der Datenintegration aus heterogenen Systemen, dem Reporting, der Analyse und der Big Data Analytics ist er schnell auf das Datenqualitätsmanagement als wesentlichen Wettbewerbsvorteil für Unternehmen gestoßen. Er hat namhafte Kunden aus unterschiedlichen Branchen bei der Einführung und Optimierung ihres Datenmanagements erfolgreich beraten sowie als Architekt und Entwickler die technische Implementierung übernommen. Weiter ist er Redner auf verschiedenen Konferenzen, Autor zahlreicher Fachpublikationen und Vertreter des Expert-Connect-Programms von Capgemini.

Dr. Wolfgang Behme ist als Global Support Manager im Competence Center BI/CRM/eCom/Mobility bei der Continental Reifen Deutschland GmbH verantwortlich für den weltweiten Support der SAP BW Plattform, auf der alle BI-Anwendungen der Reifen-Division laufen. Er arbeitet seit mehr als 15 Jahren im BI-Umfeld und ist Autor und Herausgeber diverser Fachpublikationen. Sein Anliegen, den Austausch zwischen Theorie und Praxis zu fördern, wird durch zahlreiche Vorträge auf verschiedenen BI-Konferenzen sowie durch Lehraufträge an Hochschulen deutlich.

Rüdiger Eberlein ist Chief Technology Officer Business Information Management bei Capgemini Deutschland. Als Architekt von Anwendungslandschaften hat er sich immer wieder mit der Problematik der Datenqualität auseinandergesetzt. Er hat BI- und Big-Data-Analytics-Lösungen für Unternehmen verschiedener Branchen wie Automobil, Finanzdienstleister, Telekommunikation und Öffentlicher Bereich mitgestaltet. Weiter hat er mehrere Fachartikel zu Architekturthemen aus Big Data Analytics und Business Intelligence veröffentlicht sowie Vorträge auf Konferenzen gehalten. Als Verantwortlicher der Rubrik Daten der Capgemini IT Trends Studie weiß er um die enorme Bedeutung, die das Thema Datenqualität für CIOs in Deutschland hat.

Christian Merighi ist Senior Berater im Bereich BI/DWH Strategic Services bei Teradata GmbH in Österreich. Zu seinen Aufgabengebieten gehören die fachliche Konzeption von Business-Intelligence-/Data-Warehouse-Lösungen, die Erarbeitung von Kosten/Nutzen-Modellen sowie die Definition von Vorgehensmodellen für die Projektumsetzung in diesen Bereichen. In den letzten Jahren hat er sich im Rahmen dieser Tätigkeiten zudem auf den Bereich BI & Data Governance (Konzeption und Aufbau BICC) sowie das ganzheitliche Datenqualitätsmanagement fokussiert. In diesem Umfeld verantwortet er Projekte bei Unternehmen in Österreich, Deutschland und Osteuropa.

Datenqualität erfolgreich steuern

Praxislösungen für Business-Intelligence-Projekte

3., überarbeitete und erweiterte Auflage

Edition TDWI

Detlef ApelWolfgang BehmeRüdiger EberleinChristian Merighi

Detlef Apel · [email protected] Behme · [email protected]üdiger Eberlein · [email protected] Merighi · [email protected]

Fachlektorat: Marcus PilzLektorat: Christa PreisendanzCopy-Editing: Annette Schwarz, DitzingenHerstellung: Birgit BäuerleinUmschlaggestaltung: Anna Diechtierow, HeidelbergDruck und Bindung: M.P. Media-Print Informationstechnologie GmbH, 33100 Paderborn

Fachliche Beratung und Herausgabe von dpunkt.büchern in der Edition TDWI: Marcus Pilz · [email protected]

Bibliografische Information der Deutschen NationalbibliothekDie Deutsche Nationalbibliothek verzeichnet diese Publikation in der Deutschen Nationalbibliografie; detaillierte bibliografische Daten sind im Internet über http://dnb.d-nb.deabrufbar.

ISBN:Buch 978-3-86490-042-6PDF 978-3-86491-641-0ePub 978-3-86491-642-7

3., überarbeitete und erweiterte AuflageCopyright © 2015 dpunkt.verlag GmbHWieblinger Weg 1769123 Heidelberg

Die vorliegende Publikation ist urheberrechtlich geschützt. Alle Rechte vorbehalten. Die Verwendung der Texte und Abbildungen, auch auszugsweise, ist ohne die schriftliche Zustimmung des Verlags urheberrechtswidrig und daher strafbar. Dies gilt insbesondere für die Vervielfältigung, Übersetzung oder die Verwendung in elektronischen Systemen.Es wird darauf hingewiesen, dass die im Buch verwendeten Soft- und Hardware-Bezeichnungen sowie Markennamen und Produktbezeichnungen der jeweiligen Firmen im Allgemeinen warenzeichen-, marken- oder patentrechtlichem Schutz unterliegen.Alle Angaben und Programme in diesem Buch wurden mit größter Sorgfalt kontrolliert. Weder Autor noch Verlag können jedoch für Schäden haftbar gemacht werden, die in Zusammenhang mit der Verwendung dieses Buches stehen.

5 4 3 2 1 0

Geleitwort zur 3. Auflage

Es zeugt von einem anhaltenden Interesse für das Thema Datenqualität und auch für die Qualität der vorliegenden Publikation, dass nun schon die 3. Auflage erscheinen kann. Ich danke den Autoren Detlef Apel, Dr. Wolfgang Behme, Rüdiger Eberlein und Christian Merighi für die überaus fundierten Ausführungen und die Breite, in der sie das Feld der Datenqualität im Kontext von Business Intelligence abhandeln. Es ist deutlich erkennbar, dass alle Autoren die Problemdomäne um schlechte Datenqualität in Unternehmen nicht nur theoretisch erfasst haben, sondern aus ihrer Praxiserfahrung heraus auch Lösungsansätze zu liefern vermögen. Auch in der 3. Auflage ist es zu Anpassungen und Erweiterungen gekommen, die dem Buch gutgetan haben und dessen Wert noch steigern.

Da in der Unternehmenspraxis der Druck zur Verbesserung der Datenqualität nicht nachlässt, bin ich sicher, dass die vielen hilfreichen Handreichungen zur Arbeit in BI-Projekten das Buch zu einem ständigen Begleiter der Projektmitarbeiter machen. Darüber hinaus nimmt das Werk auch einen festen Platz in der Literaturliste der Hochschulen und Universitäten ein, denn es vermittelt in sehr anschaulicher Art und Weise die Problemstellungen und die Lösungswege, welche wir den Studierenden näherbringen wollen.

In diesem Sinn empfehle ich allen Lesern die Lektüre der 3. Auflage, sei es als Lehrstoff oder als Kompendium zur eigenen Projektarbeit.

Univ.-Prof. Dr. Peter Chamoni

Vorwort zur 3. Auflage

Nach Schätzungen (vgl. [Crosby 1979, S. 15] und [Juran 1988, S. 1]) verursacht schlechte Datenqualität in Unternehmen Verluste in Höhe von bis zu 25 Prozent des operativen Gewinns. Aufgrund der zunehmenden Integration von IT in die Geschäftsprozesse der Unternehmen, der Anforderungen hinsichtlich Compliance sowie der Einbeziehung unternehmensexterner Daten (z.B. Big Data) nimmt die Bedeutung von Datenqualität nochmals erheblich zu. Die Hoffnung vieler Unternehmen auf Lösung der Datenqualitätsproblematik durch die Einführung von Standardsoftware für Enterprise Resource Planning (ERP), Customer Relationship Management (CRM), Supply Chain Management (SCM) u.a. hat sich nicht erfüllt und macht endlich Platz für wirksame Maßnahmen.

Im Mittelpunkt dieses Buches steht die Vermittlung langjähriger Erfahrungen aus BI-Projekten mit Datenqualitätsmanagement-Aktivitäten bei Unternehmen unterschiedlicher Branchen. Neben der anwender- und praxisorientierten Darstellung der verschiedenen Bereiche von Datenqualitätsmanagement (DQM) werden die Best Practices und Lessons Learned dargestellt, sodass der Leser eigene Projekte in diesem Umfeld erfolgreich durchführen kann.

Generell werden Daten über eine Benutzerschnittstelle erfasst oder durch Geschäftslogik von IT-Systemen erzeugt. Meistens fließen die Daten weiter in andere IT-Systeme und werden dabei transformiert. Ein Datenfluss kann viele Stationen haben. Das Data Warehouse ist häufig nur die »Endstation« solcher Datenflüsse. Werden fehlerhafte Daten nicht erkannt und behandelt, führen sie im Verlauf des Datenflusses zu Folgefehlern, die sich leicht zu größeren Problemen aufschaukeln können. Es liegt also auf der Hand, ein Datenqualitätsmanagement möglichst frühzeitig im Datenfluss anzusetzen. Nachhaltiges Datenqualitätsmanagement ist daher idealerweise eine unternehmensweite Aktivität, die ggf. von Vorhaben für Business Intelligence oder auch Customer Relationship Management angestoßen werden muss.

In den meisten Unternehmen kommen fehlerhafte Daten erst im Data Warehouse ans Licht. Das liegt daran, dass dort alle Daten in Gänze und verdichtet betrachtet werden, während beim Datenzugriff durch operative Systeme nur einige Felder in dem einen oder anderen Datensatz zutage treten. Schlechte Datenqualität lässt sich im Data Warehouse nicht verbergen. Allerdings ist es oft genau diese schlechte Datenqualität, die die Akzeptanz der BI-Anwendung durch den Endanwender in den Fachbereichen verhindert und häufig direkt zum Misserfolg des mit dem Data Warehouse verbundenen Vorhabens führt. Wer will schon wichtige geschäftliche Entscheidungen auf fehlerhafte Daten stützen? Da lässt es sich noch besser aus dem Bauch heraus entscheiden.

Dieses Buch hat nicht den Anspruch eines unternehmensweiten Datenqualitätsmanagements, sondern fokussiert auf den Bereich Business Intelligence, wo der Schmerz mit fehlerhaften Daten am größten ist. Unter Business Intelligence (BI) wird ein integrierter, unternehmensspezifischer, IT-basierter Gesamtansatz zur Unterstützung betrieblicher Entscheidungen verstanden. »Business Intelligence ist der Prozess, der Daten in Informationen und weiter in Wissen umwandelt« (Definition von Howard Dresdner (Gartner) 1989). Unternehmensentscheidungen und Prognosen stützen sich auf dieses Wissen und führen zu geschäftlichem Mehrwert. Business Intelligence kommt sowohl zur Unterstützung strategischer Entscheidungen als auch im operativen Bereich zum Einsatz.

Business Intelligence umfasst ein breites Spektrum an Anwendungen und Technologien und ist der Oberbegriff für Data Warehousing, Data Mining, Online Analytical Processing und Analytische Anwendungen. Im weiteren Sinne umfasst Business Intelligence auch die Erschließung unstrukturierter Daten mittels Content- und Dokumentenmanagement. Letztgenannte Bereiche sind jedoch nicht Gegenstand dieses Buches. Betrachtet wird lediglich die Business Intelligence im engeren Sinn, also auf strukturierte Daten bezogen.

Abb. 1 Grobe Architektur für Business Intelligence

Das Data Warehouse ist eine konsolidierte Datenhaltung zur Unterstützung von Reporting und Analyse. »Ein Data Warehouse ist eine themenorientierte, integrierte, chronologisierte und persistente Sammlung von Daten, um das Management bei seinen Entscheidungsprozessen zu unterstützen« (vgl. [Inmon 1996]).

Das Buch gliedert sich in drei Teile. Im ersten Teil wird beschrieben, was Datenqualitätsmanagement ausmacht. Der zweite Teil befasst sich mit der Umsetzung und stellt insbesondere technische Hilfsmittel dar. Im dritten Teil wird erklärt, wie man Verfahren, Methoden, Organisation und Werkzeuge des Datenqualitätsmanagements in der Praxis einsetzt.

Zu Beginn des ersten Teils (Kapitel 1) werden die wesentlichen Begriffe im Zusammenhang mit Datenqualitätsmanagement definiert. In Kapitel 2 wird erklärt, woran sich schlechte Datenqualität festmacht und wo die Ursachen dafür liegen. In Kapitel 3 wird dargelegt, warum es sich lohnt, ein Datenqualitätsmanagement aufzusetzen. In Kapitel 4 werden die organisatorischen Belange in Bezug auf die Datenqualität ausführlich geschildert. Die Architektur für BI-Anwendungen wird unter dem Blickwinkel der Datenqualität in Kapitel 5 betrachtet. In Kapitel 6 wird Big Data Analytics mit den Herausforderungen an das Datenqualitätsmanagement diskutiert. Hierbei wird auch auf den Bereich der unstrukturierten Daten eingegangen. Das Kapitel 7 beschreibt, wie sich Datenqualität messen lässt.

Im zweiten Teil des Buches werden wichtige Prinzipien der technischen Umsetzung des Datenqualitätsmanagements beschrieben. Dabei werden die Werkzeuge zur Unterstützung des Datenqualitätsmanagements betrachtet, angefangen beim Metadatenmanagement über Data Profiling, die Validierung, Bereinigung und Anreicherung von Daten bis hin zur fortlaufenden Überwachung der Datenqualität. Anschließend wird auf die Integration der Werkzeuge in die Anwendungslandschaft der jeweiligen IT-Umgebung eingegangen. Am Ende dieses Buchteils werden Kriterien zur Produktauswahl aufgeführt.

Der dritte und letzte Teil des Buches bildet Datenqualitätsmanagement auf das Vorgehen in BI-Projekten ab. Dabei werden die einzelnen Phasen eines BI-Projekts von der Vorstudie über Spezifikation, Design und Umsetzung bis zum Betrieb im Unternehmen betrachtet. Für jede Projektphase werden die jeweils einzusetzenden Elemente des Datenqualitätsmanagements benannt, die im zweiten Teil des Buches beschrieben wurden. Somit bietet der dritte Buchteil für Projektverantwortliche eine unverzichtbare Hilfestellung zur erfolgreichen Durchführung von Projekten.

Was hat sich in der 3. Auflage geändert? Im 1. Teil des Buches wurde das Thema Big Data neu aufgenommen, da es für die Welt der Business Intelligence eine neue Evolutionsstufe darstellt und somit Auswirkungen auf das Datenqualitätsmanagement hat. Weiterhin wurden in allen Kapiteln Aktualisierungen vorgenommen.

Detlef Apel, Wolfgang Behme, Rüdiger Eberlein, Christian MerighiTroisdorf, Hannover, München, Wien, im Dezember 2014

Inhaltsübersicht

Teil I

1 Datenqualität

2 Ausprägungen und Ursachen schlechter Datenqualität

3 Auswirkungen schlechter Datenqualität

4 Organisation

5 Referenzarchitektur für Business-Intelligence-Anwendungen

6 Big Data

7 Kennzahlen zur Messung der Datenqualität

Teil II

8 Verbesserung der Datenqualität im Quellsystem

9 Data Profiling

10 Erfolgreiche Datenvalidierung und -filterung

11 Standardisierung und Bereinigung

12 Datenanreicherung

13 Verbesserung der Datenqualität in der Bereitstellung und Visualisierung

14 Wertschöpfung durch Metadaten

15 Data Quality Monitoring

16 Produktauswahl und -integration

Teil III

17 Datenqualitätsmanagement in einer Studie

18 Datenqualitätsmanagement in der Spezifikation

19 Datenqualitätsmaßnahmen in der Konstruktionsphase

20 Steuerung der Datenqualität in der Realisierung

21 Steuerung der Datenqualität im Betrieb

Anhang

Abkürzungen

Literatur

Index

Inhaltsverzeichnis

Teil I

1 Datenqualität

1.1 Daten

1.2 Qualität

1.3 Datenqualität

1.4 Datenqualitätsmanagement

1.5 Zusammenfassung

2 Ausprägungen und Ursachen schlechter Datenqualität

2.1 Geschäftstreiber

2.2 Ausprägungen schlechter Datenqualität

2.3 Ursachen schlechter Datenqualität

2.4 Beispiel: Finanzdienstleister

2.5 Empfehlungen

3 Auswirkungen schlechter Datenqualität

3.1 Datenqualitätskosten

3.2 Gesetzliche Anforderungen

3.3 Business-Case-Betrachtungen

3.4 Empfehlungen

4 Organisation

4.1 Aufbauorganisation

4.2 Ablauforganisation

4.3 Empfehlungen

5 Referenzarchitektur für Business-Intelligence-Anwendungen

5.1 Referenzarchitektur

5.1.1 Datenquellen und Datenströme

5.1.2 Datenintegration

5.1.3 Datenhaltung

5.1.4 Informationsbereitstellung

5.1.5 Anwender und Rollen

5.1.6 Operative Anwendungen und Prozesse

5.1.7 Querschnittsprozesse

5.2 Problemstellen und Lösungsansätze hinsichtlich der Datenqualität

5.2.1 Datenquellen

5.2.2 Datenintegration

5.2.3 Datenhaltung

5.2.4 Informationsbereitstellung

5.3 Architektur für Datenqualitätsmanagement

5.4 Serviceorientierte Architektur

5.5 Master Data Management

5.5.1 Architektur

5.5.2 Umsetzung

5.6 Empfehlungen

6 Big Data

6.1 Definitionen von Big Data

6.1.1 Fachlich-datenbezogene Sicht

6.1.2 Gartner-Sicht

6.1.3 Technisch-infrastrukturelle Sicht

6.2 Bedeutung der Datenqualität bei Big Data

6.3 Herausforderung externe Daten

6.4 Herausforderung unstrukturierte Daten

6.5 Herausforderung Geschwindigkeit

6.6 Herausforderung Volumen

6.7 Empfehlungen

7 Kennzahlen zur Messung der Datenqualität

7.1 Anwendungsmöglichkeiten von Kennzahlen

7.2 Messpunkte für Datenqualität

7.3 DQ-Metriken

7.4 Kennzahlen für ausgewählte Datenqualitätskriterien

7.5 Kennzahlenbaum

7.6 Kennzahlenformular

7.7 Empfehlungen

Teil II

8 Verbesserung der Datenqualität im Quellsystem

8.1 Vorbeugung vor neuen Datenqualitätsproblemen

8.2 Empfehlungen

9 Data Profiling

9.1 Data-Profiling-Prozess

9.1.1 Schritt 1: Integration der Daten

9.1.2 Schritt 2: Analyse der integrierten Daten

9.1.3 Schritt 3: Darstellung der Ergebnisse

9.1.4 Schritt 4: Fachliche Bewertung der Ergebnisse

9.2 Zusammensetzung des Data-Profiling-Teams

9.3 Vorgehensweise beim Data Profiling

9.4 Data-Profiling-Verfahren zur Analyse von Attributen

9.4.1 Standardanalysen auf Attributebene

9.4.2 Analyse der Attribute mit Geschäftsregeln

9.5 Data-Profiling-Verfahren zur Analyse von Datensätzen

9.5.1 Analyse auf Schlüsselattribute

9.5.2 Analyse auf abgeleitete Werte

9.5.3 Analyse von Datensätzen mit Geschäftsregeln

9.6 Data-Profiling-Verfahren zur Analyse von Tabellen

9.6.1 Analyse von Tabellen auf referenzielle Abhängigkeiten

9.6.2 Analyse von Tabellen mit Geschäftsregeln

9.7 Empfehlungen

10 Erfolgreiche Datenvalidierung und -filterung

10.1 Validierung auf vier Ebenen

10.2 Filterung fehlerhafter Daten

10.3 Validierung bei Extraktion oder Laden

10.4 Arten der Datenvalidierung

10.5 Erstellung der Validierungsregeln und Speicherung der Ergebnisse

10.6 Empfehlungen

11 Standardisierung und Bereinigung

11.1 Standardisierung

11.2 Datenbereinigung

11.3 Standardisierung und Bereinigung im ETL-Prozess

11.4 Verfahren für nicht zu bereinigende Daten

11.5 Empfehlungen

12 Datenanreicherung

12.1 Wirtschaftsinformationen

12.2 Geografische Informationen

12.3 Soziodemografische Informationen

12.4 Haushaltsbildung

12.5 Standards zur Klassifizierung von Waren und Dienstleistungen

12.6 Branchenklassifizierung

12.7 Empfehlungen

13 Verbesserung der Datenqualität in der Bereitstellung und Visualisierung

13.1 Bereitstellung der Daten

13.2 Visualisierung der Information

13.3 Empfehlungen

14 Wertschöpfung durch Metadaten

14.1 Metadaten: Begriff und Strukturierung

14.2 Metadatenarchitekturen

14.3 Metadatenmanagement

14.4 Metadatenkategorien

14.5 Probleme bei der Erstellung: Motivation und Aktualität

14.6 Nutzung von Metadaten

14.7 Empfehlungen

15 Data Quality Monitoring

15.1 DQ-Planung

15.2 DQ-Assessment

15.3 DQ-Phasenkonzepte

15.4 Methoden

15.5 Verantwortlichkeiten

15.6 Empfehlungen

16 Produktauswahl und -integration

16.1 Anbieter und Produkte

16.2 Auswahlkriterien im Überblick

16.3 Funktionale Kriterien

16.4 Integration

16.5 Einbeziehung der Fachbereiche

16.6 Sprachen und Länder

16.7 Einbindung in DQM-Prozesse

16.8 Empfehlungen

Teil III

17 Datenqualitätsmanagement in einer Studie

17.1 Analyse des Istzustands

17.2 Entwurf des Sollkonzepts

17.3 Bewertung

17.4 Umsetzungsplanung

17.5 Empfehlungen

18 Datenqualitätsmanagement in der Spezifikation

18.1 Spezifikation der Schnittstellen

18.2 Definition der Rollen in der Datenorganisation

18.3 Festlegung der Datenqualitätsziele

18.4 Bezeichnung und Definition der Objekte

18.5 Festlegung der Geschäftsregeln

18.6 Messung der Qualität von Definitionen und Geschäftsregeln

18.7 Data Profiling in der Spezifikation

18.8 Entwurf des Systems

18.9 Empfehlungen

19 Datenqualitätsmaßnahmen in der Konstruktionsphase

19.1 Übertragung der Datenqualitätsziele

19.2 Konventionen und Richtlinien

19.3 Entwurf des Systems

19.4 Erstellung eines Prototypen

19.5 Empfehlungen

20 Steuerung der Datenqualität in der Realisierung

20.1 Einhaltung der Konventionen, Richtlinien und Konzepte

20.2 Data Profiling in der Realisierung

20.3 Einbindung der Datenverantwortlichen und Benutzer

20.4 Realisierung der Datenqualitätsmaßnahmen

20.5 Durchführung von Tests

20.6 Empfehlungen

21 Steuerung der Datenqualität im Betrieb

21.1 Monitoring und Berichtswesen

21.2 Ausbildung

21.3 Empfehlungen

Anhang

Abkürzungen

Literatur

Index

Teil I

1 Datenqualität

2 Ausprägungen und Ursachen schlechter Datenqualität

3 Auswirkungen schlechter Datenqualität

4 Organisation

5 Referenzarchitektur für Business-Intelligence-Anwendungen

6 Big Data

7 Kennzahlen zur Messung der Datenqualität

1 Datenqualität

Der Begriff Datenqualität ist sehr stark subjektiv geprägt. Sowohl bei der Befragung von Fachleuten als auch in der Literatur erhält man zu diesem Thema sehr unterschiedliche Antworten. Viele Autoren gehen in Ermangelung einer einheitlichen Definition daher auf die beiden Grundbestandteile des Begriffs zurück und definieren sowohl Daten als auch Qualität allgemein und folgen damit Larry English, einem der Pioniere auf dem Gebiet der Datenqualität: »The best way to look at information quality is to look at what quality means in the general marketplace and then translate what quality means for information« (vgl. [English 1999, S. 15ff.]).

In diesem Kapitel werden zunächst die grundlegenden Begriffe Daten und Qualität und daraus abgeleitet der Begriff Datenqualität erläutert. Nach einer ausführlichen Beschreibung der Eigenschaften wird auf unterschiedliche Taxonomien eingegangen. Den Abschluss des Kapitels bildet das Thema Datenqualitätsmanagement.

1.1 Daten

Die aktuelle Situation in den Unternehmen ist durch eine steigende Datenflut gekennzeichnet. Beispielsweise fallen durch die Vernetzung von Scannerkassen in Supermärkten oder die Speicherung von Verbindungsdaten in der Telekommunikationsbranche große Datenmengen an. Dieser Trend wird durch neue Entwicklungen wie Radio Frequency Identification (RFID) noch verstärkt. Nach Schätzungen der Gartner-Gruppe würde die Einzelhandelskette Wal-Mart täglich Daten im Umfang von 7 Terabyte generieren, wenn alle Artikel mit RFID-Marken versehen würden (vgl. [Raskino/Fenn/Linden 2005]). Gemäß einer IDC-Studie (vgl. [IDC 2011]) ist die weltweit produzierte Datenmenge im Jahr 2011 auf ein Volumen von 1,8 Zettabyte1 angestiegen. Daten allein haben jedoch nur einen begrenzten Wert, erst in einem sinnvollen Kontext werden daraus unternehmensrelevante Informationen.

Bisher gibt es keine einheitliche Definition des Begriffs Daten. Den meisten Definitionen ist jedoch gemein, dass sie Daten nicht getrennt, sondern im Zusammenhang mit Information und Wissen betrachten, weil sich die Begriffe jeweils ergänzen (vgl. [English 1999, S. 18; Helfert 2002, S. 13; Müller 2000, S. 5ff. u.a.]). Zumeist findet eine Hierarchisierung statt, deren unterstes Glied die Daten darstellen. Hierbei wird häufig die Semiotik als Strukturierungshilfe (Syntaktik – Semantik – Pragmatik) genutzt, die die allgemeine Lehre von den Zeichen, Zeichensystemen und Zeichenprozessen in das Gebiet der Informatik überträgt.

Abb. 1–1 Semiotisches Dreieck (in Anlehnung an [Hinrichs 2002, S. 27])

Auf syntaktischer Ebene werden lediglich die Zeichen sowie ihre mathematisch-statistischen Beziehungen untereinander (z.B. relative Häufigkeit innerhalb bestimmter Grundstrukturen) untersucht, ohne dabei auf die Bedeutung der Zeichen einzugehen. Diese maschinenlesbaren Zeichenfolgen (Daten) bilden somit die Informationen der realen Welt ab.

Wird den Daten Bedeutung hinzugefügt, gelangt man auf die semantische Ebene, d.h., die Daten werden in einem bestimmten Kontext gesehen, und man spricht von Information.

Auf der pragmatischen Ebene steht der direkte Benutzer (Interpreter) im Mittelpunkt der Untersuchungen, d.h., hier spielt die Wirkung von Information auf die sie verarbeitenden Verwender (Menschen, Maschinen) eine wichtige Rolle. Somit kommt die pragmatische Ebene der Wirklichkeit am nächsten, indem sie sich über die ersten zwei Ebenen hinausgehend noch mit Fragen der jeweiligen Absicht und des Werts für den einzelnen Benutzer befasst. Erst dann wird aus der Information Wissen.

Aus Gründen der besseren Lesbarkeit bezieht sich in den nachfolgenden Kapiteln dieses Buches der Begriff Datenqualität sowohl auf die Qualität der Daten als auch auf die Qualität der Informationen.

1.2 Qualität

Der Begriff Qualität stammt ab vom lateinischen »qualitas« und bedeutet Eigenschaft oder Beschaffenheit. Ursprünglich weder positiv noch negativ belegt, wird der Begriff in der Umgangssprache automatisch als positiv angesehen. Die Suche nach einer einheitlichen Definition führt zu einer Vielzahl von Definitions- und Interpretationsversuchen. Eine allgemein akzeptierte Begriffsbeschreibung ist die DIN-Norm 55 350. Danach ist die »Qualität die Gesamtheit von Eigenschaften und Merkmalen eines Produktes oder einer Tätigkeit, die sich auf deren Eignung zur Erfüllung festgelegter oder vorausgesetzter Erfordernisse beziehen« (vgl. [DIN 55350]).

Einer der ersten Systematisierungsansätze geht auf Garvin (vgl. [Garvin 1984, S. 40ff.]) zurück, der fünf generelle Qualitätsvorstellungen unterscheidet:

Produktorientierter Ansatz

Anwenderorientierter Ansatz

Prozessorientierter Ansatz

Wertbezogener Ansatz

Transzendenter Ansatz

Die produktbezogene Sicht entspricht einem objektiven Qualitätsbegriff, weil Qualität als eine messbare, genau spezifizierbare Größe, die das Produkt beschreibt, gesehen wird. Qualität stellt dabei eine objektive Größe dar, die unabhängig von subjektiven Wahrnehmungen bestimmt werden kann, d.h., dieser Ansatz bezieht sich nur auf das Endprodukt, unabhängig von den Kunden (Benutzern). Qualitätsdifferenzen lassen sich damit auf die Unterschiede in den Produkteigenschaften zurückführen.

Der kunden- oder anwenderbezogene Ansatz hingegen definiert die Qualität eines Produkts über den Produktnutzer, und somit entscheidet ausschließlich der Kunde, inwieweit das Produkt der geforderten Qualität entspricht (subjektive Beurteilung des Kunden). In die amerikanische Literatur hat dieser Ansatz Eingang über die Definition »fitness for purpose« oder »fit for use« gefunden. Dabei können verschiedene Endbenutzer unterschiedliche Bedürfnisse haben, sodass die Qualität des gleichen Produkts unterschiedlich bewertet werden kann.

Beim Herstellungsbezug (prozessorientierter Ansatz) wird angenommen, dass Qualität dann entsteht, wenn der Herstellungsprozess optimal und kontrolliert verläuft und alle Vorgaben (Produktspezifikationen) eingehalten werden. Abweichungen von dem definierten Prozess werden als Qualitätsverlust angesehen.

Der wertbezogene Ansatz betrachtet Qualität unter Kostengesichtspunkten. Ein Produkt ist dann von hoher Qualität, wenn die Kosten und die empfangene Leistung in einem akzeptablen Verhältnis stehen.

Der transzendente Ansatz kennzeichnet Qualität als vorgegebene Vortrefflichkeit, Einzigartigkeit oder Superlativ. Qualität wird als Synonym für hohe Standards und Ansprüche angesehen. Dieser Grundgedanke setzt ein philosophisches Verständnis voraus, das davon ausgeht, dass Qualität nicht messbar, sondern nur erfahrbar ist. Dieser Ansatz ist für den hier zu betrachtenden Kontext von Business Intelligence nicht geeignet.

Auch wenn die hier beschriebenen Ansätze für die Fertigungsindustrie entwickelt wurden, lassen sie sich ohne Weiteres auf den Bereich der Datenqualität übertragen, wie die folgenden Analogien zeigen (vgl. [Wang/Ziad/Lee 2001, S. 3f.]. Ein Datenverarbeitungsprozess kann auch als Herstellungsprozess im Sinne der Fertigungsindustrie gesehen werden. Die Datenquellen (Lieferanten), die die Rohdaten (Rohmaterialien) bereitstellen, bilden den Ausgangspunkt der Wertschöpfungskette. Sie werden im Zuge der Integration/Transformation (Produktionsprozess) bearbeitet. Das Ergebnis des Prozesses sind die Datenprodukte, die den Datenbeziehern (Kunden) zu Auswertungszwecken zur Verfügung gestellt werden.

Abb. 1–2 Analogie zwischen industrieller Fertigung und Datenverarbeitung (Data Warehousing) (in Anlehnung an [Grimmer/Hinrichs 2001, S. 72])

Der wesentliche Unterschied liegt im Betrachtungsgegenstand sowie dessen Qualitätsmerkmalen. Im industriellen Fertigungsprozess werden physische Produkte erstellt, die Merkmale wie Haltbarkeit, Länge und Gewicht aufweisen. Im dargestellten Kontext der Datenverarbeitung entspricht das Produkt einem bestimmten Ausschnitt des Datenbestands, auch als Datenprodukt (gleichbedeutend mit einem Datensatz) bezeichnet. Zur Bestimmung der Qualität wird einem Produkt eine Menge von Merkmalen zugeordnet. Ein Merkmal ist dabei eine Eigenschaft, die zur Unterscheidung von Produkten in qualitativer oder quantitativer Hinsicht herangezogen werden kann (vgl. [Behme 2002, S. 52]).

Während in der Industrie der Qualitätsbegriff seit Jahrzehnten einen wichtigen Platz einnimmt, taucht der Begriff Datenqualität erst Mitte der 1990er-Jahre vermehrt auf. Die Vorgaben zu Datenqualität liegen damit in ihrer Entwicklung hinter den im Kontext der industriellen Fertigung entwickelten Standards hinsichtlich Qualität deutlich zurück.

1.3 Datenqualität

Es gilt nun, aus den obigen allgemeinen Daten- und Qualitätsdefinitionen den Begriff der Datenqualität abzuleiten. Helfert hat die in der Literatur vorhandenen Ansätze zur Definition von Datenqualität untersucht und einander gegenübergestellt (vgl. [Helfert 2002, S. 69ff.] und [Helfert 2000, S. 62ff.]). Das Ergebnis dieser Untersuchung zeigt, dass der Anwender das Qualitätsniveau festlegt und damit im Kontext der Datenverarbeitung ausschließlich der anwenderorientierte Ansatz (vgl. [Müller 2000, S. 15; English 1999, S. 52ff.]) sinnvoll ist. Datenqualität wird daher nach Würthele definiert als »mehrdimensionales Maß für die Eignung von Daten, den an ihre Erfassung/Generierung gebundenen Zweck zu erfüllen. Diese Eignung kann sich über die Zeit ändern, wenn sich die Bedürfnisse ändern« (vgl. [Würthele 2003, S. 21]).

Diese Definition macht deutlich, dass die Qualität von Daten vom Zeitpunkt der Betrachtung sowie von dem zu diesem Zeitpunkt an die Daten gestellten Anspruchsniveau abhängt.

Um die Datenqualität letztendlich messbar zu machen, bedarf es objektiver Merkmale (auch Qualitätskriterien genannt), die den Daten (Datenprodukten) zugeordnet werden. Diese werden dabei aufgrund der praktischen Erfahrungen intuitiv definiert, auf Basis von Literaturrecherchen erstellt oder anhand von empirischen Untersuchungen zusammengestellt (vgl. [Helfert 2002, S. 69]). Die Qualitätskriterien müssen messbar sein, damit der jeweilige Erfüllungsgrad durch den Datennutzer ermittelt werden kann. In der Praxis wird es einen hundertprozentigen Erfüllungsgrad der Kriterien nicht geben, vielmehr sind jeweils anwendungs- oder kundenbezogene Anspruchsniveaus (Sollwerte) zu definieren, an denen die Datenqualität gemessen wird.

Beispielsweise gelten für Quartals- oder Jahresbilanzen im Bankenbereich, die kurzfristig nach Ablauf des jeweiligen Zeitraums an die Aufsichtsbehörden übermittelt werden, sehr hohe Ansprüche an die Genauigkeit und Aktualität. Dagegen sind bei Auswertungen zum Kundenverhalten geringere Anspruchsniveaus akzeptabel.

Tabelle 1–1 zeigt eine Übersicht über häufig genannte Datenqualitätskriterien (DQ-Kriterien) in alphabetischer Reihenfolge (in Anlehnung an [Helfert/Herrmann/Strauch 2001, S. 7]).

Aktualität

Allgemeingültigkeit

Alter

Änderungshäufigkeit

Aufbereitungsgrad

Bedeutung

Benutzbarkeit

Bestätigungsgrad

Bestimmtheit

Detailliertheit

Effizienz

Eindeutigkeit

Fehlerfreiheit

Flexibilität

Ganzheit

Geltungsdauer

Genauigkeit

Glaubwürdigkeit

Gültigkeit

Handhabbarkeit

Integrität

Informationsgrad

Klarheit

Kompaktheit

Konsistenz

Konstanz

Korrektheit

Neutralität

Objektivität

Operationalität

Performanz

Portabilität

Präzision

Problemadäquatheit

Prognosegehalt

Quantifizierbarkeit

Rechtzeitigkeit

Redundanzfreiheit

Referenzielle Integrität

Relevanz

Robustheit

Seltenheit

Sicherheit

Signifikanz

Testbarkeit

Unabhängigkeit

Überprüfbarkeit

Verdichtungsgrad

Verfügbarkeit

Verlässlichkeit

Verschlüsselungsgrad

Verständlichkeit

Vollständigkeit

Wahrheitsgehalt

Wiederverwendbarkeit

Wirkungsdauer

Zeitbezug

Zeitnähe

Zugänglichkeit

Zuverlässigkeit

Tab. 1–1 Liste möglicher Datenqualitätskriterien

Im Folgenden wird lediglich auf eine Auswahl der vorgestellten Qualitätskriterien näher eingegangen, da die Liste zum Teil Doppelungen enthält sowie nicht alle Kriterien als besonders geeignet erscheinen (vgl. [Hinrichs 2002, S. 30f.; Zeh 2009, S. 43f.]):

Datenqualitätskriterien

Definition

Korrektheit Fehlerfreiheit

Die Attributwerte eines Datensatzes (im Data Warehouse) entsprechen denen der modellierten Entitäten der realen Welt, d.h., die Daten stimmen mit der Realität überein.

Konsistenz

Die Attributwerte eines Datensatzes weisen keine logischen Widersprüche untereinander oder zu anderen Datensätzen auf. Inkonsistente Daten innerhalb der operativen Systeme führen zu massiven Glaubwürdigkeitsproblemen in den analytischen Systemen.

Zuverlässigkeit Nachvollziehbarkeit

Die Attributwerte sind vertrauenswürdig, d.h., die Entstehung der Daten ist nachvollziehbar. Insbesondere bei externen Daten ist auf die Zuverlässigkeit der Quellen zu achten. Aber auch innerhalb des Data Warehouse müssen die verschiedenen Transformationen der Daten nachvollziehbar sein. Dies beginnt bei der Erfassung der Daten und geht bis zur Erstellung der Berichte in den analytischen Systemen.

Vollständigkeit

Die Attributwerte eines Datensatzes sind mit Werten belegt, die semantisch vom Wert NULL (unbekannt) abweichen. Eine andere Definition bezieht sich auf den modellierten Ausschnitt der Welt. Alle wichtigen Entitäten, Beziehungen und Attribute müssen im System repräsentiert sein.

Vollständigkeit beschreibt auch die generelle Verfügbarkeit von Inhalten, die der Anwender benötigt, um seine Arbeit überhaupt durchführen zu können. Dies behandelt die Frage, ob beispielsweise alle Datenbereiche in den Business-Intelligence-Systemen integriert sind, um die Anforderungen zu erfüllen.

Des Weiteren beschreibt dieses Kriterium auch, ob die Daten komplett im ELT-Prozess oder im Fehlerfall in das Data Warehouse übernommen werden. Besonders schwierig ist dies beispielsweise bei tagesaktuellen Lieferungen aus verschiedenen Zeitzonen.

Genauigkeit

Abhängig vom jeweiligen Kontext liegen die Daten in der geforderten Genauigkeit (z.B. Anzahl Nachkommastellen) vor.

AktualitätZeitnäheZeitbezug

Alle Datensätze entsprechen jeweils dem aktuellen Zustand der modellierten Welt und sind damit nicht veraltet. Die Daten bilden die tatsächlichen Eigenschaften des Objekts zeitnah ab. Mangelnde Aktualität kann einerseits aus der Frequenz der Ladezyklen resultieren (z.B. wöchentlich statt täglich) oder durch die verspätete Pflege der Daten bereits im operativen System (z.B. keine regelmäßige Neubewertung von Sicherheiten).

Redundanzfreiheit

Innerhalb der Datensätze dürfen keine Duplikate vorkommen. Als Duplikate werden hierbei Datensätze verstanden, die dieselbe Entität in der realen Welt beschreiben. Sie müssen aber nicht notwendigerweise in allen Attributwerten übereinstimmen.

Relevanz

Der Informationsgehalt einer Datensatzmenge bezüglich eines definierten Anwendungskontextes deckt sich mit dem Informationsbedarf einer Anfrage.

Einheitlichkeit

Die Repräsentationsstruktur einer Menge von Datensätzen ist einheitlich, d.h., sie werden fortlaufend gleich abgebildet.

Eindeutigkeit

Ein Datensatz muss eindeutig interpretierbar sein, d.h., die vorhandenen Metadaten müssen die Semantik des Datensatzes festschreiben.

Verständlichkeit

Die Datensätze stimmen in ihrer Begrifflichkeit und Struktur mit den Vorstellungen des Fachbereichs überein.

Schlüsseleindeutigkeit

Die Primärschlüssel der Datensätze sind eindeutig.

Referenzielle Integrität

Im relationalen Modell muss jeder Fremdschlüssel eindeutig auf einen existierenden Primärschlüssel referenzieren.

Tab. 1–2 Definition ausgewählter Datenqualitätskriterien

Die beiden letzten Kriterien stellen eine spezielle Ausrichtung auf das relationale Datenbankmodell dar. Aufgrund der sehr starken Verbreitung des relationalen Modells ist diese Sichtweise legitim.

Die sechs DQ-Kriterien Korrektheit, Konsistenz, Zuverlässigkeit, Vollständigkeit, Zeitnähe und Relevanz werden in Abschnitt 2.3 nochmals aufgegriffen und im Kontext Business Intelligence näher betrachtet.

Das folgende Beispiel (in Anlehnung an [Leser/Naumann 2007, S. 354f.]) aus dem BI-Umfeld verdeutlicht die Relevanz der DQ-Kriterien Vollständigkeit, Zeitnähe und Glaubwürdigkeit. Als Entscheidungsgrundlage für das Management eines Industrieunternehmens werden regelmäßig aus einem Data Warehouse Berichte erstellt:

Diese Berichte müssen Daten aus allen Werken vollständig abdecken, sonst sind die Produktionszahlen ungenau.

Die Berichte müssen zeitnah abrufbar sein, sonst kann nicht schnell genug bei einer veränderten Absatzlage reagiert werden.

Wenn die Zahlen in den Berichten nicht stimmen, weil in der Vergangenheit nachträglich viele Daten manuell geändert wurden, sind die Kennzahlen unglaubwürdig, und die Akzeptanz der BI-Lösung sinkt.

Dieses Beispiel zeigt deutlich, dass Datenqualität stets mehrdimensional zu betrachten ist. Wird die Datenqualität auf ein einzelnes Kriterium (wie beispielsweise Vollständigkeit) reduziert, wird die Datenqualität von den Anwendern dennoch gefühlt als schlecht wahrgenommen, wenn veraltete Daten vorliegen (DQ-Kriterium Zeitnähe).

Werden die hier vorgestellten DQ-Kriterien strukturiert in Gruppen zusammengefasst, spricht man von einem Qualitätsmodell. Ein wesentliches Charakteristikum eines solchen Modells ist die Zerlegungssystematik. In der Literatur sind diverse Systematiken zu finden (vgl. [Wang/Strong 1996, S. 20; Redman 1996, S. 267]), die bei genauerer Betrachtung gewisse Unstimmigkeiten bezüglich der Zerlegung aufweisen. Ziel dieses Kapitels ist es jedoch nicht, diese Lücke durch ein eigenes Modell zu schließen. Daher sei an dieser Stelle beispielhaft zunächst das Qualitätsmodell von Hinrichs vorgestellt, das sich aus den beschriebenen Qualitätskriterien ableiten lässt:

Abb. 1–3 Taxonomie von Datenqualitätskriterien (vgl. [Hinrichs 2002, S. 30])

Diesem eher aus theoretischer Sicht entstandenen Qualitätsmodell stellt die Deutsche Gesellschaft für Informations- und Datenqualität (DGIQ) eine Kategorisierung gegenüber, die aus einer Studie (vgl. [Wang/Strong 1996]) durch Befragung von IT-Anwendern hervorgegangen ist (siehe Abb. 1–4).

Abb. 1–4 Taxonomie von Datenqualitätskriterien (vgl. [DGIQ 2007])

Ergänzend zu den bereits beschriebenen Kriterien sind vor allem die Zugänglichkeit und die Bearbeitbarkeit hinzugekommen. Unter Zugänglichkeit wird die einfache Abrufbarkeit der Daten für den Anwender verstanden. Inwieweit die Daten leicht für unterschiedliche Zwecke zu bearbeiten sind, wird mit dem Kriterium Bearbeitbarkeit ausgedrückt.2

Die Identifikation und Klassifikation von Datenqualitätskriterien allein reicht für die Messung der Datenqualität allerdings nicht aus. Was fehlt, sind konkrete, numerische Metriken. Nur darüber kann später geprüft werden, ob die Verbesserungsmaßnahmen auch wirkungsvoll waren (»You cannot control what you cannot measure« (vgl. [deMarco 1982])).

Die Anwendung geeigneter Metriken ermöglicht eine Quantifizierung von Datenqualitätskriterien und ist somit die Voraussetzung zur Bildung von Qualitätskennzahlen. In Kapitel 7 wird genauer auf die Bildung dieser Kennzahlen auf Basis ausgewählter DQ-Kriterien eingegangen.

1.4 Datenqualitätsmanagement

Das nachträgliche Bereinigen von Daten, das durch eine Vielzahl an existierenden Werkzeugen zur Fehlererkennung und -korrektur erleichtert wird, ist im Vergleich zu qualitätssichernden Maßnahmen um den Faktor 5–10 teurer (vgl. [Hankins 1999]). Trotzdem finden in den Unternehmen kaum präventive Maßnahmen statt, sondern es wird erst beim Auftreten von Problemen reagiert (vgl. [Otto et al. 2008, S. 215f.]).

Dieses reaktive Vorgehen führt u.a. dazu, dass Risiken nicht rechtzeitig erkannt werden oder gesetzliche Auflagen nicht zu erfüllen sind (siehe Abschnitt 3.2). Erst langsam kommt es in den Unternehmen zu einem Sinneswandel und somit zu einem proaktiven Ansatz mit einem Datenqualitätsmanagement, das von vornherein auf qualitativ hochwertige Daten setzt und kostenintensive nachträgliche Bereinigen minimiert.

Das dazu erforderliche Qualitätsmanagement umfasst nach DIN ISO 8402 »alle Tätigkeiten der Gesamtführungsaufgabe, die die Qualitätspolitik, -ziele und -verantwortung festlegen sowie durch Mittel wie Qualitätsplanung, -lenkung, -sicherung und -verbesserung im Rahmen des Qualitätsmanagementsystems verwirklichen« (vgl. [DIN ISO 8402]). Hieraus wird deutlich, dass das Qualitätsmanagement in der Gesamtstrategie des Unternehmens verankert sein muss. Diese aus heutiger Sicht sinnvolle Definition entwickelte sich in der Historie seit Beginn des 20. Jahrhunderts gemäß Abbildung 1–5 in vier Stufen:

Abb. 1–5 Entwicklungsstufen des Qualitätswesens (in Anlehnung an [Wolf 1999, S. 63])

In der ersten Stufe (Qualitätskontrolle) wurde eine klare Trennung zwischen der Produktion und der Qualitätskontrolle vorgenommen, d.h., festgestellte Mängel konnten erst nachträglich am bereits fertigen Produkt erkannt und bereinigt werden. Erst in den 1930er-Jahren wurde die Qualitätskontrolle in den Produktionsprozess integriert. Damit war es möglich, die Fehler während des Prozesses am Entstehungsort zu beheben (Qualitätssicherung). In den 1960er-Jahren setzte sich zunehmend die Erkenntnis durch, dass sich durch die prozessbegleitenden Maßnahmen nicht alle Fehlerquellen abstellen lassen. Daher wurde das Qualitätswesen sowohl auf die vorgelagerten Bereiche wie Forschung & Entwicklung oder Konstruktion als auch auf die nachgelagerten Bereiche wie den Vertrieb ausgedehnt. Geprägt wurde diese Stufe durch Feigenbaum (vgl. [Feigenbaum 1961]), der den Begriff »Total Quality Control« einführte. Die ständige Weiterentwicklung der Konzepte führte zu dem heute bekannten, ganzheitlichen Qualitätsmanagement (Total Quality Management), das in der Gesamtstrategie des Unternehmens integriert sein muss.

Für den Aufbau eines Qualitätsmanagements (QM) sind vor allem die Bereiche Qualitätsplanung und -lenkung von Interesse (vgl. [English 1999, S. 70ff.]). Aufgabe der Qualitätsplanung ist es, die Qualitätsanforderungen an den Prozess und das Produkt in überprüfbarer Form festzulegen. Dies beinhaltet die Auswahl von Qualitätskriterien sowie die Festlegung von Sollwerten (Anspruchsniveaus) für diese Kriterien. Die Qualitätslenkung, zu der Arbeitstechniken und Tätigkeiten gehören, die zur Erfüllung der Qualitätsanforderungen angewendet werden, setzt die Qualitätsplanung um. Dazu müssen geeignete Prozesse identifiziert und Maßnahmen zum Erreichen einer Prozesskonformität ergriffen werden. Produkt-und Prozessqualität müssen im Rahmen der Qualitätslenkung gemessen werden (vgl. [Helfert 2002, S. 40ff.]). Die Qualitätssicherung umfasst vor allem organisatorische Maßnahmen, die nach außen sicherstellen sollen, dass im Unternehmen ein Qualitätsmanagement existiert.

Die Ausführungen zum Qualitätsmanagement lassen sich auf ein Datenqualitätsmanagement (DQM) für den Datenverarbeitungsprozess übertragen. Besonders erwähnenswert sind in diesem Zusammenhang die Arbeiten von Wang (vgl. [Wang 1998; Wang/Strong 1996]) am Massachusetts Institute of Technology (MIT), der eine Adaption der QM-Konzepte unter der Bezeichnung Total Data Quality Management (TDQM) entwickelte. Der Grundgedanke seiner Methode ist der sogenannte Plan-Do-Check-Act-Zyklus, der die Ideen von Deming als Regelkreis beschreibt (siehe Abb. 1–6).

Abb. 1–6 Plan-Do-Check-Act-Zyklus (vgl. [Redman 1996])

Tab. 1–3 Vergleich ausgewählter DQM-Strategien

Der Zyklus beginnt mit der Definition der Datenqualitätsziele (Plan). Anschließend wird der Istzustand der Daten aufgenommen und analysiert (Do, Check). Im letzten Schritt muss durch den Einsatz geeigneter Methoden die Datenqualität verbessert werden (Act).

Das Konzept des TDQM wurde u.a. von English (vgl. [English 1999, S. 69ff.]) weiterentwickelt, der eine Vorgehensweise zur kontinuierlichen Datenqualitätsverbesserung einführte (siehe Abb. 1–7).

Abb. 1–7 Total-Quality-data-Management-Methodik (TQdM) nach English (vgl. [English 1999, S. 70])

Neben der bereits erwähnten Erweiterung gibt es in der wissenschaftlichen Literatur eine Vielzahl von Arbeiten, die sich mit dem Thema Datenqualitätsmanagement, basierend auf den Gedanken von Wang, auseinandersetzen. Die wichtigsten sind in Tabelle 1–3 aufgeführt (vgl. [Behme/Nietzschmann 2005, S. 46]).

Bei der Betrachtung der einzelnen Strategien zeigt sich, dass entweder ein eher technisch orientierter Ansatz gewählt wurde oder der Fokus auf dem Managementkonzept liegt. Einig ist man sich aber, dass die technisch orientierten Ansätze nicht ohne ein begleitendes Managementkonzept möglich sind.

Für die Umsetzung eines Datenqualitätsmanagements für ein Data-Warehouse-System lassen sich drei Bereiche identifizieren (vgl. [Helfert/Herrmann/Strauch 2001, S. 19]):

Datenqualität als Unternehmenskultur und -philosophie ist als Verpflichtung des Managements anzusehen.

Ein Qualitätsmanagementsystem (nach ISO 8402) ist zu etablieren, das in allen Bereichen geeignete Prozesse, Richtlinien, Pläne sowie Test- und Prüfverfahren aufsetzt, um die geforderte Datenqualität dauerhaft zu erreichen.

Zur Ausübung der Qualitätsprozesse sind geeignete Methoden, Verfahren und Werkzeuge zur Verfügung zu stellen.

Auf Basis der bestehenden Datenqualitätsmanagement-Ansätze haben Otto u.a. einen Ordnungsrahmen entwickelt, der dem Ansatz des Business Engineering folgt (vgl. [Otto et al. 2008, S. 215ff.]). Dieser Ordnungsrahmen setzt sich aus den folgenden sechs Gestaltungselementen zusammen:

Datenqualitätsstrategie

Führungssystem

Data Governance

Datenmanagement-Prozesse

Datenarchitektur und Datenhaltung

Systemunterstützung

Den Aufbau des Ordnungsrahmens zeigt Abbildung 1–8. Die Datenqualitätsstrategie befindet sich auf der Ebene »Strategie«, wodurch die enge Verzahnung mit der Unternehmensstrategie deutlich wird. Zwischen den Ebenen »Strategie« und »Organisation« liegt das Führungssystem, das die Umsetzung der Strategie steuert. Die Ebene »Organisation« enthält zum einen die Data Governance (Zuordnung der Aufgaben und Verantwortlichkeiten im Rahmen des DQM) sowie die Datenmanagement-Prozesse (umfasst die Prozesse Anlage, Pflege und Ausphasen der Daten). Auf der Ebene »Systeme« wird im Rahmen der Datenarchitektur der Geltungsbereich für einzelne Datenobjekte definiert (z.B. globale versus lokale Lieferantennummer). Außerdem legt die Datenarchitektur fest, welche Rolle die Systeme bei der Anlage, Änderung und Verteilung der Stammdaten spielen.

Abb. 1–8 Ordnungsrahmen für das Datenqualitätsmanagement (vgl. [Otto et al. 2008, S. 218])

1.5 Zusammenfassung

Die Ausführungen in diesem Kapitel machen deutlich, dass die Anforderungen an die Datenqualität jeweils von dem Unternehmen und insbesondere von den Anwendern der Daten abhängen. Eine allgemein gültige Festlegung, was eine gute Datenqualität im Rahmen von Business-Intelligence-Lösungen ausmacht, gibt es nicht.

Um Datenqualität aber nicht nur als abstraktes Gebilde stehen zu lassen, wurde mithilfe der Datenqualitätskriterien eine Operationalisierung vorgenommen. Die Aufgabe im konkreten Projekt besteht darin, eine Auswahl dieser Kriterien zu treffen und jeweils auf das Unternehmen und den Projekthintergrund passende Anspruchsniveaus festzulegen und diese zu realisieren.

Insgesamt wird auch deutlich, dass Datenqualität keine Einmal-Aktion im Rahmen eines Projekts ist, sondern vielmehr als eine permanente Aufgabe angesehen werden muss. Dazu ist bei den Mitarbeitern ein Bewusstsein für Datenqualität zu schaffen sowie die Motivation, diese auch herzustellen. Nur so kann langfristig und nachhaltig eine bessere Datenqualität sichergestellt werden.

2 Ausprägungen und Ursachen schlechter Datenqualität

Die Zielsetzung dieses Kapitels ist es, ein grundlegendes Verständnis für wesentliche Ursachen und Ausprägungen schlechter Datenqualität zu schaffen. Die Ausführungen beziehen sich dabei auf den in Kapitel 1 eingeführten Begriff der anwenderorientierten Qualitätsvorstellung. Wie in diesem einführenden Kapitel beschrieben, basiert die nachgefragte Qualität von Daten einerseits auf den subjektiven Anforderungen der Anwender und hängt andererseits wesentlich von der Anforderung der beabsichtigten Anwendung ab. Regulatorische Anforderungen haben oftmals andere Qualitätsansprüche als z.B. Marketing-Anwendungen.

Auf Business-Intelligence-Projekte bezogen ist diese Sichtweise der anwenderorientierten Qualitätsvorstellung sicherlich am besten geeignet, da sich die Qualität der Daten unmittelbar auf die dort entwickelten Anwendungen auswirkt. Dieses Kapitel behandelt nun im Folgenden die Ursachen und Auswirkungen schlechter Datenqualität basierend auf Erfahrungen aus solchen Projekten.

Business-Intelligence-Projekte und deren Ergebnisse stellen in vielen Fällen den erstmaligen Kontakt der Anwender mit den Daten dar; den Anwendern eröffnet dies oftmals eine komplett neue Sichtweise auf die Daten bzw. ermöglicht erstmals eine Verknüpfung verschiedener Bestände von Daten. Damit einher geht jedoch die Unsicherheit bezüglich der Datenqualität aufgrund fehlender Vergleichsmöglichkeiten bzw. großer Datenvolumina, die manuell nicht mehr überprüfbar sind. Dies kann in letzter Konsequenz dazu führen, dass die Akzeptanz von Business-Intelligence-Projekten massiv unter schlechter Datenqualität oder auch nur unter subjektiv wahrgenommenen Datenqualitätsproblemen leidet (vgl. [Friedman/Richardson 2008]).

Business-Intelligence-Anwendungen sind zudem meist das letzte Glied in der Kette der Datenaufbereitung und -bereitstellung. Aus diesem Grund scheitern Business-Intelligence-Projekte oftmals wegen fehlender Akzeptanz durch die Anwender. Daher ist es für eine erfolgreiche Umsetzung solcher Projekte unumgänglich, bei den Projektsponsoren und potenziellen Anwendern frühzeitig ein Verständnis für die Ursachen und Auswirkungen schlechter Datenqualität aufzubauen.

Die Capgemini-Studie »IT Trends 2011« (vgl. [Capgemini 2011]) zeigt, dass Datenqualität für Unternehmen zu den Top-5-Themen im IT-Umfeld gehört. Im Rahmen dieser Studie wurde Datenqualität bereits das fünfte Jahr in Folge als eines der am höchsten priorisierten Themen genannt. IT-seitig ist also laut dieser Studienreihe die Wichtigkeit von Datenqualität für die erfolgreiche Umsetzung von IT- und somit letztendlich auch von Geschäftsinitiativen zumindest weitestgehend bekannt.

Eine Sensibilisierung der Endanwender für die Ursachen und Auswirkungen schlechter Datenqualität und in letzter Konsequenz für den Umgang damit ist als ein wesentlicher Schritt zum Projekterfolg dringend zu empfehlen. Diese Problematik ist bereits im Vorfeld von Projekten zu berücksichtigen, und es sind Maßnahmen aufzuzeigen, um negativen Auswirkungen entgegenzusteuern.

Es kommt dabei allerdings erschwerend hinzu, dass die Ursachen schlechter Datenqualität sehr vielfältig sind und deren Vermeidung oftmals auch unter größtmöglichen Anstrengungen nicht immer durchgängig möglich ist. Auch aus diesem Grund ist eine dahingehende frühzeitige Sensibilisierung der Anwender ein wichtiger Baustein für die erfolgreiche Umsetzung von Business-Intelligence-Projekten.

2.1 Geschäftstreiber

Eine schlechte oder auch nur unzureichende Datenqualität hat Auswirkungen auf viele unterschiedliche Bereiche in Unternehmen bzw. in Organisationen1 generell. Eine Verbesserung der Datenqualität ist deshalb ein wünschenswertes Unterfangen, das prinzipiell auf wenig Widerstand trifft. In der Praxis ist die Sicherung der Datenqualität jedoch eine komplexe und oftmals sehr aufwendige Angelegenheit.

Budget- und Ressourcenbeschränkungen sind in den meisten Organisationen die Realität. Es sind daher in jedem Fall Kosten-Nutzen-Betrachtungen anzustellen, um eine Argumentation hinsichtlich der Mittelbereitstellung aufzubauen. Diese Kosten-Nutzen-Betrachtungen können dabei sowohl quantitativer als auch qualitativer Natur sein (siehe Kap. 3).

In diesem Abschnitt sind im Folgenden vier Kategorien2 von Geschäftstreibern beschrieben, die ein aktives Management der Datenqualität erfordern. Diese Geschäftstreiber geben oftmals den initialen Anstoß zur Verbesserung mangelhafter Datenqualität.

Zudem erfordern die zunehmende Integration von Geschäftsprozessen und Anwendungen über Abteilungsgrenzen hinweg (und immer öfter auch über Unternehmensgrenzen hinweg) sowie Ansätze wie Serviceorientierte Architekturen (SOA), die Einbindung von Business Intelligence in operative Prozesse (operational BI) und Right Time Business Intelligence saubere Daten. Während einer Right-Time-Datenintegration bleibt schlichtweg keine Zeit mehr für die Durchführung umfassender Datenqualitätsmaßnahmen. Viele Unternehmen gehen derzeit dazu über, mittels Informationen aus Right-Time-Business-Intelligence-Anwendungen operative Geschäftsprozesse zu unterstützen, und erkennen dabei unmittelbar die Wichtigkeit einer entsprechenden hohen Datenqualität.

Abbildung 2–1 zeigt nun vier Geschäftstreiber, die direkt durch die Qualität der Daten beeinflusst werden und somit eine der geplanten Anwendung3 entsprechende, akzeptable Datenqualität speziell im Rahmen der Datenbereitstellung durch Business-Intelligence-Anwendungen voraussetzen.

Abb. 2–1 Datenqualität beeinflusst Geschäftstreiber.

Diese vier Geschäftstreiber sind grundsätzlich unabhängig von bestimmten Branchen oder Unternehmen, hängen allerdings oftmals direkt mit Business-Intelligence-Projekten bzw. mit der Datenbereitstellung und Datenverwendung generell zusammen. Aus den diversen Anforderungen dieser Geschäftstreiber heraus entsteht daher in weiterer Folge die Forderung nach einem nachhaltigen und ganzheitlichen Datenqualitätsmanagement.

Compliance

Externe regulatorische Vorgaben sowie die interne Revision erfordern die Definition und die Umsetzung einheitlicher Standards und Mechanismen für ein aktives Datenqualitätsmanagement. Wesentliche Zielsetzung dabei ist die Etablierung unternehmensweiter Richtlinien und Strukturen zur Sicherstellung der Datenqualität bzw. zur Standardisierung des Umgangs mit schlechter Datenqualität und auftretenden Datenqualitätsproblemen.

Regulatorische Vorgaben sind zum Beispiel der Sarbanes-Oxley Act, die International Financial Reporting Standards (IFRS) sowie Basel-II-Vorgaben für Finanzdienstleistungen. Im Zuge der jüngsten Turbulenzen auf den Finanzmärkten wurden weitere regulatorische Anforderungen definiert bzw. bereits verabschiedet, die von den Unternehmen zu erfüllen sind (Dodd-Frank Act, Basel III) und die ebenfalls eine entsprechende Qualität der Daten voraussetzen (siehe auch Abschnitt 3.2).

Kosten und Risiken

Das Erkennen und die frühzeitige Behebung von Datenqualitätsproblemen sowie ein laufendes aktives Datenqualitätsmanagement reduzieren das tägliche operative Risiko in den Unternehmen. Speziell betrifft das operative Geschäftsprozesse, die auf qualitativ hochwertige Daten aus den Business-Intelligence-Anwendungen4 angewiesen sind.

Das aktive Beheben schlechter Datenqualität mindert generell die Projektrisiken und führt zu geringeren Kosten bzw. zu reduzierten Durchlaufzeiten von Projekten (insbesondere auch von Business-Intelligence-Projekten). Besonders betroffen sind dabei die Entwicklungen von Schnittstellen und Datenmigrationen zwischen Anwendungen. Dies ist insbesondere relevant, da die Forderung nach immer agileren und schnelleren Projekten keine Zeit für projektinterne Datenqualitätsmaßnahmen mehr lässt.

Während auf der einen Seite eine zu niedrige Eigenkapitalhinterlegung im Finanzsektor aus regulatorischer Sicht problematisch ist, bedeutet auf der anderen Seite eine zu hohe Eigenkapitalhinterlegung erhöhte Kosten für das Unternehmen. In jedem Fall ist die Qualität der Daten daher ein wesentlicher Einflussfaktor für die korrekte Kalkulation.

Wettbewerb

Im täglichen Wettbewerb (vgl. [Davenport/Harris 2007]) um den Kunden ist eine dem Verwendungszweck entsprechende Datenqualität Voraussetzung, z.B. für den Erfolg von Kampagnen sowie bei der effizienten Entwicklung neuer Produkte. Für eine Verbesserung der Kundenbeziehung ist eine hohe Qualität der Daten ebenso förderlich (z.B. durch eine korrekte Anrede). Im Customer-Service-Bereich erhöht eine gesicherte Datenqualität zudem die Chancen für ein erfolgreiches Cross Selling von Produkten und Leistungen.

Jene Anwendungen, die sich hinter dem Schlagwort Big Data verbergen, fallen insbesondere auch unter diese Kategorie. Speziell sind dies die Verarbeitung und Analyse von unstrukturierten und semistrukturierten Daten zum besseren Verständnis und zur Voraussage des Kundenverhaltens sowie die Integration in die bestehende BI-Architektur der Unternehmen. Dadurch ergeben sich erweiterte Anforderungen an ein aktives Datenqualitätsmanagement (siehe Kap. 6).

Speziell zu erwähnen ist in diesem Zusammenhang auch das immer stärkere Aufkommen von mobilen Applikationen und sogenannten Location Based Services (vgl. [Economist 2012a]). Diese Services sind gelinde gesagt unbrauchbar, wenn die auf den Karten dargestellten Informationen nicht eine entsprechende Qualität haben.

Steuerung

Für die Unternehmenssteuerung verantwortliche Personen müssen sich auf die Qualität der bereitgestellten Informationen verlassen können, da diese eine unmittelbare Auswirkung auf die Qualität der Entscheidungen im Unternehmen hat. Unter diesen Punkt fallen im Gegensatz zu den kurz- bis mittelfristigen Sichtweisen der anderen Kategorien vor allem Entscheidungen, die die mittel- bis langfristige Ausrichtung des Unternehmens beeinflussen.

Merger & Acquisition-Aktivitäten erfordern ebenfalls eine hohe Qualität der Daten, da die erfolgreiche und zugleich effiziente Zusammenführung unterschiedlicher Unternehmen davon abhängig ist.

Fazit

Wie einleitend bereits erwähnt, ist die Wahrnehmung der Qualität der Daten durch den jeweiligen Anwender weitestgehend subjektiv bestimmt bzw. durch die beabsichtigte Anwendung vorgegeben. Dieselben Daten können für verschiedene Anwender unterschiedliche Qualität besitzen. Dies kann durchaus bedeuten, dass eine für einen Anwender (z.B. aus dem externen Rechnungswesen/Wirtschaftsprüfer) schlechte Datenqualität einer ausreichenden bis guten Datenqualität für einen anderen Anwender (zum Beispiel aus dem Vertrieb für Kampagnenmanagement) entspricht bzw. auch umgedreht.

Diese Unterscheidung ist gerade im Umfeld von Business-Intelligence-Projekten von außerordentlicher Wichtigkeit. Eine 100-prozentige Qualität aller Daten ist praktisch mit vertretbarem Aufwand nicht erreichbar. Der Grad der benötigten Qualität ist daher immer in Abhängigkeit von der beabsichtigten Anwendung zu evaluieren und zu entscheiden. Bei einer mehrfachen Verwendung von Datenbereichen durch verschiedene Anwendungen mit teils unterschiedlichen Datenqualitätsanforderungen ist die unternehmensweite Kommunikation von Datenqualitätsproblemen essenziell (siehe Kap. 4).

Eine frühzeitige Verifikation der Qualität der Daten sowie die zeitgerechte Einbindung der betroffenen Anwender und die Einleitung von Gegenmaßnahmen ist daher eine wesentliche Voraussetzung, um die Auswirkungen schlechter Datenqualität auf die diversen Geschäftstreiber in den Griff zu bekommen.

2.2 Ausprägungen schlechter Datenqualität

Wie kann Datenqualität nun ausgedrückt werden?

Die oben beschriebenen Geschäftstreiber erfordern jeweils eine bestimmte Qualität der Daten. Die Ausprägungen von als schlecht wahrgenommener Datenqualität lassen sich anhand der bereits in Kapitel 1 definierten Datenqualitätskriterien festmachen. Die in diesem Kapitel ausgewählten Ausprägungen schlechter Datenqualität bzw. deren Auswirkungen in der realen Welt sind insbesondere im Rahmen verschiedener Business-Intelligence-Projekte sehr stark von den jeweiligen Anwendern reklamiert worden.

Der Anspruch dieses Kapitels ist nun keineswegs eine generelle Definition und Auflistung aller möglichen Ausprägungen schlechter Datenqualität. Der Fokus liegt hier speziell auf jenen Datenqualitätskriterien, deren Verwendung sich insbesondere in Business-Intelligence-Projekten bewährt hat.

Die Darstellung in Abbildung 2–2 beschränkt sich daher auf die wesentlichen Ausprägungen schlechter Datenqualität, dargestellt mittels sechs ausgewählter Datenqualitätskriterien. Die Abbildung zeigt, dass von BI-Projekten und somit auch von den beabsichtigten Anwendungen ein bestimmter Druck zur Sicherstellung einer gewissen Datenqualität ausgeht. Um die entsprechende nachgefragte Datenqualität auch bereitstellen zu können, ist im Kern ein aktives Datenqualitätsmanagement notwendig.

Abb. 2–2 Datenqualitätskriterien aus Sicht der Anwendung

Im Folgenden sollen beispielhaft die Inhalte dieser sechs Datenqualitätskriterien beschrieben werden. Zielsetzung dabei ist es, ein besseres Verständnis für die unterschiedlichen Ausprägungen schlechter Datenqualität im Umfeld von Business-Intelligence-Projekten zu schaffen.

Zeitnähe

Zeitnähe hat aus Sicht der Anwender von Business-Intelligence-Systemen grundsätzlich zwei Ausprägungen, die die subjektiven Anforderungen an die Qualität der Daten beeinflussen.

Einerseits ist dies der Anlieferungszeitpunkt der Daten aus den Quellsystemen bzw. der Zeitpunkt der Verfügbarkeit der Daten für den Anwender in den Business-Intelligence-Systemen. Daten besitzen aus Sicht der Anwendung dann eine schlechte Qualität, wenn sie nicht zu dem vom Anwender benötigten Zeitpunkt zur Verfügung stehen. Dieses Problem potenziert sich mit der Verknüpfung von Daten verschiedener Bereitstellungszeitpunkte.

Die zweite Ausprägung betrifft die Aktualität der angelieferten Daten. Darunter fällt zum Beispiel die Aktualität der Pflege von Telefon- und Adressdaten. Ein anderes aktuelles Beispiel aus dem Einsatzfeld von Banken ist die regelmäßige Neubewertung von Sicherheiten für Kredite.

Korrektheit

Das Datenqualitätskriterium Korrektheit beschreibt die inhaltliche und formale Komponente der Daten. Korrekte Daten beinhalten die inhaltlich richtigen Informationen in den vordefinierten Formaten der Attribute. Somit müssen zum Beispiel die Geburtsdaten von Personen nicht nur inhaltlich richtig sein, sondern die Anlieferung hat auch im vordefinierten Datenformat (z.B. ttmmjjjj) zu erfolgen.

Die bereitgestellten Informationen in den Anwendungen bilden somit die reale Welt im vordefinierten Format ab.

Konsistenz

Die Konsistenz bzw. die Inkonsistenz von Daten stellt gerade im Umfeld von Business-Intelligence-Anwendungen oftmals ein massives Problem hinsichtlich der Wahrnehmung schlechter Datenqualität dar. Die Inkonsistenz selbst kann dabei praktisch an jeder Stelle im Rahmen der Datenverarbeitung, beginnend bei der Datenerfassung, entstanden sein. Konsistenz in diesem Zusammenhang bezieht sich dabei in erster Linie auf die Übereinstimmung bzw. auf die vorhandene Möglichkeit zum Abgleich von Daten aus verschiedenen analytischen und operativen Anwendungen.

Dieses Kriterium zielt auf die Widerspruchsfreiheit der Daten aus unterschiedlichen Anwendungen ab. Inkonsistente Daten führen zu inkonsistenten Berichten und zu einem Glaubwürdigkeitsproblem für die gesamte Business-Intelligence-Anwendung.

Zuverlässigkeit

Das Kriterium Zuverlässigkeit beschreibt die ausreichende Verfügbarkeit von Informationen, um die ursprüngliche Herkunft und die verschiedenen Transformationen der Daten nachvollziehen zu können. Dies beginnt bei der initialen Erfassung der Daten und geht hin bis zur Erstellung der Berichte aus den BI-Anwendungen5 heraus. Hier ist insbesondere das Thema Metadatenmanagement zu erwähnen (siehe Kap. 14).

Zur Vertrauensbildung trägt die sogenannte Reconciliation bei. Reconciliation beschreibt in diesem Zusammenhang den Abgleich von Daten aus unterschiedlichen Datenquellen. Im Speziellen ist mit diesem Begriff der Abgleich von Detaildaten aus dem Data Warehouse mit Daten aus dem Hauptbuch des Buchhaltungssystems gemeint.

Relevanz

Relevanz beschreibt, inwieweit das Informationsangebot der Anwendungen mit dem Informationsbedarf der Anwender übereinstimmt. Eine 100-prozentige Qualität der bereitgestellten Daten ist aus Sicht der Anwender unzureichend, wenn die bereitgestellten Daten nicht benötigt werden bzw. andere Daten vonnöten sind. Die Relevanz beschreibt somit die generelle Verfügbarkeit von Inhalten, die der Anwender benötigt, um seine Aufgaben vollständig erfüllen zu können. Dies führt zu der Frage, ob z.B. alle wesentlichen Datenbereiche in den Business-Intelligence-Systemen integriert sind, um die Anforderungen der Anwender erfüllen zu können. Semantische Datenmodelle können hier bei der Kommunikation zwischen den Geschäftsbereichen und der IT zu Hilfe genommen werden.

Vollständigkeit

Die Vollständigkeit der Daten hat wiederum zwei Ausprägungen. Einerseits kennzeichnet dieses Kriterium die Vollständigkeit der übermittelten Daten zwischen den Anwendungen, das bedeutet, es sind im Zuge der Transformationen keine Daten verloren gegangen. Andererseits bezeichnet das Datenqualitätskriterium Vollständigkeit die vollständige Befüllung der angelieferten Attribute mit Daten, d.h., die einzelnen Attribute beinhalten keine NULL-Werte.

2.3 Ursachen schlechter Datenqualität

Was sind nun die Ursachen schlechter Datenqualität? Wie kann schlechte Datenqualität überhaupt entstehen?

Ebenso wie die Ausprägungen sind auch die Ursachen schlechter Datenqualität grundsätzlich sehr vielfältig. Gerade im Rahmen von Business-Intelligence-Projekten ist es wesentlich, die Ursachen zu verstehen, um diese rechtzeitig adressieren zu können. Davon ist in vielen Fällen der Erfolg dieser Projekte abhängig.

Bevor nun detaillierter auf verschiedene Kategorien von Ursachen eingegangen wird, sei noch der Einflussfaktor Unternehmenskultur (vgl. [Friedman 2012]) erwähnt. Unternehmen mit einem hohen Qualitätsbewusstsein und laufenden Qualitätsprogrammen werden im Durchschnitt weniger Datenqualitätsprobleme haben als Unternehmen, die diesen Themen tendenziell eher teilnahmslos gegenüberstehen. Wie in vielen anderen Belangen auch beginnt dies mit der Einstellung und der Vorbildwirkung der Unternehmensleitung.

Abb. 2–3 Ursachen schlechter Datenqualität

Abbildung 2–3 gibt in sechs Kategorien zusammengefasst einen ersten Überblick über eine Auswahl von wesentlichen Ursachen schlechter Datenqualität, deren Auswirkungen insbesondere in Business-Intelligence-Projekten bzw. in den Anwendungen häufig zutage treten.

Datenerfassung

Die initiale Eingabe der Daten ist eine der wesentlichsten Quellen für das Auftreten schlechter Datenqualität. Die verschiedenen Ursachen für Fehler bei der Erfassung der Daten sind vielfältig. Dies beginnt bei einfachen Benutzerfehlern und geht hin bis zu fehlenden Ressourcen, um eine korrekte Datenerfassung in unterschiedlichen, meist hochkomplexen Anwendungen garantieren zu können.

Benutzerfehler unterteilen sich zum Beispiel in falsche Eingaben, fehlendes Know-how für eine korrekte Bedienung der Anwendungen, falsche Interpretationen der zu erfassenden Daten sowie die unvollständige Erfassung der Daten aufgrund fehlender Informationen.

Eine der grundlegenden Ursachen für das Entstehen schlechter Datenqualität bereits bei der Datenerfassung ist das fehlende Problembewusstsein für die sich potenzierenden Auswirkungen mangelhafter Datenqualität auf den nachfolgenden Ebenen der Informationsverarbeitung. Einhergehend damit sind die fehlenden Beschäftigungsanreize für eine korrekte Erfassung von Daten.

Es wird oftmals ausschließlich die Anzahl der eingegebenen Daten und die Geschwindigkeit der Erfassung gemessen, ohne ausreichend auf die Qualität zu achten. Dies führt in weiterer Folge auch dazu, dass keine Zeit für eventuell notwendige Rückfragen bei Unklarheiten im Rahmen der Erfassung zur Verfügung steht.

Ein mangelhaftes Design der Eingabemasken stellt eine weitere Quelle für Probleme bei der Erfassung der Daten dar. Die Absicherung einzelner Felder bzw. die Plausibilisierbarkeit der Inhalte ist nicht immer ausreichend, die Möglichkeiten zur Einschränkung der Erfassung in den Masken bleiben ungenutzt. Zudem erfolgt das Design solcher Masken meist aus Sicht eines einzigen Unternehmensbereichs, etwa durch den Vertrieb.

Dies führt dazu, dass sich z.B. abgesicherte Muss-Felder in den Eingabemasken vor allem an den Bedürfnissen des Vertriebs orientieren und vorhandene Kann-Felder nicht weiter eingeschränkt werden. Aus Sicht des externen Rechnungswesens haben diese Kann-Felder möglicherweise eine ganz andere Bedeutung und führen in weiterer Folge zu Datenqualitätsproblemen im Rahmen der Bilanzerstellung.

Ein potenzieller Ressourcenmangel im Zuge der Datenerfassung zieht in vielen Fällen ebenfalls eine mangelhafte Datenqualität nach sich, falls beispielsweise über längere Zeiträume keine bzw. nur eine eingeschränkte Datenerfassung erfolgt. Dies hat Auswirkungen auf die Zeitnähe der Daten in den verschiedenen Business-Intelligence-Anwendungen. Eine unzureichend aktuelle Datenerfassung hat unter Umständen falsche Meldungen an die Aufsichtsbehörden zur Folge oder kann zu Irritationen in den Kundenbeziehungen führen.

Fehlerhafte externe Daten sind zusätzlich oftmals einer der Gründe für schlechte Datenqualität in den Business-Intelligence-Anwendungen. Externe Daten können dabei unter anderem zugekaufte Adressdaten sein.

Die Schlussfolgerung daraus ist, dass bereits bei der Erfassung der Daten die Bedürfnisse des Gesamtunternehmens in die Überlegungen zur Sicherstellung der Datenqualität einfließen müssen, um so aus einer ganzheitlichen Sichtweise heraus entsprechende Maßnahmen definieren zu können.

Prozesse

Diese Kategorie beschreibt die Auswirkungen auf die Datenqualität, die sich durch die Komplexität der Abläufe in den Unternehmen bzw. durch generell mangelhaft aufgesetzte Prozesse im Zuge der Datenverarbeitung ergeben. Dies beginnt bereits bei der Erfassung der Daten und zieht sich hin bis zur Erstellung der Berichte.

Fehlende oder auch nur unvollständig aufgesetzte Prozesse führen zu fehlerhaften Datenerfassungen. Fehlende Prüfprozesse im Sinne einer weiteren Absicherung hinsichtlich Falscheingaben verstärken dies zusätzlich. Ergänzend zu den Erfassungsprozessen sind fehlende Feedbackprozesse ebenfalls problematisch, da Möglichkeiten zur standardisierten Revidierung falscher Eingaben fehlen.

Diese Probleme werden zusätzlich noch durch eventuelle Brüche in den verwendeten Medien verstärkt, z.B. durch eine Unterbrechung der automatisierten Datenverarbeitung durch manuelle Ergänzungen oder auch durch eine teilweise manuelle Erfassung innerhalb der Kette von der Datenerfassung bis zur Datenverwendung.

Abteilungsübergreifende Prozesse mit einem Übergang der Verantwortung im Rahmen der Datenbereitstellung führen ebenfalls zu Abstimmungsproblemen und ziehen potenziell eine Verschlechterung der Datenqualität nach sich.

Das Überschreiten von Unternehmensgrenzen, beispielsweise hervorgerufen durch ein Outsourcing der Datenerfassung, stellt eine weitere besondere Herausforderung an die Sicherstellung der Datenqualität dar. Diese Konstrukte sind meist ausschließlich auf Kostenersparnis und die Maximierung der erfassten Datenmengen bzw. auf eine Minimierung der Erfassungszeiten aufgebaut. Die für eine Sicherstellung der Datenqualität erforderlichen Ressourcen und deren zeitliche Verfügbarkeit spielen dabei häufig nur eine sekundäre Rolle.

Fehlende standardisierte Abstimmungsprozesse zwischen den Daten auf verschiedenen Stufen der Verarbeitungskette führen dazu, dass die Erkennung potenzieller Fehler erst sehr spät stattfindet. Daraus resultiert eine Verkürzung der Reaktionszeiten bei auftretenden Datenqualitätsproblemen. Eine in den Verarbeitungsprozess integrierte Reconciliation im Sinne eines Abgleichs der Daten des Data Warehouse mit den Buchhaltungssystemen ermöglicht z.B. ein frühzeitiges Reagieren auf Abweichungen in wichtigen Bereichen.

Architektur

Das richtige Design der Datenarchitektur eines Unternehmens ist ein grundlegender Baustein zur Sicherstellung der Datenqualität. Unter den Begriff Datenarchitektur fallen hier neben der Vielfalt der verwendeten Technologien und der bereitgestellten Daten auch deren Zugänglichkeit bzw. Unzugänglichkeit durch die Anwender.

Das Design der Datenarchitektur beginnt bereits mit den operativen Systemen, die als Datenquellen für die durchzuführenden Aufgaben ausgelegt sein müssen. Eine konsistente Konzeption der Datenintegration der BI-Anwendungslandschaft beginnt bei den ETL6-Prozessen bzw. den Datenflüssen zwischen diesen Systemen. Inhaltlich klar abgegrenzte analytische Data Marts sind dabei ebenso eine wesentliche Voraussetzung für eine konsistente Datenarchitektur von Unternehmen.

Das Thema Datenarchitektur im Umfeld von Business-Intelligence-Projekten wird in Kapitel 5 im Detail behandelt. In diesem Abschnitt erfolgt zunächst eine erste Sensibilisierung hinsichtlich der Datenarchitektur als Ursache von Datenqualitätsproblemen.

In vielen Unternehmen sind in den vergangenen Jahren die operativen Anwendungslandschaften kontinuierlich gewachsen und um zusätzliche Funktionalitäten erweitert worden, die ursprünglich nicht vorgesehen waren. Das Ergebnis dieser nachträglichen Modifikationen ist oftmals eine heterogene operative Anwendungslandschaft mit redundanten, inkonsistenten Datenhaltungen sowie redundanten Transformationen zwischen den verschiedenen Anwendungen.

Systemumstellungen, Datenmigrationen und Fehler in den Anwendungen selbst führen bereits in den operativen Systemen zu einer Verschlechterung der Datenqualität. Die auf dieser Stufe entstehenden Probleme vervielfachen sich im Zuge der Datenverarbeitung bis hin in die BI-Anwendungen und führen zu einem erhöhten Aufwand für die Eindämmung der Auswirkungen.

Innerhalb der BI-Anwendungslandschaft sind die Problembereiche analog den operativen Anwendungen. Dazu kommen noch inkonsistente Transformationen der Daten aus den operativen Systemen in die verschiedenen analytischen Systeme. Dies zieht Inkonsistenzen in den Berichten und einen erhöhten Abstimmungsaufwand zwischen den Anwendungen nach sich.

Zusammenfassend führen Datenflüsse zwischen verschiedenen Anwendungen unweigerlich zu Problemen, hervorgerufen durch unterschiedliche Felddefinitionen und mehrfache Transformation der Daten. Im Zuge der Betrachtung von Datenqualitätsproblemen ist daher immer ein Augenmerk auf die Datenflüsse zwischen den Anwendungen zu legen. Das Design der Datenarchitektur sowie die Nachvollziehbarkeit von Transformationen in den Datenflüssen sind wesentliche Voraussetzungen für die nachhaltige Sicherstellung der Datenqualität.

Definitionen

Ein weiterer oftmals vernachlässigter Punkt hinsichtlich schlechter Datenqualität sind inkonsistente fachliche Beschreibungen der Daten. Dies beinhaltet unterschiedliche Definitionen von Feldformaten, verschiedene Inhalte von grundsätzlich identischen Feldern in verschiedenen Business-Intelligence-Anwendungen oder vielfach sogar bereits in den Quellsystemen sowie miteinander unvereinbare Sichtweisen auf das Unternehmen durch die einzelnen Unternehmensbereiche. Diese unterschiedlichen Sichtweisen innerhalb von Unternehmen können sich auch oftmals bereits durch inkonsistente Geschäftsprozesse manifestieren.

Bedingt durch heterogene Anwendungslandschaften verstärken sich die Auswirkungen dieser unterschiedlichen Definitionen auf die Qualität der Daten mit jeder weiteren Transformation zwischen den Anwendungen. Diese Kategorie hat hinsichtlich einer konsistenten Business-Intelligence-Architektur höchste Relevanz. Gerade spezifische Data Marts in den einzelnen Fachbereichen der Unternehmen bergen die Gefahr inkonsistenter Definitionen in sich.

Die Konzeption vieler Anwendungen erfolgt sehr oft aus Sicht eines einzelnen Unternehmensbereichs, ohne Berücksichtigung der Bedürfnisse des Gesamtunternehmens. Ein wesentlicher Grund dafür ist oftmals die eingeschränkte Verfügbarkeit von Ressourcen und Budgets, aber auch fehlendes Problembewusstsein oder im schlimmsten Fall einfach nur Ignoranz. Dies führt in weiterer Folge unweigerlich zu erhöhten Abstimmungserfordernissen aufgrund inkonsistenter Berichte.