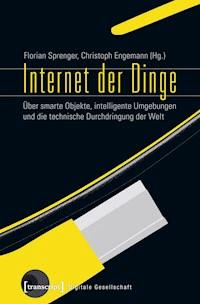

Internet der Dinge E-Book

26,99 €

Mehr erfahren.

- Herausgeber: transcript Verlag

- Kategorie: Geisteswissenschaft

- Serie: Digitale Gesellschaft

- Sprache: Deutsch

Das Internet der Dinge wird als neue Stufe der Digitalisierung und Zukunft unseres computergestützten Weltzugangs angepriesen: Unsichtbar, smart, miniaturisiert und allgegenwärtig sollen Gadgets und Devices unseren Alltag durchdringen. Die Vernetzung der Dinge durch Chips, Tags und Sensoren transformiert unser Verhältnis zur Technik und verschafft den Dingen einen neuen Ort in der Welt.

Dieser Band versammelt Erstübersetzungen paradigmatischer englischer Texte sowie aktuelle Analysen deutschsprachiger Autoren und liefert einen Überblick über den gegenwärtigen Stand der Diskussion zur Geschichte, zur Epistemologie, zu Techniken und zu Anwendungen des Internets der Dinge.

Mit Beiträgen u.a. von Natascha Adamowsky, John Seely Brown, Mercedes Bunz, Ian Bogost, Ina Bolinski, Keller Easterling, Christoph Engemann, Jennifer Gabrys, Sebastian Gießmann, Kai Hofmann, Gerrit Hornung, Sabina Jeschke, Timo Kaerlein, Linus Neumann, Jussi Parikka, Stefan Rieger, Jens Schröter, Michael Seemann, Florian Sprenger und Mark Weiser.

Das E-Book können Sie in Legimi-Apps oder einer beliebigen App lesen, die das folgende Format unterstützen:

Seitenzahl: 639

Veröffentlichungsjahr: 2015

Ähnliche

Das Internet der Dinge wird als neue Stufe der Digitalisierung und Zukunft unseres computergestützten Weltzugangs angepriesen: Unsichtbar, smart, miniaturisiert und allgegenwärtig sollen Gadgets und Devices unseren Alltag durchdringen. Die Vernetzung der Dinge durch Chips, Tags und Sensoren transformiert unser Verhältnis zur Technik und verschafft den Dingen einen neuen Ort in der Welt.

Dieser Band versammelt Erstübersetzungen paradigmatischer englischer Texte sowie aktuelle Analysen deutschsprachiger Autoren und liefert einen Überblick über den gegenwärtigen Stand der Diskussion zur Geschichte, zur Epistemologie, zu Techniken und zu Anwendungen des Internets der Dinge.

Mit Beiträgen u.a. von Natascha Adamowsky, John Seely Brown, Mercedes Bunz, Ian Bogost, Ina Bolinski, Keller Easterling, Christoph Engemann, Jennifer Gabrys, Sebastian Gießmann, Kai Hofmann, Gerrit Hornung, Sabina Jeschke, Timo Kaerlein, Linus Neumann, Jussi Parikka, Stefan Rieger, Jens Schröter, Michael Seemann, Florian Sprenger und Mark Weiser.

Florian Sprenger (Dr. phil.) ist PostDoc am Digital Cultures Research Lab der Leuphana Universität Lüneburg und ab Oktober 2015 Juniorprofessor für Medienkulturwissenschaft an der Goethe-Universität Frankfurt am Main.

Christoph Engemann (Dipl.-Psych.) arbeitet an der DFG-Kollegforschergruppe Medienkulturen der Computersimulation der Leuphana Universität Lüneburg.

cdc.leuphana.de

www.leuphana.de/en/research-centers/mecs.html

Florian Sprenger, Christoph Engemann (Hg.)

Internet der Dinge

Über smarte Objekte, intelligente Umgebungen und die technische Durchdringung der Welt

Gefördert mit Mitteln der DFG-Kollegforschergruppe Medienkulturen der Computersimulation und des Digital Cultures Research Labs der Leuphana Universität Lüneburg.

Bibliografische Information der Deutschen Nationalbibliothek Die Deutsche Nationalbibliothek verzeichnet diese Publikation in der Deutschen Nationalbibliografie; detaillierte bibliografische Daten sind im Internet über http://dnb.d-nb.de abrufbar.

eBook transcript Verlag, Bielefeld 2015

© transcript Verlag, Bielefeld 2015

Die Verwertung der Texte und Bilder ist ohne Zustimmung des Verlages urheberrechtswidrig und strafbar. Das gilt auch für Vervielfältigungen, Übersetzungen, Mikroverfilmungen und für die Verarbeitung mit elektronischen Systemen.

Covergestaltung: Kordula Röckenhaus, Bielefeld

Coverabbildung: Occhiali a realtà aumentata © fusolino - Fotolia

Konvertierung: Michael Rauscher, Bielefeld

Print-ISBN: 978-3-8376-3046-6

PDF-ISBN: 978-3-8394-3046-0

ePUB-ISBN: 978-3-7328-3046-6

http://www.transcript-verlag.de

Inhalt

Im Netz der Dinge

Zur Einleitung

Florian Sprenger/Christoph Engemann

Das kommende Zeitalter der Calm Technology

Mark Weiser/John Seely Brown

Die Vergangenheit der Zukunft

Kommentar zu »Das kommende Zeitalter der Calm Technology«

Florian Sprenger

Die Dinge des Internets

Das Internet der Dinge, die wir nicht brauchen

Ian Bogost

Game of Things

Michael Seemann

Vom Internet zum Internet der Dinge

Die neue Episteme und wir

Natascha Adamowsky

Die Welt als Interface

Über gestenbasierte Interaktionen mit vernetzten Objekten

Timo Kaerlein

Epistemologien der Distribution

Die Dinge tragen keine Schuld

Technische Handlungsmacht und das Internet der Dinge

Mercedes Bunz

Rechtliche Herausforderungen des Internets der Dinge

Kai Hofmann/Gerrit Hornung

Animal Tagging

Zur Ubiquität der smarten Tiere

Ina Bolinski

Die neue Arbeit in der Ökonomie verteilter Maschinen

Das Internet der Dinge, die allgemeine Ökologie und ihr Ökonomisch-Unbewusstes

Jens Schröter

Industrie 4.0 ante portas

Paradigmenwechsel im deutschen Maschinen- und Anlagenbau

Sabina Jeschke/Tammo Andersch/Karsten Schulze/Dorothée Fritsch/Katharina Marquardt/Tobias Meisen/Anja Richert/Max Hoffmann/Christian Tummel

Sensoren der Cloud

Linus Neumann

Geld, Kredit und digitale Zahlung 1971/2014

Von der Kreditkarte zu Apple Pay

Sebastian Gießmann

Un/Ordnungen des Urbanen

Programmieren von Umgebungen

Environmentalität und Citizen Sensing in der smarten Stadt

Jennifer Gabrys

Eine geteilte Stadt

Affekt, Technologie und Visuelle Kultur in London 2012

Jussi Parikka

Smart Homes

Zu einer Medienkultur des Wohnens

Stefan Rieger

Ein Internet der Dinge

Keller Easterling

Autorinnen und Autoren

Im Netz der Dinge

Zur Einleitung

Florian Sprenger/Christoph Engemann

Mit der Rede vom Internet der Dinge und von Ubiquitous Computing wurde um die Jahrtausendwende die Zukunft des Computers in zumeist überaus euphorische Worte gefasst.[1] Die Vernetzung vieler oder sogar aller Dinge durch Chips und Tags, ihre Ausstattung mit Sensoren und ihre feine Abstimmung aufeinander sowie auf die Bedürfnisse der User sollten dafür sorgen, die damals meist in Gestalt grauer Kisten auftretenden Computer auf eine neue Weise dienlich zu machen: unsichtbar, smart, miniaturisiert, räumlich verteilt und allgegenwärtig. Während die Aussichten dieser Zeit entweder von der New Economy verschluckt wurden oder sich als unrealistisch herausstellten, befinden wir uns heute in einer anderen Lage, die ein erstes Fazit und einen neuen, nicht mehr von Euphorie überlagerten Ausblick auf die Umgestaltung technischer, sozialer und ökonomischer Zusammenhänge möglich macht. Während damals Technikbegeisterung und historisch tradierte Phantasmen die Unzulänglichkeiten der Technik und die Trivialität vieler Anwendungen verdeckten, sind heute die Erwartungen einem technikoptimistischen Pragmatismus gewichen, der darauf abzielt, zu tun, was möglich ist. Eine ganze Reihe der damals visionierten Technologien gehört heute in Form von allgegenwärtigen Smartphones, RFID-Chips, smarten oder weniger smarten Häusern und automatisierten Autos zum Alltag. Selbst wenn manche der Anwendungen in der Tat trivial oder gar überflüssig erscheinen, wie Ian Bogosts Beitrag in diesem Band unterstreicht, ändert dies nichts an der Tatsache, dass die notwendigen technischen Infrastrukturen vorhanden sind und ausgebaut werden. Ihre Auswirkungen und Eingriffe in unser Leben und unser Selbstverständnis lassen sich unabhängig von der Übereinstimmung mit Erwartungen und Versprechungen nicht mehr wegdiskutieren. Sie stehen zugleich in einer Kontinuität mit tiefer reichenden Entwicklungslinien, die nicht auf den Computer beschränkt werden sollten. Wir sind konfrontiert mit Technologien, die es uns auf verschiedenen Ebenen nahelegen, Grundbegriffe wie Handlung und Arbeit, Denken und Wahrnehmen, Leben und Menschsein neu zu durchdenken. Diese Einleitung soll das Feld dieser Herausforderungen in einigen groben Zügen skizzieren, die damit verbundenen Erwartungen historisch situieren, sie mit der tatsächlichen Entwicklung kurzschließen und aufzeigen, wo heute noch unerkannte Fragen liegen könnten.

Rechenkraft wandert, darin sind sich alle Beobachter einig,[2] aus den Black Boxes isolierter Endgeräte zunehmend in Umgebungen aus, um dort vernetzt und kontextabhängig auf der Grundlage massenhaft gesammelter Sensordaten zu operieren: Everyware, wie sie Adam Greenfield treffend genannt hat.[3] Dinge werden zu Akteuren, wenn sie im Zuge dieser Neuverteilung von Handlungsmacht beginnen, selbstständig zu agieren, indem sie nicht nur Daten sammeln, sondern auf ihrer Grundlage zukünftige Ereignisse berechnen oder gar Entscheidungen treffen, die zu diesen Ereignissen führen oder sie verhindern sollen. Programmiert und konstruiert wird weiterhin von Menschen, doch unterlaufen die zeitlichen und operativen Prozesse im Internet der Dinge deren Kapazitäten. Dies ist zwar bei jedem zeitgenössischen Computer der Fall, doch basieren die Berechnungen, die die Grundlage des Internets der Dinge sind, auf umgebungsbezogenen Sensordaten, auf der Vernetzung verteilter Bestandteile und auf ausgelagerter Rechenkraft. Deshalb liegt es durchaus nahe, von einem perzeptiven und einem kognitiven Vermögen dieser nicht zufällig smart genannten Technologien auszugehen. Damit verändert sich, so der Tenor der einschlägigen Debatten, der Status der Dinge in der Welt und zugleich die Handlungsperspektive des Menschen. Während auf technischer Ebene das Paradigma des Computers dabei ist, eine neue Relation von Mensch und Maschine anzunehmen, sind die sozialen und epistemologischen Folgen dieses Wandels bislang noch kaum durchdacht. Wir befinden uns, wie es jüngst Mark Hansen ausgedrückt hat, in einem grundlegenden Medienwandel: »From a past-directed recording platform to a data-driven anticipation of the future«[4]. Denn mit dem, was Hansen die Medien des 21. Jahrhunderts nennt, geht es nicht mehr darum, Inhalte zu repräsentieren oder an passive User zu verteilen. Vielmehr ist es Zweck der von Hansen beschriebenen Medien, auf der Grundlage von Sensordaten, die direkt in unseren Umgebungen gesammelt werden, Bewegungen, Wissen und Prozesse prädikativ zu extrapolieren, zu überwachen, zu kontrollieren und letztlich bis in die Tiefenschichten zu ökonomisieren.

Seit einigen Jahren beginnen diese im Einzelnen sehr unterschiedlichen Technologien, unsere Wohnungen, unsere Häuser, unsere Städte zu durchdringen. Die Räume, die solche Technologien aufbereiten, die sie mit ihren Sensoren kontrollieren und aus denen sie Daten sammeln – seien es Wohnzimmer, Küchen, Büros, Supermärkte, öffentliche Plätze, Fahrzeuge oder Fabrikhallen –, werden als Environments, d.h. als gestaltbare Umgebungen aus Information berechnet, synthetisiert, kontrolliert und moduliert. Viele kleine, vereinzelt leistungsschwache, aber interagierende Computer sind in Alltagsgegenstände integriert, miteinander vernetzt und mit der Cloud sowie ihren Datenbanken zum Internet der Dinge verbunden. Auch wenn keine einzelne Komponente die Fähigkeiten eines Stand-Alone-Rechners erreicht, übertreffen sie in ihrer schieren Masse deren Rechenfähigkeiten um ein Vielfaches – sofern das Computing nicht gänzlich in die Cloud ausgelagert ist. Diese Kombination von Vernetzung und Neuverteilung macht die Gestalt des heutigen Internets der Dinge aus, das sich auf keine einzelne Technologie und auf kein singuläres Gerät beschränken lässt und doch in der Vielfalt von Anwendungen und Techniken eine Kohärenz aufweist.

Die unüberschaubare Breite an Projekten, Angeboten und Geräten in diesem Gebiet, von Smart Clothes und Smart Gadgets über Smart Homes bis hin zu Smart Cities, macht deutlich, dass es sich beim Internet der Dinge um kein abgegrenztes Feld technischer Entwicklungen handelt, sondern um ein Zusammenkommen verschiedener Wissenschaften, Technologien, Ingenieurspraktiken, wirtschaftlicher Interessen, Imaginationen und Geschichten, das kaum einen Konsens kennt.[5] Wie zur Zeit seiner ersten Imaginationen ruft das Internet der Dinge heute zugleich Begeisterung und Ängste hervor, die von einer neuen Stufe künstlicher Intelligenz über die Eskalation globaler Überwachung bis hin zur Aufhebung der Grenze zwischen Menschen und Nicht-Menschen reichen. Die Befürworter versprechen sich Erleichterungen des Alltags, neue Marktchancen durch Anwendungen im Konsumentenbereich und in der Logistik, aber auch für die Gesundheitsfürsorge. Die Kritiker des Internets der Dinge befürchten vor allem, dass diese unsichtbaren und vernetzten Computer eine neue Qualität der Überwachung und Ökonomisierung der Welt mit sich bringen. ›Internet der Dinge‹ dient in diesen Debatten ebenso wie Ubiquitous Computing notwendigerweise als Sammelbegriff für unterschiedliche Ansätze, die jedoch spezifische Vorstellungen von der Zukunft des Computers und seiner Technologien teilen.[6] An diesen gemeinsamen Vorstellungen kann in einer ersten Annäherung angesetzt werden, um zu verstehen, worum es mit dem Internet der Dinge geht.

Nicht länger als unattraktive Rechenmaschinen, sondern in alle Geräte oder schlicht alle Dinge eingebaut, sollten Computer, so die Visionen der Anfangszeit, unauffällig und effektiv die lästigen, aber notwendigen Aufgaben erledigen, die uns von den wirklich wichtigen Bestandteilen unseres Lebens abhalten. Die berühmten ersten Sätze von Mark Weisers Aufsatz »The Computer for the 21st Century« kündigen dieses Zeitalter an: »The most profound technologies are those that disappear. They weave themselves into the fabric of everyday life until they are indistinguishable from it.«[7] Dabei sollte der Anwendungsbereich des drahtlos vernetzten oder verkabelten Computers ebenso ausgeweitet werden wie die Zahl derjenigen, die für seine Potentiale Verwendung haben. Bereits in den 1990er Jahren wurde offensichtlich, dass der Singular Computer eine kaum noch überschaubare Vielzahl an Erscheinungsformen in sich aufzunehmen begann. Zeitgenössische Beobachter teilten die Erfahrung, dass zunächst ein Computer pro Firma, dann ein Minicomputer genannter Rechner pro Abteilung und schließlich ein Personal Computer pro Schreibtisch angeschafft wurde. Spätestens zu diesem Zeitpunkt wurden Computer auch für Privatpersonen erschwinglich und verließen die Büros, um in die privaten Wohn- und Arbeitszimmer einzuwandern und allgemeine Akzeptanz zu gewinnen. Das Versprechen des PCs wies bereits auf die Person selbst und es wurde absehbar, dass bald nicht nur jeder Angestellte, sondern jeder Haushalt nicht bloß einen persönlichen Computer haben würde, sondern mehrere. Eben hier sollten neue Entwicklungen ansetzen, weil die Beschränkungen des PC-Paradigmas offensichtlich wurden. Die Geräte waren unhandlich, kompliziert und gerade für den Hausgebrauch oftmals dysfunktional. Die fortschreitende Miniaturisierung von Chips sollte stattdessen die Welt der Dinge mit digitalen Maschinen durchsetzen und somit jedes Ding potentiell ein Computer sein können. Die gleichzeitig einsetzende Vernetzung sowohl lokaler Rechensysteme mittels des Ethernets als auch die Möglichkeiten eines globalen Internets bereiteten den Boden für neuartige Vorstellungen der Relationen von Rechnern und Menschen und Rechnern.

Entsprechend hat die smarte Vernetzung, wie wir heute sehen, Auswirkungen auf nahezu alle Bereiche, die mit Computern in Beziehung stehen und wird in den einschlägigen, von diesem Band fortgesetzten Debatten als Transformation des Verhältnisses von Mensch und Welt durch Computer beschrieben. Verschoben oder gar aufgehoben wird damit mehr oder weniger explizit die Grenze von menschlichen und nichtmenschlichen Akteuren hin zu einer »Dingpolitik«[8], wie sie in den letzten Jahren auch in philosophischen Strömungen populär geworden ist. Deshalb ist es notwendig, den heutigen Wandel ubiquitärer Medien und seine vielfältigen Effekte nicht allein auf die Digitalisierung und Vernetzung des Alltags, auf soziale Medien und die Potentiale der Kalkulierbarkeit zu beziehen. Das Internet der Dinge kann, dies wird heute offensichtlich, kaum noch von Endgeräten her verstanden werden, sondern sollte vielmehr in seiner infrastrukturellen, umgebenden und temporalen Dimension durchdacht werden. Doch wir haben es mit mehr als einer Überlagerung der Welt mit den Netzen eines Internets zu tun. Die Welt des Internets der Dinge impliziert eine Ontologie, in der es nur das gibt, was vernetzt ist.

Diese Ontologie ist eng verbunden mit der Geschichte des Computers. Die in den 1990er Jahren imaginierte Generation von Computern sollte, durchaus in Reaktion auf den Sachverhalt, dass Informationstechnologien verschiedene Gestalten anzunehmen begannen, keine neue Form hinzufügen, sondern die Definition dessen betreffen, was Computer genannt wurde. Diese Neudefinition ist seitdem um uns herum technisch vollzogen worden, theoretisch aber noch kaum eingeholt. Eine zentrale Herausforderung bei der Betrachtung des Internets der Dinge liegt also auf konzeptueller Ebene: Wovon sprechen wir, wenn wir vom Internet der Dinge sprechen? Ist das Internet der Dinge überhaupt ein Internet? Sind seine Dinge noch Dinge? Die Beschäftigung mit der Vielzahl technischer Gegenstände, die heute smart genannt werden, impliziert zwar keine Abwendung, aber doch eine Re-Zentrierung von Rechnertechnologien, die in Form singulärer Kalkulationsgeräte allzu oft monothematisch für gegenwärtige Medientechnologien stehen oder aber als soziale Medien ohne technische Infrastrukturen missverstanden werden. Daher gilt es – und diese Offenheit zieht sich durch alle hier versammelten Beiträge –, sich noch einmal und vielleicht immer wieder vom einem aus Dingen bestehenden Internet irritieren zu lassen, seiner Vielgestaltigkeit zu begegnen und die Breite der Fragen, die von ihm aufgeworfen werden, ernstzunehmen. Die Aufsätze dieses Bandes addieren entsprechend verschiedene Perspektiven, Abstraktionsebenen, Herangehensweisen und Traditionen zu einem Panorama. Die Autorinnen und Autoren sind Praktiker wie Theoretiker und kommen aus unterschiedlichen Feldern – der Politik, der Kultur- und Medienwissenschaft, dem Netzaktivismus, dem Journalismus, der Wirtschaft, der Technik, der Soziologie, der Rechtswissenschaft. Wie sich in den letzten Jahren gezeigt hat, können die Phänomene digitaler Kulturen, insofern sie die genannten kategorialen Herausforderungen stellen, nur mit einer Selbstverständlichkeit interdisziplinären Arbeitens angegangen werden. Auch zu diesem Selbstverständnis einer Medienwissenschaft digitaler Kulturen möchte der vorliegende Sammelband einen Beitrag liefern.

Miniaturisierung, Adressierung, Vernetzung – Zur Geschichte des Internets der Dinge

Für die Situierung der entsprechenden Technologien und der in diesem Band versammelten Beiträge, ist es sinnvoll, einleitend die Linien zu skizzieren, die zur gegenwärtigen Entwicklung des Internets der Dinge geführt haben. Die Rede vom Internet der Dinge geht auf den Titel einer Präsentation des britischen Unternehmers Kevin Ashton im Jahre 1999 zurück.[9] In seinem Vortrag erläuterte Ashton seine Erfahrungen mit der RFID-Technik (Radio Frequency Identification), die er als Manager beim Konsumartikelhersteller Procter & Gamble gesammelt hatte. Inzwischen Mitbegründer des MIT Auto-ID Centers, eines Instituts mit dem sprechenden Namen Zentrum für Selbstidentifikations-Techniken, war Ashton davon überzeugt, dass die Warenströme der Logistik mit funkbasierten Etiketten effizienter zu organisieren wären. Gegenwärtig wird das Internet der Dinge im regelmäßig veröffentlichten Hype-Cycle-Report der renommierten Unternehmensberatung Gartner auf dem Scheitelpunkt zwischen Hype und langsam einsetzender Desillusionierung verortet.[10] Erst nach dieser Enttäuschung setze Gartner zufolge die eigentlich produktive und wertschöpfende Phase einer Technologie ein.

Abbildung 1: Gartner Hype Cycle 2015

Quelle: www.gartner.com/newsroom/id/3114217 vom 18. August 2015

Von Beginn an scheint das Internet der Dinge also auf dem Höhepunkt eines Hypes zu stehen. Es wurde bislang fast ausschließlich als Technologie am Wendepunkt begriffen, als Versprechen auf zukünftige Entwicklungen, als Wette auf Kommendes.[11] Daher ist es an der Zeit, sich vom vermeintlichen Status Quo einer unmittelbar bevorstehenden Revolution zu lösen und vielmehr in den Blick zu nehmen, was im Konkreten geschieht und welche politischen, sozialen und kulturellen Folgen heute erkennbar werden. Verstehen wird man diese Entwicklungen aber erst, wenn man die Aufladungen, Erwartungen und Phantasmen berücksichtigt, die mit ihm verbunden sind. Noch haben sich keine Marktführer dieser Technik herausgebildet. Dennoch zeigen Beispiele wie Smart Clothes[12], Fitbit, Google Nest, die Apple Watch, die Debatten um autonome Fahrzeuge ebenso wie die Angriffe auf industrielle SCADA-Steuerungsanlagen[13], dass das Internet der Dinge im Jahre 2015 in verschiedenen, nicht immer vorhergesagten Formen Realität geworden ist. In ihr konvergieren drei größere Trends, die sich teilweise unabhängig voneinander entwickelt haben: Ubiquitous Computing, RFID und das Cloud-Computing mit Big Data. Grob können sie mit den drei übergeordneten Entwicklungen der Miniaturisierung, der Adressierung und der Vernetzung identifiziert werden.

Ubiquitous Computing

Ubiquitous Computing wurde in den 1990er Jahren am kalifornischen Xerox Palo Alto Research Center (PARC) geprägt und entwickelt. Das Team um den dortigen Computerpionier Mark Weiser verstand darunter eine fundamentale Verlagerung der Computer weg von den Schreibtischen und Serverräumen hin in den umgebenden Hintergrund, wie auch der in diesem Band erstmals in deutscher Übersetzung vorliegende Aufsatz »Das kommende Zeitalter der Calm Technology« von John Seely Brown und Mark Weiser zeigt. Treiber dieser Visionen war die fortschreitende Miniaturisierung der Computerchips. Bereits in den 1980er Jahren wurde absehbar, dass die Moore’s Gesetz[14] folgende Steigerung der Rechenleistung und gleichzeitige Verringerung des Energieverbrauchs[15] digitaler Bauteile bald gänzliche neue Computer-Formate ermöglichen würde. Nicht nur würden diese klein genug werden, um in der Hand gehalten werden zu können. Es wird zu diesem Zeitpunkt auch denkbar, stecknadelkopfgroße Computer in die Dinge der Umgebung zu implementieren. Computer sollten somit, wie Florian Sprengers Kommentar zu Browns und Weisers Text vorführt, sowohl allgegenwärtig und ubiquitär als auch quasi unsichtbar werden.

Weiser bezog sich in seinen Beispielen für das Ubiquitous Computing auf zwei Situationen: Büroumgebungen, wie sie beim Bürogerätehersteller Xerox erforscht wurden, und das häusliche Wohnen. Beide, so betont Weiser in seinen Schriften immer wieder, würden sich durch die Vielzahl der im Hintergrund tätigen Assistentensysteme fundamental ändern. Wie an den aktuellen Beispielen der Industrielogistik und der SCADA-Steuerungen sowie der Popularität von Smart Homes deutlich wird, hat Weiser in dieser Hinsicht Recht behalten. Dennoch tragen seine in den 1990er Jahren entstandenen Projekte einen deutlichen Stempel ihrer Zeit. Die Infrastrukturen der Vernetzung ubiquitärer Computer wurden zwar auch als mit dem Internet verbunden gedacht. Weiser ging aber von relativ lokal verbleibenden Datenströmen und Verarbeitungsprozessen aus. Visioniert wurden computerisierte und technisch durchdrungene Häuser, Büroensembles oder einzelne Fabriken, innerhalb derer die Koordination und das Prozessieren der jeweiligen Daten stattfinden sollte. Die Infrastrukturen des Ubiquitous Computings haben in Weisers Vision zwar globalen Anschluss, sind aber fundamental lokal. Wie die Beiträge von Natascha Adamowsky, Linus Neumann und Michael Seemann in diesem Buch zeigen, ist die tatsächliche Entwicklung an dieser Stelle anders verlaufen als zu dieser Zeit geplant. Mit dem Internet der Dinge wird, so diese Autoren, das Lokale zu einer anzuzapfenden Datenquelle. Anders als von Weiser erwartet, werden die entscheidenden Rechenoperationen heute an entfernten Orten getätigt.

Für die Genealogie des Internets der Dinge sind die bei PARC erarbeiteten Visionen des ubiquitären Computings dennoch von zentraler Bedeutung. Viele Entwicklungen, von Handhelds bis hin zu Tablets, wurden an diesem Ort nicht nur luzide vorausgesehen, sondern auch patentiert, in prototypischer Form gebaut, mittels eigens entwickelter Protokolle vernetzt und im Büro- und Lebensalltag erprobt. Bereits 1992, noch bevor das Internet öffentlich wurde, hantierte man hier mit Geräten, die erst zwanzig Jahre später tatsächlich alltäglich sein sollten. So ist es kein Wunder, dass die heutige Produktpalette von Apple exakt die Gerätetypen umfasst, die vor 20 Jahren bei PARC entworfen wurden – zu einer Zeit, als Xerox Aktien von Apple besaß und Apple die Patente von Xerox nutzen durfte.[16] Wesentliche Ideen und Konzepte einer smarten Vernetzung der Dinge wurden an diesem Ort auch in ihren philosophischen und sozialen Konsequenzen durchdacht. Die resultierenden Ansätze dienten in den folgenden Jahrzehnten als Bezugspunkt für die Entwicklung von digitalen Medien.

Radio Frequency Identification

Neben dem Ubiqitous Computing sind die Entwicklungen der RFID-Technologie der zweite wichtige Bestandteil einer Genealogie des heutigen Internets der Dinge. RFID steht für Radio Frequency Identification und trägt mit dem Begriff ›Identifikation‹ schon einen zentralen Bestandteil des Internets der Dinge im Namen. Die Dinge sollen adressierbar werden, d.h. innerhalb eines Netzwerks unter einer bestimmten und eindeutigen Adresse erreichbar sein. In den frühen 1970er Jahren waren in der Computerisierung des Handels Barcodes eingeführt worden.[17] RFID war ursprünglich als Weiterentwicklung des Barcodes gedacht, die zwei wesentliche Nachteile überwinden sollte: erstens seine begrenzte Datenmenge und zweitens das aufwendige Scannen vor einem Laserdetektor durch menschliche Operateure. RFID-Etiketten sollten gänzlich automatisch ausgelesen werden können und darüber hinaus nicht nur einen auf eine Artikelklasse verweisenden Code speichern, sondern für jedes Produkt eine individuelle Adresse ermöglichen.[18] Als bekannteste und am stärksten verbreitete Technologie der Adressierbarmachung basieren RFID-Chips, wie Christoph Rosols eingehende historische Darstellung gezeigt hat,[19] ebenfalls auf der Strukturverkleinerung digitaler Bauteile. Es handelt sich um Kleinstcomputer mit Maßen von weniger als einem Millimeter. Mit einer Antenne ausgestattet, beziehen sie Strom über die Induktion in einem Funkfeld und benötigen keine Batterien. Entscheidend an RFID-Chips ist, dass sie nicht dauerhaft senden, sondern das vom Scanner erzeugte Feld modulieren und durch Induktion Energie für Eigenprozesse erzeugen. In der zweiten Hälfte der 1990er Jahre entstanden im Kontext der ersten praktikablen RFID-Implementierungen Vorstellungen wie die vom anfangs angeführten Urheber des Internet of Things-Begriffs Kevin Ashton: Jedes Ding solle mittels eines RFID-Tags vom Internet aus adressierbar sein und sich in den globalen Logistikketten nach dem erfolgreichen Vorbild digitaler Packet Switching-Netzwerke selbst seinen Weg suchen. So könnten sich die logistischen Netzwerke im Handel und in der Industrie selbstständig koordinieren und enorme Effizienzgewinne erzielen,[20] während zugleich, wie Katherine Hayles betont hat, eine räumliche Verteilung kognitiver Vermögen stattfand.[21]

Auch in diesen Debatten ist in zweierlei Hinsicht ein spezifischer Zeitindex auszumachen. Erstens wird die Bedeutung von Mesh-Netzwerken[22] zwischen den RFID-Systemen betont und eine lokale, spontane und temporäre Form der Koordination visioniert.[23] Zweitens, und nicht im Widerspruch dazu, gehen die RFID-Diskurse um das Jahr 2000 von einem weitgehenden Verbleib der Daten in der Enterprise-Ressource-Management-Software des jeweiligen Unternehmens aus. Ein Internet der Dinge ist in dieser Vision vor allem ein entsprechendes SAP-Modul,[24] das an entscheidenden Zeitpunkten der Koordination aus RFID-befähigten Logistikketten Daten empfängt bzw. entscheidungskritische Daten zur Verfügung stellt.[25] Nach der Jahrtausendwende löste sich diese Idee teilweise von den konkreten RFID-Tags, da konkurrierende und alternative Methoden vor allem auf der Ebene der Protokolle erforscht und implementiert wurden.[26] Von der RFID-Technik wird bei diesen Forschungsprojekten vor allem der Fokus auf die Verringerung des Energieverbrauchs bis hin zur passiven Stromversorgung als wichtiges Motiv übernommen.

Trotz des zeitlichen Indexes bleibt das Zentralstück dieses Diskurses wichtig: die Idee, dass jedes Ding eine Adresse hat und nur dadurch Teil von Netzen werden kann. In dieser Diskursivierung und Verfertigung von Formaten und Methoden der Adressierung von Dingen liegt der essentielle Beitrag der RFID-Debatte zur Entwicklung des Internets der Dinge. In diesem Kontext erlaubt eine eindeutige Adressierung nicht nur ein räumliches und zeitliches Tracking, eine bilanzierende Indexierung der zurückgelegten Wege und damit eine Datenerhebung, die zur Optimierung der Abläufe genutzt werden kann. Darüber hinaus ist mit der Adressierung aller Objekte die bereits erwähnte Ontologie verbunden, für die nur das existiert, was eine Adresse hat und vernetzt ist.

Cloud Computing

Der dritte Aspekt der Genealogie des heutigen Internets der Dinge sind die seit etwa 2006 entstandenen Infrastrukturen des Cloud Computings und die damit einhergehende Aggregation und Auswertung großer Datenmengen, die unter dem Schlagwort Big Data verhandelt werden.[27] Strukturell ist Big Data durch eine Verschränkung von Verbreitung und Konzentration gekennzeichnet. Auf der einen Seite steht die Quantität von Smartphones und Tablets als alltagstaugliche, allzeit präsente und mit einer Vielzahl von Sensoren bestückte Datenquellen. Victor Mayer-Schönhuber und Kenneth Cukier bezeichnen diesen Prozess, der insbesondere auf den Aufstieg der sozialen Medien und das gleichzeitige Aufkommen von Smartphones ab etwa 2006 zurückgeht, als »Datafication«.[28] Auf der anderen Seite stehen Anbieter wie Google, Facebook, Amazon, Microsoft und Apple, deren Angebote weltweit mehr als 80 Prozent des Traffics für diese Endgeräte auf sich vereinen. Dabei ist die Datensammlung in Datencentern integraler Bestandteil der Angebote und Services dieser Firmen. Nicht nur beim Streaming von Audio und Video, auch beim Online-Shopping und in sozialen Medien liegen die relevanten Daten in der Cloud. Google könnte ohne eine permanente Speicherung, Indexierung und Auswertung quasi des gesamten Webs ebensowenig eine Suche anbieten wie Facebook die Vernetzung mit einer beliebigen Person ermöglichen. Obwohl also, wie von Mark Weiser in seinen Konzepten des Ubiquitous Computing richtig erahnt, immer mehr Rechenkraft in die Hände der Nutzer gerät und Handhelds oder Tablets inzwischen Realität sind, findet derzeit immer weniger ›Computing at the Edge‹ statt.[29] Mit der ›Edge‹ ist der äußere Rand des Internets gemeint, also die Geräte an den anwenderseitigen Internetanschlüssen: die Computer, Handys, Tablets und Dinge des Internets der Dinge, die Anschluss finden sollen. Ihre Rechenleistung steigt nach wie vor stetig. Dennoch findet das wesentliche Computing in Datencentern und nicht an der ›Edge‹ statt. Vielmehr dient das ›Computing at the Edge‹ vor allem zwei Zielen: erstens der Darstellung und Darbietung von an entfernten Orten – nämlich in Datacentern – aus Big Data-Analysen berechneten Inhalten. Zweitens steht die Rechenkraft der Gadgets im Dienst ihrer Sensorik: Smart Clothes, Bewegungstracker, Mikrophone und Kameras weisen immer höhere Auflösungen auf und liefern immer mehr Daten in die Cloud der Datencenter, um dort in weiteren Big Data-Analyseläufen ausgewertet zu werden.

Wandlungen der Märkte

Das Geschäftsmodell, Nutzer zu Datengeneratoren zu machen und ihnen im Gegenzug kostenlose Services anzubieten, die just aus dem Verkauf der von ihnen gelieferten Daten finanziert sind, hat sich als überaus erfolgreich erwiesen und bildet die Grundlage für das heutige Internet.[30] Bruce Sterling nennt die oben genannten Firmen: Google, Facebook, Amazon, Microsoft und Apple die »Big-Five« und bezeichnet sie als »Stacks« – vertikal integrierte Unternehmen, die Feedbackschleifen aus nutzerbasierter Datengeneration und zentralisierter Aggregation und Auswertung großer Datenmengen aufgebaut haben. »The Internet of Things is basically a recognition by other power-players that the methods of the Big Five have won, and that they should be emulated.«[31] Tatsächlich sind diese Firmen inzwischen marktbeherrschende Akteure im Internet der Dinge und sehen darin eine Chance zur weiteren Eskalation ihrer Datenquellen für Big Data-Analysen. Die Apple Watch, Googles Nest, Amazons Echo, Microsofts Fitnesstracking-Armband und Facebooks Integration von Bilderkennungssoftware zeigen dies deutlich. Der Nest-Designer Tony Fadell beispielsweise hat deutlich ausgesprochen, das bei einem Objekt wie einem Thermostat, das nur sehr selten ausgetauscht oder gewartet wird, Services der Weg sind, Geld zu verdienen: »We’ll get more and more services revenue because the hardware sits on the wall for a decade.«[32]

Zugleich ist einschränkend anzumerken, dass beim Wandel vom Minicomputer zum PC, vom PC zum Internet und vom Internet zu mobilen Medien die jeweils marktbeherrschenden Unternehmen von neuen Anbietern verdrängt wurden. Im Zuge der Einführung des PCs trat Microsoft an die Stelle des zuvor jahrzehntelang dominierenden Unternehmens IBM. Microsoft selbst geriet in den 1990er Jahren ins Hintertreffen, da Firmen wie Netscape und Google im Internet erfolgreicher waren. Mit dem Aufkommen der Smartphones schließlich wurden Firmen wie Apple, aber auch Facebook zu den dominierenden Anbietern. Es ist nicht ausgemacht, dass der Wandel zum Internet der Dinge nicht zu neuerlichen Verschiebungen in den Marktverhältnissen führt und die von Sterling als dominant identifizierten Stacks ihre Vormachtstellung einbüßen. Wie in diesem Band der Beitrag von Sebastian Gießmann verdeutlicht, sind die technischen, organisatorischen und juristischen Fragen nach den Monetarisierungsformaten des Internets der Dinge bislang offen. Das gilt umso mehr, als das unter diesem Begriff substanzielle Veränderungen in mindestens fünf sehr unterschiedlichen Märkten erwartet werden: erstens im Konsumentenmarkt mit seinen Fitnesstrackern, Ambient Assisted Living-Systemen, Smart Clothing, Heimautomationssystemen und Mobilitätsservices wie Uber oder iDrive von BMW; zweitens in der industriellen Fertigung und Logistik, die unter den Schlagworten »Industrie 4.0« (Deutschland) oder »Industrial Internet« (USA) zugleich massive Effizienzsteigerungen wie individualisierte Produktion erleben soll; drittens im Bereich der Infrastrukturen wie dem Stromnetz, wo das so genannte Smart Grid und als Smart Meter bezeichnete computerisierte Stromzähler dezentrale und verbrauchsoptimierte Stromversorgung ermöglichen sollen. Für Verkehrswege wie für die Wasserversorgung werden durch Sensornetzwerke neuartige Steuerungslogiken erwartet; viertens in der Gesundheitsversorgung, wo neben den schon genannten Fitnesstrackern vernetzte Medikamentenpumpen oder Insulingeräte bereits Realität sind, während für die Krankenhauslogistik und für die ambulante Versorgung durch das Internet der Dinge sowohl Effizienzgewinne wie auch neuartige Diagnose- und Behandlungsmöglichkeiten erhofft werden; sowie fünftens, und weniger bekannt, in der agrarindustriellen Produktion, die bereits heute, wie der Beitrag von Ina Bolinski zeigt, Schauplatz des intensiven Einsatzes von vernetzenden Technologien in der Tiermast und der Feldbewirtschaftung ist, wo Sensoren Nahrungsaufnahme und Bewegungsprofile der Nutztiere protokollieren und auf den Feldern Bewässerungs- und Düngezeiten dem lokalen Wetter entsprechend organisiert werden.[33]

Öffentliche Aufmerksamkeit finden vor allem jene Produkte des Internets der Dinge, die auf Konsumenten abzielen. Die Apple Watch, Google Glass oder das Nest-Thermostat sind in die Plattformen von Anbietern wie Apple bzw. Google integriert. Die anderen genannten Bereiche sind jedoch in ihrer wirtschaftlichen Bedeutung und transformativen Potenz ebenso wichtig und könnten sowohl für die Entwicklung der medientechnischen Gestalt des Internets der Dinge Impulse geben wie auch die entscheidenden Monetarisierungsmodelle hervorbringen. Insbesondere öffentliche Infrastrukturen und das Gesundheitswesen sind hochregulierte Bereiche, in denen der Staat als Akteur agiert und regelgebend interveniert. Da das Internet der Dinge die Grenzen zwischen den genannten Bereichen häufig überschreitet und neu definieren wird, ist die Regulationsfrage einerseits offen, kann aber andererseits für den Markterfolg oder das Marktversagen einzelner Anbieter und Projekte entscheidend sein. Zugleich erwarten skeptische Beobachter wie Evgeny Morozov gerade mit dem Internet der Dinge eine weitere Schwächung und schleichende Delegitimierung klassischer staatlicher Interventionspotenz: »Thanks to sensors and internet connectivity, the most banal everyday objects have acquired tremendous power to regulate behaviour.«[34] Die Effizienzgewinne solcher auf dem Potential individueller Adressierung basierender »algorithmic regulation« geraten Morozov zufolge in Konkurrenz zu hergebrachten staatlichen Legitimationsformaten: »Why rely on laws when one has sensors and feedback mechanisms?«[35] In der »algorithmic regulation« – und hier zitiert Morozov einen unveröffentlichten Vortrag von Giorgio Agamben – trete eine epochale Verkehrung der Formen des Regierens ein: »[C]auses and effects are inverted, so that, instead of governing the causes – a difficult and expensive undertaking – governments simply try to govern the effects.«[36] Die Proponenten dieses Wandels verortet Morozov, wie schon in seinem 2013 erschienenen Buch To Save everything click here im technolibertären Umfeld der großen Firmen des Silicon Valleys.[37] Aus wirtschaftlichem Eigeninteresse werde hier das kybernetische Phantasma einer ultrastabilen Regulierung durch Feedback in einer neuen Dimension propagiert, die sich aber zugleich von den klassischen, staatsskeptischen libertären Ideologien signifikant unterscheide: »[I]t’s a mistake to think that Silicon Valley wants to rid us of government institutions. Its dream state is not the small government of libertarians – a small state, after all, needs neither fancy gadgets nor massive servers to process the data – but the data-obsessed and data-obese state of behavioural economists.«[38]

Der Urheber der von Morozov angeführten Wortschöpfung »algorithmic regulation« ist Tim O’Reilly, ein amerikanischer Verleger und prominenter Stichwortgeber der Internetbranche. Er hat 2014 die These aufgestellt, dass das entscheidende Marktmodell des Internets der Dinge, anders als erwartet, Versicherungen seien. Der Informationszugewinn durch abertausende Sensoren und die damit verbundenen Auswertungsmöglichkeiten würden die Risikoabschätzungen der Versicherungsmathematik revolutionieren können: »You know the way that advertising turned out to be the native business model for the internet? I think that insurance is going to be the native business model for the Internet of Things.«[39] Das Beispiel der von der Generali-Versicherung auch in Deutschland beabsichtigen Prämienzahlungen an Kunden, die ihre körperliche Aktivität mittels Fitnesstracker dokumentieren, zeigt, dass O’Reillys und Morozovs Thesen eine mögliche Entwicklung anvisieren könnten.

Demgegenüber steht die Erwartung, dass vor allem der Konsumentenmarkt und Produkte, die in sozialen Netzwerken integriert sind, die Entwicklung des Internets der Dinge vorantreiben werden. Amazon führt mit dem Amazon Echo und den Dash Buttons bereits zwei eher unscheinbar und beinahe vulgär anmutende Beispiele des Internets der Dinge. Beide Produkte dienen zu nichts mehr und nichts weniger als der Erleichterung des Einkaufs auf Amazons Website. Amazon Echo ist ein zylinderförmiges Gerät, das im Haushalt platziert auf Spracheingaben des Nutzers wartet und Bestellungen bei Amazon entgegen nehmen kann. Die Dash Buttons reduzieren den Einkauf bei Amazon auf einen bloßen Knopfdruck. Es handelt sich um gebrandete, mit einem Haftstreifen versehene Druckknöpfe. Ein Amazon Dash Button beispielsweise für Toilettenpapier kann am Verbrauchsort angebracht werden, um auf Knopfdruck via WLAN rechtzeitig Nachschub für die Lieferung am nächsten Tag zu bestellen. Der primitive und triviale Anwendungsfall wird mit dem Bequemlichkeitsgewinn des Kunden begründet, stellt aber zugleich eine Verkaufserleichterung wie auch eine wichtige Datenquelle dar. Ein Beispiel für einen komplexeren Anwendungsfall, der zudem den Marktsektoren übergreifenden Charakter vernetzter Produkte zeigt, ist das Rush Hour Rewards-Programm von Googles smartem Thermostat Nest. Google schließt mit Energieversorgungsunternehmen Verträge ab, bei denen auf Grundlage der über das Nest möglichen Steuerungseingriffe und Datenauswertungen die Klimaanlagen der Kunden in Stoßzeiten großflächig runtereguliert werden.[40] Solches Abmildern von Lastspitzen erlaubt es den Energieversorgern, erhebliche Kosteneinsparungen zu erzielen. Google etabliert sich damit als Akteur im lukrativen Energiemarkt und verdient durch Zahlungen der Energieversorgungsunternehmen, während die teilnehmenden Nest-Nutzer kleine Prämien dafür erhalten, dass sie ihr Haus zu einer Datenquelle machen.

Besonders bei Googles Nest und Apples Homekit kehren Motive wieder, die in den Arbeiten bei PARC prominent waren: das Wohnen und die häusliche Situation als Schauplätze des Internets der Dinge. Nest ist mit dem Anspruch angetreten, bislang langweilige und unbeachtete Aspekte der Wohntechnik mittels smarter Geräte interessant zu machen. Mit solchen Geräten ausgestattete Smart Homes vernetzen, wie am Modellhaus von Microsoft in Redmond oder am house-N-Home of the Future Consortium des MIT deutlich wird,[41] mobile wie immobile Kommunikationsmedien und Einrichtungsgegenstände, passen sich selbsttätig den Bewohnern an und sind von beliebigen Orten außerhalb des Hauses aus permanent erreichbar.[42] Wie Stefan Riegers Beitrag zeigt, steht die Altersversorgung durch Ambient Assisted Living und die smarte Haushaltsführung in einer Tradition der Externalisierung von Arbeits- und Dienstleistungen, die heute automatisiert werden.

Das Internet der Dinge hat sich also gewandelt. War es bei Mark Weiser und auch im Kontext der RFID-Debatten noch als eine lokal emergierende und jeweils zeitlich beschränkte Form der logistischen Koordination von computerisierten Objekten imaginiert, so ist es heute in größere Kontexte der Entwicklung der Internetökonomie sowie der kulturellen und sozialen Möglichkeiten der Vernetzung eingebettet. Kennzeichen dieser Entwicklung ist vor allem die Spannung zwischen Zentralisierung und Peripherie, die unter Bedingungen von Cloud Computing und Big Data Asymmetrien aufweist, die weder bei Weiser noch im RFID-Diskurs präsent waren. Die Ungleichheiten dieses rechnenden Raumes sind längst politischer Natur und durchstoßen Unterscheidungen wie die zwischen Privat und Öffentlich, zwischen Eigentum und Gemeingut, zwischen Inland und Ausland, vielleicht auch zwischen Mensch und Technik. Die Ungleichheiten durchdringen, wie Mercedes Bunz’ Beitrag ausführt, auch die Dinge selbst und verkomplizieren die schlichte Frage, was ein Ding ist. Die in diesem Band versammelten Beiträge möchten für diese Verkomplizierung sensibilisieren und zugleich einen Überblick über die wesentlichen Aspekte an die Hand geben.

Die technologische Bedingung der Gegenwart

Wenn heute oder morgen ubiquitäre Medientechnologien die Grenzen zwischen User und Environment oder privatem und öffentlichem Raum aufzuheben scheinen,[43] wenn jeder Ort, an dem sich ein mobil vernetzter Mensch befindet, dank GPS oder RFID zum Ausgangspunkt einer potentiell weltweiten Adressierbarkeit wird,[44] wenn eine Lokalisierung von der Distribution von Informations- und Energieströmen abhängt[45] und wenn jedes vernetzte Gerät nicht nur um seinen eigenen Ort im Koordinatensystem weltweiter Netze weiß, sondern mit allen anderen angeschlossenen Objekten interagieren kann, dann werden damit klassische Fragen neu aufgeworfen. Sie betreffen das Verhältnis von Mensch und Maschine, von Mensch und Mensch sowie letztlich auch von Maschine und Maschine.

In diesem Sinne will der vorliegende Sammelband in den Blick nehmen, was Erich Hörl als gegenwärtige ›technologische Bedingung‹ beschrieben hat: »Unter der technologischen Bedingung haben die überlieferten Kategorien der Bedeutungskultur und das dazugehörige Anschauungsregime, also die prätechnologischen Zeitlichkeits- und Räumlichkeitsbestimmungen bewusster Subjekte, schlicht ihre Beschreibungsmacht und Evidenz eingebüßt.«[46] In diesem Rahmen verändern ubiquitäre, smarte und mobile Medien die Kulturen der Übertragung in ihren Tiefenschichten. Informationsflüsse weisen weiterhin exponentiell ansteigende Bandbreiten auf, werden untereinander verschaltet und bleiben trotz restriktiver Zugangsregelungen für ihre Datenbanken von überall aus zugänglich. Vor allem aber verbinden diese Informationsflüsse nicht mehr nur Computer mit Computern und Endgeräte mit Endgeräten. Das Internet der Dinge allein als eine Verbundenheit von Recheneinheiten zu verstehen, würde zu kurz greifen. Vielmehr haben wir es zu tun mit Transformationen auf unterschiedlichen Maßstabsebenen und technischen Kontexten, mit Verschiebungen des Verhältnisses von Menschen zur sie umgebenden Welt und mit einer Herausforderung unseres Verständnisses von Dingen durch aktive, vernetzte, smarte Objekte – einer allgemeinen Transformation von Objekthaftigkeit, wie sie Hörl im Anschluss an Gilbert Simondon beschrieben hat.

Drei besonders prominente Stimmen haben sich bereits früh um eine medientheoretische Perspektive auf diese Herausforderungen bemüht und dabei die Verschiebung unseres Fragehorizonts reflektiert. Die Ansätze von Mark Hansen, Katherine Hayles und Nigel Thrift zeigen, dass das Internet der Dinge unsere Fragen nach dem Computer in Frage stellt. Sie stimmen vor allem darin überein, dass sie nicht nur eine Erweiterung der Gegenstandsfelder kultur- und medienwissenschaftlicher Auseinandersetzungen, sondern eine grundsätzliche Reorientierung unseres Nachdenkens über Technik fordern. Das Internet der Dinge kann demnach weder als Werkzeug verstanden werden, das als Zweck intentionalen Mitteln dient, weil seine Dinge keinem instrumentellen Willen Untertan sind, sondern diesen Willen eigenmächtig informieren. Noch kann das Internet der Dinge allein mit dem Instrumentarium eines an Fernsehen, Radio und Kino geschulten Blicks bearbeitet werden, weil es die Instanzen der Wahrnehmung unterläuft, an die sich diese Medien richten. Schließlich würde man das Internet der Dinge aber auch missverstehen, wenn man es lediglich als kontinuierliche Fortentwicklung des Computers oder gar als Supplement oder Extension menschlicher Fakultäten ansehen würde. Vielmehr fordert das Internet der Dinge, wie es Hörl ausdrückt, eine »Reorientierung unserer Erkenntnis- und Seinsweise«[47].

Ubiquitäre Technologien des Mobilen sammeln gegenwärtig, so Mark Hansen, in Form von GPS-lokalisierten Smartphones oder RFID-Chips »riesige Mengen von Verhaltens- und Umweltdaten ohne aktive Beteiligung, Initiative oder auch nur Bewusstsein unsererseits«[48]. Angesichts dieser Neuverteilung nicht nur von Handlungsmacht, sondern auch von sensorischem Vermögen in einem Dauerzustand medialer Übertragung hat Hansen jüngst gefordert, »unsere objekt- und unsere körperzentrierten Modelle von Medienerfahrung zugunsten eines radikal umweltlichen Ansatzes aufzugeben«[49]. Hansen sieht in den Netzen von GPS und RFID eine Ausdehnung des Empfindungsvermögens auf Technologien, wodurch mobile Medien in ein ubiquitäres Netzwerk der Distribution von Informations- oder Energieströmen und schließlich auch von Dingen und Menschen eingewoben werden. So würde die Zentralstellung des Menschen als Instanz des Wahrnehmens durch die allgegenwärtige technische Kapazität in Frage gestellt. Die Bedeutung des menschlichen Subjekts als Empfänger medialer Übertragungen sei aufgehoben oder wenigstens fraglich, weil Medien selbst in der Übertragung Daten zur Organisation ihrer Umgebung sammeln, ohne dabei noch auf die Leistungen der Sinneswahrnehmung angewiesen zu sein.

Die Medien des 21. Jahrhunderts, von denen Hansen spricht, sind kaum noch von Kapazitäten der Repräsentation von Inhalten gekennzeichnet: »Twenty-first-century media compensate for the loss of conscious mastery over sensibility by introducing machinic access to the data of sensibility that operates less as a surrogate than as a wholly new, properly machinic faculty.«[50] Hansen hat den Bruch betont, der in der Situierung der unscheinbaren Arbeitsleistungen von Computern in der Peripherie der Wahrnehmung liegt und der Erweiterung der kognitiven Fähigkeiten von Menschen und Computern durch eine neue Verbindung von Sinnlichkeit und Technik dient: »For what the constitutive and defining invisibility of ubiquitous computing actually foregrounds is the centrality of microtemporal and by definition imperceptible informational flows at the very heart of contemporary sensory experience.«[51] Hansen setzt dazu an, eine Neukonfiguration des Menschen und menschlicher Erfahrung als Bestandteil der vernetzten Medien des 21. Jahrhunderts zu durchdenken.

In our interactions with twenty-first-century atmospheric media, we can no longer conceive of ourselves as separate and quasi-autonomous subjects, facing off against distinct media objects; rather, we are ourselves composed as subjects through the operation of a hist of multi-scalar processes, some of which seem more ›embodied‹ (like neural processing), and others more ›enworlded‹ (like rhythmic synchronization with material events). In today’s media environments, that is, subjectivity is neither set off against a (media) object world, nor different in kind from the microprocesses that inform it.[52]

In ähnlicher Richtung argumentiert Katherine Hayles, dass der Verbund der beiden einflussreichen Technologien RFID und GPS eine Neubestimmung der Grenze zwischen Mensch und Technik, eine Kritik ihrer Politik und eine daraus resultierende Modifikation des Konzepts von Mediation nötig machen. In den hier thematisierten distribuierten Netzen dieser Technologien sieht Hayles ein kognitives Vermögen aufziehen, das nicht nur analog zu Kognition des menschlichen Nervensystems zu verstehen sei, sondern dessen Bindung an ein souveränes Subjekt in Frage stelle – hin zu »a more processual, relational and accurate view of embodied human action in complex environments«[53]. Hayles hat diese Veränderung dessen, was Denken heißt, vor allem am Beispiel der Aufmerksamkeit ausgeführt, die heute durch die Einbindung kybernetischer Rückkopplungsschleifen zu einem technischen Phänomen zwischen Maschine, Subjekt und Environment werde.

Der Geograf Nigel Thrift hat in ähnlicher Stoßrichtung betont, dass die neue Geografie der Verteilung eine zweite Welle der Artifizialisierung des Environments anzeige, in der nach mechanischen nun elektronische Objekte wie Bildschirme, Frequenzen oder Kabel den unsichtbaren Hintergrund und die architektonische Infrastruktur bildeten. Thrift hat dazu den Begriff des ›technologisch Unbewussten‹ fruchtbar gemacht, um Medientechnologien zu beschreiben, die räumliche Anordnungen vornehmen, ohne dabei auf das »benefit of any cognitive input«[54] zurückzugreifen. Unbewusst seien diese Technologien, weil sie in Zeitspannen operieren, die unterhalb der menschlichen Wahrnehmungsfähigkeit liegen, diese Operationen aber mit dem Menschen verschaltet sind – man denke nur an das prominente Beispiel der körperlichen Selbstoptimierung durch Fitnesstracker. So werde »a prepersonal substrate of guaranteed correlations, assured encounters, and therefore unconsidered anticipations«[55] aufgerufen, das Thrift vor allem anhand der technischen Modi der räumlichen Adressierung verfolgt. Das ›technologisch Unbewusste‹, um das es allen drei Autoren geht, meint keine Artikulation eines Begehrens oder Zustands, sondern die Sammlung oder Verteilung von Information ohne Leistung eines menschlichen, bewussten Akteurs: etwa die zahllosen Handlungsketten und automatischen Ereignisse, die in vernetzen und programmierten Umgebungen eines Smart Homes ablaufen, um eine Wohlfühl-Atmosphäre herzustellen. Kein Subjekt übt Kontrolle aus, obwohl die Abläufe in körperliche und mentale Praktiken von Menschen eingelassen sind.

Seit den 1960er Jahren, so Thrift, haben sich die Modi der Verteilung mit ›track-and-trace‹-Verfahren jedoch gewandelt, wofür er drei Gründe angibt: erstens neue Verfahren der Positionsbestimmung durch Laser, Netzwerke, GPS oder Sensortechnologien; zweitens Formalisierungen der Logistik und ihrer beiden Pole Speicherung und Distribution, wie sie sich in Flow Charts sowie Verfahren des Scheduling äußern und heute zum integralen Bestandteil von Produktionsprozessen geworden sind; sowie drittens automatisierte Verfahren der zeitkritischen Berechnung von Prozessen mittels Algorithmen. Diese drei Impulse kulminieren in mobilisierten »geographies of calculation«,[56] in denen Berechnungen nicht mehr von zentralen Geräten gesteuert werden, sondern in zahlreichen Bestandteilen im Raum verteilt angestellt werden. Diese Transformation beruht auf der beständig fortschreitenden und über die Quantität eine neue Qualität gewinnenden Automatisierung der Verfahren von »position and juxtaposition«[57]. So ist es nicht verwunderlich, dass die ersten Nutzer von RFID Walmart und das US-Verteidigungsministerium waren.

Gemeinsam ist diesen drei Positionen, denen man weitere an die Seite stellen könnte, ein Ungenügen an den Erklärungen, die medienwissenschaftliche Ansätze bis dato für die neuartigen medienräumlichen Phänomene anbieten, welche sich im Unterschied zu häufig untersuchten Medien wie Kino, Fernsehen und Telefon nicht mehr auf die Repräsentation von Bildern und Tönen richten, sondern vielmehr die Übertragung von Daten jenseits ihrer Inhalte zum Dauerzustand unserer Umgebungen bis hin zum Internet der Dinge machen.[58] So fordert Hayles eindringlich: »A framework is needed capable of building bridges between human agency and an RFID world without collapsing distinctions between them. Such a framework would allow us to shed the misconception that humans alone are capable of cognition (a proposition already deconstructed with respect to animals and growing shaky with regard to distributed cognitive systems).«[59] Während Hayles ihre Überlegungen am konkretem Beispiel von RFID und GPS entwickelt, bleiben bei Hansen und Thrift die technologischen Bezüge eher vage. Auch der geschilderte Verlust von Souveränität entspricht nicht Machtdispositiven, denen wir uns gegenübersehen. Auf der Ebene der konkreten Techniken zeigt sich schnell, dass die genannten Konzepte wie beschriebenen Phänomene strukturell eng mit dem Problem der Kontrolle und der Geschichte der Kybernetik verknüpft sind.

Infrastrukturen der Kontrolle

In den letzten Jahren sind, durchaus in Übereinstimmung mit diesen Forderungen, Infrastrukturen stärker in den Fokus kultur- und medienwissenschaftlicher Debatten gerückt.[60] Sie wurden, so haben die Ingenieure Neil Gershenfeld, Raffi Krikorian und Danny Cohen bereits 2004 im ersten Paper zum Internet der Dinge angemerkt, viel zu lange als »afterthoughts of architecture«[61] angesehen, könnten nun jedoch smart werden, um sich kostengünstig selbst zu konfigurieren und zu reparieren. Die auftretenden Skalierungsprobleme bei der von Glühbirnen zu Rechenzentren reichenden Vernetzung können demnach nur auf der Ebene der Infrastrukturen gelöst werden. Versteht man als ihr zentrales Charakteristikum die Fähigkeit, zwischen Maßstabsebenen des Mikroskopischen bis zum Makroskopischen durch den Einsatz von Standardisierungen und Modularisierungen zu vermitteln, dann wird der Umfang dieses Vorhabens deutlich: Das Internet der Dinge soll reibungslosen Austausch zwischen allen Skalierungsebenen erlauben, ohne dass der Nutzer etwas davon merken würde. Dafür ist eine massive Aufrüstung der uns umgebenden Infrastrukturen notwendig.

Von diesen Infrastrukturen aus ließe sich eine andere Geschichte des Internets der Dinge schreiben, die ihren Anfang weniger vom Computer als von den Verteilungsnetzen für Energie, Materie und Information her nimmt, die ihnen zugrunde liegen. Schließlich besteht auch die von Gershenfeld, Krikorian und Cohen entworfene Vision zunächst darin, das ›dumme‹ Stromnetz durch ein ›intelligentes‹ Informationsnetz zu ergänzen, indem aus dem Stromnetz ein Internet wird.[62] Dies wiederum führt im Effekt dazu, dass, wie auf der Abbildung zu sehen, eine Neuverteilung von Rechenkraft stattfindet, die an jedem Ort verfügbar sein soll. Es geht nunmehr um die Distribution von Daten und Dingen im Raum. Inwieweit diese Dezentralisierung auf einer Zentralisierung in externen Datencentern beruht, die zur Überwachung der Räume notwendige Sensortechnik zugleich auch kommerziellen Interessen dient und die Neuverteilung letztlich vor allem eine kapitalistische Umverteilung darstellt, diese bislang viel zu selten geführten Debatten drängen sich den Autoren dieses Bandes geradezu auf.

Abbildung 2: Gershenfeld, Neil/Krikorian, Raffi/Cohen, Danny: »The Internet of Things«

Quelle: Scientific American 10 (2004), S. 76-81, hier: S. 79.

Im Internet der Dinge geht es mithin darum, Personen, Wissen oder Objekte zum richtigen Zeitpunkt am richtigen Ort verfügbar zu machen bzw. sie zu steuern oder um ihren Ort zu wissen. Ein Blick auf die Historie von Infrastrukturen, die immer schon diesen Zwecken dienten, erlaubt es, das Internet der Dinge nicht nur in der Computergeschichte zu verorten, sondern vielmehr in den größeren Bogen der Technikgeschichte der kapitalistischen Industrialisierung einzuordnen. Mit den technischen und ökonomischen Innovationen des 19. Jahrhunderts werden, so hat es James Beniger bereits 1986, also noch vor der Vernetzung von Computern, in The Control Revolution detailliert geschildert, die Kontrollmöglichkeiten prekär. Die Krise der Kontrolle, die die Mitte des Jahrhunderts prägt, weil zwar Güter und Informationen auf den neuen Transportwegen von Eisenbahn und Dampfschiff schnell verschickt, aber ihre Verwendung und Verarbeitung in der Ferne nicht kontrolliert werden können, wird durch die Übertragung elektrischer Signale zunächst der Telegrafie besänftigt.[63] Sie stellt die Sicherheit her, an anderen Orten zeitgleich Macht auszuüben, d.h. kontrollierend auch dort einzugreifen, wo der Kontrolleur nicht ist. Die Hand des Staates kann noch weniger als die Hände der Wirtschaft überall intervenieren, wo sie benötigt wird, geschweige denn Schritt halten mit den technischen Neuerungen: »All else being equal, increases in power will always result in increases in speed, which in turn increases the need for control and hence for communication, processing, programming, and decision.«[64]

Die Notwendigkeit der Kontrolle bezieht sich nicht mehr auf lokale Umgebungen oder die Face-to-face-Absprachen der Fabrikdirektoren und Händler, sondern auf Orte, die räumlich entfernt liegen und deshalb zeitkritische Medien benötigen, um ihre unterschiedlichen Zeitebenen aufeinander zu beziehen. Erst dadurch werden die für die Industrialisierung typischen Produktionsketten möglich, in denen an verschiedenen Orten gewonnene Rohstoffe zu Fabriken transportiert, dort in einem überaus zeitkritischen Prozess verarbeitet und an verteilte Populationen verteilt werden. Durch die Industrialisierung der Kontrolltechnologien, der analogen wie später der digitalen Informationsverarbeitung, des Transports, der Kommunikation sowie der bürokratischen Ordnungen, sozialen Geschäftsregeln und des Zeitmanagements kann sich Kontrolle über Produktionsabläufe und Verwaltungsvorgänge zunehmend von ihrer lokalen Gebundenheit lösen. Mit der Elektrizität wird die von Beniger so genannte »Information Society« begründet, die durch Programmierung und rückgekoppelte Kontrolle definiert ist. Telegraf, Dampfschiff und Eisenbahn sowie moderne Brücken, Kanäle und Kabelnetze erlauben im Verbund mit ökonomischen, bürokratischen und politischen Entwicklungen ein Kontingenzmanagement durch die Überwindung räumlicher Distanzen und Zeitbeherrschung, wie es bereits für das Transatlantikkabel angepriesen wurde: »Distance as a ground of uncertainty will be eliminated from the calculation of the statesman and the merchant.«[65] Kontrolle als die Fähigkeit, an anderen Orten Macht auszuüben, muss schnell sein und ist in immer stärkerem Maße von Geschwindigkeit abhängig – möglichst schneller als die Eisenbahn oder das Schnellboot, schneller also als der materielle Transport von Waren. Zugleich beginnen Fabriken mit den neuen Transportwegen der Eisenbahn, ›on the fly‹ zu produzieren, also Rohstoffe sofort nach der Lieferung zu verarbeiten, anstatt sie zu lagern. Dafür aber muss die zeitkritische Verteilung dieser Rohstoffe sichergestellt werden, und dazu braucht es Kommunikation, die schneller ist als der Transport: Telegrafie. Die Sicherheit der Kontrolle basiert auf der Geschwindigkeit der Übertragung. Die Herausbildung kommunikativer und logistischer Infrastrukturen ist somit eine Antwort auf die Herausforderungen der Kontrolle, erlauben sie es doch, durch Kommunikation vermittelt Macht an entfernten Orten auszuüben.

Während seit der frühen Neuzeit die räumliche Verteilung von Kontrolle vor allem im Handel und in der Kolonialisierung durch menschliche Stellvertreter geregelt wurde, wird diese Funktion, so Beniger, seit der Wende zum 20. Jahrhundert zunehmend auch von technischen Agenten übernommen.[66] Entsprechend stellt sich, wie Beniger zeigt, die Frage nach der Handlungsmacht von Stellvertretern, seien sie menschlich oder technisch. Sie verfügen zwar über Anweisungen, doch kann deren Einhaltung aus der Ferne nur nachträglich überprüft werden. Ihr Spielraum wird schon zu dieser Zeit unter dem Titel Agency verhandelt. Bereits um 1600 bezeichnet Agency die Funktion des Stellvertretens, um auf ein spezielles Ziel gerichtete Handlungen zu erreichen, aber auch die Institution, Person oder Sache, die dies vermag.[67] Vor allem in der Diplomatie, aber auch im Handel wird diese Stellvertretungsfunktion wichtig und ist immer an Übertragungsmedien gebunden, die Stellvertreter und Stellvertretene aneinander binden.

Agency bestimmt demnach, inwieweit ein Akteur zwischen autonomem und vorgegebenem Handeln pendeln darf, wenn Kommunikation mit den übergeordneten Instanzen aufgrund räumlicher Entfernung zu lange braucht, um auf lokale Ereignisse adäquat zu reagieren.[68] Das Konzept der Agency, das in gegenwärtigen Debatten um die Actor-Network-Theory und in den Science and Technology Studies diskutiert wird, aber auch die jüngste Rückkehr zu den Dingen in objektorientierten Philosophien anleitet,[69] hat einen seiner historischen Orte also in diesem Kontrollproblem. Es wird seit der Mitte des 20. Jahrhunderts kybernetisch formuliert, heute mit dem Internet der Dinge und mit Ubiquitous Computing neu bearbeitet und, wie Kai Hofmann und Gerrit Hornung in diesem Band zeigen, auch als juristisches Problem diskutiert: Was bedeutet es, wenn Dinge handeln, und wer trägt dann die Verantwortung? Vor dem Hintergrund dieser Geschichte kann man das Internet der Dinge als Versuch verstehen, Kontrolle auf ungekannte Weise räumlich auszudehnen, indem alle Dinge zu Stellvertretern werden und somit über Agency verfügen. Dass sich dabei das Konzept der Handlungsmacht von menschlichen auf nichtmenschliche Akteure verschiebt und die Dinge im Internet der Dinge selbst aktiv werden, schließt an die historische Krise der Kontrolle an. So zeigt sich eine bislang unterbelichtete Dimension von kontrollierter und kontrollierender Handlungsmacht in industriellen Infrastrukturen.

Aus den Rahmenbedingungen dieser Geschichte hat Beniger folgende drei die »Information Society« prägende Dynamiken herausgestellt: erstens eine Abhängigkeit von Kontrolltechnologien, Energieproduktion und Verarbeitungsgeschwindigkeit, die sich in gegenseitiger Beeinflussung entwickeln; zweitens die Verlässlichkeit und Vorhersagbarkeit von Prozessen und Strömen, die wiederum ökonomische Vorteile durch Informationsverarbeitung versprechen; sowie drittens die Tatsache, dass Kontrolle sich im 20. Jahrhundert immer mehr von Materie und Energie hin zu Information gelöst hat, nicht zuletzt weil auch Kontrolle kontrolliert werden muss. Die Beispiele, die Beniger anführt, reichen von den Kontrollmechanismen großer Stromgeneratoren, die zu überaus komplexen Rechenanlagen angeleitet haben, über die Herausbildung von Fahrplänen für den Schiffsverkehr, die durch die Verlässlichkeit von Dampfbooten ermöglicht wurden, bis hin zur bürokratischen Kontrolle der Kontrolleure durch Vorarbeiter, die nicht die Produktion von Waren, sondern die erhobene Information über die Produktion kontrollieren. Alle drei Dynamiken können auf das Internet der Dinge extrapoliert werden: Die Energieversorgung computerisierter Dinge ist erstens zwar weiterhin eine zentrale Herausforderung, aber die notwendigen Akkus haben den Energieverbrauch nicht nur temporär von der Energieproduktion unabhängig gemacht, sondern auch von den Infrastrukturen der Energieverteilung, während zugleich das Frequenzspektrum für drahtlose Übertragung kaum noch mit den Ansprüchen Schritt halten kann. Zweitens wird aus der Verlässlichkeit gesammelter Daten mit Big Data in ungekanntem Maß eine Vorhersagbarkeit extrahiert, welche die Planbarkeit logistischer Prozesse auf das Verhalten von Individuen ausweitet.[70] Und drittens schließlich wird die Bewegung von Materie heute durch autonome Informationsflüsse kontrollierbar, indem Kontrolle im Kontrollierten implementiert wird.

Diese Fortführung des von Beniger beschriebenen Prozesses, der gleichsam die Wurzel der Medienlandschaft des 20. Jahrhunderts bildet, können wir mit dem Internet der Dinge beobachten. Auch hier geht es, wie jüngst die Debatten um die Industrie 4.0 gezeigt haben, um aus der Distanz ausgeübte Kontrolle von Fabrikationsprozessen durch eine Logistik, die von den Dingen, Waren und Produkten selbst geleistet werden soll – nicht nur in der Industrie, sondern auch im zivilen Leben. Das Internet der Dinge antwortet mithin auf diesen Kontrollanspruch durch Erfüllung des kybernetischen Traums, wie ihn das Autorenkollektiv Tiqqun in kritischer Absicht beschrieben hat: »Die ganze Geschichte der Kybernetik ist darauf angelegt, die Unmöglichkeit, gleichzeitig die Position und das Verhalten eines Körpers zu bestimmen, aus dem Weg zu räumen.«[71]

Lokalisierung und Positionierung

Die Konsequenzen der Umsetzung und gleichsam Verweltlichung des kybernetischen Traums sind tief in der technischen Gegenwart verankert. Aktuell, so kann man, wie oben bereits angeführt, mit Nigel Thrift festhalten, befinden wir uns mit Technologien des Tracings und des Trackings in einem Übergang von Verfahren der Adressierung zu Verfahren der Positionierung, in dem die Verteilung von Energie und Information von exaktem Wissen um die Position des Adressaten und Imperativen seiner Positionsnahme ersetzt wird.[72] RFID und GPS, die paradigmatisch für diesen Umbruch stehen, dienen nicht nur der Bestimmung der Position von Menschen oder Dingen, sondern der Positionierung an bestimmten Orten.[73] Sie leisten als adressierende Medien nicht nur die Lokalisierung, sondern auch die Authentisierung – die Entscheidung, ob etwas oder jemand an einem bestimmten Ort sein darf. Daraus wiederum können entsprechende Konsequenzen gezogen werden. In der letzten Dekade wurden dadurch logistische Verfahren in vielerlei Hinsicht revolutioniert, der alltägliche Umgang mit mobilen Medien transformiert und dabei etwa mit der Aufhebung von Öffentlichem und Privatem eine mehrdimensionale Raumpolitik eröffnet, deren Verschiebung der Grenzen von Innen und Außen grundlegende Fragen an unser Verständnis von Umgebungen stellt. Damit geht nicht zuletzt die Notwendigkeit einer Neubestimmung medialer Positionierungsräume einher, in denen Objekte nicht nur in der Übertragung kontinuierlich Adressen zugesprochen bekommen, sondern innerhalb von Netzwerken aus Positionen anderer Objekte lokalisiert sind, die selbst allesamt als Akteure der Vermittlung agieren.

Deutlich wird dies bereits an den ersten drei Geräten, die unter dem Label Ubiquitous Computing bei Xerox PARC vom Team um Mark Weiser entwickelt wurden.[74] Die ersten Versuche, die Dinge mobil zu machen, sind von drei Problemen geprägt: erstens der Batterielebensdauer, zweitens der Bandbreite der verfügbaren drahtlosen Übertragungsmethoden und drittens der Unzulänglichkeit der Protokolle und Standards, die den Austausch zwischen den Geräten regeln sollen. Die drei wichtigsten Innovationen der frühen 1990er Jahre, die mit diesen Problemen umgehen, sind das LiveBoard, eine digitale Wandtafel, das in Buchgröße entworfene ParcPad sowie das handgroße ParcTab. Alle drei Geräte, die als Display, Notebook und Handheld anhand der Größen Yard, Foot und Inch gestaltet werden[75] und denen noch die gegenwärtige Produktstrategie von Apple verdächtig ähnelt, wurden bei PARC über Jahre hinweg verwendet und ihre Nachfolger sind noch heute in Gebrauch.[76]

Alle drei Geräte haben den Raum aufteilende Funktionen: Die fest installierten LiveBoards sollen vernetzt gleiche Inhalte in verschiedenen Konferenzräumen zeigen und so lokale Zusammenkünfte mit entfernten Kollegen ermöglichen. Sie liefern die für solche Übertragungen nötigen Rechen- und Darstellungskapazitäten und erlauben darüber hinaus eine Vernetzung entfernter Orte, an denen identische Inhalte repräsentiert werden. Liest man diese heute trivial erscheinende Innovation vor dem Hintergrund damaliger Technikentwicklung, wird deutlich, welcher Umbruch der Arbeitswelt sich hier ankündigt. Eines der von Xerox vorgegebenen Ziele des Projekts ist naheliegenderweise die Förderung von Heimarbeit und »telecommuting«. Alle drei Geräte sollen es den Mitarbeitern von zu Hause aus erlauben, sich in die »cycles of activity« am Arbeitsplatz einzuklinken, die sich damit tendenziell vom Ort des Büros lösen oder vielmehr auf neue Weise in ihm verankert werden.

Während LiveBoards unbeweglich sind, liegen Pads herum und werden nicht ständig am Körper getragen. Sie sind mit Touchscreens ausgestattet und nicht personalisiert, sondern sollen vielmehr ihre User zunächst durch Passwörter, später aber auch durch Fingerabdrücke oder Lokalisierungsverfahren erkennen und entsprechend Zugriff auf deren Daten ermöglichen. Sie sind mittels lizenzfreier Kurzwellenübertragung mit 250 kbps über Transceiver in jedem Raum an drahtlose Netzwerke angeschlossen. Technologien wie RFID, WiFi, ZigBee oder Bluetooth stehen noch nicht bereit. Jeder soll jedes Pad benutzen können. Besitz wird durch Mobilität ersetzt. Ein Tab ist also im Unterschied zu den heutigen Smartphones und Tablets kein hyperpersonalisiertes Objekt. Vielmehr lässt man ein nicht mehr benötigtes Pad vor Ort liegen, bis es vom nächsten Kollegen in Anspruch genommen wird, was selbstredend gerade in einer so offenen Bürolandschaft wie der von PARC sinnvoll ist, wo in den Konferenzräumen Sitzsäcke statt Bürostühle stehen.

Die Tabs, mit drei Tasten und ebenfalls einem Touchscreen versehen, in einer einfacheren Variante auch als vernetztes Namensschild gestaltet, werden mit ihrem User identifiziert und dienen zu dessen Lokalisierung innerhalb eines definierten Raums. So können sich die Mitarbeiter untereinander Nachrichten schicken, Daten austauschen, die Klimaanlage bedienen oder Spiele spielen. Tabs kommunizieren auch ohne Wissen des Users untereinander über den Kontext des jeweiligen Ortes und die Umgebung, um so genaue Informationen darüber darstellen zu können, wer bei wem, wo welcher Netzwerkzugang vorhanden oder an welchem Ort es so leise ist, dass ruhiges Arbeiten möglich ist.[77] Gerade diese Frage des Kontexts oder des Environments des jeweiligen Geräts ist bis heute eine technische Herausforderung, denn zum einen muss dazu konstant Information zum Gerät übertragen werden, um es bei dessen Bewegung über die veränderten Zustände des Environments auf dem laufenden zu halten, wozu zeitkritische Synchronisationsvorgänge nötig sind. Zum anderen stellen das Erkennen der Umgebung und die Definition ihrer Variablen ein großes Hindernis dar. Technisch basieren die Tabs auf schlichter Infrarotübertragung, die eine Übertragungsrate von bis zu 10 kbps erlaubt und eine gewisse Nähe zu Lesegeräten erfordert, also die räumliche Konzentration auf bestimmte Punkte. Tabs geben mittels dieser Überwachung jedem User eine Adresse.

Abbildung 3: Weiser, Mark: »Some computer science issues in ubiquitous computing«

Quelle: Communications of the ACM 36 (1993), S. 75-84, hier: S. 78.

Auf einer Karte, die auf LiveBoards und Pads angezeigt werden kann, wird die Position jedes Users innerhalb des Gebäudes durch kleine Icons visualisiert. Diese Lokalisierung dient unter anderem dazu, Anrufe an das nächstgelegene Telefon weiterzuleiten, den Fahrstuhl automatisch auf der richtigen Etage anhalten zu lassen oder anzuzeigen, wer sich noch für das beginnende Football-Match interessiert. Als tauglichste Funktion stellt sich schnell die Möglichkeit heraus, drahtlos im ganzen Gebäude die aktuelle Arbeitslast der Kaffeemaschine überwachen zu können. Sie wird mit einem Tab ausgestattet, über das immer dann, wenn neuer Kaffee gebrüht ist, eine Nachricht an alle Mitarbeiter versandt wird, die daraufhin die Küche aufsuchen – den wichtigsten kommunikativen Umschlagsplatz jedes Büros. Von durchsichtigen Interfaces, wie sie Weiser vorschweben, oder Geräten, die eigenständig operieren, ist man jedoch noch weit entfernt. Stattdessen muss man sich mit altmodischen Stromnetzen beschäftigen und Kabel verlegen. Die an der Decke befestigten Transceiver, die den Raum und die in ihm befindlichen Tabs überwachen, werden per Kabel an das bestehende lokale Netzwerk angeschlossen, wozu lediglich eine Verbindung mit den vorhandenen Workstations nötig ist: »We thus had to string only a small amount of additional phone cable to connect ceiling-mounted transceivers to our UNIX-workstations and, through them, to the Ethernet.«[78] Auch wenn in diesem Aufsatz auf die Frage der Energieversorgung nur am Rande eingegangen wird und diese Aspekte in den Patenten eine bemerkenswert marginale Rolle spielen, sind alle Geräte weiterhin vom Stromnetz abhängig.

Abbildung 4: Weiser, Mark: »The Computer for the 21st Century«

Quelle: Scientific American 265/3 (1991), S. 94-104, hier: S. 99.

In einer ersten Annäherung kann man anhand dieser drei Geräte drei Formen eingebauter Mobilität unterscheiden, die einer »automatic production of space«[79] dienen, wie sie Nigel Thrift und Shaun French beschrieben haben: die Versammlung und Verschaltung von Versammlungen untereinander und für mehrere User vor einem Gerät, die Bereitstellung lokaler, netzwerkfähiger Pads für beliebige User innerhalb vorgegebener Räume sowie die Lokalisierung durch Tabs, mit denen Individuen koordiniert werden können. Funktional sind diese drei Ebenen eng aneinander gekoppelt und werden mittels eigener Protokolle so aufeinander abgestimmt, dass die PARC-Mitarbeiter fugenlos zwischen ihren Funktionen wechseln können. Sie bilden mithin eine Umgebung, die nicht von einem zentralen Ort definiert ist und keinem cartesischen Koordinatensystem entspricht, sondern in der vielmehr die Position von Objekten von der Position anderer Objekte abhängt. Alle Objekte verfügen über Sensoren oder Netzwerkzugänge, die es ihnen erlauben, die Geräte in ihrer Nähe zu erfassen. Aus den gesammelten Daten wird ein relationales Feld berechnet, das die Positionen aller Objekte und ihr Verhältnis zueinander abbildet. Implementiert ist damit eine Konnektivität von Dingen, die untereinander in Verbindung treten, sich als Sender und Empfänger gegenseitig orientieren und ihre Funktionen ergänzend zu einem Kontinuum des Gebrauchs verweben.