0,49 €

Mehr erfahren.

- Herausgeber: via tolino media

- Kategorie: Geisteswissenschaft

- Sprache: Deutsch

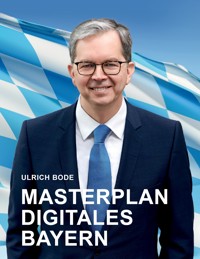

Warum kommt die Digitalisierung der bayerischen Behörden nur schleppend voran? In seinem neuen Buch "Masterplan Digitales Bayern" zeigt Ulrich Bode die Schwierigkeiten auf, beschreibt die Akteure und entwickelt die Lösungswege. Darüber hinaus schildert er die Entwicklungen in Deutschland als auch auf europäischer Ebene. Am Ende steht der Masterplan für Bayern. Ein leistungsstarkes E-Government ist längst überfällig – und machbar.

Das E-Book können Sie in Legimi-Apps oder einer beliebigen App lesen, die das folgende Format unterstützen:

Veröffentlichungsjahr: 2023

Ähnliche

Masterplan Digitales Bayern

Ulrich Bode

Bibliografische Information der Deutschen Nationalbibliothek:

Die Deutsche Nationalbibliothek verzeichnet diese Publikation in der Deutschen Nationalbibliografie; detaillierte bibliografische Daten sind im Internet über

http://dnb.dnb.de abrufbar.

© Ulrich Bode

Alle Rechte vorbehalten.

Verlag: Trochos GmbH, Georg-Koch-Str. 4, 82223 Eichenau, Deutschland

Druck: WIRmachenDRUCK GmbH, Mühlbachstraße 7, 71522 Backnang

Mitarbeit: Barbara Niedner

Porträtfotos Bode: Christoph Vohler

Coverbild Flagge: iStock.com/bkindler

Erstveröffentlichung: 22. Mai 2023

Das Werk, einschließlich aller seiner Teile, ist urheberrechtlich geschützt. Jede Verwertung ist ohne Zustimmung des Verlages unzulässig. Dies gilt insbesondere für Vervielfältigungen, Übersetzungen, Mikroverfilmungen und die Einspeicherung und Verarbeitung in elektronischen bzw. digitalen Systemen.

ISBN 978 3 938277 07 2 » eBook

ISBN 978 3 938277 08 9 » Hardcover

http://masterplan.bayern

Inhalt

Grußwort Dr. Volker Wissing 15

Vorwort 19

1 Mensch und Digitalisierung 23

1.1. Chancen und Risiken 23

1.2. Digitalisierung und Demokratie 24

1.3. Mensch und Gesellschaft 26

1.4. Human Factors 29

2 Digitale Zukunft 33

2.1. Virtualisierung 35

2.2. Vernetzung und Globalisierung 36

2.3. Qualität und Agilität 37

2.4. Komplexität und Nachhaltigkeit 38

2.5. Resilienz und IT-Sicherheit 41

2.6. Modellbasierte Entwicklung 43

2.7. Prognose und Simulation 47

2.8. Künstliche Intelligenz 49

2.9. Additive Fertigung 52

2.10. Kryptografie 56

2.11. Digitales Geld 58

2.12. Quantencomputing 60

2.13. Web X.0 60

3 Digitale Anwendungen 65

3.1. Steuern 65

3.2. Gesundheit 68

3.2.1. Gesundheitsbürokratie und die gematik 69

3.2.2. Digitale Gesundheitsanwendungen 75

3.2.3. Digital Reality – die Reise durch den Körper 76

3.2.4. Passgenau durch 3D-Druck 77

3.2.5. Perfektion durch Simulation 77

3.2.6. Personalisierte Medizin 78

3.2.7. Die Gesundheitsvorhersage 79

3.3. Pflege 80

3.4. Bildung 82

3.4.1. Lernwelt Schule 83

3.4.2. Bayerische Schulen 96

3.4.3. Die Schule der Zukunft 98

3.5. Wissenschaft 102

3.6. Rechtswesen 103

3.7. Arbeit 107

3.8. Wirtschaft 110

3.9. Finanzwesen 111

3.10. Sozialpolitik 114

3.11. Umwelt 116

3.12. Energie 118

3.13. Mobilität 120

3.14. Innenpolitik 122

3.15. Bauen 124

3.16. Landwirtschaft 127

3.16.1. Digitale Transformation 128

3.16.2. Virtueller Bayern-Hof 128

3.16.3. Urform und High-Tech 130

4 Digitaler Staat 133

4.1. Der föderale Rahmen 134

4.1.1. Grundgesetz 134

4.1.2. Bundesländer 137

4.1.3. Kommunen 138

4.2. E-Government 141

4.2.1. Open Government 145

4.2.2. Digitale Souveränität 147

4.2.3. Gewaltenteilung 150

4.2.4. Virtualisierung 151

4.2.5. One face to the citizen 153

4.2.6. Once-Only Prinzip 154

4.2.7. No-Stop-Shop 156

4.2.8. Zero Downtime 157

4.2.9. Data Only 158

4.2.10. Digital-Check 160

4.2.11. Digital first 161

4.2.12. GovTech 162

5 Bürger und Staat 165

5.1. Smart City und Smart Region 165

5.2. Freie und vertrauliche Kommunikation 166

5.2.1. Digitale Öffentlichkeit 168

5.2.2. Digitale Privatheit 170

5.3. Informationelle Selbstbestimmung 171

5.4. E-Government Gesetz 172

5.5. Vertrauensdienste 173

5.6. Online-Ausweis 174

5.7. Bezahlen 176

5.8. Nutzerkonto und Portale 176

5.9. E-Mail und Postfächer 177

5.10. Messenger 178

5.11. E-Akte 179

5.12. Web 4.0 182

5.13. Bürokratieabbau 184

5.14. Registermodernisierungsgesetz 187

5.14.1. Identifikationsnummer 189

5.14.2. Persönlichkeitsprofil 190

5.14.3. Datencockpit 192

5.15. Onlinezugangsgesetz 192

5.15.1. Nachnutzungsmodelle 199

5.15.2. Harmonisierung 209

5.15.3. Integration 211

5.16. Netzneutralität 214

5.17. Vorratsdatenspeicherung 218

5.18. Netzwerkdurchsetzungsgesetz 219

5.19. Telekommunikationsgesetz (TTDSG) 220

5.20. Cybermobbing und Internet-Hetze 220

5.21. Computer- und Cyberkriminalität 220

5.22. Cyber-Lagezentrum 222

5.23. Katastrophenschutz 223

6 Digitale Welt 225

6.1. International 226

6.1.1. Estland 227

6.1.2. GovStack 229

6.2. Europa 230

6.2.1. Digitale Dekade 230

6.2.2. Digitale Rechte 232

6.2.3. Datenschutzrecht (DSGVO) 233

6.2.4. Digital Services Act 234

6.2.5. Digital Markets Act 235

6.2.6. Chip-Souveränität 237

6.2.7. Cybersecurity 239

6.2.8. Open Data 240

6.2.9. Single Digital Gateway 240

6.2.10. EU-eGovernment-Aktionsplan 241

6.2.11. Interoperabilität 242

6.2.12. Regulierungsstellen (GEREK) 243

6.2.13. E-Rechnung 243

6.3. Bund 245

6.3.1. Deutscher Bundestag 245

6.3.2. Bundesregierung 246

6.3.3. Digitalkabinett 250

6.3.4. Digitalministerium 250

6.3.5. Behörden und Gremien 254

6.3.6. Kommunale IT-Dienstleister 277

6.3.7. IT-Vergabeverfahren 281

6.3.8. Digitale Netze 283

7 Die Lage in Bayern 295

7.1. Akteure 296

7.1.1. Bayerischer Landtag 296

7.1.2. Bayerisches Digitalministerium 297

7.1.3. Bayerisches Finanzministerium 302

7.1.4. Bayerisches Innenministerium 303

7.1.5. Weitere Bayerische Ministerien 304

7.1.6. Landesamt für Digitalisierung 307

7.1.7. Landesamt für Sicherheit 309

7.1.8. Bayern Innovativ 311

7.1.9. Munich Quantum Valley 312

7.1.10. Forschungsinstitut bidt 312

7.1.11. Datenschutz 313

7.1.12. Arbeitsgruppe Cyberabwehr 314

7.1.13. Beauftragter für Bürokratieabbau 314

7.1.14. Kommunale IT-Dienstleister 314

7.2. Bayerischer Koalitionsvertrag 2018 318

7.3. Digitalgesetz 320

7.4. Digitalplan 332

7.5. Digitale Netze 333

7.6. Bayerische Wirtschaft 335

7.6.1. Chip-Industrie 337

7.6.2. Start-ups 338

7.7. Bayerns Kommunen 339

7.7.1. Digitale Kommunalverwaltung 340

7.7.2. Dresdner Forderungen 343

7.7.3. BayernFunk 344

8 Masterplan Digitales Bayern 345

8.1. Deutschland, VW & Co. 345

8.2. Strategie für Bayern 351

8.3. Digitalministerium 352

8.4. Landesämter 356

8.5. Kompetenzzentrum für Qualität und Sicherheit in der IT 357

8.6. CIO Bayern 359

8.7. Komplexitätsmanagement 359

8.8. Normen und Standards 360

8.9. Wettbewerb 360

8.10. Konzept kommunale IT 361

8.10.1. Teil-Privatisierung der AKDB 362

8.10.2. Im gesetzlichen Auftrag 362

8.10.3. Software as a Service 362

8.10.4. App Store 364

8.10.5. Leistungsstarke Qualitätssicherung 364

8.10.6. Umfassende Cloud 365

8.10.7. Innovative Beschaffung 365

8.10.8. Kompetente Beratung 366

8.10.9. Horizontale Kooperation 366

8.10.10. Vertikale Kooperation 366

8.10.11. Zusammenfassung 367

8.11. IT-Architektur 367

8.11.1. Geschäftsarchitektur 369

8.11.2. Informationssystemarchitektur 369

8.11.3. Technologiearchitektur 374

8.12. Blueprint 374

8.12.1. IT-Betrieb 375

8.12.2. Softwareentwicklung 376

8.12.3. Komplexitätsmanagement 377

8.13. Zusammenfassung und Fazit 378

Autor 381

The Making of Digital 383

Grußwort Dr. Volker Wissing

Liebe Freundinnen und Freunde des digitalen Fortschritts,

Wer ab und zu ins Ausland reist, stellt fest: Andere sind beim Thema Digitalisierung deutlich weiter als wir. Schauen wir nur mal auf die Jahre der Pandemie: Während man sich in anderen Ländern beim Betreten eines Restaurants längst per App einloggen konnte, haben wir noch monatelang Fragebögen auf Papier ausgefüllt – per Hand und mit Kugelschreiber. Dass Gesundheitsämter bei uns nur per Fax zu erreichen waren, traut man sich gar nicht, laut zu sagen. Nach dem Europäischen Index für die digitale Wirtschaft und Gesellschaft belegt Deutschland im Vergleich der 27 EU-Mitgliedstaaten gerade mal Platz 13. Ein Wirtschaftsstandort wie unserer, der es gewohnt ist, in der Topliga zu spielen, kann sich das nicht leisten.

Deshalb ist klar: Wir brauchen einen digitalen Aufbruch! Dafür hat die Bundesregierung eine Digitalstrategie beschlossen. Sie führt erstmals die digitalpolitischen Schwerpunkte aller Ministerien zusammen und zeigt sehr konkret, wie der Staat das Leben der Bürgerinnen und Bürger mit Hilfe der Digitalisierung verbessern will.

Dabei haben wir drei Hebelprojekte definiert, die Grundlage für viele digitale Anwendungen sind. Das sind zum einen die Digitalen Identitäten, die wir dringend brauchen, um Leistungen und Dienste im Netz sicher nutzen zu können, also etwa bei Online-Behördengängen, bei Gesundheitsdienstleistungen, beim Beantragen des Personalausweises, aber auch beim Online-Shopping.

Ein weiteres Hebelprojekt betrifft internationale, einheitliche technische Standards. Sie ermöglichen Interoperabilität, sprich: Sie sorgen dafür, dass alles zusammenpasst.

Der Gigabitausbau und eine deutlich höhere Verfügbarkeit von Daten sind ebenfalls ein Hebelprojekt. Daten sind der Schlüssel für digitale Innovationen. Wenn man sie analysiert, aufbereitet, verknüpft, können daraus neue Geschäftsmodelle entstehen, neue Produktionsweisen und optimierte Abläufe. Deshalb wollen wir Daten leichter verfügbar und nutzbar machen – mithilfe von Datenräumen, die einen rechtssicheren Austausch von Daten ermöglichen.

Ineffiziente Doppelstrukturen, also digital und analog parallel zu arbeiten, wollen wir abschaffen. Es passt nicht zu einem modernen Land, wenn wir Formulare erst am Computer ausfüllen, um sie anschließend auszudrucken und zur Post zu bringen, oder dass wir bei Behördengängen immer wieder die gleichen Fragen zu Adresse, Geburtsdatum und Telefonnummern beantworten müssen.

Stattdessen wollen wir ein digitales Deutschland, in dem alle ihre Behördengeschäfte digital erledigen können – bequem und unkompliziert am heimischen PC oder direkt per Smartphone; ein Deutschland, in dem Patientinnen und Patienten virtuell mit ihren Ärzten sprechen, Erwerbstätige digital arbeiten können, Unternehmen effizienter und nachhaltiger wirtschaften und der ÖPNV mit dem bundesweiten digitalen Deutschlandticket zu einer echten Alternative wird.

Die gute Nachricht ist: Wir sind längst mittendrin in der Umsetzung unserer Digitalstrategie. Alle Ministerien arbeiten mit Hochdruck daran. Bis 2025 wollen wir es so unter die Top Ten in Europa schaffen. Und ich bin überzeugt: Gemeinsam kann uns das gelingen. Denn wir wissen: Digital wird alles einfacher. Und einfach ist besser.

Ihr

Dr. Volker Wissing, MdB

Bundesminister für Digitales und Verkehr

Vorwort

Seit 1990 standen alle Instrumente bereit, um öffentliche Verwaltungen mit vertretbarem Aufwand vollständig zu digitalisieren. Wir hatten damals bereits Server, PC mit Grafikmonitor, Netzwerke, Scanner, relationale Datenbanken mit SQL-basierten Programmiersprachen (4GL) und methodische Arbeitsweisen. Ab etwa dem Jahr 2005 war das Internet leistungsfähig genug, um auch Bürgern Online-Behördengänge zu ermöglichen.

Leider ist eine wohlstrukturierte, hochautomatisierte und agile Digitalisierung in der öffentlichen Verwaltung noch immer nicht der Standard. Deutschland und Bayern laufen der Entwicklung hinterher. Die Gründe sind vielfältig: schwergängiger Föderalismus, fehlende Kompetenz, mangelhafte Konzeption und unzureichende Koordination.

Rund 3,5 Mrd. Euro wurde allein für die 2017 gestartete Umsetzung der Online-Behördengänge (Onlinezugangsgesetz) veranschlagt. Mit einem Teil des Geldes wäre es möglich, Software zu entwickeln, die 99% der Kommunen komplett einschließlich der Fachverfahren versorgt und den Bürgerinnen und Bürgern den vollen Leistungsumfang digitaler und stark automatisierter Verfahren bietet. Denn die Kommunen tragen den größten Teil der bürgernahen Verwaltungsleistungen.

Dieses Buch soll ein Beitrag zur Digitalisierung in Bayern und darüber hinaus sein. Bayern ist eingebettet in die internationale, europäische und deutsche Digitalisierung der öffentlichen Verwaltung sowie von Wirtschaft und Gesellschaft. Diesen Rahmen gilt es zu berücksichtigen.

Bedauerlicherweise partizipiert die Öffentlichkeit bislang nur im geringen Umfang an den Fachdiskussionen. Insbesondere fehlen Experten aus der Informatik im Diskurs. In der Politik sind die Aktivitäten zu oft von aktionistischem Bemühen, denn strategischer Orientierung geprägt.

Das Buch ist daher mit folgenden Zielen zur Digitalisierung konzipiert:

Politik und interessierter Öffentlichkeit einen Überblick über Aktivitäten und Akteure zu geben.Das Wissen der in der Informatik Tätigen für die fachliche Fundierung der Digitalisierung im öffentlichen Bereich einzuwerben.Entwicklung konkreter Gestaltungsvorschläge für die Digitalisierung und Aufzeigen von Strategien.Als Kompendium führt das Buch viele Themen zusammen und strukturiert diese. Die Grundstruktur führt vom Allgemeinen zum Speziellen. Forderungen sind in einem Block zusammengefasst.

Kapitelübersicht

Allgemeine Trends in der Digitalisierung

Die ersten drei Kapitel „Mensch und Digitalisierung“, „Digitale Zukunft“ und „Digitale Anwendungen“ beschäftigen sich mit Wirkung und Nutzen der Digitalisierung für die Allgemeinheit.

Bürger und Staat

Das Kapital „Digitaler Staat“ zeigt die Strukturen und Instrumente für die Digitalisierung des Staates an sich auf. „Bürger und Staat“ führt dies weiter im Verhältnis zu den Bürgern als Nutzer digitalisierter Leistungen.

Aktivitäten der verschiedenen staatlichen Ebenen

Im Kapitel „Digitale Welt“ werden die Akteure dargestellt, zunächst im internationalen Rahmen, anschließend Europa und die Bundesrepublik. Das Kapitel „Digitales Bayern“ beschäftigt sich ausführlich mit den verschiedenen Facetten der Digitalisierung in Bayern.

Masterplan für Bayern

Abschließend führt der „Masterplan Digitales Bayern“ die wichtigsten Erkenntnisse und anstehenden Aufgaben für Bayern in einem Zukunftskonzept zusammen.

Die Quellen sind durch Fußnoten referenziert. Da es sich nicht um ein wissenschaftliches Werk handelt, habe ich auf eine formale Zitierung zugunsten der besseren Lesbarkeit verzichtet. Teilweise sind Textfragmente fließend integriert, wobei die jeweilige Rechtsschreibung und Gendersprache weitgehend beibehalten wurde.

Das Buch ist auch für IT-Laien verständlich. Technische Details sind an einigen Stellen ergänzend für IT-Experten dargestellt und können für das Gesamtverständnis übergangen werden. Grundkenntnisse zur Digitalisierung vermittelt mein Buch „The Making of Digital“.

Ich bedanke mich bei allen aus Beruf und Politik, die mit wertvollen Anregungen und Diskussionen zum Gelingen dieses Buches beigetragen haben. Mein besonderer Dank gilt dem Digitalminister Dr. Volker Wissing, den Abgeordneten Maximilian Funke-Kaiser, Sandra Bubendorfer-Licht, Martin Hagen und Dr. Helmut Kaltenhauser sowie den Mitgliedern des Digitalrats. Der Digitalrat ist ein Thinktank, der Empfehlungen zur Digitalisierung in allen Lebensbereichen erarbeitet. Der Digitalrat unterstützt direkt den Landesvorsitzenden der FDP Bayern, Martin Hagen.

Ulrich Bode

Mai 2023

Die Digitalisierung hat einen epochalen Wandel in allen Bereichen ausgelöst. Wirtschaft und Gesellschaft befinden sich in einem grundlegenden Veränderungsprozess. Die Menschheit erschafft sich eine neue, digitalisierte Welt.

Chancen und RisikenDie Digitalisierung bietet Chancen der Demokratisierung von Wissen, für mehr soziales Miteinander und Teilhabe. Die Individualisierung der Arbeitswelt, die globale Zusammenarbeit und digitalisierte Produkte sind großartige Möglichkeiten für eine fortschrittliche Welt. Die Medizin wird sich durch Digitalisierung erheblich weiterentwickeln. Menschen können Einschränkungen überwinden, wenn sie die Dienste von Robotern und digitalen Systemen nutzen. Digitalisierung bietet die Chance auf mehr Freiheit für jeden Einzelnen.

Weizenbaum-Institut

Das vom Bundesministerium für Bildung und Forschung (BMBF) geförderte Weizenbaum-Institut1 (Deutsche Internet-Institut) erforscht interdisziplinär und grundlagenorientiert den Wandel der Gesellschaft durch die Digitalisierung und entwickelt Gestaltungsoptionen für Politik, Wirtschaft und Zivilgesellschaft. Namenspate des Instituts ist der deutsch-amerikanische Informatikpionier Joseph Weizenbaum (1923 – 2008), der sich kritisch mit dem Verhältnis zwischen Mensch und Maschine auseinandergesetzt hat und sich für einen verantwortungsvollen Umgang mit der Technik engagierte.

Doch gibt es auch Risiken. Die Digitalisierung führt zu Technologien, die die totale Überwachung ermöglichen. Jeder Schritt kann überwacht werden und jede Handlung gespeichert werden. Die Digitalisierung lässt Vorlieben und Abneigungen erkennen, ungenannte Wünsche und Pläne erahnen. Digitale Systeme können unsere Gedanken und Emotionen erkennen, ob wir die Wahrheit sagen oder lügen. Die umfassende Kontrolle und Manipulation, wie sie in dem Roman Nineteen Eighty-Four (1984) von George Orwell skizziert wird, ist machbar geworden. Nicht nur der Staat kann über solche Technologien verfügen, sondern letztlich jeder. Die Digitalisierung birgt das Risiko der völligen Unfreiheit.

Forderungen

Digitalisierung trägt dazu bei, die Lebenschancen und Lebensoptionen von Menschen zu erweitern.Gesellschaft und digitale Systeme sind resilient gegen Angriffe auf die Freiheit von innen und außen.Digitalisierung unterstützt die Entbürokratisierung und Kostensenkung der öffentlichen Verwaltung für alle Beteiligte.Digitalisierung und DemokratieDigitalisierung braucht Demokratie. Digitale Werkzeuge können sehr mächtig sein und ein unmenschliches System errichten. Eine leistungsfähige Digitalisierung erlaubt es, mit wenigen Stellschrauben in kurzer Zeit einen Staat zu kippen. Deshalb muss eine Demokratie strukturell wehrhaft gestaltet werden. Wir werden in späteren Kapiteln entsprechende Instrumente kennenlernen, etwa das Cockpit zur Kontrolle im Rahmen der Registermodernisierung oder die Transparenz der Prozesse bei FIM.

Die Digitalisierung bietet aber auch neue Chancen. Sich zu informieren, auszutauschen und zu beteiligen ist einfacher geworden, selbst im internationalen Maßstab. Konterkariert wird dies durch Zunahme von Falschinformationen und Hassreden.

Um das Verhältnis von Digitalisierung und demokratischen Öffentlichkeiten angemessen zu erfassen, sind laut Leopoldina2 vier Aspekte zu berücksichtigen:

die Digitalisierung von Infrastrukturen demokratischer Öffentlichkeiten wie etwa Wikipedia, die Veränderung von Information und Kommunikation durch digitale Medien, die Erweiterung von demokratischer Partizipation durch neue, digitale Formate sowie der Wandel politischer Selbstbestimmung.Die Leopoldina empfiehlt unter anderem die Suchalgorithmen von Plattformen wie Facebook, Twitter, YouTube und Instagram durch externe Experten überprüfen zu lassen und transparent zu machen. Datenbestände der Plattformen sollen für Forschungszwecke zugänglich gemacht werden und ein Verbandsklagerecht eingerichtet werden.

Forderungen

Digitalisierung braucht mutige Unternehmen, aber auch einen wohlfunktionierenden Rechtsstaat. Digitalisierung ist ohne eine entwickelte und widerstandsfähige Demokratie eine Bedrohung. Aber nur, wer auch entschlossen die Chancen ergreift, wird teilhaben können.Staatliche Aufgaben sind, den ordnungspolitischen Rahmen für die Digitalisierung voranzutreiben sowie leistungsfähige Strukturen für Demokratie und Recht sicherzustellen.Die Verfahren und eingesetzten Technologien sind transparent zu machen, etwa durch Open Source, veröffentlichte Verfahrensbeschreibungen (Spezifikationen) sowie individuelles Monitoring der Aktivitäten (Cockpit). Mensch und GesellschaftInterview mit Dr. Helmut Kaltenhauser3, Mitglied des Bayerischen Landtags.

Dr. Helmut Kaltenhauser ist FDP-Mitglied und Mitglied des Bayerischen Landtags. Er studierte Mathematik an der Universität Würzburg und war viele Jahre Abteilungsleiter für das Rechnungs- und Meldewesen sowie Digitalisierung bei der Landesbank Hessen-Thüringen. Er ist im Landtag Mitglied im Ausschuss für Staatshaushalt und Finanzfragen und im „Untersuchungsausschuss Maske“. Er gehört der Datenschutzkommission, Kontrollkommission BayernFonds und dem IuK-Beirat an. Als stv. Mitglied gehört er dem Beirat beim Unternehmen Bayerische Staatsforsten an.

Ulrich BODE: Ich würde gerne jenseits der Gremien und technischen Details mit Dir über die Digitalisierung sprechen. Wo siehst Du die wesentlichen Veränderungen?

Dr. Helmut KALTENHAUSER: Durch die digitale Transformation ergeben sich für die Menschen zuerst einmal große Veränderungen bei der Information und Kommunikation. Wir haben eine steigende Geschwindigkeit der Informationsversorgung, eine unüberschaubare Menge an Informationen, mit vielen Falsch-Informationen darunter. Und die Informationen, die uns angeboten werden, sind gerade in den Social Media oft auch sehr einseitig, das heißt wir bewegen uns in sogenannten Informationsblasen. Also insgesamt sind die Gefahren: zu viel, falsch, einseitig. Deshalb brauchen wir mehr Medienkompetenz, etwa Quellen prüfen, Informationen abgleichen, unterschiedliche Quellen verwenden, Meinung und Fakten auseinanderhalten. Und das ist nicht nur eine Frage der schulischen Bildung, auch Erwachsene müssen lernen, zum Beispiel die verwendeten Informationsquellen kritisch zu prüfen.

BODE: Die Digitalisierung bietet aber auch Chancen. Es wäre schön, wenn der Staat die Behördengänge wieder einfacher und verständlicher macht, ganz im Sinne von schlankem Staat.

KALTENHAUSER: Absolut! Das fängt beim Staat an, der die Gesetze, Verordnungen, Regeln einfacher und verständlicher darstellen kann, beispielsweise indem Details im Hintergrund abgelegt werden. Die Abläufe für den Bürger kann der Staat wesentlich vereinfachen, aber auch transparenter machen, ganz im Sinne eines schlanken Staats. Die Digitalisierung von Prozessen – und das ist etwas anderes als die digitale Kopie von bisherigen analogen Abläufen – bietet eine einmalige Gelegenheit, sich stärker auf den Nutzer, hier also den Bürger zu konzentrieren.

BODE: Als Liberaler ist Dir Datenschutz ja ein besonderes Anliegen. Aber es gibt auch Beispiele, etwa in der Gesundheitsforschung, bei denen möglichst detaillierte und unverschlüsselte, auch sehr persönliche Daten hilfreich sein können.

KALTENHAUSER: Je mehr Daten zusammengeführt werden, desto nützlicher können sie sein. Das Zusammenführen von Daten gibt oft eine Zusatzinformation. Andererseits ist hier der individuelle Schutz sehr hoch anzusetzen. Wir müssen das aber auch aus der Perspektive der Menschen sehen. Wenn etwa jemand eine schwere Krankheit hat, dann steigt das Interesse, seine Daten für entsprechende Forschung zur Verfügung zu stellen. So steigt die Wirkung von Forschung und rückt näher an die Menschen. Wichtig ist mir dabei: Jeder Bürger muss jederzeit sehen können, welche Daten über ihn von wem wo gespeichert sind und wer darauf zugreifen kann und zugegriffen hat.

BODE: Von der Information ist der Weg zur Kommunikation nicht weit. Allein das Arbeitsumfeld hat sich für viele Menschen geändert, besonders natürlich durch die Pandemie-Bedingungen.

KALTENHAUSER: Die Abgrenzung zum Privaten wird fließender, das Arbeiten zeitlich flexibler, aber auch die Erwartung an die Erreichbarkeit und Reaktionszeit höher. Eine Antwort wird immer schneller erwartet.

BODE: Zudem beschleunigen sich die Prozesse.

KALTENHAUSER: Und die Veränderung der Prozesse selbst beschleunigt sich ebenfalls, allen voran die Entwicklungsprozesse. Ich denke schon, dass die arbeitende Bevölkerung bereit ist, da mitzugehen. Aber es ist wichtig, dass die Balance zwischen Arbeit und Leben im Gleichgewicht bleibt.

BODE: Im Idealfall kann ich beides verbinden, etwa als Schriftsteller oder Leistungssportler. Arbeit und Leben ist dann so eng miteinander verwoben, dass alles Trennende wegfällt.

KALTENHAUSER: Schön, wenn es gelingt, ich kann mir das auch gut für Entwicklungstätigkeiten vorstellen. Aber dieser Lebensstil wird auch in Zukunft nicht für alle möglich sein. Und es muss die Entscheidung des Einzelnen bleiben, ob er diese Grenze wirklich so fließend haben will; denn die Gefahr auch psychischer Überforderung wächst mit falsch verstandenem Digitalisierungshype. Doch für alle gilt, dass nicht nur die Arbeitszeit flexibler wird, sondern auch das Arbeitsfeld selbst ist nicht mehr so festgezurrt, es wird fließender.

BODE: Durch die Chat-Nachrichten erfolgt die Kommunikation schneller als bei E-Mail, dadurch auch verstärkt schriftlich.

KALTENHAUSER: Das direkte Gespräch fehlt jedoch erkennbar. Es wird mehr gestritten, statt einen Konsens zu suchen. Kreativität geht verloren. Wir bräuchten einen Knigge oder Netiquette für Umgangsformen in der elektronischen Kommunikation, an den sich auch alle halten. Es gibt jedoch auch Kommunikation, die gerne automatisiert werden darf. Etwa den Datenaustausch zwischen Behörden, natürlich unter Kontrolle und dem Einverständnis der Betroffenen.

BODE: Spaltet die Digitalisierung die Gesellschaft in immer kleinere Blasen und verstärkt sie destruktive Tendenzen?

KALTENHAUSER: Das ist leider so. Auf der anderen Seite verbinden digitale Systeme auch. Die Digitalisierung verändert unsere Gesellschaft und wird sie weiter verändern. Das passiert in den Familien, den Vereinen, wie wir einkaufen, wohnen und zusammenleben. Die Bürgerbeteiligung und das Miteinander in Kommunen und Staat wird sich ebenfalls verändern. Die Digitalisierung ist nicht entscheidend, sondern wie Jede und Jeder sich einbringt. Und vor allem: Wir dürfen niemanden hineinzwingen in eine nur noch digitale Welt. Jeder muss selbst entscheiden können, wie weit er da mitgeht.

Human FactorsDer Mensch ist nicht digital und logisch, sondern analog und biologisch. Entgegen der weitläufigen Meinung handelt der Mensch weniger rational als vielmehr intuitiv. Die Herausforderung ist, diese menschlichen Faktoren in der Produktentwicklung von Anfang an zu berücksichtigen. Selbst unter Belastung soll der Mensch zuverlässig agieren und sinnvoll entscheiden. User Centered Design ist der Schlüssel dazu. Nicht nur Ästhetik, sondern auch Gebrauchstauglichkeit und Sicherheit liegen hierbei im Fokus.

Der menschliche Faktor, fachsprachlich Human Factor(s), stellt in der Luftfahrt den größten Risikofaktor dar. Etwa 75 Prozent der Flugzeugunfälle gehen auf menschliches Versagen zurück, zu einem Großteil auf Probleme in der Mensch-Maschine-Interaktion. Die Sicherheit im Flugverkehr hängt somit essentiell von der fehlerfreien Bedienung der Technik ab. Ein Pilot darf keine Fehler machen. Insofern ist es überlebenswichtig, dass das Design von Hard- und Software explizit zur Fehlervermeidung beiträgt, anstatt Fehler zu provozieren.

Während sich IT-Sicherheit primär auf den Schutz der Systeme bezieht, geht es in der Luftfahrt bei der Human Factor Integration (HFI) um den Menschen. Damit dieser reibungslos mit komplexen Systemen interagieren kann, ist ein tiefes Verständnis menschlichen Verhaltens erforderlich.

Der Berater Steve Krug schrieb im Jahr 2000 ein brillantes Buch. Genau genommen ist der Titel des Buches unglaublich genial. Es heißt „Don’t make me think“. Dies fasst nicht nur den Buchinhalt perfekt zusammen – ganz im Sinne des Buches versteht man auch sofort, was gemeint ist. Wer den Buchtitel verstanden hat, braucht den Rest des Buches fast nicht mehr zu lesen.

Leichte Sprache

Laut Koalitionsvertrag von 2021 ist geplant einen Sprachdienst in einem eigenen Bundeskompetenzzentrum „Leichte Sprache / Gebärdensprache“ einzurichten.4

Ein perfektes Beispiel für radikale Einfachheit ist die Eingabemaske von Google. Ein simples Feld, und es erschließt sich die gewaltige Vielfalt des Internets. Einfacher kann man ein Formular nicht gestalten. Im Hintergrund arbeitet eine gigantische IT-Maschinerie mit den größten Rechenzentren und spezialisierter Software. Make it simple – perfekt umgesetzt. Barrierefreiheit wird weitergedacht und nicht auf eine bestimmte Zielgruppe beschränkt.

Die Datenverarbeitung vergangener Tage fristete lange Zeit ein Nischendasein in großen Maschinenräumen. Mit dem PC hat die Informationstechnologie die Menschen im privaten Bereich erreicht. Heute durchdringt sie mehr und mehr alle Lebensbereiche. Menschen beginnen, sich auf Schritt und Tritt selbst mit digitalen Tools zu überwachen und jede Aktivität zu erfassen. Auf der anderen Seite durchforsten Google, Facebook, Amazon und Co. ihre Datenbanken, um so individuell und so relevant wie möglich, Angebote auf den einzelnen Menschen hin maßzuschneidern. Die digitale Technologie bewegt sich unaufhaltsam auf den ganzen Menschen zu.

Weniger ist mehr

KISS: Keep it simple & stupid.

YAGNI: „You Aren’t Gonna Need It“ („Du wirst es nicht brauchen“).

Think big, start small.

MVP: Minimal Viable Product, das minimal funktionierende Produkt.

Lean Start-up: Prototyp statt Businessplan.

Lean Production: Die Beseitigung von Verschwendung. Dies wurde unter „Lean Thinking“ als generelle Methode weiterentwickelt.

Was im Industriezeitalter die Rationalität war, ist im Informationszeitalter die Emotionalität. Lange Zeit hat sich der Mensch an seine Umwelt und an die mit der Industrialisierung verbundenen Technologien angepasst. Jetzt nähert sich der technische Fortschritt dem Menschen und seinem ganzen Wesen – mit großen Chancen ebenso wie mit Risiken.

Das Faszinierende ist, dass die zunehmende Ausbreitung der Digitalisierung den Menschen in den Mittelpunkt rückt. In der Beziehung Mensch zur Maschine hat sich anfangs der Mensch an die Maschine angepasst. Aber je leistungsfähiger die Systeme werden, desto mehr werden die Maschinen an den Menschen angepasst.

Forderungen

Die Digitalisierung stellt den Menschen in den Mittelpunkt und achtet seine Grundrechte.Human Factors, Usability, kognitive und physische Barrierefreiheit sowie einfache Sprache sind Bestandteil der Anforderungen an digitale Systeme und deren Qualitätssicherung.Digitale ZukunftDie Grundlage für die permanente Revolution in der IT sind Trends, die seit Anbeginn der IT wirken:

Die Leistungsfähigkeit der technischen Grundlagen nehmen beständig zu, insbesondere in der Rechenleistung als auch im Speichervermögen.Jedes Bauteil eines Computers wird immer kleiner und leistungsfähiger und dadurch auch immer mobiler.Die Herstellungskosten der Bauteile sinken, bei gleichzeitiger Zunahme der Leistung.Grenz- und Transaktionskosten sinken durch Digitalisierung drastisch.Die IT durchdringt schrittweise alle Bereiche.Mooresches Gesetz

Gordon Moore ist Mitgründer der Firma Intel. 1965 formulierte er das nach ihm benannte ‚Gesetz‘: Moore erkannte die Faustregel, dass sich alle 12 bis 24 Monate die Zahl der Transistoren pro Flächeneinheit verdoppelt, etwa alle 18 Monate also. Analog stieg die Prozessorleistung. Bis 2016 war ‚Moore‘s Law‘ auch Planungsgrundlage der Halbleiter-Industrie und erfüllte sich auf diese Weise selbst.

Die 2019 gegründete Bundesagentur5 für Sprunginnovationen „SPRIND“6 soll Räume schaffen, in denen innovative Menschen Risiken eingehen und radikal anders denken können.

Die geplante „Deutsche Agentur für Transfer und Innovation“7 (DATI) soll mit starkem regionalen Fokus sowie einer zentralen Servicestelle zur bundesweiten Vernetzung agieren.

Digitale Schlüsseltechnologien

Der Koalitionsvertrag von 2021 über die Pläne für Zukunftstechnologien:8

Wir werden Treiber eines starken Technologiestandorts, der auf europäischen Werten basiert, Talente anzieht sowie Zukunftsfähigkeit und Wohlstand unseres Landes sichert. Investitionen in Künstliche Intelligenz (KI), Quantentechnologien, Cybersicherheit, Distributed-Ledger-Technologie (DLT), Robotik und weitere Zukunftstechnologien stärken wir messbar und setzen Schwerpunkte. Wir stärken strategische Technologiefelder z. B. durch Important Projects of Common European Interest (IPCEIs) und treiben den angekündigten EU Chips Act voran. Mit europäischen Partnerländern fördern wir die Zusammenarbeit starker europäischer Forschungsstandorte, insbesondere bei KI, und ermöglichen institutionelle Freiräume. Im Sinne eines lernenden, technologiefördernden Staates setzen wir digitale Innovationen in der Verwaltung ein, schaffen notwendige Rechtsgrundlagen und Transparenz. Wir unterstützen den europäischen AI Act. Wir setzen auf einen mehrstufigen risikobasierten Ansatz, wahren digitale Bürgerrechte, insbesondere die Diskriminierungsfreiheit, definieren Haftungsregeln und vermeiden innovationshemmende ex-ante-Regulierung. Biometrische Erkennung im öffentlichen Raum sowie automatisierte staatliche Scoring Systeme durch KI sind europarechtlich auszuschließen.

VirtualisierungDie Fähigkeit der Abstraktion, nutzt die IT-Branche für ureigene Aufgaben. Schon als Klassiker gilt die Virtuelle Maschine (VM). Auf einem realen Computer wird ein anderer Computer simuliert, eben die VM. Eine VM kann ein anderer Rechnertyp mit einem anderen Betriebssystem sein als der reale.

Durch diese Virtualisierung eines Computers besteht die Möglichkeit, beliebig verschiedene VMs auf einer realen Maschine zu betreiben. Praktisch hat das seine Grenzen, denn irgendwann wird der reale Rechner an seine Leistungsgrenzen stoßen. Sind zu viele VMs aktiv, werden sie entsprechend langsam. Doch mit einem leistungsfähigen Server kann eine respektable Zahl von VMs auf nur einer Maschine laufen.

Ein Server ist zwar deutlich teurer als mehrere kleine Maschinen, aber dennoch günstiger als diese einzelnen Maschinen in der Summe. Zudem wird er besser ausgelastet, ist energieeffizienter und die Wartungskosten für einen großen Server sind ebenfalls günstiger als für viele kleine Maschinen. Darüber hinaus können sie flexibel genutzt werden und ermöglichen eine zentrale Verwaltung, etwa von Zugriffsrechten.

Der Mechanismus „Virtualisierung“, die Simulation einer Komponente auf einer realen Hardware, ist so kraftvoll, dass inzwischen alle IT-Komponenten virtualisiert sind und legoartig standardisiert werden. So können auch Netzwerke als sogenannte Software-defined Networks (SDN) virtualisiert werden; oder der klassische Desktop als Virtual Desktop. Dahinter steckt selbstverständlich immer reale Hardware.

Das Prinzip der Virtualisierung reicht längst über die engere IT hinaus. Dezentrale Stromerzeuger werden zu einem virtuellen Kraftwerk zusammengeschaltet. Verteilte Batterien werden zur Strom-Cloud verbunden. Teams arbeiten virtuell zusammen, obwohl sie weit verstreut beheimatet sind. Die große Zahl an Bauteilen und Lieferanten beim Bau eines Automobils erschafft eine virtuelle Fabrik. Bitcoin ist eine dezentral organisierte Notenbank und das glatte Gegenteil einer Zentralbank. Die Virtualisierung macht auch vor dem Staatswesen nicht halt.

Forderung

Das Prinzip der Virtualisierung ist durchgängig zu beachten.

Vernetzung und GlobalisierungDas Internet hat innerhalb von 20 Jahren die Welt in Echtzeit vernetzt und die globale Zusammenarbeit verändert und beschleunigt. Nach der Vernetzung von Menschen und IT-Systemen, folgt die Vernetzung der Dinge, dem Internet of Things (IoT). Die Vernetzung treibt auch die Transformation in Fabriken (Industrie 4.0) und Produkten (vernetztes Automobil) voran. Grundlage sind Standards; mindestens der Schnittstellen (API). Plattformen vereinfachen den Informationsaustausch.

Beispielsweise will intermodale Mobilität die Verkehrslage, Navigation, Parkraum, Fahrpläne und Fahrtickets über alle Verkehrsträger hinweg koordinieren. Viele verschiedene Arten von Systemen und Teilnehmern zu einer Mobilitätskette aufeinander abzustimmen, ist allerdings eine Herausforderung.

Vernetzung hebt in Unternehmen die Abteilungsschranken auf. Projektorientierte Organisationsformen ersetzen Hierarchien, durchgängigeProzesse überwinden die Mauern der Abteilungen, agile und parallelisierte Arbeitsweisen folgen auf serielle und bürokratische Arbeitsweisen. Organisation und Arbeitsweise in der öffentlichen Verwaltung haben diese Revolution noch nicht erreicht.

Forderung

Projektorientierte Organisationen, prozessorientiertes Arbeiten und agile Methoden werden schrittweise auch in der öffentlichen Verwaltung umgesetzt.

Qualität und AgilitätDas „Magische Dreieck“ von Kosten, Zeit und Umfang steht nach klassischer Lehre in einem Konflikt. Eine der Dimensionen leidet immer. In Softwareentwicklung und IT-Betrieb gibt es einen Schlüssel, um den Konflikt aufzulösen bzw. auf einem ganz anderen Niveau zu heben: Qualität. Die Steigerung der Qualität führt zur Senkung der Kosten und Beschleunigung der Arbeit, damit auch zur Erhöhung des Umfangs. Die Realisierung von Qualität erfolgt durch Automatisierung der Qualitätssicherung (DevOps). Entscheidend dabei ist die Testautomatisierung und ein auf Container-Technologie basiertes Betriebssystem wie Kubernetes.

Erst auf dieser Grundlage sind agile Arbeitsweisen wie Scrum überhaupt möglich. Agile Arbeitsweisen zerteilen ein Projekt in zahlreiche Kurz-Projekte (Sprints) und Einzelaufgaben (User Story), die jeweils für sich zu einem Abschluss führen und das Produkt weiterentwickeln. Jede Änderung am Produkt hinterlässt dieses voll funktionsfähig. Dies kann nur durch einen sehr hohen Automatisierungsgrad in der Qualitätssicherung der Softwareentwicklung sowie im IT-Betrieb gewährleistet werden.

Forderung

Qualität ist der Schlüssel, um bei der Digitalisierung Kosten zu senken und das Tempo zu beschleunigen. Eine konsequente Qualitätssicherung ist bei IT-Projekten durchzusetzen.

Komplexität und NachhaltigkeitDie hohe Dynamik und Geschwindigkeit der technologischen Entwicklung in der Informatik hat zu einer unglaublich großen Zahl an Softwareprodukten geführt. Allein die CNCF Cloud Native Interactive Landscape9 beeindruckt mit einer großen Breite an Open Source Software für Entwicklung und Betrieb von Software. Die Softwarelandschaft großer Unternehmen sieht mit typischerweise 200 bis 1.000 Anwendungen10 ganz ähnlich aus, zumal diese auch die Historie ihrer IT (Legacy) mitschleppen. Darüber hinaus gibt es viele Abhängigkeiten von Open Source Software-Bausteinen, die in einer einzelnen Anwendung durchaus 500 bis 1.000 Einzelelemente betragen, sowie zahlreiche Abhängigkeiten von anderen Systemen. Dies führt zu einer erheblichen Komplexität und auch Kompliziertheit der IT-Systeme. Die stetig wachsenden Rechnerkapazitäten konnten dieses Wachstum zumindest bezüglich der Ausführungsgeschwindigkeit und Speicherkapazität immer wieder auffangen. Doch die Aufwände für diese IT-Landschaften steigen massiv. Entsprechend nimmt der Personalbedarf zu. Personalanzeigen demonstrieren mit langen Anforderungslisten immer wieder den massiven Einsatz von Technologie und entsprechenden Expertenbedarf.

Man sollte dabei nicht aus dem Auge verlieren, dass Software für Verwaltungen zu den eigentlich einfacheren Entwicklungsaufgaben gehören. Software im Automobilbereich ist schon von der Produktseite her wesentlich komplexer. Software für die Landwirtschaft muss mit massiven äußeren Dynamiken umgehen können, angefangen beim Wetter. In der öffentlichen Verwaltung sind nicht die Softwareprodukte selbst komplex, sondern das Umfeld. Das gilt auch für das Umfeld bei der Entwicklung.

Komplexitätsmanagement

Viele innere Abhängigkeiten und äußere Einwirkungen führen in einer IT-Landschaft zu einer komplexen Dynamik. Komplexität lässt sich nicht perfekt kontrollieren, aber managen. Um Komplexität zu vermeiden, zu reduzieren und zu beherrschen hat die Informatik einen reichen Instrumentenkasten entwickelt. Eine Auswahl:

IT-Strategie, IT-ArchitekturAgile Arbeitsmethoden, BizDevOpsModellbasierte Entwicklung, DomänenmodelleVirtualisierung, EntkopplungModularisierung, StandardisierungIntegrationsmanagementQualitätssicherung, Quality GatesRisikomanagementHuman Factors, UsabilitySimulation, digitaler Zwilling, Chaos EngineeringIn vielgestaltigen IT-Landschaften, besonders bei einer hohen Zahl unterschiedlicher Akteure, ist über eine solide Produktentwicklung hinaus ein straffes Komplexitätsmanagement erforderlich. Weiterhin gilt es die Mitwirkung der Akteure sicherzustellen. Stabilität und Anpassungsfähigkeit sind die Leitmotive des Komplexitätsmanagements.

Qualitätsmängel führen zu einer Zunahme der Komplexität, die bis zum Scheitern von Projekten führt. Agile Organisation, gute IT-Architekturen, Standardisierung, Management der Abhängigkeiten, Integrationsmanagement, hochautomatisiertes DevOps und eine rigide Qualitätssicherung sind Wege, um die Komplexität einzuhegen. Perspektivisch werden digitaler Zwilling, Simulationen und KI dabei unterstützen. Letztere sind allerdings selbst auch starke Verbraucher.

Nachhaltigkeit in der Digitalisierung

Der Koalitionsvertrag 2021 verbindet Digitalisierung und Nachhaltigkeit:11

Wir wollen die Potentiale der Digitalisierung für mehr Nachhaltigkeit nutzen. Durch die Förderung digitaler Zwillinge (z. B. die Arbeit an einem virtuellen Modell eines analogen Produktes) helfen wir den Verbrauch an Ressourcen zu reduzieren. Wir werden Rechenzentren in Deutschland auf ökologische Nachhaltigkeit und Klimaschutz ausrichten, u. a. durch Nutzung der Abwärme. Neue Rechenzentren sind ab 2027 klimaneutral zu betreiben. Öffentliche Rechenzentren führen bis 2025 ein Umweltmanagementsystem nach EMAS (Eco Management and Audit Scheme) ein. Für IT-Beschaffungen des Bundes werden Zertifizierungen wie z. B. der Blaue Engel Standard. Ersatzteile und Softwareupdates für IT-Geräte müssen für die übliche Nutzungsdauer verpflichtend verfügbar sein. Dies ist den Nutzerinnen und Nutzern transparent zu machen.

Die Informatik hat zahlreiche und leistungsfähige Instrumente für das Komplexitätsmanagement entwickelt, auch wenn diese noch viel zu selten in Projekten gelebt werden. Nicht nur die Entwicklung von Software ist aufwendig, sondern ein Softwareprodukt ist meist auch in eine umfangreiche und komplexe IT-Landschaft eingebunden. Darüber hinaus ist auch die organisatorische und unternehmerische Landschaft in intensiven Märkten eine weitere Herausforderung. Mangelhaftes Komplexitätsmanagement ist existenzgefährdend für IT-lastige Organisationen.

Diesen komplexen Systemen steht das Prinzip der Nachhaltigkeit und einem geringen Ressourcenverbrauch gegenüber. Die heutige IT ist strukturell verschwenderisch. Diese breite Nutzung von Technologie widerspricht auch dem Sicherheitsprinzip der Härtung (Hardening) von IT-Systemen. Bei einer Härtung wird alles weggelassen, was für die Aufgabe nicht erforderlich ist.

Eine nachhaltige Informatik muss den Verbrauch an Rechenkapazitäten reduzieren. Das gilt analog auch für die Intensivbürokratie in Deutschland und ihrem enormen Verbrauch an Personal und Zeit. Da stehen wir bestenfalls am Anfang.

Forderungen

Komplexitätsmanagement wird konsequent umgesetzt.Bei Ausschreibungen wird eine nachhaltige und gehärtete IT berücksichtigt.Die Verfahren und Werkzeuge werden als Blueprint standardisiert.Resilienz und IT-SicherheitDer Begriff Resilienz leitet sich aus der Psychologie ab und bedeutet die psychische Widerstandsfähigkeit, also die Fähigkeit, schwierige Situationen zu bewältigen. In der IT entspricht dies, Systeme in die Lage zu versetzen, Störungen sinnvoll abzufangen (Fallback). Beispielsweise werden bei Ausfall eines Rechners die virtuellen Maschinen und Container automatisch auf einen anderen Rechner verschoben. Der Betrieb geht ohne merkbare Unterbrechung weiter (Business Continuity). Auf diese Weise erweist sich das System gegenüber Störungen und Belastungen als widerstandsfähig und stabil. Das Land Brandenburg hat in seinem Digitalprogramm12 die Digitale Resilienz zu einem der zentralen Rahmenbedingungen bestimmt.

Freiheit und Sicherheit13

Im Koalitionsvertrag 2021 wurde vereinbart:

Die Ausnutzung von Schwachstellen von IT-Systemen steht in einem hochproblematischen Spannungsverhältnis zur IT-Sicherheit und den Bürgerrechten. Der Staat wird daher keine Sicherheitslücken ankaufen oder offenhalten, sondern sich in einem Schwachstellenmanagement unter Federführung eines unabhängigeren Bundesamtes für Sicherheit in der Informationstechnik immer um die schnellstmögliche Schließung bemühen.

Für den Einsatz von Überwachungssoftware, auch kommerzieller, setzen wir die Eingriffsschwellen hoch und passen das geltende Recht so an, dass der Einsatz nur nach den Vorgaben des Bundesverfassungsgerichtes für die Online-Durchsuchung zulässig ist. Die Befugnis des Verfassungsschutzes zum Einsatz von Überwachungssoftware wird im Rahmen der Überwachungsgesamtrechnung überprüft. Das Bundespolizeigesetz novellieren wir ohne die Befugnis zur Quellen-TKÜ und Online-Durchsuchung. Solange der Schutz des Kernbereichs privater Lebensgestaltung nicht sichergestellt ist, muss ihr Einsatz unterbleiben. Transparenz und effektive Kontrolle durch Aufsichtsbehörden und Parlament werden wir sicherstellen.

Wir schaffen für die Zentrale Stelle für Informationstechnik im Sicherheitsbereich (ZiTis) und in enger Abstimmung mit den Ländern für die gemeinsamen Zentren (GTAZ etc.) gesetzliche Grundlagen, legen die Verantwortlichkeiten klarer fest und garantieren die lückenlose Kontrolle durch Parlamente und Datenschutzaufsichtsbehörden. Zum Schutz der Informations- und Meinungsfreiheit lehnen wir verpflichtende Uploadfilter ab.

IT-Sicherheit ist ein zentrales Thema der Digitalisierung geworden. Als Student habe ich die ersten Viren kennengelernt und später mit Klaus Brunnstein14 über Datenschutz und Datensicherheit diskutiert, als er in den 1980er Jahren das Viren-Test-Center aufbaute. Wir haben damals die Viren gewissermaßen noch persönlich gekannt. Heute kommen jeden Tag rund 400.000 neue Schadprogramm-Varianten dazu.15 Die thematische Bandbreite der IT-Sicherheit lässt sich nur noch durch Teams mit unterschiedlichen Experten bearbeiten.

Forderung

Resilienz und Business Continuity sind Ziele für die öffentliche Verwaltung und IT, um auch in schwersten Krisen bestehen zu können.

Modellbasierte EntwicklungDer Berliner Konrad Zuse entwickelte 1941 den ersten funktionsfähigen Computer der Welt, weil ihm als Ingenieur die statischen Berechnungen zu mühselig und langweilig waren. Er automatisierte seine Arbeit. Dieses Prinzip zieht sich wie ein roter Faden durch die Entwicklung des Computers und der Softwareentwicklung.

Compiler übersetzen automatisch Programmiersprachen in Maschinencode. Ihre Entwicklung ermöglicht ein viel höheres Entwicklungstempo. Zugleich wurden - und werden - immer höherwertige Programmierstrukturen wie die objektorientierte Programmierung geschaffen. Damit konnte der Leistungsumfang der Programme wachsen und trotzdem blieb die Softwarestruktur beherrschbar. Auch wenn das nicht immer in jedem Projekt gelang. Heute entwickeln wir für bestimmte Anwendungen, den sogenannten Domänen, spezialisierte Programmiersprachen. Eine solche Domäne kann beispielsweise das Steuerwesen sein.

Konfigurierbare Parameter sorgen für die Flexibilität einer Software. Es wird dazu ein grundlegendes, verallgemeinertes Modell einer Anwendung entwickelt und durch Konfiguration auf ein Unternehmen oder eine Person individualisiert. Das kennt man nicht nur in der Softwareentwicklung: Die Standard-Kontenrahmen16 der DATEV geben Buchhaltungen eine Vorlage, die im einzelnen Betrieb dann als Kontenplan konkretisiert wird. Konfiguration statt Programmierung beschleunigt die Bereitstellung von Software um ein Vielfaches.

Kubernetes ist eine Software für den Rechenzentrumsbetrieb, die es erlaubt, den Betrieb der Anwendungsprogramme durch Konfigurationen vollständig zu automatisieren. Diese durchaus umfangreichen Konfigurationen werden standardisiert in Dateien geschrieben. Durch die Standardisierung können sie automatisch verarbeitet werden. Die Konfigurationsdateien werden wie jede andere Datei in der Softwareentwicklung in einer Versionsverwaltung, meistens Git, abgespeichert. Deshalb spricht man auch von GitOps, wobei Ops für Operations (Betrieb) steht. Wie aus dem Nichts lässt sich dann auf einem blanken Rechner ein ganzes einsatzfähiges Rechenzentrum über diese Konfigurationsdateien entfalten.

Wir entwickeln also auf verschiedenen Ebenen, vom Rechenzentrumsbetrieb bis zu Fachanwendungen, Modelle, die dann bedarfsabhängig konfiguriert werden. Diese sogenannte modellbasierte Entwicklung erlaubt ein viel höheres Tempo der Softwareproduktion verbunden mit einer sehr hohen Flexibilität. Ggf. muss nur ein Parameter angepasst werden.

Modellbasierte Entwicklung ist eine über viele Jahre gereifte Methode, um leistungsfähige Software in kürzerer Zeit zu entwickeln. Low-Code ist eine moderne Form der modellbasierten Entwicklung, die sich durch folgende Arbeitsweisen auszeichnet:

Grafische Modellierung der GeschäftslogikDrag & Drop Entwicklung von BenutzeroberflächenGenerierung von AnwendungenEntwicklung wiederverwendbarer Bausteine, wie z.B. eines Formularbausteins für Postadressen Bereitstellung fertiger Konnektoren für Transportprotokolle, d.h. Programme zur standardisierten DatenübertragungJe nach Anbieter eines Low-Code Systems laufen die fertigen Anwendungen auf dessen Plattformen (Platform as a Service) und/oder können auf kundeneigenen Systemen von Unternehmen und Behörden genutzt werden.

In der Regel liefern die Low-Code Systeme auch umfangreiche Entwicklungswerkzeuge mit, wie z.B. für den vollautomatisierten Zusammenbau und die Qualitätssicherung der Software (CI/CD Pipeline). Darüber hinaus stehen Funktionen etwa für Datenhaltung (Persistenz), Identitätsmanagement und Schnittstellen (API) zur Verfügung.

Zu den führenden Low-Code-Systemen gehören:

Outsystems: Große Community, bei der öffentlichen Verwaltung in verschiedenen Ländern im Einsatz, u.a. Japan und Schottland;Mendix: Teil von Siemens, spezialisiert in Finanzwesen und Maschinenbau;Appian: Für die öffentliche Verwaltung in Österreich im Einsatz.Budibase und ToolJet sind entsprechende Werkzeuge aus dem Bereich Freeware.

Bei der Digitalisierung der öffentlichen Verwaltung handelt es sich um klassische IT. Daten werden erfasst, gespeichert, verarbeitet und über Schnittstellen weitergegeben oder als Dokumente ausgegeben. Diese Arbeitsweise ist prädestiniert für Low-Code.

Zudem stehen mit dem Föderalen Informationsmanagement (FIM) bereits Datenstrukturen und Prozessbeschreibungen zur Verfügung. Weiterhin sind mit der Bund-ID, dem Deutsche Verwaltungsdiensteverzeichnis (DVDV), dem Bezahlverfahren (ePayBL) und dem Sovereign Cloud Stack (SCS) eine Reihe von Komponenten verfügbar.

Um Low-Code Systeme für die öffentliche Verwaltung nutzbar zu machen und den Wettbewerb zu organisieren, sind folgende Rahmenbedingungen sinnvoll (die einzelnen Elemente werden in Kapitel 5 erläutert):

FIM-Datenstrukturen können automatisiert eingebunden werden.Die Integration von FIM-Prozessen ist möglich.Protokolle wie FIT-Connect und die XÖV-Reihe können integriert werden.Komponenten wie Bund-ID, DVDV, ePayBL können integriert werden.SCS stellt eine Zielplattform dar.Als Präsentationsschicht stehen klassische Programmoberflächen, Browser (Portale), Apps und Multimessenger zur Verfügung, und die Rollen beinhalten unter anderem die Sachbearbeitung und die des Bürgers.Besonderes Augenmerk wird auf die effiziente Generierung von Erfassungsformularen und Geschäftsprozessen auf Basis der FIM-Datenstrukturen und -prozesse gelegt.

Um einen hohen Grad der Unabhängigkeit zu erreichen, sollte folgendes möglich sein:

Die Prozessdefinitionen können in Business Process Model and Notation (BPMN) exportiert werden.Auf den generierten Programmcode kann zugegriffen werden.Ein User Interface (UI) kann in einem noch zu standardisierenden Format exportiert und importiert werden.Grundsätzlich gehört ein Low-Code Werkzeug in professionelle Hände. Die Idee, Laien als sogenannte „Citizen Developer“ einzusetzen, sollte im öffentlichen Bereich sehr zurückhaltend verfolgt werden. Dies sprengt in der Regel schon die Stellenbeschreibungen.

Mit modellbasierter Entwicklung verlagert sich der Aufwand von der funktionalen Entwicklung der Software weiter auf die konzeptionelle Seite. Die Fachlichkeit wird modelliert und konfiguriert. Der Schlüssel für agiles E-Government liegt in der fachlichen Spezifikation und Modellierung – also zwischen den Anforderungen und dem Software-Code. Im Fall der öffentlichen Verwaltung sind die Anforderungen durch das Gesetz bestimmt. Neben dem Gesetz gilt dies entsprechend auch für Rechtverordnung, Satzung, Beschluss, Richtlinie und anderen Handlungsgrundlagen.

Methoden wie modellbasierte Entwicklung (Low-Code), Domain-driven Design, Continuous Development und DevOps verbunden mit agilen Prinzipien haben in den letzten 20 Jahren die Softwareentwicklung revolutioniert. Allerdings erfordert dies neue Kompetenzen von Entwicklungsteams wie auch den Führungskräften sowie neue Organisationsstrukturen.

Forderungen

Arbeitsweisen wie modellbasierte Entwicklung, Domain-driven Design und DevOps sind Grundlage einer leistungsfähigen Softwareentwicklung für die öffentliche Verwaltung.Zu diesen Techniken werden die für die öffentliche Verwaltung geeigneten Rahmenbedingungen definiert. Prognose und SimulationWenn Verwaltungsvorgänge und Daten digital verfügbar sind, dann führt Digitalisierung zu einer Revolution in der Art und Weise der politischen Willensbildung. Bis heute werden grundsätzliche politische Überzeugungen direkt in Verwaltungshandeln umgesetzt. Der Gesetzgeber stellt Vermutungen an, durch welche Maßnahmen die Ziele erreicht werden können. Aber gut gemeint ist noch lange nicht gut gemacht.

Die Digitalisierung ermöglicht es, sehr viel einfacher die Auswirkungen sowohl vorab zu simulieren als auch nach einer Umsetzung zu beobachten und auszuwerten. Im sogenannten sozio-ökonomischen Panel (SOEP) werden rund 15.000 repräsentative Privathaushalte mit 30.000 Personen regelmäßig detailliert befragt. Auf diesen Daten aufbauend hat beispielsweise das ifo-Institut ein ökonomisches Verhaltensmodell entwickelt und kann Verhaltenseffekte für diese Haushalte simulieren. Dies ermöglicht die Vorhersage der Auswirkungen politischer Entscheidungen. Selbst Randeffekte können erkannt werden.

Ähnlich einem Schachprogramm rechnen wir Millionen verschiedenster Konstellationen durch, um die beste Konstellation auszuwählen. Die empirische Steuerung politischer Ziele ist in greifbarer Nähe. Simulation und Monitoring sind zukünftige Instrumente, um Politik zielorientiert umzusetzen. Die Mutmaßungen über die richtige Ausgestaltung der Details weicht der methodischen und systematischen Simulation.

Im Jahre 2016 programmierte die Google-Tochter DeepMind ihrer Software „AlphaGo“ die Regeln des asiatischen Strategiespiels „Go“ ein. Anschließend ließen sie das System Millionen Mal gegen die eigene Kopie spielen. Das System entwickelte sich ohne Expertenwissen und ohne die Eingabe von Beispielen aus eigener Kraft von Anfängerniveau auf unschlagbar.

Wir werden in Zukunft auf diese Weise nicht nur die perfekten Parameter eines Konzepts schlicht ausrechnen können, sondern lassen auch verschiedene Konzepte digital gegeneinander antreten.

In der Studie „Vollzugsorientierte Gesetzgebung durch eine Vollzugssimuluationsmaschine“17 wird eine Simulation des Gesetzesvollzugs vorgeschlagen, die mögliche Kostenwirkungen berechnet. Voraussetzung ist, dass Begriffe in Gesetzestexten konsistent verwendet werden.

Eine andere Art der Prognose basiert auf Wahrscheinlichkeiten18: Welche Therapie hat die besten Heilungschancen? Wo drohen Engpässe im Straßenverkehr? Wie wird der Energieverbrauch verlaufen?

Die Digitalisierung liefert den Rahmen und wird die Qualität politischer Entscheidungen erhöhen. Die fachlich-politischen Zielvorgaben bleiben Aufgabe der politischen Willensbildung.

Forderung

Simulation wird ein Standardinstrument für politische Prognosen.

Künstliche IntelligenzKünstliche Intelligenz (KI, englisch Artificial Intelligence, AI) ist eine Methode, aus bestehenden Daten Muster zu erkennen und daraus die Programmlogik aufzubauen – also zu lernen. KI hat eine lange Geschichte, die sich seit 1955 als Begriff etabliert hat. Aber erst seit etwa 2010 ist die IT so leistungsfähig, dass sich der massive Aufwand buchstäblich rechnet.

Mit ChatGPT19 erschien 2022 ein auf Deep Learning basierender Chatbot, der in der Lage ist menschenähnliche Konversationen zu führen. Das Modell berechnet die statistische Nähe von Wörtern und dessen Kontext.

In den 1980er Jahre war KI schon einmal populär und dies führte 1988 zur Gründung des Deutschen Forschungszentrums für künstliche Intelligenz (DFKI) in Kaiserslautern mit heute 800 Mitarbeitende und 560 studentische Kräfte. Die deutsche Politik finanzierte das DFKI trotz anschließend sinkender Aufmerksamkeit für die KI durch.

Heute besteht die Herausforderung, die KI wirkungsvoll zur Anwendung zu bringen. Da die Rechensysteme nach wie vor immer leistungsfähiger werden, wird die KI davon besonders profitieren. In der Folge wird sich das Anwendungsspektrum ständig erweitern und die Leistungsfähigkeit der KI zunehmen. Erfolgreiche KI-Anwendungen aus Deutschland sind beispielsweise Deepl20 (Übersetzung), Celonis21 (Prozessoptimierung), Fraugster22 (Betrugserkennung) und Enway23 (autonome Kehrmaschine).

Die KI-Strategie von 2018 der Bundesregierung hat deshalb neben den Forschungsaktivitäten ein besonderes Augenmerk darauf, KI in die Anwendung zu bringen.24

Marktbeherrschende KI-Modelle

Der Beirat „Junge Digitale Wirtschaft“25 beim Bundesministerium Wirtschaft und Klimaschutz fordert im Sinne der digitalen Souveränität den Aufbau deutscher bzw. europäischer IT-Dienste für besonders leistungsfähige KI-Modelle. Sehr große Modelle wie GPT von OpenAI sind weltweit Grundlage für KI-Anwendungen zur Erzeugung von Text und anderen Medien.

Der Beirat stellt dazu fest:

Wegen des erforderlichen Aufwands, vor allem an Rechenkapazität, können diese Modelle nur von finanz- und ressourcenstarken Unternehmungen umgesetzt werden. Dies wird mittelfristig dazu führen, dass zentrale KI-Funktionalitäten von einigen wenigen Marktteilnehmern bereitgestellt und diese von Anwendern über den Aufruf von Programmierschnittstellen in der Cloud genutzt werden. Es werden mittelfristig Monopole oder Oligopole für spezifische Bereiche der KI-Anwendungen entstehen. Das innovative deutsche KI-Ökosystem wird in der Konsequenz vom Zugang zu diesen Modellen abhängig.

Fairness ist in der KI eine besondere Herausforderung. Joy Buolamwini und Timnit Gebru zeigten 2018, dass die Gesichtserkennung einiger Hersteller bei Männern besser funktioniert als bei Frauen und bei hellerer Hautfarbe besser als bei dunklerer.26 Bei hellhäutigen Männern betrug die Fehlerrate höchstens 0,8 %, bei dunkelhäutigen Frauen bis zu 34,7%. KI baut die Programmlogik durch Mustererkennung von vorhandenen Daten auf. Einseitige Daten führen zu voreingenommener Logik. Bei der KI haben nicht die Programme die Bugs27, sondern die Daten.

Das ist kein Problem der KI allein. Wenn ein Richter in der Literatur überwiegend einseitige Urteile findet oder selbst eine vorgefasste Ansicht vertritt, sind die Urteile mehr Meinungs- als Rechtsprechung (Judicial Bias). Eine KI, die diese Urteile auswertet, würde eben auch das Muster von Vorurteilen erkennen und in der Programmlogik einbauen. Das Programm würde entsprechend einseitige Empfehlungen oder Entscheidungen treffen – ein Teufelskreis.

Darüber hinaus können Angreifer durch Einschleusung manipulierter Daten gezielt Fehlentscheidungen provozieren (Data Poisoning).

Wir müssen – analog der Qualitätssicherung von Programmcode mit Werkzeugen wie Sonarqube und Testautomatisierung – die Datenqualität professioneller und automatisierter sicherstellen. Nach Dr. Daniel Kondermann28 müssen Datensätze für die KI vielfältig (representativeness), präzise (accuracy) und herausfordernd (difficulty) sein.

Aufgabe der Politik ist es nicht nur, den bestehenden Rechtsrahmen gegen Diskriminierung so weit erforderlich zu ergänzen, sondern auch Forschung für die Qualitätssicherung voranzutreiben. Es ist naheliegend, im europäischen Kontext aktiv zu werden. Mit dem AI Act29 will die EU eine risikobasierte Konformitätsprüfung für KI einführen.

Der European AI Fund30 ist eine philanthropische Initiative zur Gestaltung der Entwicklung von KI in Europa. Verschiedene in Europa aktive Stiftungen, wie die Robert Bosch Stiftung und Bertelsmann Stiftung, unterstützen das Projekt als gemeinschaftliche Initiative. Der Fund will die sozialen und politischen Wirkungen von KI katalogisieren und überwachen, damit KI den Interessen des Einzelnen und der Gesellschaft dient. Fachkundige Organisation und Personen sollen dazu vernetzt und unterstützt werden.

Zahlreiche KI-Richtlinien versuchen Orientierung zu geben. Jobin et al.31 haben 84 Richtlinien ausgewertet, mit Werten wie Transparenz, Gerechtigkeit und Fairness, Unparteilichkeit, Verantwortlichkeit, Datenschutz, Wohlwollen, Freiheit und Autonomie, Vertraulichkeit, Nachhaltigkeit, Würde und Solidarität. Die Herausforderung ist, solche Richtlinien umsetzbar zu machen, so dass sie von einer Maschine berechnet werden können. Diese Richtung bezeichnet sich als „machine ethics“ oder „computational ethics“.

Forderungen

Die Politik fördert weiterhin die KI-Forschung.Es werden konkrete KI-Anwendungen im öffentlichen Bereich umgesetzt.Es werden Instrumente zur Qualitätssicherung der Daten entwickelt und eingesetzt.Forschung für rechnende Ethik wird gefördert, um KI-Richtlinien direkt in die Anwendungen zu implementieren. Additive FertigungDer normale 2D-Druck arbeitet bekanntlich mit Tinte bzw. Toner auf flachem Papier. Beim 3D-Druck werden anstelle des Toners andere Materialien verwendet, etwa Kunststoffe oder Metalle. Diese werden im flüssigen Zustand mehrfach aufgetragen, so dass Schicht für Schicht ein dreidimensionales Werkstück aufgebaut wird. Je nach Material können Industrieteile, Schmuck, Lebensmittel oder sogar Organe gedruckt werden. Auch ein ganzes Haus lässt sich per Druckverfahren mit Flüssigbeton bauen (Contour Crafting).

Beim 3D-Druck wird das Werkstück also nicht durch Abtragen aus einem Klotz erstellt, sondern durch Aufbau des Materials. Daher spricht man im professionellen Bereich auch von der generativen oder additiven Fertigung, im Gegensatz zu subtrahierenden Fertigung wie Fräsen.

Durch den Materialaufbau lassen sich Materialeinsparungen erzielen, da in der Regel weniger Material als etwa beim Fräsen verwendet wird. Weiterhin muss die Konstruktion nicht so viel Rücksicht auf das Fertigungsverfahren nehmen (Design-driven Manufacturing). Dank der höheren Designfreiheit sind Optimierungen möglich, die zu Gewichtseinsparungen sowie zu höherer Belastbarkeit führen. Auch kann ein komplexes Bauteil in einem Arbeitsgang gefertigt werden, das mehrere Einzelteile ersetzt (Assembly Consolidation). In der Summe führen diese Verbesserungen auch zu einem geringeren Energieverbrauch.

Vorteile 3D-Druck

Höhere DesignfreiheitSenkung MaterialeinsatzVerringerung der Anzahl an BauteilenGeringeres GewichtHöhere StabilitätGeringerer Energiebedarf für die ProduktionWeniger ArbeitsschritteVereinfachte und flexiblere ProduktionBessere Skalierung der ProduktionKundennahe (on site) Produktion, Reduzierung der LogistikkostenBedarfsorientierte (on demand) Produktion, Verzicht auf ErsatzteillagerSchneller am MarktKürzere LieferzeitenFerner ist es möglich, die Produktion bei geringeren Rüstzeiten zu individualisieren. Im Rahmen der Druckmöglichkeiten kann jedes Werkstück variieren. Der Bedarf an verschiedenen Maschinen sinkt, die Fabrik skaliert besser und die minimal erforderliche Fabrikgröße wird kleiner. Von der Mini-Fabrik im Wohnzimmer hin zur 3D-Drucker-Farm, die flexibel unterschiedlichste Produkte herstellt, sind viele Gestaltungsmöglichkeiten für eine Produktionsstätte möglich. Die additive Fertigung ermöglicht die direkte Erstellung von der digitalen Konstruktion zum realen Werkstück, wahlweise als Muster (rapid prototyping) oder als Serienteil (rapid manufacturing).

Neben der gewachsenen Gestaltungsfreiheit erfolgt auch noch die schnellere Umsetzung. Ähnlich wie in der Softwareentwicklung (DevOps) rücken auch Industrie-Design, Konstruktion und Produktion immer enger zusammen. 3D-Drucker erlauben, eine Produktion überall und sofort umzusetzen. Beispielsweise können 3D-Drucker an den Flughäfen dieser Welt dafür sorgen, dass Ersatzteile für Flugzeuge kurzfristig gedruckt werden, anstatt vom Herstellerlager eingeflogen zu werden. Das Auslieferungslager kann durch kundennahe Produktion (on site) nach Bedarf (on demand) ersetzt werden. Denkbar ist sogar, dass 3D-Drucker in Verbindung mit Robotertechnologie mobil werden. 3D-Druck ist eine spannende neue Möglichkeit, sofort, überall und für jeden, Werkstücke zu fertigen.

Der 3D-Druck wird bewährte Produktionsverfahren nicht beliebig verdrängen. Premium-Handwerk wird ebenso wie klassische Massenfertigung weiterhin bestehen. Auch sind manche Materialien und Anforderungsprofile naturgemäß für Druckverfahren ungeeignet.

Weitere Innovationen sind zum einen bei den Drucktechniken zu erwarten, zum anderen bei den Materialien und ihrer Zusammensetzung. Dadurch werden neue Einsatzmöglichkeiten erschlossen und Eigenschaften wie Präzisionsgrad, Belastbarkeit und Gestaltungsspielraum weiter verbessert. Zugleich werden Serienproduktionen mit dem 3D-Drucker zunehmend wirtschaftlicher werden, insbesondere dann, wenn die Arbeitsschritte automatisiert und besser miteinander verzahnt werden. Darüber hinaus werden die Drucker um weitere Funktionen wie Scannen und Laserschneiden zu 3D-Multifunktionsdruckern ergänzt.

Die Vision ist die komplette Fabrik in einer Maschine.

Eine weitere Entwicklung ist der 4D-Druck, das sind 3D-Drucke, deren Werkstücke ihre Form im Einsatz verändern können oder die sich mit der Zeit abbauen. Die Werkstücke verfügen hierzu über ein materielles Formgedächtnis; sie verändern sich beispielsweise strukturell, je nach Temperatur oder Lichtstärke. Ein entsprechender Sonnenschutz würde sich bei zunehmender Wärme so verändern, dass weniger Sonnenlicht durchdringt. Diese Materialintelligenz ist dabei von analoger Art.

Die Intelligenz steckt in der Produktion, im Produkt und manchmal auch im Material.

Wie zentral (Produktion) oder dezentral (Produkt) die Intelligenz aufgeteilt wird, ist nicht nur eine Frage der Technik, sondern u.a. auch eine der Kostenstruktur, des Marketings und der Wartung. Dabei wird sich der Schwerpunkt der Arbeit immer stärker auf Design, Entwicklung und Steuerung verlagern.

3D-Druck und intelligente Produkte sind wesentliche Bausteine für die Revolution in der Fabrik. Aufgrund der weiteren Verkleinerung digitaler Komponenten können Sensoren und Aktoren direkt in das Material integriert werden. Digitale Komponenten sind wie eine Beimischung in das Druckmaterial. Auf diese Weise werden reales Material und digitale Systeme nicht nur zusammengebaut, sondern miteinander verschmolzen – zu digitalisiertem Material. Damit eröffnet sich die digitale Dimension des Materials und ebnet revolutionären Entwicklungen den Weg.

Forderung

Drucktechniken, Druckmaterialen und digitalisiertes Material haben an einem Ingenieurstandort wie Deutschland und Bayern ein großes Wachstumspotential. 3D-Druck ist daher ein Produktionsverfahren mit großer Zukunft und durch die Politik in Forschung und Anwendung zu unterstützen.

KryptografieKryptografische Verfahren sind eine wesentliche Grundlage für sichere Systeme und werden auch für Digitalgeld wie Bitcoin eingesetzt.

Klassische Verschlüsselung erfolgt über ein einziges Geheimnis: Dem Schlüssel. Wer eine Nachricht verschlüsselt übermitteln will, muss auch den Schlüssel zum Empfänger transportieren. Der Empfänger muss wissen, wie er die Botschaft entschlüsseln kann.

Um das Transportproblem des Schlüssels zu lösen, wurden in den 1970er Jahren Public-Key-Verfahren mit asymmetrischen Schlüsselpaaren entwickelt. Jeder Teilnehmer erzeugt mithilfe einer speziellen Software einen privaten Schlüssel (Private Key) und einen öffentlichen (Public Key). Die beiden Schlüssel sind zwar unterschiedlich, aber kryptografisch so verbunden, dass die Inhalte, die mit dem einen Schlüssel verschlüsselt werden, mit dem anderen Schlüssel entschlüsselt werden können.

Nur der private Schlüssel bleibt geheim, während der öffentliche Schlüssel im Internet verbreitet wird. Wer eine Nachricht geheim versenden will, sucht den öffentlichen Schlüssel des Empfängers, verschlüsselt die Nachricht und übersendet sie. Mit seinem geheimen privaten Schlüssel kann der Empfänger die Nachricht entschlüsseln.

Kryptografie

Der Begriff Kryptografie basiert auf griechischer Begrifflichkeit und bedeutet „geheim schreiben“. Kern der Kryptografie ist die Verschlüsselung. Durch die Digitalisierung hat die Kryptografie einen großen Aufschwung genommen.

Ein solches Schlüsselpaar kann auch für die digitale Unterschrift genutzt werden. Dazu wird zuerst der private Schlüssel des Unterschreibenden auf den Inhalt angewendet und das Ergebnis, die sogenannte Signatur, gemeinsam mit dem Klartext übermittelt. Sodann kann mit dem öffentlichen Schlüssel die Signatur in den ursprünglichen Klartext gewandelt werden und dieser mit dem mitgesendeten Klartext verglichen werden (validieren). Damit ist sichergestellt, dass der Inhaber des privaten Schlüssels digital „unterschrieben“ hat.

Aufgrund des allgemein offenen Zugangs zum öffentlichen Schlüssel kann die Prüfung von jedem durchgeführt werden und ist im Gegensatz zur Handschrift fälschungssicher. Voraussetzung ist allein, dass der Eigentümer des privaten Schlüssels diesen strikt geheim und sicher aufbewahrt. Deshalb ist das Hauptziel krimineller Angriffe der Zugang zum privaten Schlüssel.

Kryptografische Verfahren beruhen auf mathematischen Modellen, die voraussetzen, dass bei Digitalcomputern nicht genügend Rechenleistung vorhanden ist, um die Sicherheit entsprechend auszuhebeln. Quantencomputer würden schlagartig in bestimmten Fällen diese Grenze überschreiten; kryptografische Verfahren wären dann nicht mehr sicher und somit unbrauchbar. Solange dies nicht der Fall ist, werden Public-Key-Verfahren ihre Stellung als ein zentraler Baustein für sichere Systeme beibehalten. Als Alternative zu klassischen Public Key-Verfahren werden quantencomputerresistenten Verfahren entwickelt. Sie beruhen auf mathematischen Problemen, für deren effiziente Lösung heute weder klassische Algorithmen noch Quantenalgorithmen bekannt sind.32

Allerdings steigt kontinuierlich auch die Rechenleistung von Digitalcomputern, so dass kryptografische Standards immer wieder angepasst werden müssen, zum Beispiel durch längere Schlüssel. Kryptografie ist ein Dauerthema, eine Basis für sichere Kommunikation und steht ständig vor neuen Herausforderungen.

In Bayern besteht ein Bayerisches Kompetenzzentrum Quanten Security and Data Science33 (BayQS). Es ist sinnvoll, ein Kompetenzzentrum zur Kryptografie ganz allgemein zu institutionalisieren und insbesondere auch die mathematische Grundlagenforschung zu forcieren.

Forderung

Kryptografische Verfahren sind Kernkompetenz der digitalen Gesellschaft, die unter den verschiedenen Sicherheitsaspekten dauerhaft institutionalisiert werden. Bayern bündelt und fördert die Kompetenz in einem Kompetenzzentrum für Kryptografie.

Digitales GeldBeim Blockchain-Verfahren werden Inhalte, etwa Überweisungen (Transaktionen), in einem Datenpaket, dem Block, gespeichert – die Buchführung. Jeder Block ist mit dem vorhergehenden Block verknüpft, so dass sich eine Kette (Chain) von Blöcken bildet – die Blockchain. Der neue Block bezieht dabei Inhalte aus dem vorhergehenden Block in seinen Hashwert ein und kettet sich auf diese Weise an ebendiesen Block – die kryptografische Verkettung.

Die Blockchain ist eine häufig verwendete Grundlage für Digitalgeld. Das 2009 gestartete Bitcoin ist die erste und bekannteste Marke unter einer Vielzahl von Digitalwährungen, die sich seitdem auf Basis der Blockchain gebildet haben. Die technischen Details und Zielsetzungen variieren teilweise erheblich. Gemeinsam ist ihnen allen die digitale Form. Darüber hinaus sind digitale Währungen nach ihrem Start nur noch durch Kauf und Verkauf zu beeinflussen, aber nicht mehr durch Entscheidungen in Politik, Banken oder anderer Stelle.

Blockchain-Technologien sind intensiv durch Start-ups erforscht und umgesetzt worden. Es gibt aber noch eine Reihe anderer Technologien für Digitalgeld, die bislang im Schatten stehen.34 Wenn Forschung zum Digitalgeld gefördert werden sollte, dann zu den Alternativen der Blockchain.

Geldart

Form

Bargeld

Physisches Geld in Form von Papiernoten und Münzen.

Buchgeld

Girokonten mit dem Versprechen der Umtauschbarkeit in Bargeld.

Digitalisiertes Geld

Digitaler Zugriff auf Buchgeld durch Kreditkarten und Softwareprogramme.

Digitalgeld

Unabhängig von Bargeld und vollständig digitalisiert.

Bitcoin hat einen hohen Energiebedarf. Dies ist dem eingesetzten Konsens-Algorithmus geschuldet. Es gibt Alternativen, die deutlich weniger aufwendig sind. Es wäre ein gutes Forschungsziel für Bitcoin eine entsprechende Alternative zu entwickeln, die den Energieverbrauch massiv senkt, zu weniger Konzentration der Miner führt und die Verlässlichkeit unabhängig vom Kurs gewährleistet. Zudem ist der Einsatz von Konsens-Algorithmen auch in anderen Bereichen denkbar.

Forderungen

Zentralbanken und Finanzministerien sind vorrangig verantwortlich für Geldsysteme und dem Vertrauen der Menschen in diese Systeme. Digitalgeld durch unabhängige Dritte sorgt für Wettbewerb um Solidität und Vertrauen in Währungen. Forschungsrelevant für Digitalgeld sind Verfahren, die nicht auf einer Blockchain basieren.Konsens-Algorithmen sind unabhängig von Digitalgeld ein Forschungsziel.QuantencomputingQuantencomputer sind eine völlig andere Art als digitale Computer auf der Basis der Quantenmechanik. Quantencomputer arbeiten bei speziellen Aufgaben wie Optimierung und Simulation um buchstäblich Quantensprünge leistungsfähiger. Sie lösen komplexe Aufgaben nicht Schritt für Schritt, sondern in einem Arbeitsgang. Das Kernproblem der Quantencomputer ist ihre strukturbedingte Instabilität und Fehlerhaftigkeit, je größer die Rechenleistung (Anzahl Qubits) ist. Sollte Quantencomputing gelingen, wird dies in einer Vielzahl von Anwendungen völlig neue Möglichkeiten schaffen. Deshalb muss ein zukunftsorientierter Forschungsstandort in Quantencomputing investieren.

Forderungen

Die akademische Forschung am Quantencomputing wird gefördert und Start-ups unterstützt.Anwendungsmöglichkeiten im öffentlichen Bereich werden aktiv initiiert.Web X.0Die verschiedenen technologischen Entwicklungen des World Wide Web (WWW) wird üblicherweise mit den in der IT üblichen Versionsnummern durchgezählt, also 1.0, 2.0, 3.0 usw., allgemein X.0.

Das Web 1.0 (1991) verknüpft Inhalte, zu Anfang Texte und Bilder. Technische Basis ist HTML, das die Gestaltung von Texten, Medien und Verbindungen (Links) definiert, die vom Webbrowser interpretiert und dargestellt wird.

Mit Web 2.0 (2004) wurde das Internet interaktiv, entstanden Plattformen und Social Media. Auf der technischen Seite bildet die Programmiersprache JavaScript die Grundlage. Die Verbindung von HTML und Programmiersprache ermöglichte die Dynamisierung und Interaktion.

Unter Web 3.0 (2014) werden einige aktuelle Trends zusammengeführt. Technische Grundlagen sollen Blockchain und Digital Reality35 sein. Die Zentralisierung auf den Plattformen des Web 2.0 soll im Web 3.0 durch eine neue Dezentralisierung abgelöst werden. Starke Standards sollen Vielfalt und Wettbewerb organisieren. Es ist auch für staatliche und besonders kommunale Anwendungen ein nützliches Muster, wie durch Standards Wettbewerb organisiert werden kann.

Die analoge und digitale Welt soll im Metaverse verwoben werden bis sie miteinander verschmelzen. Das Kofferwort Metaverse wird aus Meta und Universe (Universum) gebildet. Im Metaverse ist die Präsenz an beliebigen virtuellen Orten jederzeit möglich. Der Handel mit digitalen Vermögenswerten soll per NFT‘s organisiert werden. Das „Industrial Metaverse“ bringt diese Konzepte in Fabrik und Kundendienst, etwa als Handlungsanleitungen über VR oder Bauteile-Management mit NFT‘s.

Auch wenn Gaming ein großer Treiber für das Web 3.0 ist, werden Geschäftsanwendungen von den technischen Entwicklungen und der Kostensenkung, etwa für Simulationen, profitieren.

Reality

Abkürzung

Erläuterung

Virtual Reality

VR

Simuliert digital eine dreidimensionale Welt. Das kann auch ein digitaler Zwilling sein.

Augmented Reality

AR

Erweitert die reale Welt um digitale Darstellungen.

Mixed Reality

MR

Interaktion zwischen realer und virtueller Welt.

übermittelte Einkommenssteuer-Erklärungen36

Diese vielen Entwicklungen führen zu einer Explosion von Information, Interaktion und Präsentation. Neben der marktwirtschaftlichen Vielgestaltigkeit führt dies in Verbindung mit der besonders in Deutschland ausgeprägten Intensivbürokratie und filigran ausdifferenziertem Rechtswesen zu einem kognitiven Overkill. Ob der Tarifdschungel beim Mobiltelefonieren, die Undurchschaubarkeit von Versicherungsverträgen, die Überschwemmung mit AGBs, Cookies, Widerrufs- und Datenschutzbelehrung bei einem simplen Internet-Einkauf oder eben die Vielzahl an Vorschriften und Formularen staatlicher Behörden – sie alle überfordern Menschen jeden Tag. Wer sich Rechtsberater, Steuerberater, Vermögensberater etc. leisten kann, der kann sich davon freikaufen. Die Mehrheit kann das nicht.